上周,欧洲立法者以压倒性多数投票支持具有里程碑意义的人工智能法规《欧盟人工智能法案》(EU AI Act)。虽然该法案还没有法律效力,但一边倒的投票表明它很快就会在欧盟生效。在其他国家,公司仍然可以自由使用人工智能。例如,到目前为止,美国对人工智能代表的是风险还是机遇缺乏共识。

欧洲议会499名议员投了赞成票,28人反对,93人弃权,以较大优势通过了《人工智能法案》草案。在议会成员、欧盟委员会和欧盟理事会进行谈判后,今年晚些时候可能会进行最终投票。

2021年4月首次提出的《欧盟人工智能法案》将限制公司在其产品中使用人工智能的方式;要求人工智能以安全、合法、合乎道德和透明的方式实施;强制公司获得某些人工智能用例的事先批准;并要求公司监控其人工智能产品。

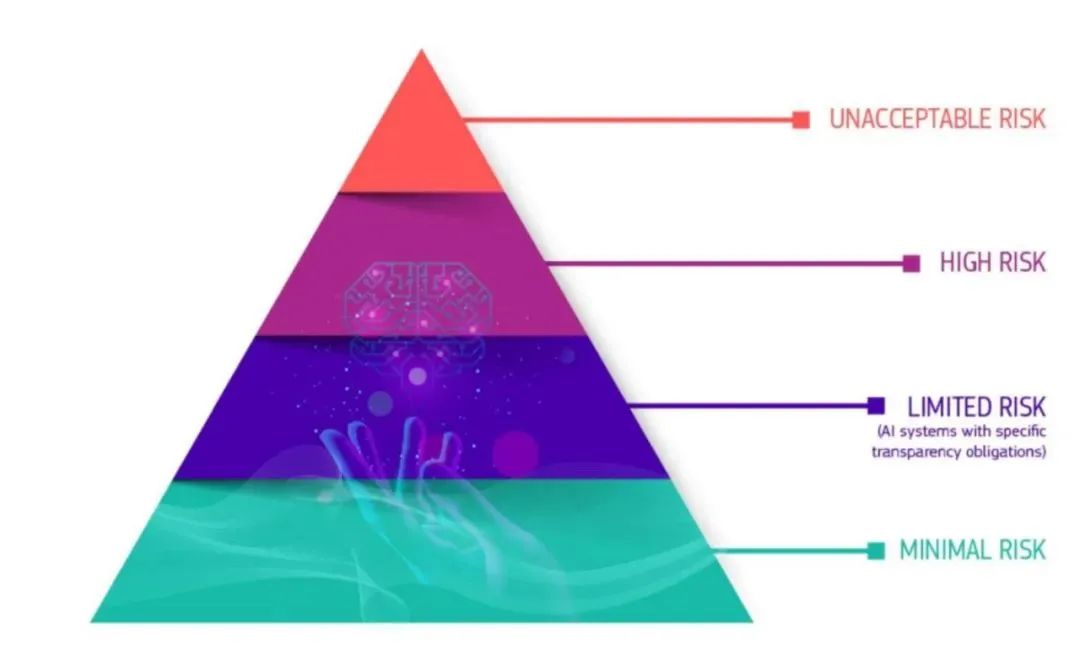

人工智能法将根据不同的人工智能使用带来的风险对其进行排名并将其分为四类,并要求公司在人工智能给客户使用之前达到相应安全标准。

第一类风险最小的人工智能,如垃圾邮件过滤器或视频游戏,可以继续像以往一样使用,并且不受透明度要求的约束。

第二类人工智能被称为“风险有限”,这一类别包括OpenAI的ChatGPT或谷歌的Bard等聊天机器人。根据拟议的法律,为了遵守《欧盟人工智能法案》,必须告知用户他们正在与聊天机器人互动。

第三类是组织需要对所谓的高风险人工智能系统进行影响评估和审计,其中包括自动驾驶汽车,以及教育、移民和就业方面的决策支持系统。欧洲中央政府将在一个中央数据库中跟踪高风险的人工智能使用案例。

第四类被认为具有“不可接受”风险的人工智能,在欧盟永远不会被允许,即使有审计和监管。这种被禁止的人工智能的包括实时生物特征监测和社会评分系统。不遵守规定可能会被处以相当于公司收入6%或7%的罚款。

法案投票结果表明大多数人支持人工智能已经失控,需要加以控制的观点。一些著名的人工智能开发者最近呼吁禁止或暂停人工智能研究,包括Geoffrey Hinton和Yoshua Bengio,他们为普及现代神经网络做出了巨大贡献。如今他们签署了人工智能安全中心的一份声明,呼吁将人工智能视为全球风险。

Hinton今年初辞去了谷歌的工作,以便能够更自由地谈论人工智能的威胁,他将人工智能比作核武器。在5月3日Hinton对美国有线电视新闻网说:“我只是一个突然意识到这些东西比我们更聪明的科学家。”“…我们应该认真考虑如何阻止这些事情控制我们。”

然而,并不是所有的人工智能研究人员或计算机科学家都认同这一观点。Yann LeCun是Facebook母公司meta的人工智能研究负责人,他与Hinton和Bengio一起因在神经网络方面的集体工作而获得2018年图灵奖,他一直直言不讳地认为,现在不是监管人工智能的合适时机。

LeCun近期在推特上表示,他认为“过早的监管会扼杀创新”,特别是在提到新的欧盟人工智能法案时。

LeCunn上周在法国巴黎举行的VivaTech会议上表示:“从总体上讲,人工智能本质上是好的,因为人工智能的作用是让人们变得更聪明。”“你可以把人工智能视为人类智慧的放大器。当人们更聪明时,事情就会发生。人们的生产力更高,更快乐。”

Meta的人工智能主管Yann LeCun在VivaTech上表示:“你可以把人工智能视为人类智能的放大器。”

LeCunn继续说道:“现在毫无疑问,坏人可以利用它来做坏事。”“然后是一个问题,好人是否比坏人多。”

商业转型专家Kamales Lardi表示,正如欧盟的《通用数据保护条例》(GDPR)构成了其他国家和美国各州(如加利福尼亚州)许多数据隐私法的基础一样,拟议的《欧盟人工智能法案》将为世界各地的人工智能监管开辟道路。

她说:“欧盟的法案可能会成为一项全球标准,对人工智能如何影响我们的生活以及如何在全球范围内对其进行监管产生影响。”“然而,该法案也有局限性……监管应侧重于在创新和技术错误应用之间取得智能平衡。该法案也不灵活,没有考虑到人工智能发展的指数级速度,一两年后人工智能的发展速度可能与今天大不相同。”

总部位于伦敦的人工智能公司Encord的联合创始人兼总裁Ulrik Stig Hansen表示,现在不是监管人工智能的合适时机。“我们听说过太大而无法监管,但太早怎么办?”“按照欧盟的传统方式,他们正在寻求监管一项新技术,而这项技术很少有企业或消费者采用,也很少有人在这一点上进行开发。”他说,由于我们还没有牢牢把握人工智能系统固有的风险,现在制定监管人工智能的法律还为时过早。

“一个更明智的方法可能是相关行业机构像监管其他技术一样监管人工智能。”“人工智能作为一种医疗设备,是一个很好的例子,它需要获得美国食品药品监督管理局(FDA)的批准或CE标志。这与我们在英国看到的情况一致,英国采取了更务实的支持创新的方法,并将责任交给了人工智能应用领域的现有监管机构。”

虽然美国目前还没有制定人工智能法规,但正在采取措施,指导各组织合乎道德地使用人工智能。今年1月,美国国家标准与技术研究所(NIST)发布了《人工智能风险管理框架》(RMF),该框架指导各组织完成人工智能系统的规划、衡量、管理和治理过程。RMF有几件事要做,包括有可能成为多方认可的法律标准。更重要的是,它保留了适应快速变化的人工智能技术的灵活性,这是《欧盟人工智能法案》所缺乏的。