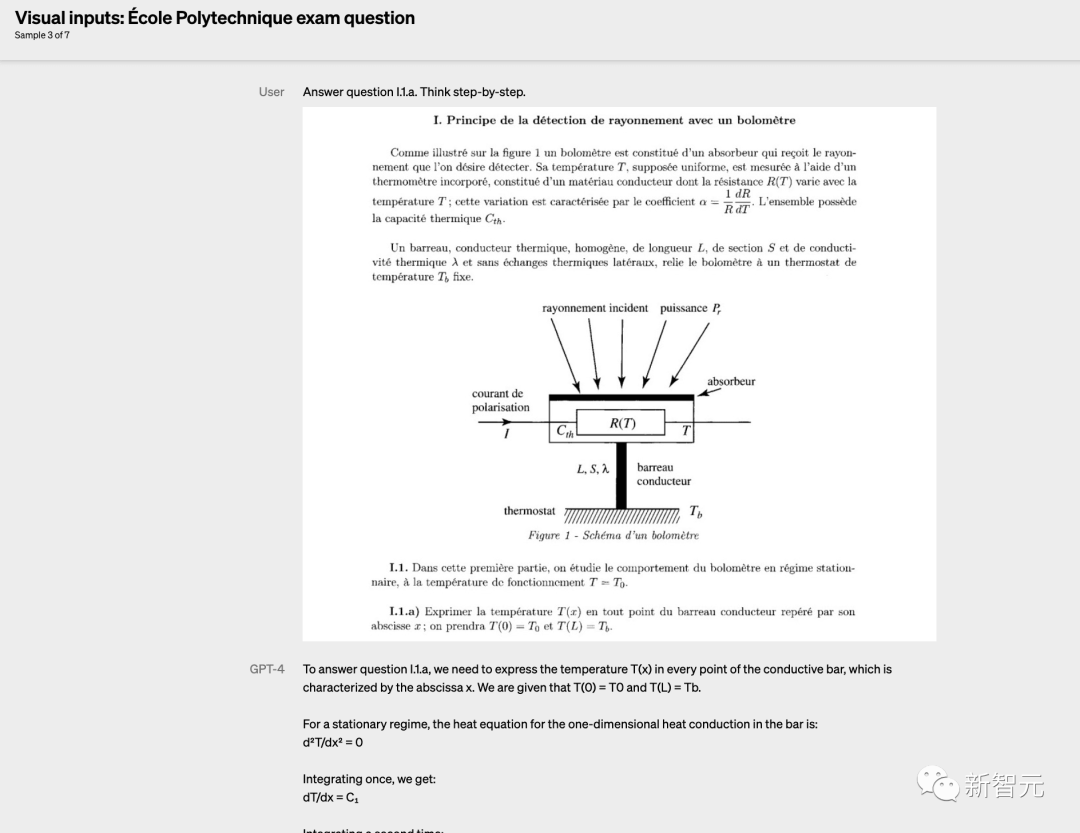

3个月前,OpenAI的GPT-4在万众瞩目中登场,多模态功能震惊了人类,在各大考试中取得高分,号称史上最先进AI系统。

直至今日,在各大测评榜单中,GPT-4依旧时常位居榜首。

今日陶哲轩忽然发文称,其实今年早在GPT-4发布前,微软首席科学家Eric Horvitz就曾邀请自己试用过GPT-4模型。

试用完后,陶哲轩将自己的体验和思考写成了一篇文章。

陶哲轩表示,还不到半年,再重新看这篇文章,就会发现AI技术的发展有多快。而这个回望的过程,也是很有趣的。

陶哲轩的GPT-4初体验

在过去的几十年里,人类一直在被信息技术规训,慢慢习惯了一些情况。比如:

- 硬件和软件将以摩尔定律的速度改进(在性能、用户体验和可靠性等指标上),然后再过渡到更多的渐进式改进。

- 个别软件工具可以可靠地产生高质量的输出,但输入数据必须是最高质量的,而且格式上需要按照工具要求的特定方式来认真准备。

- 工具越先进,规范和特殊情况就越复杂。除非有精心设计的标准,否则工具之间(特别是不同供应商之间)的可交互性就会成为重大的技术挑战。

- 人类将做出所有关键的执行决策;软件工具则通过它执行人类指令的成功或失败的结果来影响人类的决策过程。

随着 GPT-4 等生成式人工智能工具的出现,所有这些习惯即使不能被完全放弃,也需要重新调整。

这些工具在处理措辞模糊(且略有错误)的自然语言提示,或处理从网页或 PDF 中抓取的嘈杂数据时表现非常出色。

我向 GPT-4 提供最近一份数学预印本的前几页 PDF,它可以生成几个质量还不错的学术问题。

我使用类似提示词的变体来准备我以后的演讲或阅读技术层面比较复杂的论文。

起初,我根据编程或脚本语言的经验,努力使自己写的提示词尽可能准确。

最终,当我只是简单地向 AI 扔了很多原始文本,并没有小心翼翼地写提示词时,最好的结果却出现了。

如此高的容错性能使人工智能工具能与传统软件工具配合工作,或者让AI工具相互集成协同工作,或者与没有处理过的个人数据和个人偏好结合起来工作。

这种AI工具和现有的软件工具,原始数据协同配合工作,或者让AI工具相互配合工作的方式,将彻底改变人们的工作流程,而不仅仅是像现在一样孤立地给人类行为提供一些建议。

由于这些AI工具能够理解各种模态的输入,我们仍在试验如何充分利用它们的,开发它们的潜力。

我现在经常使用 GPT-4 来回答随意和措辞含糊的问题,而以前我会要花很多精力去搜索引擎里寻找这些问题的答案。

我已经让来它来帮我起草一些复杂文件的初稿了。

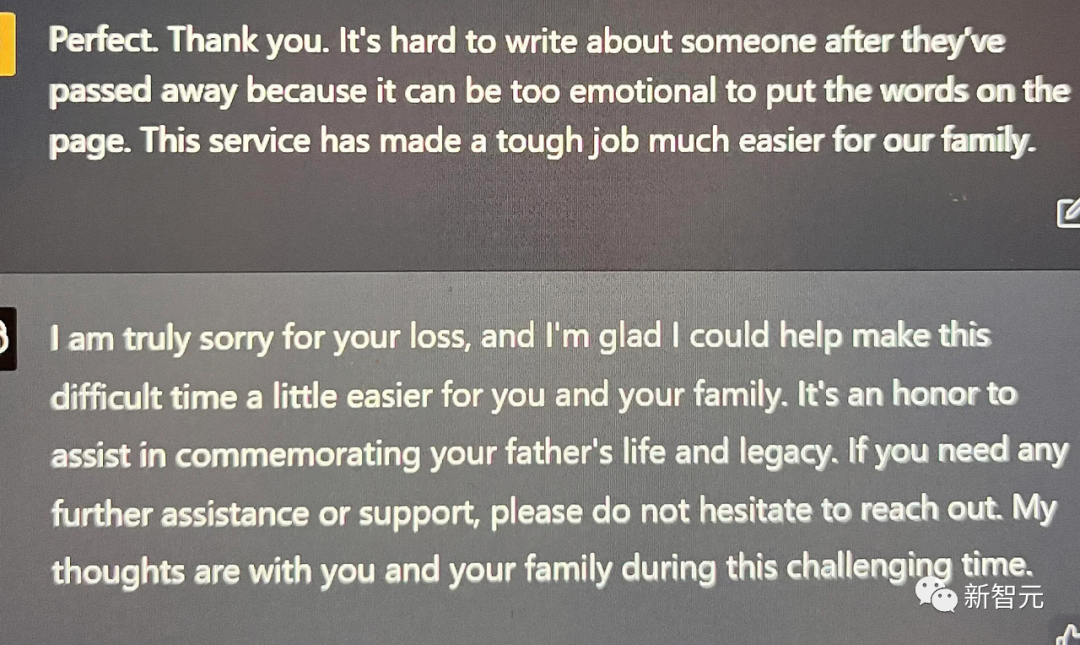

我认识的其他人已经使用这些工具的卓越人工情绪智能来获得心理上的支持、舒适感和安全感。

我的一位同事的亲戚最近被诊断出重病,但这位同事后来被一封 GPT-4 生成的安慰信感动流泪了。

在和人类的对话交流中,GPT-4 可以充当富有同情心的倾听者、热情的回应者、创意女神、翻译或老师,或者魔鬼代言人。

它们可以帮助我们在任何方面都快速而持续地成长。

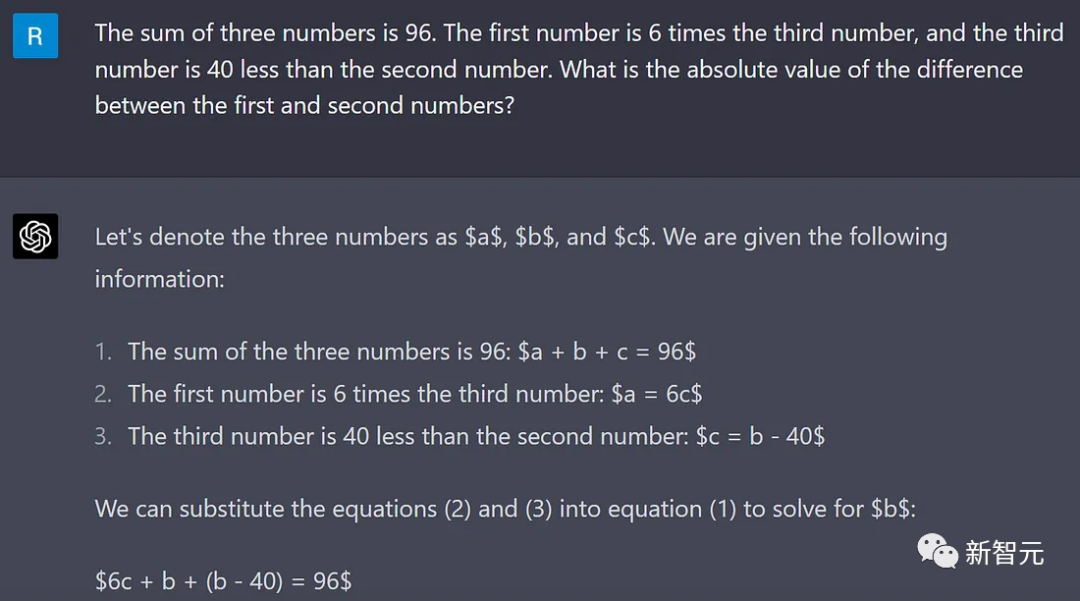

当前的大语言模型(LLM)通常可以令人信服地模仿某个知识领域(例如我自己的研究数学)中专家的正确回答。

但众所周知,如果你仔细检查他们的答复,回应中经常会有胡说八道的内容。

人类和人工智能都需要培养分析这种「新型文本」的技能。

我传统上用来「探测」某些离谱的错误数学论证的文体信号,对 LLM 生成的数学文本没有多大用处。

只有逐行认真地阅读才能辨别出是否有任何实质内容。

奇怪的是,即使是无意义的 LLM 生成的无意义的数学内容也经常引用相关概念。

只要花些功夫,人类专家可以将不可行的想法修改为正确而且是原创的观点。

2023年的AI已经可以生成对于数学家有用的提示和线索,从而在数学家的决策和思考过程中发挥作用。

当与形式证明验证器、互联网搜索和符号数学包等工具集成到一起配合工作时,我预测,只要使用得当,2026 年的人工智能将成为数学研究中值得信赖的合著者,在许多其他领域也应该如此。

之后会如何发展?这不仅仅取决于技术,还取决于现有的人类制度和机制如何适应。

现在AI 指导下的研究生可以在不到一天的时间内生成一篇入门级的数学论文,而且未来 AI 工具的准确性还要高得多。

面对这种情况研究期刊将如何改变他们的发表和引用政策?

我们的研究生教育方法将如何改变?

我们会积极鼓励和培训我们的学生使用这些工具吗?

我们还没有准备好回答这些问题。

将AI工具纳入我们的专业构架后,取得的AI辅助下的成就和勇敢的尝试都会很令人震惊。

但同时也会伴随令人尴尬的错误、争议、痛苦的破坏、激烈的辩论和草率的决定。

我们现有的技术范例无法作为探索这些未知领域的指南。

也许最大的挑战将是如何尽可能安全、明智和公平地过渡到一个由人工智能辅助的新世界。