一项新的研究发现,15%的员工经常在ChatGPT上上传公司数据,其中超过四分之一的数据被认为是敏感信息,这使公司在无形中面临安全漏洞的风险。

6月的研究报告《揭示真正的GenAI数据暴露风险》分析了超过10000名员工,主要研究员工如何在工作场景下使用ChatGPT和其他生成性AI应用程序。

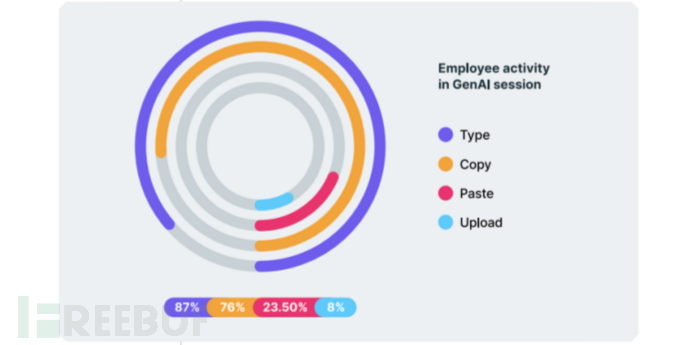

该报告显示,至少有15%的员工在工作中使用ChatGPT和其他生成性人工智能工具,其中近25%的访问直接将公司数据粘贴在AI工具中。许多员工每周、甚至每天都在粘贴敏感数据。

根据报告显示,员工平均每天向生成性人工智能工具输入数据36次,而且随着人工智能的普及,这些数字预计只会增加。

LayerX在这份长达10页的报告中说:用不了多久,员工将使用GenAI作为他们日常工作流程的一部分,就像他们使用电子邮件、聊天软件(Slack)、视频会议(Zoom、Teams)、项目管理和其他辅助工作的工具一样。

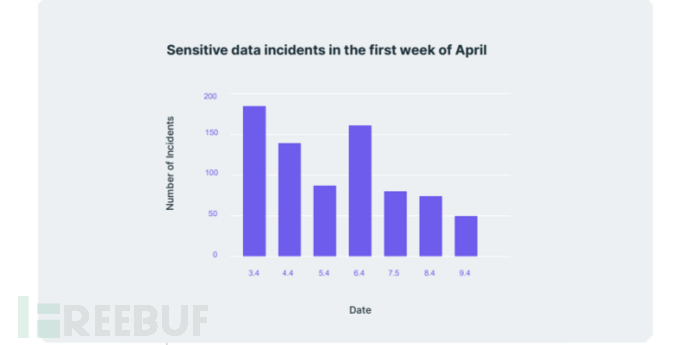

从报告来看,尽管GenAI正在开辟一个全新的领域,但它也给企业带来了巨大的风险,特别是关于敏感数据的安全和隐私。

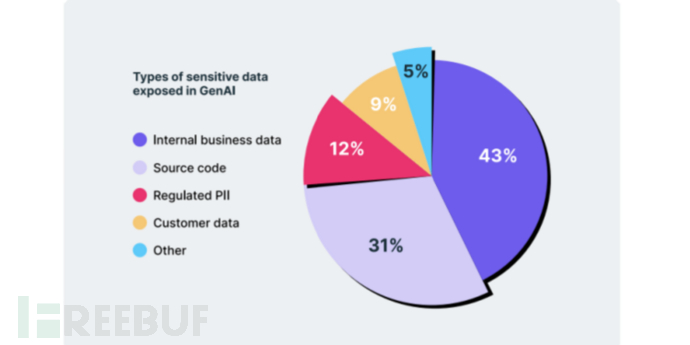

更重要的是,被粘贴进GenAI工具的敏感信息的主要类别包括:内部业务数据占43%,源代码占31%,以及个人身份信息(即PII)占12%。这其中,源代码和内部业务数据被利用的风险是最高的。

研究报告说,由于GenAI平台在浏览器中运行,现有的安全解决方案无法解决敏感数据粘贴等风险。

主要研究结果显示,4%的员工每周都会将敏感数据粘贴到GenAI中,增加了敏感数据外流的机会。

这些数字还发现,50%与GenAI接触最多的员工来自研发部门,其次是销售和营销部门,超过23%,财务部门超过14%。

研究发现,相当一部分GenAI用户不仅依赖提示指令,而且还会粘贴数据以尝试生成所需的文本。

例如,一个销售经理使用GenAI来制作其季度的业绩报表及执行流程,就必须向GenAI工具提供实际的销售结果数据。

这就把公司的敏感数据暴露在GenAI中,尽管这么做的原始目的可能是为了节省时间。

2023年1月,在其发布后不到两个月的时间里,ChatGPT迅速积累了超过1亿的活跃用户。

而到4月,ChatGPT报告其活跃用户增长到每月高达8亿多用户。

报告发现44%的员工在过去3个月中使用过GenAI API,其中一部分人每月访问AI网站和应用程序的次数超过50次。

随着AI对生产力的大幅提高,这一现象在日后只会有增无减,届时如何保护公司内部数据不外流,将成为每个公司都要面临的问题。

参考链接:https://cybernews.com/security/workers-regularly-post-sensitive-data-into-chatgpt/