大数据文摘出品

被誉为深度学习三巨头之一的Yann LeCun一直是乐天派,他不止在一个场合表达他对人工智能(AI)发展的乐观预期。例如:“AI是人类智慧的放大器,AI越强大,人类就越聪明,更快乐和更有经济效率。”

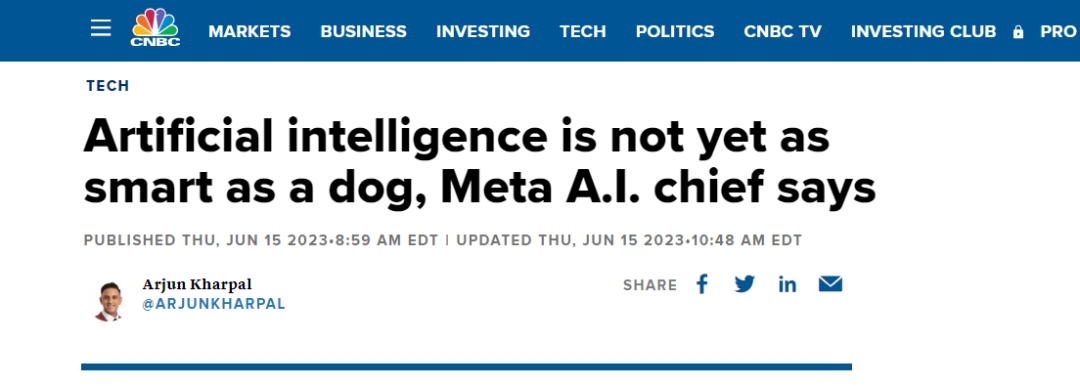

今日,CNBC有篇文章披露出了Yann LeCun对AI能力现状的定义:它还不如一条狗聪明。至于原因,LeCun谈到:

那些系统只在文本上训练,它们对现实世界的基本现实没有任何理解,然而大部分人类知识与语言无关……所以大部分人类经验AI是学不会的。”

为了论证 LeCun的观点,他举了个例子,现在的AI系统可以通过美国的律师资格考试,然而,AI不会用/装(load)洗碗机,一个10岁的小孩却10分钟就能搞定。

更深层次的原因,是AI无法复制人类能力,例如五月大的婴儿看到水上漂浮物体可能无感,但九月大的婴儿可能会表现出震惊,因为他会意识到物体不应该漂浮。

“不知道如何用机器复制这种能力。在我们能做到这一点之前,AI不会拥有人类水平的智能,也不会拥有狗或猫水平的智能。”LeCun如此解释。

CNN之父的人工智能观点

在去年的十月份,Yann LeCun在接采访中提到,“今天的人工智能方法永远不会带来真正的智能。所有人工智能都面临某些基本问题,特别是如何衡量信息。”

而最近公开的演讲中,更是强烈批判GPT大模型所使用的方法,即根据概率生成自回归的大模型,根本无法破除幻觉难题。

此前, LeCun提出目前AI研究面临的三大挑战,而这些挑战也是GPT所使用方法无法解决的。

- AI如何学会表征世界,学习预测,并学习主要通过观察来行动?

- AI如何才能以与基于梯度的学习相兼容的方式进行推理和计划?

- AI如何学习在多个抽象层次和多个时间尺度上以层次化的方式表示感知和行动规划?

针对上述问题,LeCun提出了两个解决方向。一是运用自监督学习方法,减少系统学习所需的数据量,这本质上是通过预训练来获得更好的性能。二是进行端到端的训练,设计一些能够处理边缘情况的系统,通过强化控制来解决问题。

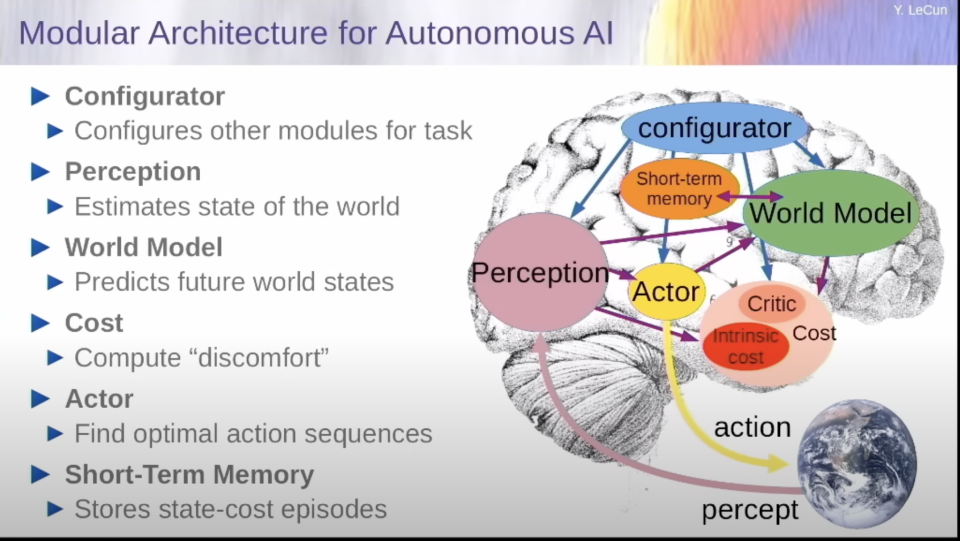

图源:北京智源大会

更为具体,他提出世界模型,给人工智能的下一步,提供解决方案。在他的设想中,世界模型为一个不光是在神经水平上模仿人脑的模型,而是在认知模块上也完全贴合人脑分区的模型。它与大语言模型最大的差别在于可以有规划和预测能力(世界模型),成本核算能力(成本模块)。

通过世界模型,它可以真正的理解这个世界,并预测和规划未来。通过成本核算模块,结合一个简单的需求(一定按照最节约行动成本的逻辑去规划未来),它就可以杜绝一切潜在的毒害和不可靠性。

至于如何实现世界模型,LeCun认为可以采用自监督模型去训练,比如一定要建立多层级的思维模式........

安全or危险?AI发展的两种预见

和LeCun同年“摘取”图灵奖得主盛誉的Geoffrey Hinton却有着不一样的观点:

“这些超级智能出现的时间可能比我过去认为的要早得多......超级智能显然会学得非常擅长欺骗人,可以让人们实际执行它喜欢的任何动作。这非常可怕!””

从最近一些领域大咖的表态来看,似乎站台Hinton,认为AI危险的人数更多一些。例如特斯拉的头头马斯克表示,人工智能是未来文明面临的最大危险之一。

而在今年五月份,大量学者、专家签名公开信《AI 风险声明》,信中警告称如果对先进人工智能的发展监管不当,可能会对人类构成生存威胁。

这封公开信与以往不同,因为其中许多重要签署者在 AI 实验室、大型科技公司担任要职。其中包括图灵奖得主 Geoffrey Hinton、Yoshua Bengio,OpenAI 首席执行官 Sam Altman,Google DeepMind 联合创始人兼 CEO Demis Hassabis,微软首席技术官 Kevin Scott,谷歌副总裁 James Manyika,OpenAI 首席科学家 Ilya Sutskever,GAN 之父 Ian Goodfellow 等都已签名。

而Hinton更是离职谷歌,表达毕生的后悔。他对造就了如今AI技术繁荣的神经网络,表示抱歉。

参考链接:

https://new.qq.com/rain/a/20230612A08QO700

https://www.cnbc.com/2023/06/15/ai-is-not-even-at-dog-level-intelligence-yet-meta-ai-chief.html

https://mp.weixin.qq.com/s/LDTpMoDaIf3tTATxWeaSgg

https://mp.weixin.qq.com/s/GxEfoD06P1UPIIbFTbTgEg