AMD放大了!

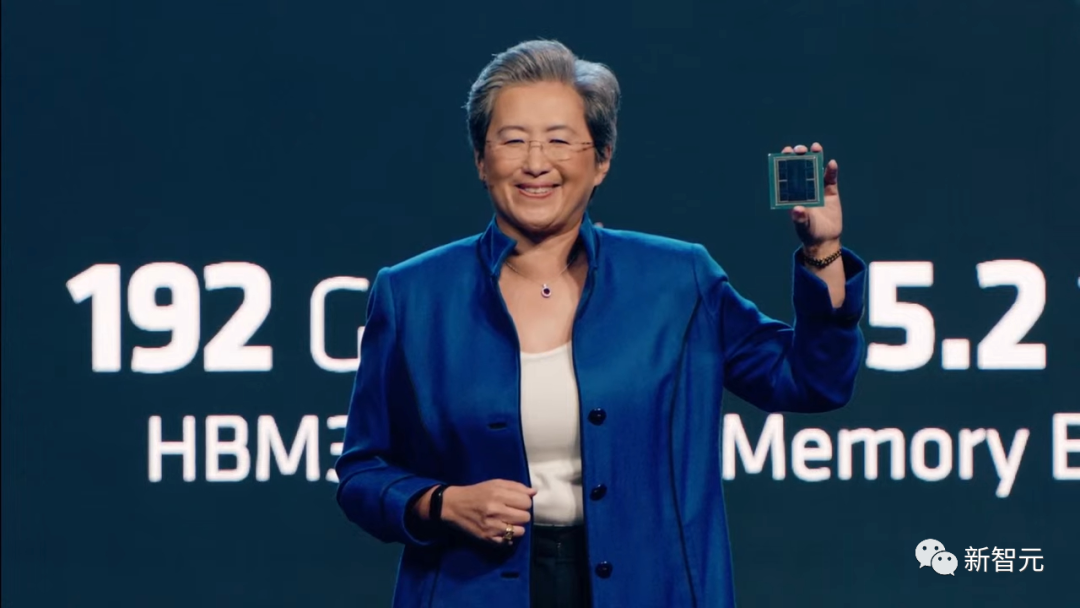

在周二的发布会上,苏妈直接宣布了最新的一款AI芯片——GPU MI300X,直接叫板英伟达。

AMD本周二表示,将于今年晚些时候开始向部分客户发货。

要知道,Nvidia目前在AI芯片市场中牢牢占据着主导地位。

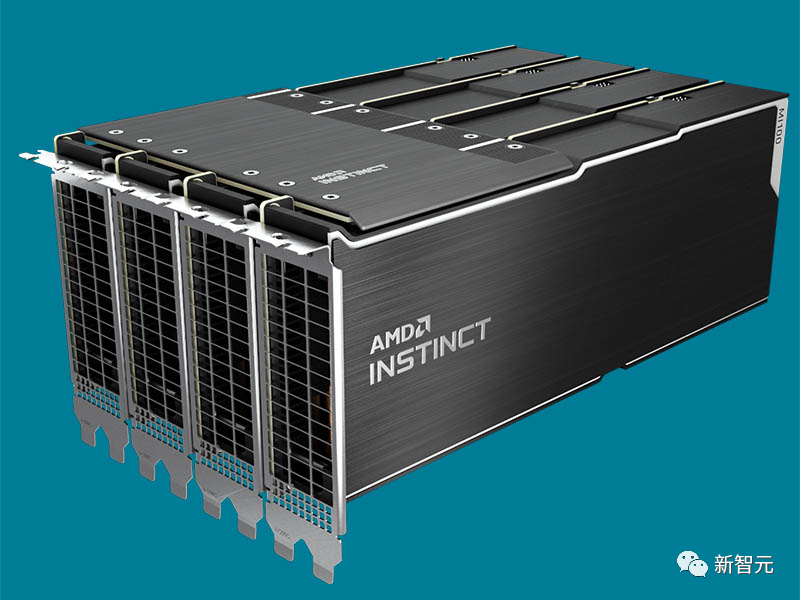

MI300X

AMD公司的CEO苏妈Lisa Su周二在旧金山发布了一款芯片——GPU MI300X。

据悉,这是该公司AI计算战略的核心。

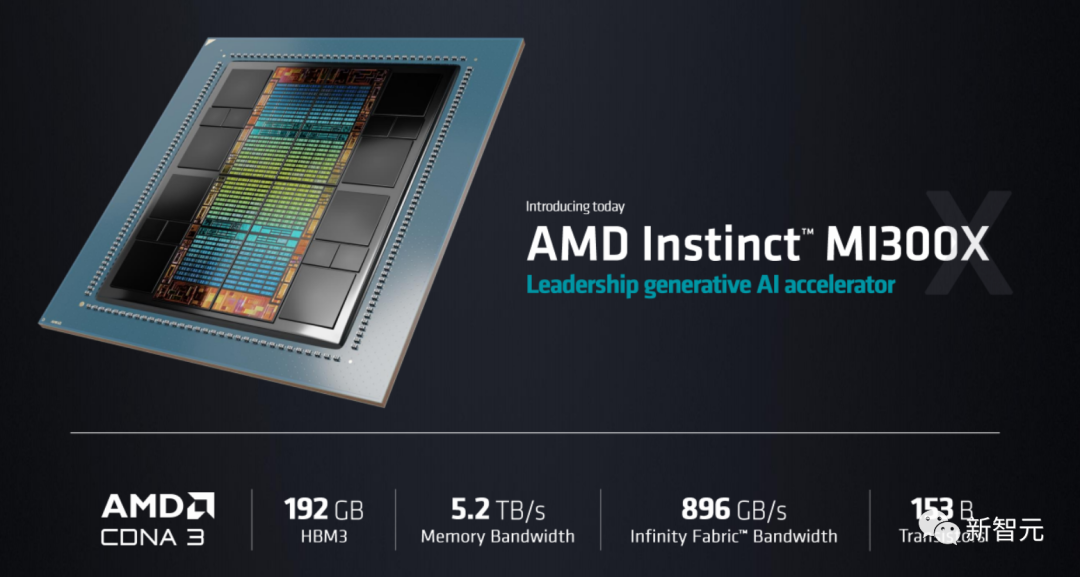

它能为生成性AI(LLM)提供巨大的内存和数据吞吐量。

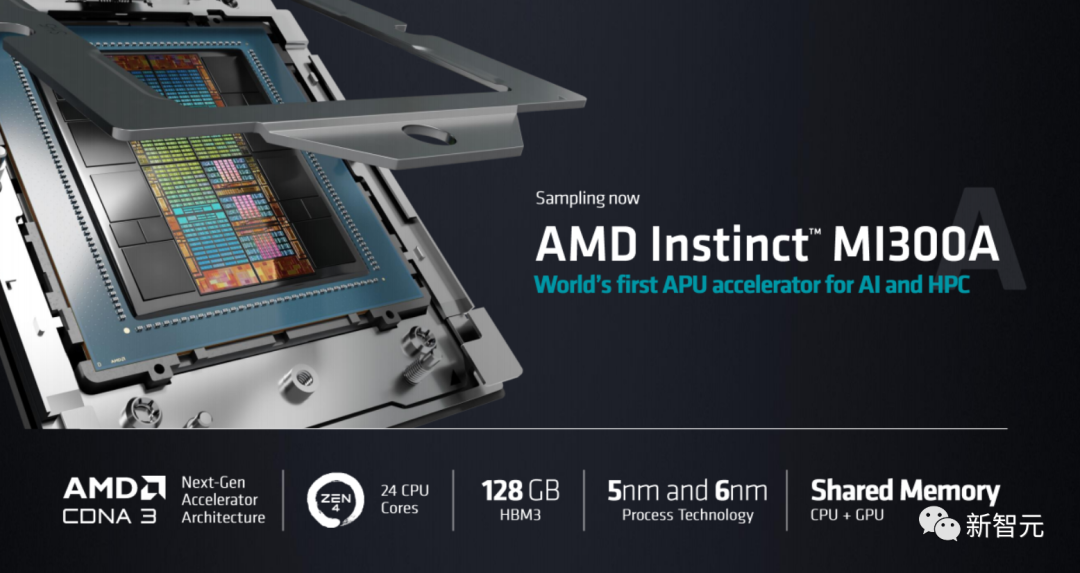

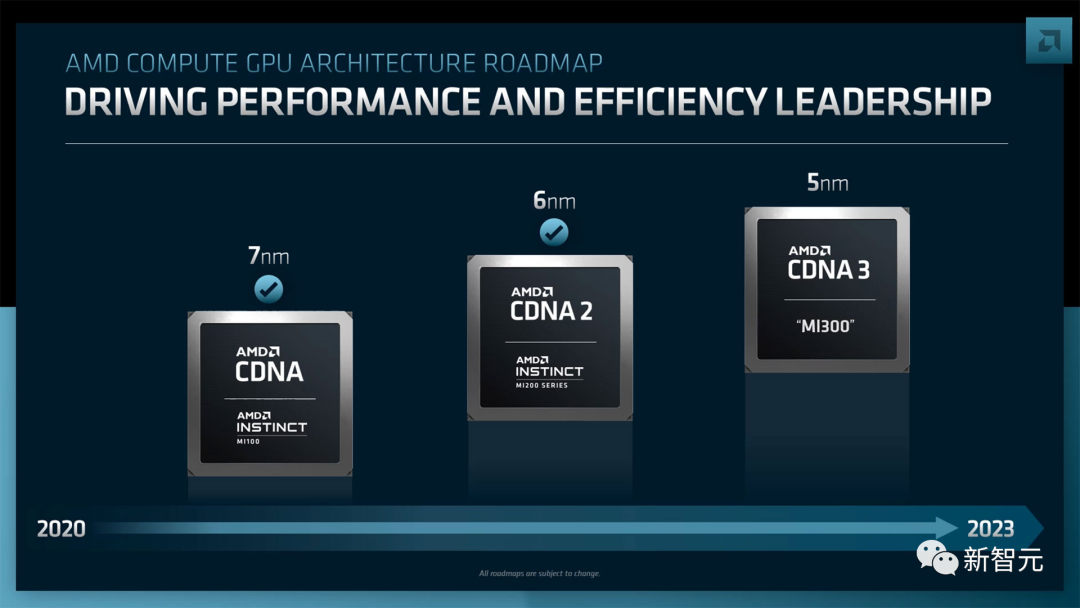

Instinct MI300X是之前发布的MI300A的后续产品。该芯片实际上是多个小芯片的组合,这些独立的芯片通过共享内存和网络链接被连接到一个单一的封装中。

苏妈将这款芯片称为生成式AI加速器,其中包含的GPU芯片是专门为AI和HPC(高性能计算)量身打造的。

MI300X是该产品的「纯GPU」版本。MI300A是三个Zen4 CPU芯片与多个GPU芯片的组合。

但在MI300X中,CPU被换成了两个额外的CDNA 3芯片组。

此外,MI300X将晶体管数量从1460亿个增加到1530亿个,共享DRAM内存从MI300A的128千兆字节提升到了192千兆字节,内存带宽从每秒800千兆字节提升到了每秒5.2兆字节。

苏妈在演讲中反复多次强调了这款芯片所具有的非常、非常重要的战略意义。

「因为它能够混合和匹配不同种类的计算,替换CPU或GPU。」

苏马表示,MI300X将提供2.4倍于Nvidia H100 Hopper GPU的内存密度,以及1.6倍的内存带宽。

生成式AI以及LLM的格局已经改变,对更多计算的需求正以指数的形式增长,无论是训练模型还是进行推理。

为了证明对强大计算的需求,苏妈展示了在目前最流行的LLM上工作的部分,即开源的Falcon-40B。

语言模型需要更多的计算,因为它们是用越来越多的所谓的神经网络参数建立的。

她表示,MI300X是AMD第一款功能强大的芯片,可以流畅地在内存中运行大规模的神经网络,而不是必须在外部内存中来回移动数据。

苏妈现场演示了MI300X使用Falcon-40B创建了一首有关旧金山的诗篇。

苏妈表示,「一个MI300X芯片可以在内存中运行高达约800亿个参数的模型。」

「当你将MI300X与竞争对手进行比较时,你就能发现,MI300X提供了2.4倍的内存,和1.6倍的内存带宽,有了所有这些额外的内存容量,我们实际上对LLM是有巨大优势的,因为我们可以直接在内存中运行更大的模型。」

这意味着,对于最大的模型,AMD减少了所需要的GPU数量,大大加快了性能,特别是推理的速度,同时也降低了总成本。

苏妈在演讲中毫不掩饰对这款芯片的喜爱。

AMD Instinct

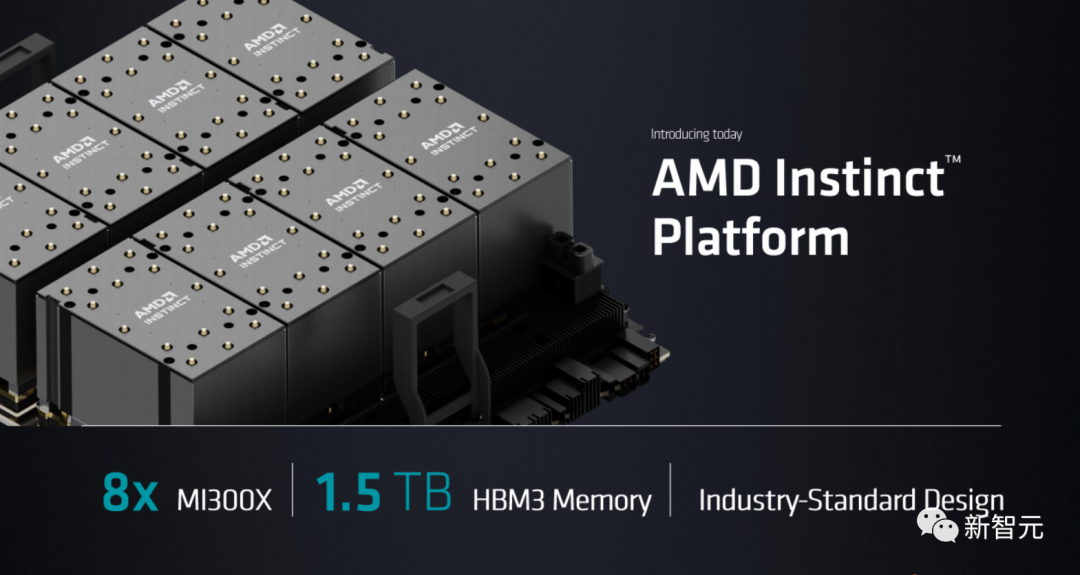

为了与Nvidia的DGX系统竞争,苏妈发布了一个人工智能计算机系列,即AMD Instinct平台。

这个平台集成了8个MI300X,可提供1.5TB的HBM3内存。

苏妈表示,对于客户来说,他们可以在一个行业标准的平台上使用所有这些AI计算能力的内存,直接放入他们现有的设施。

与MI300X不同的是,现有的MI300A只是一个GPU,它的对手是Nvidia的Grace Hopper组合芯片,它使用Nvidia的Grace CPU和它的Hopper GPU。

Su指出,MI300A正被内置到能源部的劳伦斯-利弗莫尔国家实验室在建的El Capitan超算中。

MI300A目前正作为样品展示给AMD客户,MI300X将在今年第三季度开始向客户提供样品。

苏妈表示,两者都将在第四季度进行批量生产。

和HuggingFace合作

同时,HuggingFace也在今天宣布,AMD已经正式加入其硬件合作伙伴计划。

HuggingFace的CEO Clement Delangue在旧金山举行的AMD数据中心和人工智能技术首发式上发表了主题演讲,以启动这一令人兴奋的新合作。

AMD和Hugging Face合作,意味着将在AMD的CPU和GPU上提供SOTA级别的transformer性能。

该合作对整个Hugging Face社区来说都是个好消息,他们将很快从最新的AMD平台的训练和推理中受益。

在GPU方面,AMD和Hugging Face将首先在企业级Instinct MI2xx和MI3xx系列上合作,然后在客户级Radeon Navi3x系列上合作。

在最初的测试中,AMD最近报告,MI250训练BERT-Large的速度比其竞争对手快1.2倍,训练GPT2-Large快1.4倍。

在CPU方面,两家公司将致力于为客户端Ryzen和服务器EPYC CPU优化推理。

最后,他们的合作将包括性能强大的Alveo V70 AI加速器。

HuggingFace计划支持最先进的自然语言处理、计算机视觉和语音的转化器架构,如BERT、DistilBERT、ROBERTA、Vision Transformer、CLIP和Wav2Vec2。

当然,生成式AI模型也将可用(例如,GPT2、GPT-NeoX、T5、OPT、LLaMA),包括HuggingFace自己的BLOOM和StarCoder模型。

最后,HuggingFace还将支持更多传统的计算机视觉模型,如ResNet和ResNext,以及深度学习推荐模型,这对HuggingFace来说还是头一次。

未来,合作的重点将放在确保对HuggingFace社区最重要的模型能在AMD的平台上开箱即用。

HuggingFace将与AMD工程团队密切合作,优化关键模型,以提供最佳性能,这得益于最新的AMD硬件和软件功能。

HuggingFace将把AMD的ROCm SDK无缝集成到HuggingFace的开源库中,首先是transformer库。

参考资料:

https://www.cnbc.com/2023/06/13/amd-reveals-new-ai-chip-to-challenge-nvidias-dominance.html