一直以来,量子计算与传统计算相比,量子计算在某些问题上提供了比传统计算更快的速度,然而在采用量子计算的过程中存在一个巨大的问题,即这些系统存在固有的噪声,就像声音会在嘈杂的录音中丢失一样。这些噪声以一种不可预测的方式改变波函数不同分支的相位,不利于量子计算的成功。因而研究人员尚未构建出性能普遍优于所有传统计算机的计算机。

对于如何管理量子计算存在的不可靠问题,现在大家比较接受的解决方案是采用容错量子电路,但这对当前的处理器又提出一个重大的挑战。

当前的量子处理器存在很大的误差问题,虽然在许多情况下出现误差的概率很小,通常低于 1%,但我们在每个量子比特上执行的每个操作,包括读取其状态这样的基本操作,都会带来显著的误差率。假如我们正在执行的操作需要很多量子比特,又或者我们需要在很少的量子比特上执行大量的操作,这些操作都会不可避免的带来误差。

从长远来看,采用纠错量子比特(error-corrected qubits)是一个很好的解决方案。然而采用这种方法需要很多高质量的量子比特来存储每一位信息,这也意味着我们需要成千上万的量子比特,然而,依据目前的技术,研究人员所能操作的量子数远低于需要的量子数,毫不夸张的说我们最早要在下个十年才能实现。

今天,IBM 的一项研究登上《Nature》封面,结果表明即使是嘈杂的量子计算机,其计算也可以比传统机器更准确。他们利用一种称为「误差缓解(error mitigation)」的技术,成功地克服了当今量子比特存在的问题,尽管系统存在噪声,但也生了准确的结果。而且,他们以一种明显优于经典计算机的方式做到了这一点。现在 IBM 的 Eagle 量子计算机完成的计算,曾经难倒了与之对战的传统超级计算机。

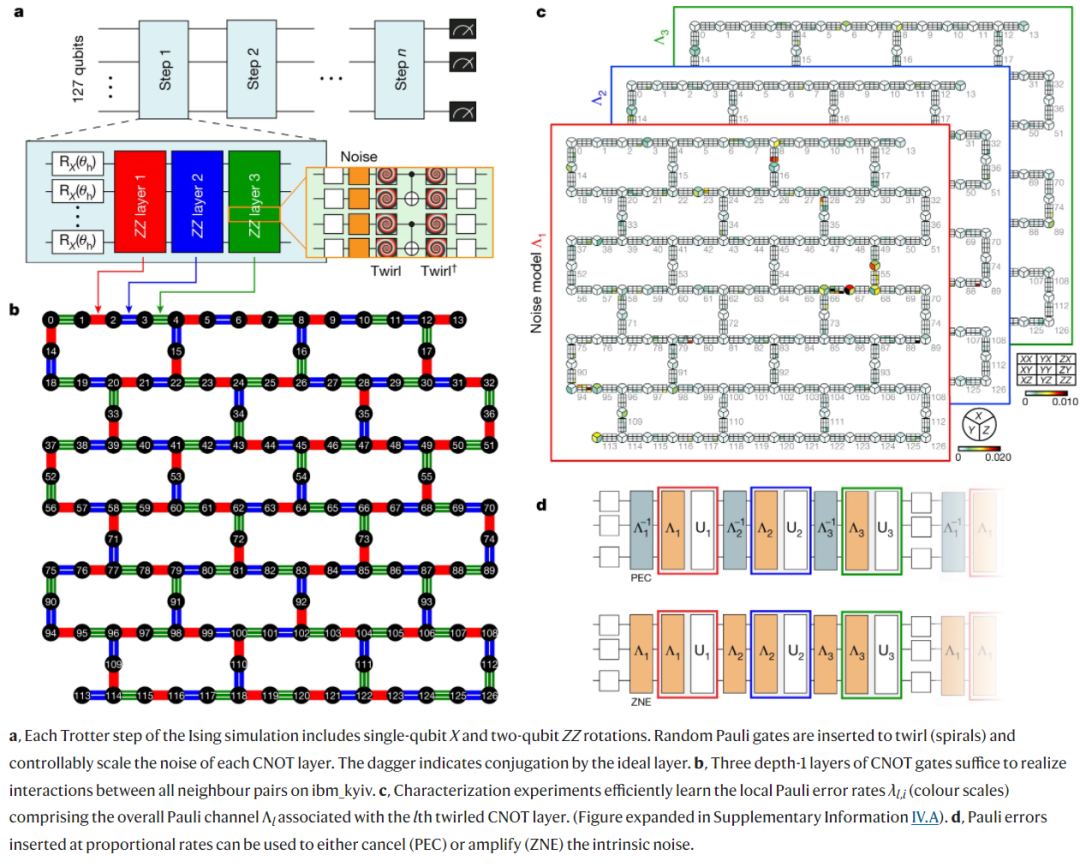

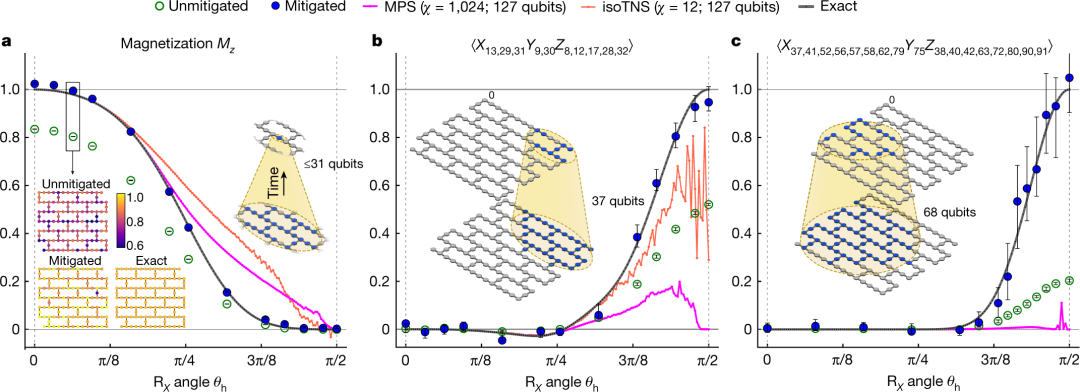

具体来讲,IBM 物理学家 Abhinav Kandala 及其合著者对每个量子比特的噪声进行了精确测量,而这些噪声遵循相对可预测、并由它们在设备内位置、制造中微观缺陷和其他因素决定的模式。利用这些知识,研究者推断出测量结果,并观察二维固体完整磁化状态在没有噪声的情况下是什么样子。然后他们能够运行涉及 Eagle 所有 127 个量子比特和多达 60 个处理步骤的计算,这要比任何其他报道的量子计算实验都要多。

论文地址:https://www.nature.com/articles/s41586-023-06096-3

结果表明,当超级计算机能够完成计算时,两种方法的结果是一致的。但是当复杂性增加到一定程度时,超级计算机就会失败,而 Eagle 仍然能够提供解决方案。

下图为 IBM 研究人员,从左到右分别是 Abhinav Kandala、Kristan Temme、Katie Pizzolato、Sarah Sheldon、Andrew Eddins 和 Youngseok Kim,以及量子计算机群。

图源:James Estrin/The New York Times

方法

如果说量子纠错是一种避免噪声的方法(避免干扰量子比特准确执行操作),那么误差缓解可以看做允许噪声的存在,然后在进行补偿。

早期的误差缓解方法(称为概率误差抵消)需要对量子处理器的行为进行采样,以建立典型噪声模型,然后从实际计算的测量输出中在减去噪声。但是随着计算中所涉及的量子比特数量增加,这种方法变得有些不切实际 —— 因为需要进行更多的采样。

因此,研究人员转向了另一种方法,他们有意放大并测量处理器在不同水平上的噪声。然后利用测量结果预估函数,该函数产生与实际测量相似的输出。之后可以将该函数的噪声设置为零,以产生在没有任何噪声情况下处理器可能执行的估计结果。

该研究使用了伊辛模型(Ising model),该模型被广泛应用于物理学,最近也被用于时间晶体、马约拉纳边缘模式的探索。其网格配置方式与其处理器上的量子比特物理排列一致。伊辛模型独立于量子硬件而存在。实验中,该研究主要使用了 IBM 的 Eagle 处理器 ibm_kyiv。

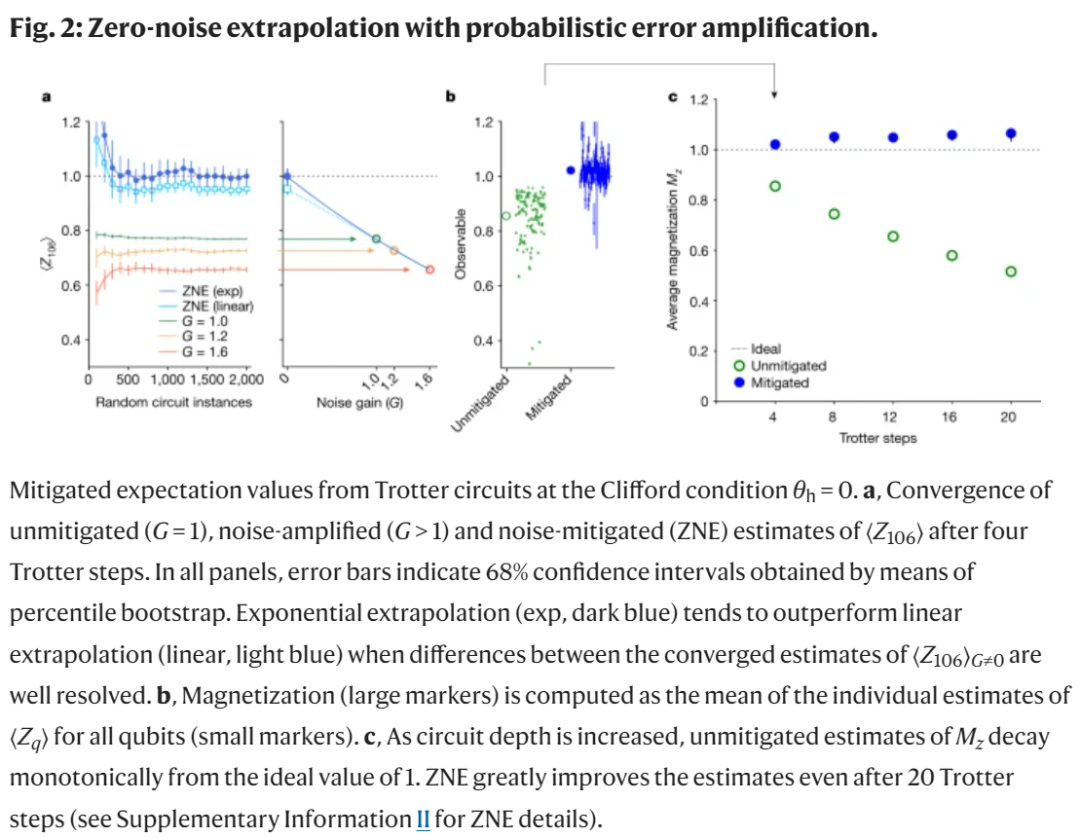

此外,该研究采用 ZNE(zero-noise extrapolation),它以低得多的采样成本提供了有偏估计器。下图为带有概率误差放大的 ZNE。

接下来,该研究测试了本文方法在 non-Clifford 电路和 Clifford θ_h = π/2 点上的有效性。

量子 VS 经典

研究者首先限制他们建模的旋转次数,以保证其行为可以在传统计算机上计算。结果表明误差缓解流程有效。一旦噪声得到补偿,量子计算的数量就与经典计算相匹配,甚至超过了十几个时间步。另外,研究者可以相对简单地将模型扩展到经典计算机(128G 的 64 核处理器)开始「挣扎」的地方。

这发生在系统需要 68 个量子比特来建模的时候。从那里开始,研究者使用软件来估计系统在经典计算机上的行为, 这使得它以一定的准确率代价来保持更长时间。即便如此,研究者仍可以将模型的大小扩展到需要 127 个量子比特(Eagle 处理器)的位置,这远远超过了经典计算机可以跟上的水平。

实验中使用 127 量子比特 Eagle 量子处理器。图源:James Estrin/The New York Times

对此,加州大学圣巴巴拉分校物理学家、2019 年带领谷歌实现量子优越性的 John Martinis 表示,这些结果验证了 IBM 的短期战略,即通过缓解而不是纠正误差来提供有用计算。从长远看,IBM 和大多数其他公司希望转向量子纠错,这种技术需要为每个数据量子比特添加大量额外的量子比特。

深远影响

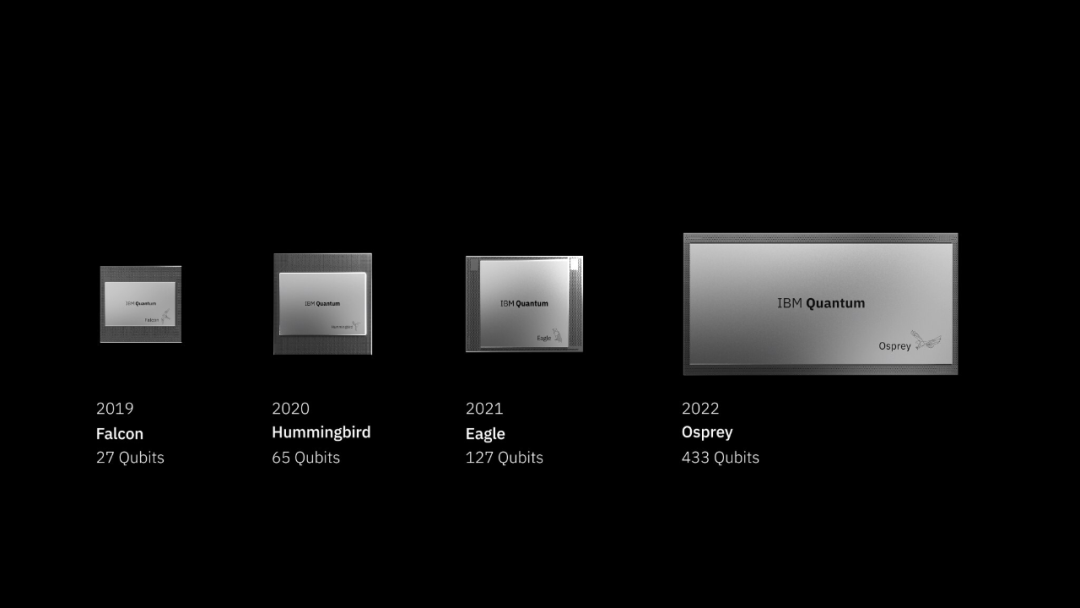

IBM 已经拥有了超过 400 个量子比特的量子处理器,那么为什么在这项研究中使用 127 个量子比特的 Eagle 呢?这是因为它是 IBM 成熟的第三代量子处理器,而 433 量子比特的 Osprey 处理器仍处于第一次迭代中。这两代量子处理器已被用于提升量子比特的性能,减少需要补偿的噪声。

下图为 IBM 量子计算机的演进历程。IBM 预计今年晚些时候推出其迄今为止最强大的处理器,即 1121 量子比特的 Condor。另外,IBM 量子技术负责人 Jay Gambetta 表示,IBM 还在其开发 pipeline 中拥有多达 4158 个量子比特的实用规模处理器。他补充道,为了实现到 2033 年建造 10 万个量子比特机器(它们可以执行完全纠错算法)的长期目标,还需要解决大量工程问题。

这引出了第二个原因:噪声补偿的计算成本很高,需要使用经典计算机来完成。相反在量子计算机上进行噪声采样只需花费 5 分钟。但即使是较小的问题,完整的降噪过程也需要 4 小时。相比之下,在经典计算机上简单地对系统建模就得 8 小时。一些较大的问题需要约 30 小时来建模,同时降噪需要 9.5 小时。

这样下来的一个结果是添加足够的量子比特也可能使得误差缓解在计算上变得难以处理。Gambetta 表示,「误差缓解依然呈指数级缩放,但它的指数级程度要弱于模拟成本。」

IBM 在这里持乐观态度有两个理由。研究者表示,首先误差缓解涉及的算法主要是经典处理延迟,它们很大程度上通过概念上直接的优化来消除。其次涉及的时间作为量子硬件中误差率函数来缩放,其中较低的误差率将加速经典计算部分。

所有这一切使得 IBM 乐观地认为,在他们可能实现纠错量子比特之前,误差缓解是在量子硬件上执行有用计算的一条路径。正如该项研究总结的那样,「即使在容错量子计算出现之前,有噪声的量子计算机也能在超过 100 量子比特和 non-trivial 电路深度的范围内产生可靠的期望值。并且从噪声限制的量子电路中获得实际的计算优势是有价值的。」