ChatGPT突然更新!

今天凌晨,OpenAI在官网上发布了所有更新细节,包含以下这几个方面:

- 在Chat Completions API中增加了新的函数调用能力

- 更新了GPT-4和GPT-3.5-Turbo版本,可操控性更强

- 为GPT-3.5-Turbo增加了16k的上下文长度(此前是4k)

- 嵌入模型成本降低75%

- GPT-3.5-Turbo的输入token成本降低25%

- 公布了GPT-3.5-Turbo-0301和GPT-4-0314模型的淘汰时间表

其中备受关注的应该就是新的函数调用能力,GPT-4和GPT-3.5-Turbo两个模型的升级,以及各种降成本。

对此,推特网友「宝玉」表示,OpenAI这次更新的函数调用功能,本质上是让API直接支持了Agent或者Plugin。

函数调用

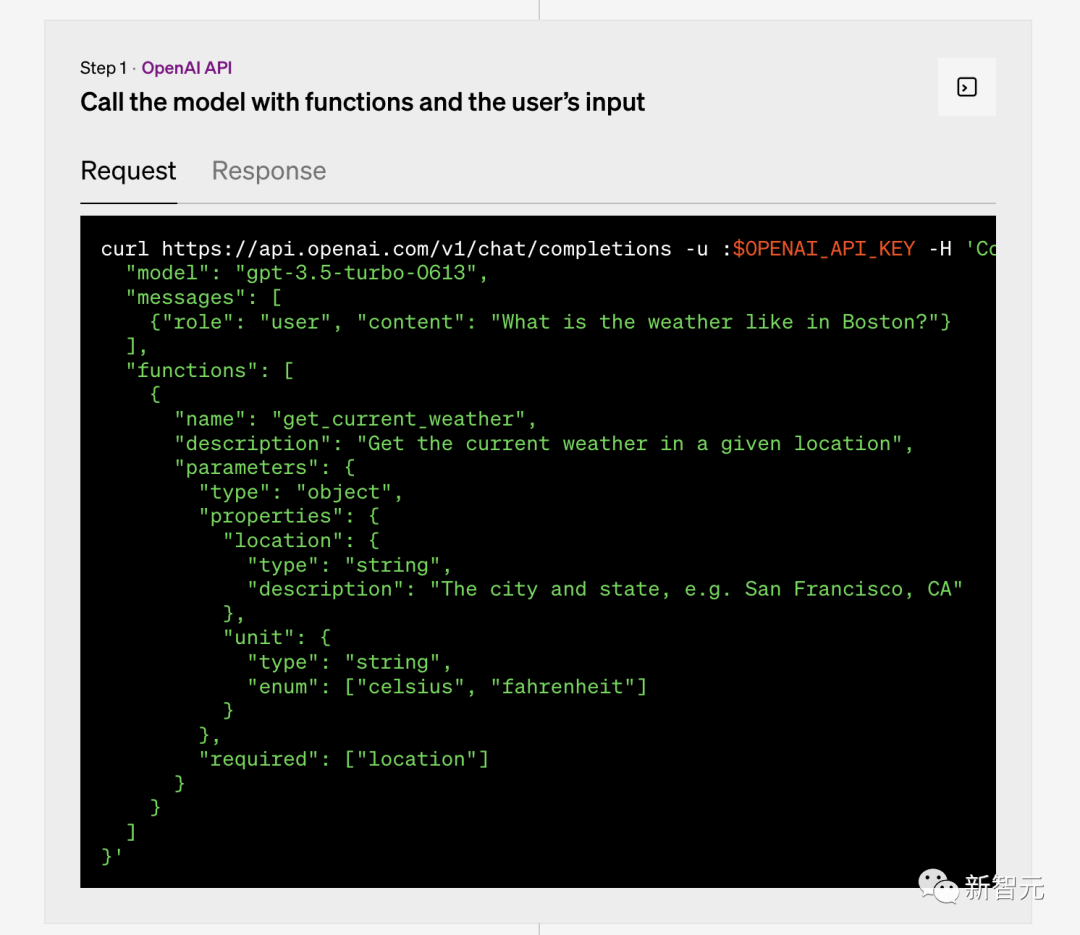

现在,开发者现在可以向GPT-4-0613和GPT-3.5-turbo-0613描述函数,并让模型智能地选择输出包含调用这些函数的参数的JSON对象。

这是一种更可靠地将GPT的功能与外部工具和API相连的新方法。

这些模型已经过微调,既能检测到何时需要调用函数(取决于用户输入的内容),又能用符合函数签名的JSON来进行响应。

函数调用允许开发者更可靠地从模型中获得结构化的数据。

比如,开发者可以创建一个聊天机器人,通过调用外部工具(例如,ChatGPT插件)来回答问题。

具体来说,可以将诸如「给Anya发邮件,看她下周五是否想喝咖啡」这样的查询转换为send_email(to: string, body: string)这样的函数调用。

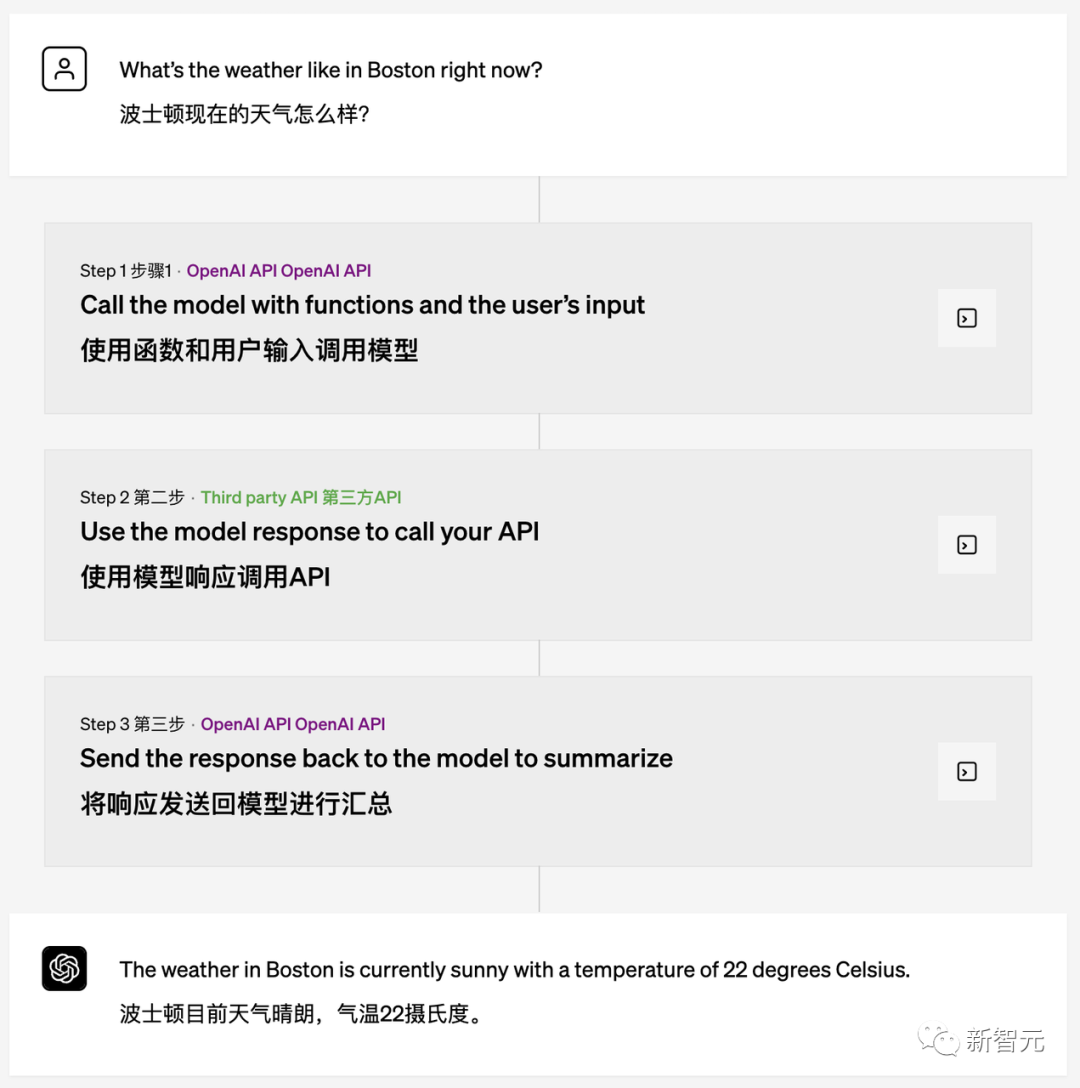

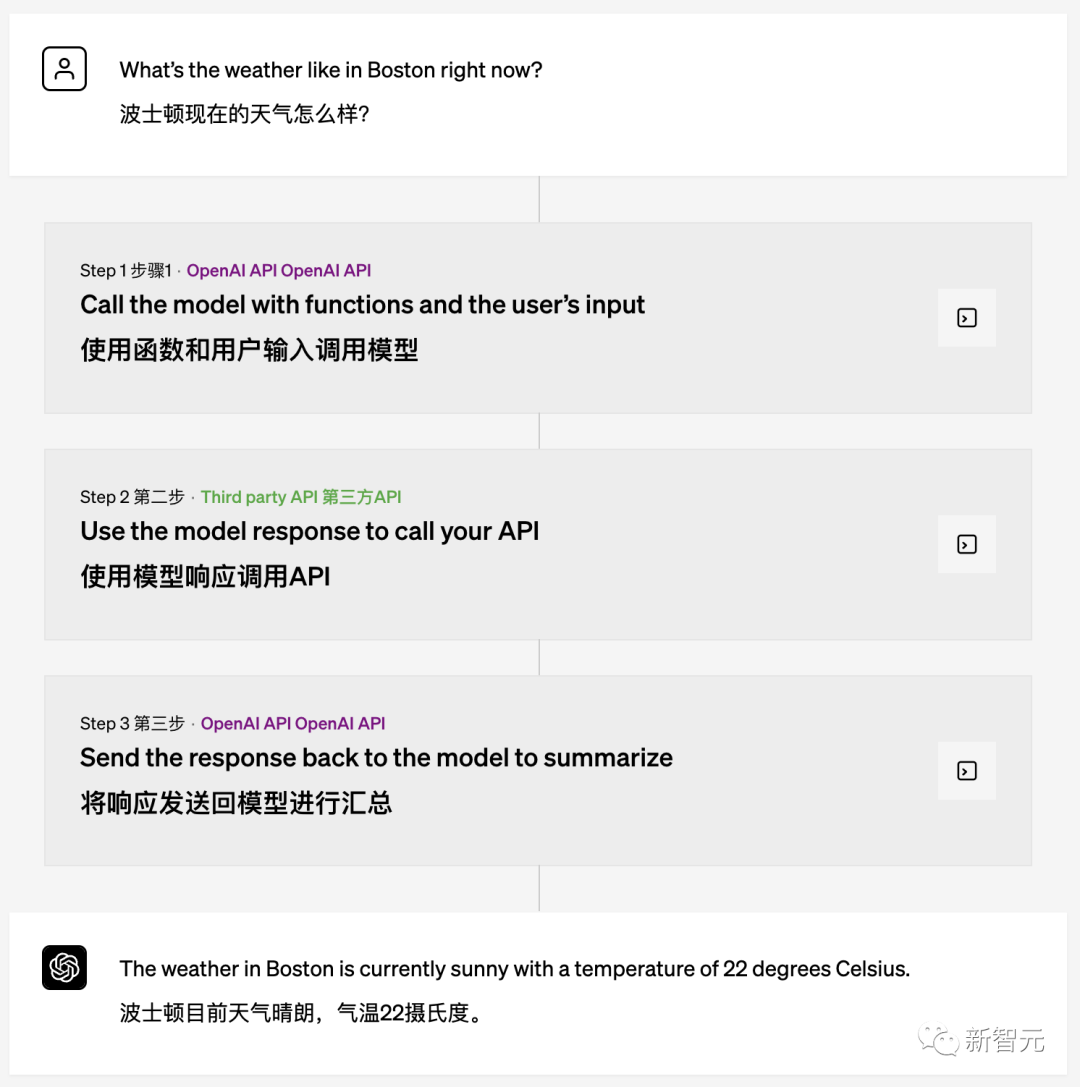

或者将「波士顿的天气如何?」转换为get_current_weather(location: string, unit: 'celsius' | 'fahrenheit')。

此外,开发者还能将自然语言转换为API调用或者数据库查询。

比如,将「谁是我这个月的十大客户?」转换为内部API调用,即为:get_customers_by_revenue(start_date: string, end_date: string, limit: int)。

又或者把「Acme, Inc.上个月有多少订单?」转换成SQL查询,即为:sql_query(query: string)。

此外,还允许开发者从文本中提取结构化数据。

只需定义一个名为extract_people_data(people: [{name: string, birthday: string, location: string}]的函数,就能提取维基百科文章中提到的所有人物。

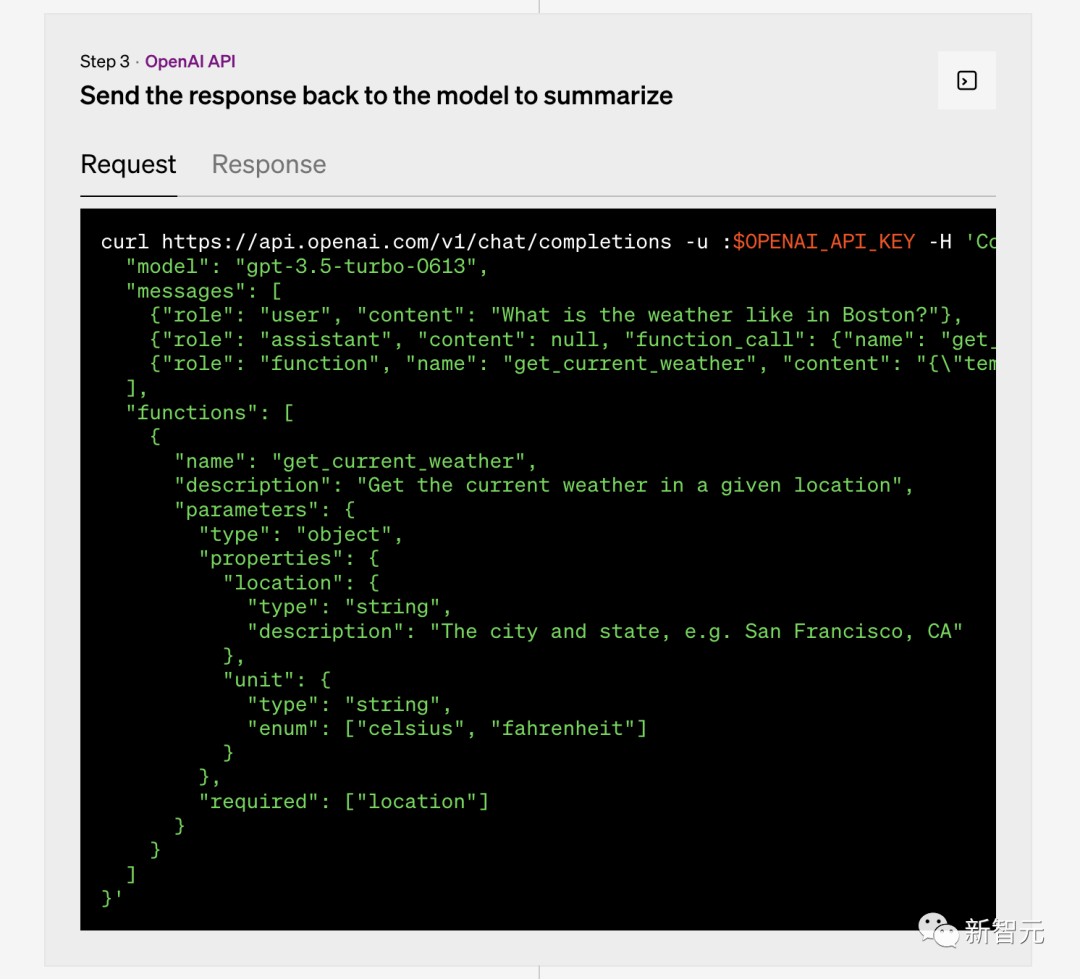

以前用户需要在Prompt里加一堆描述才能支持Agent,而现在就简单多了,只要在API请求的时候,传入一个functions参数即可。

functions参数实际上就类似于用户要指定的Agent。

注意,这里可以是不止一个function,function是一个对象,还可以加上名称(name)、描述(description)、参数(parameters)等等。

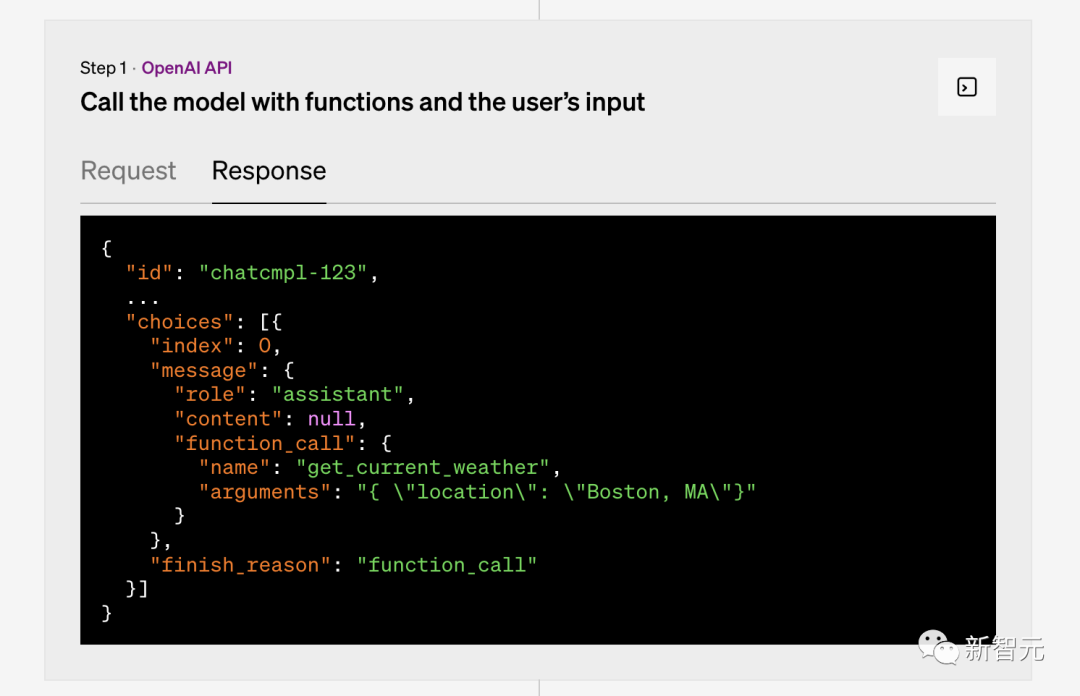

然后,返回的结果就包含了如下结构化的内容:

function_call:调用的函数名,和用户传入的函数名称一致

arguments:JSON格式的参数值,包含了用户调用函数需要的参数名称和值。

比如说:

"function_call": { "name": "get_current_weather", "arguments": "{ \"location\": \"Boston, MA\"}" }

国外网友表示,function最大的价值就是解决了GPT返回数据结构化的问题,不再需要用户输入复杂的prompt。

第一步:OpenAI API

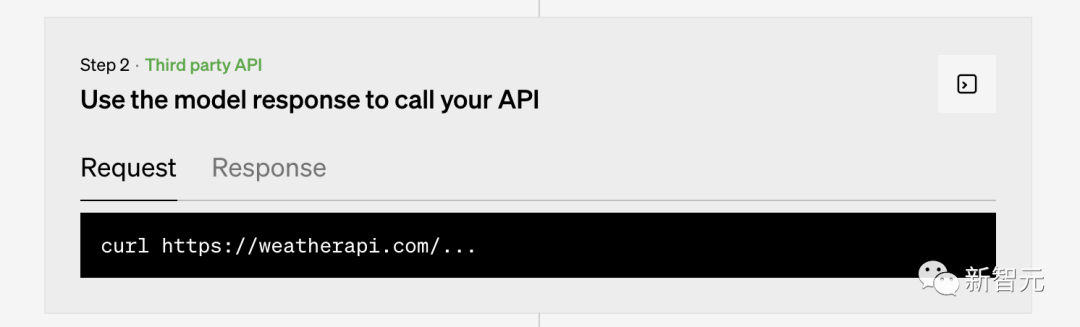

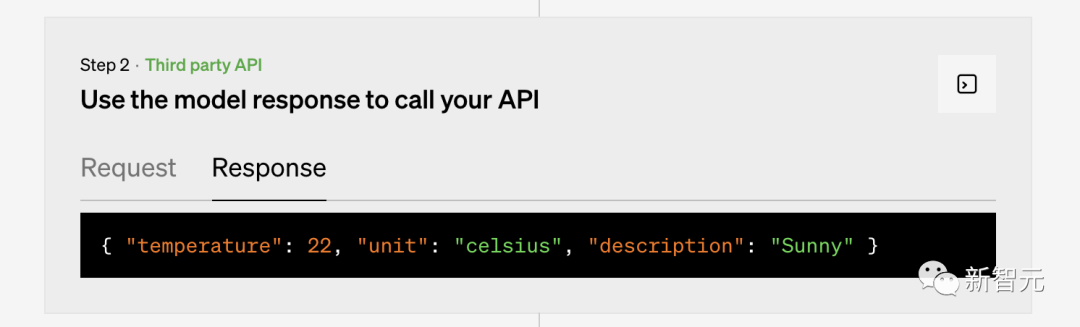

第二步:第三方API

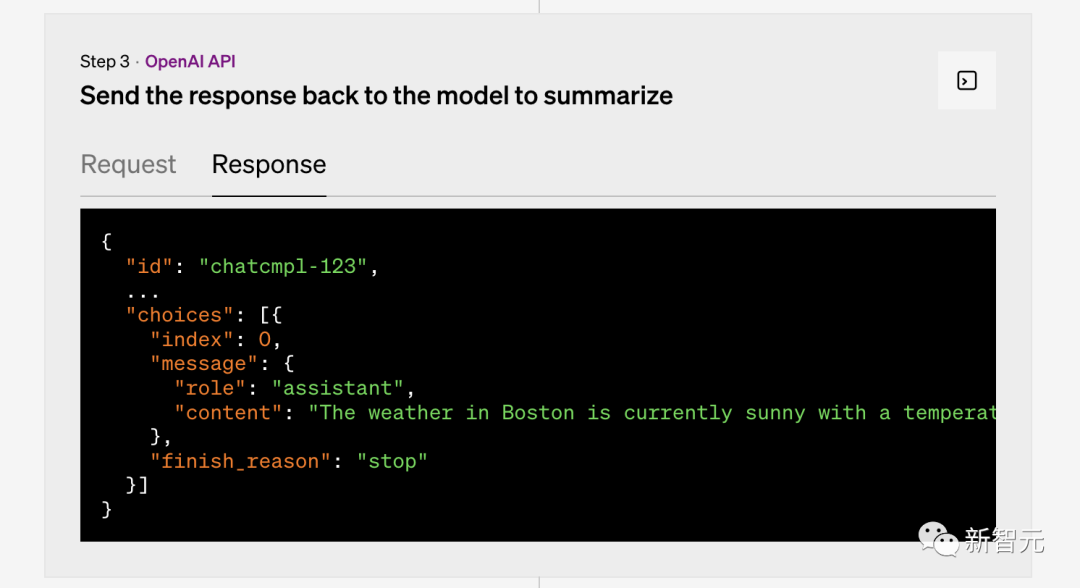

第三步:OpenAI API

模型升级

GPT-4

GPT-4-0613的主要更新就是上面提到的全新函数调用功能。

而GPT-4-32k-0613的更新,除了包含GPT-4-0613的所有更新内容以外,还新增加了更长的上下文长度,从而能更好地理解更长篇幅的文本。

OpenAI表示,未来几周内,将会有更多目前在等待名单上的人可以开始使用GPT-4.

GPT-3.5 Turbo

GPT-3.5-turbo-0613的更新中具备与GPT-4相同的函数调用功能,并通过系统信息提供了更高的可控性。

这两个特性将使开发者能够更有效地引导GPT模型生成的回复。

GPT-3.5-turbo-16k相较于GPT-3.5-turbo拥有4倍的上下文长度,但成本是前者的两倍。

每1000个token输入的费用为0.003美元,每1000个输出token的费用为0.004美元。

16k的上下文长度意味着该模型现在能够在单次对话中支持约20页长度的文本。

同时,OpenAI表示,新模型将于6.27正式上线,而旧模型将于今年9.13后无法再次访问。

价格更低

最后,OpenAI发布的价格降低的新消息也让不少用户为之一动。

text-embedding-ada-002是OpenAI最受欢迎的嵌入模型。今天我们将成本降低了75%,每1,000个token费用为0.0001美元。

而作为最受欢迎的聊天模型——GPT-3.5-turbo,其输入的token费用降低了25%。

开发者现在能以0.0015美元/1000个输入token的价格使用该模型,每1000个输出token费用为0.002美元,相当于每美元大约能使用700页。

GPT-3.5-turbo-16k的定价为0.003美元/每1000个输入token,而每1000个输出token费用为0.004美元。

参考资料:https://openai.com/blog/function-calling-and-other-api-updates