目录:

- Faster sorting algorithms discovered using deep reinforcement learning

- Video-LLaMA: An Instruction-tuned Audio-Visual Language Model for Video Understanding

- Patch-based 3D Natural Scene Generation from a Single Example

- Spatio-temporal Diffusion Point Processes

- SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression

- UniControl: A Unified Diffusion Model for Controllable Visual Generation In the Wild

- FrugalGPT: How to Use Large Language Models While Reducing Cost and Improving Performance

论文 1:Faster sorting algorithms discovered using deep reinforcement learning

- 作者:Daniel J. Mankowitz 等

- 论文地址:https://www.nature.com/articles/s41586-023-06004-9

摘要:「通过交换和复制移动,AlphaDev 跳过了一个步骤,以一种看似错误,但实际上是捷径的方式连接项目。」这种前所未见、违反直觉的思想不禁让人回忆起 2016 年那个春天。

七年前,AlphaGo 在围棋上击败人类世界冠军,如今 AI 又在编程上给我们上了一课。Google DeepMind CEO 哈萨比斯的两句话引爆计算机领域:「AlphaDev 发现了一种全新且更快的排序算法,我们已将其开源到主要 C++ 库中供开发人员使用。这只是 AI 提升代码效率进步的开始。」

推荐:AI 重写排序算法,速度快 70%:DeepMind AlphaDev 革新计算基础,每天调用万亿次的库更新了

论文 2:Video-LLaMA: An Instruction-tuned Audio-Visual Language Model for Video Understanding

- 作者:Hang Zhang 等

- 论文地址:https://arxiv.org/abs/2306.02858

摘要:近期,大语言模型展现出了令人瞩目的能力。我们能否给大模型装上 “眼睛” 和 “耳朵”,让它能够理解视频,陪着用户互动呢?

从这个问题出发,达摩院的研究人员提出了 Video-LLaMA,一个具有综合视听能力大模型。Video-LLaMA 能够感知和理解视频中的视频和音频信号, 并能理解用户输入的指令,完成一系列基于音视频的复杂任务,例如音 / 视频描述,写作,问答等。目前论文,代码,交互 demo 都已开放。另外,在 Video-LLaMA 的项目主页中,该研究团队还提供了中文版本的模型,让中文用户的体验更丝滑。

下面两个例子展示了 Video-LLaMA 的视听综合感知能力,例子中的会话围绕有声视频展开。

论文 3:Patch-based 3D Natural Scene Generation from a Single Example

- 作者:Weiyu Li 等

- 论文地址:https://arxiv.org/abs/2304.12670

摘要:北京大学陈宝权团队联合山东大学和腾讯 AI Lab 的研究人员,提出了首个基于单样例场景无需训练便可生成多样高质量三维场景的方法。

推荐:CVPR 2023 | 三维场景生成:无需任何神经网络训练,从单个样例生成多样结果。

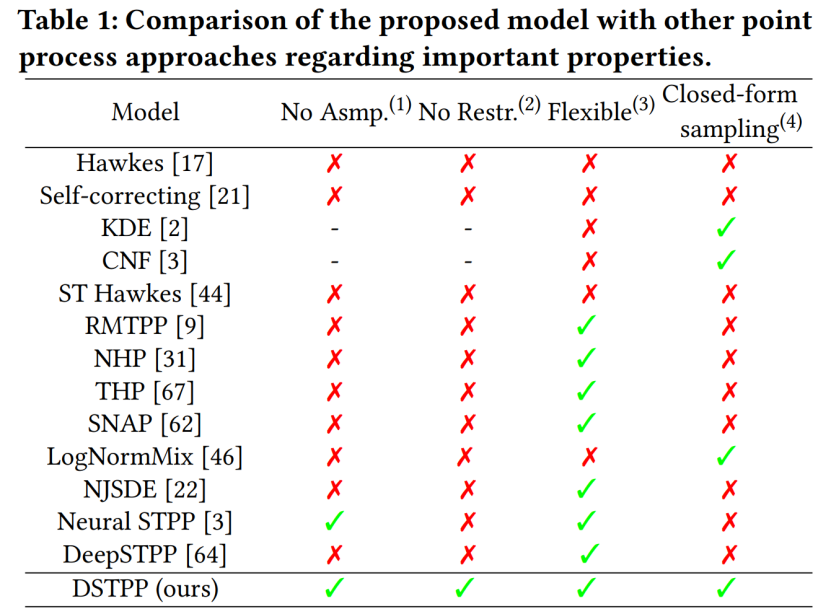

论文 4:Spatio-temporal Diffusion Point Processes

- 作者:Yuan Yuan 等

- 论文地址:https://arxiv.org/abs/2305.12403

摘要:清华电子工程系城市科学与计算研究中心最新提出时空扩散点过程,突破已有方法建模时空点过程的受限概率形式和高采样成本等缺陷,实现了灵活、高效且易于计算的时空点过程模型,可广泛用于城市自然灾害、突发事故和居民活动等时空事件的建模与预测,促进城市规划和管理的智能化发展。下表展示 DSTPP 相比已有点过程解决方案的优势。

推荐:扩散模型还能预测地震和犯罪?清华团队最新研究提出时空扩散点过程。

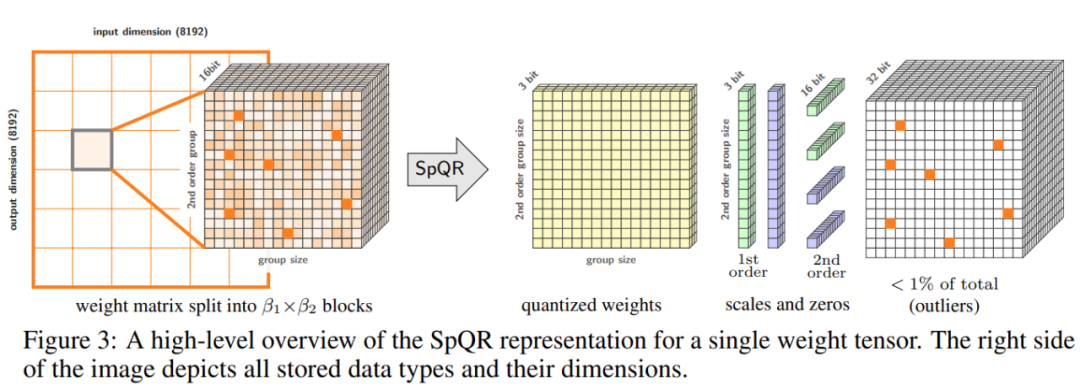

论文 5:SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression

- 作者:Tim Dettmers 等

- 论文地址:https://arxiv.org/pdf/2306.03078.pdf

摘要:为了解决准确性问题,来自华盛顿大学、苏黎世联邦理工学院等机构的研究者提出了一种新的压缩格式和量化技术 SpQR(稀疏 - 量化表征),首次实现了 LLM 跨模型尺度的近无损压缩,同时达到了与以前方法相似的压缩水平。

SpQR 通过识别和隔离异常权重来工作,这些异常权重会导致特别大的量化误差,研究者将它们以更高的精度存储,同时将所有其他权重压缩到 3-4 位,在 LLaMA 和 Falcon LLMs 中实现了不到 1% 的困惑度相对准确率损失。在单个 24GB 的消费级 GPU 上运行 33B 参数的 LLM,而不会有任何性能下降,同时还能提高 15% 的速度。下图 3 为 SpQR 的总体架构。

推荐:将 330 亿参数大模型「塞进」单个消费级 GPU,加速 15%、性能不减。

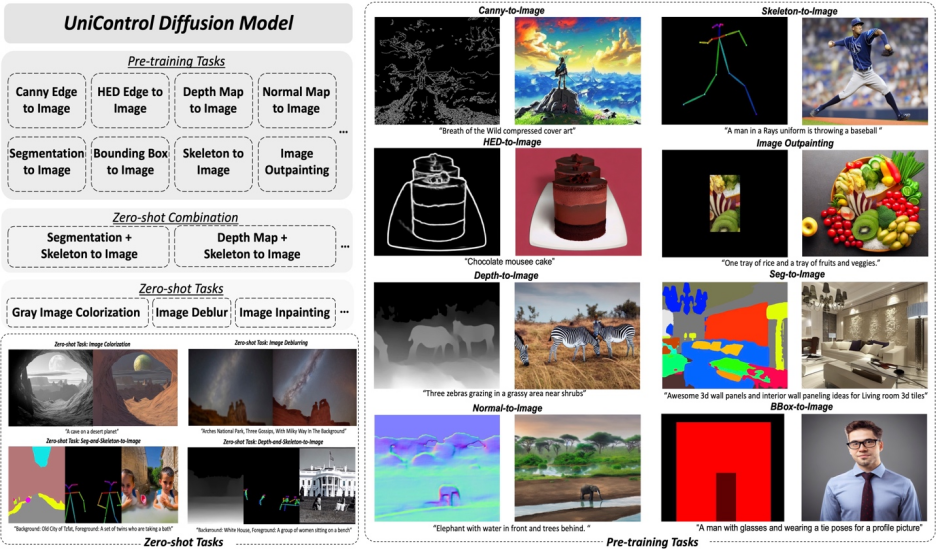

论文 6:UniControl: A Unified Diffusion Model for Controllable Visual Generation In the Wild

- 作者:Can Qin 等

- 论文地址:https://arxiv.org/abs/2305.11147

摘要:本文中,Salesforce AI、东北大学、斯坦福大学的研究者提出了 MOE-style Adapter 和 Task-aware HyperNet 来实现 UniControl 中的多模态条件生成能力。UniControl 在九个不同的 C2I 任务上进行训练,展示了强大的视觉生成能力和 zero-shot 泛化能力。UniControl 模型由多个预训练任务和 zero-shot 任务组成。

推荐:多模态可控图片生成统一模型来了,模型参数、推理代码全部开源。

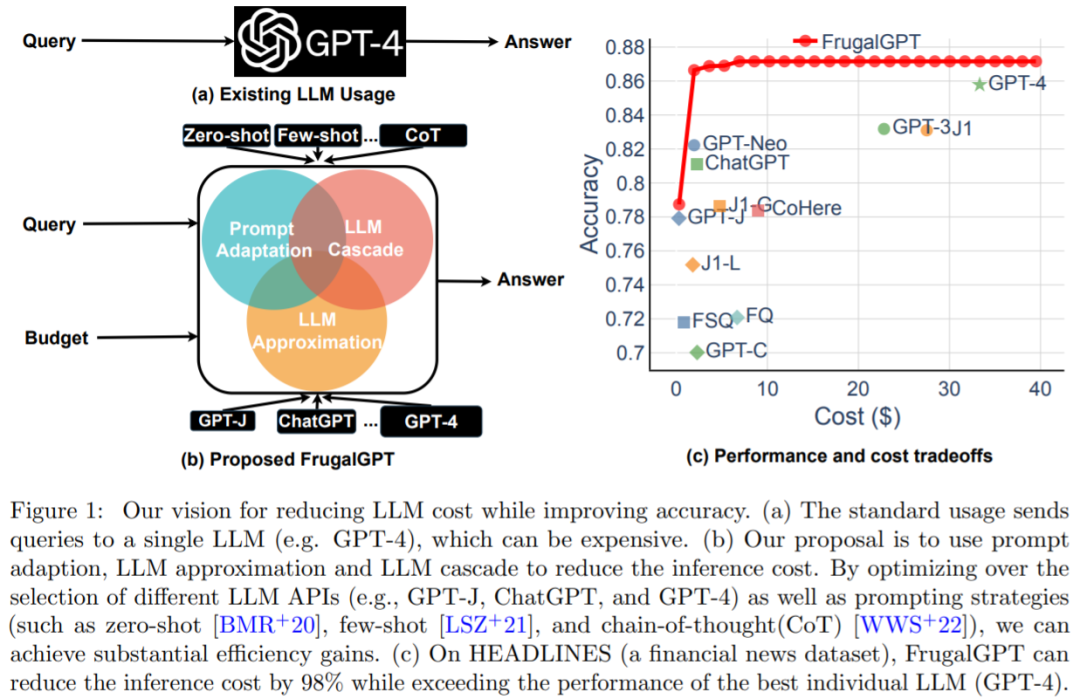

论文 7:FrugalGPT: How to Use Large Language Models While Reducing Cost and Improving Performance

- 作者:Lingjiao Chen 等

- 论文地址:https://arxiv.org/pdf/2305.05176.pdf

摘要:成本和准确性之间的平衡是决策制定的关键因素,尤其是在采用新技术时。如何有效和高效地利用 LLM 是从业者面临的关键挑战:如果任务相对简单,那么聚合来自 GPT-J (其规模比 GPT-3 小 30 倍)的多个响应可以实现与 GPT-3 类似的性能,从而实现成本和环境上的权衡。然而,在较为困难任务上,GPT-J 的性能可能会大大下降。因此,如何经济高效地使用 LLM 需要采用新的方法。

最近的一项研究尝试提出解决这一成本问题的方法,研究者通过实验表明,FrugalGPT 可以与最佳个体 LLM(例如 GPT-4) 的性能相媲美,成本降低高达 98%,或者在相同成本下将最佳个体 LLM 的准确性提高 4%。该研究讨论了三种降低成本的策略,即 prompt 适应、LLM 近似和 LLM 级联。

推荐:GPT-4 API 平替?性能媲美同时成本降低 98%,斯坦福提出 FrugalGPT,研究却惹争议。