ThinkGPT是一款创新的Python库,它增强了大型语言模型的能力,使它们能够更有效地思考、推理和行动。如果你渴望将ThinkGPT集成到你的Python脚本中,并利用它先进的功能,那么请阅读本文。本文将指导你完成在Python项目中使用ThinkGPT的第一步。

我们将探索ThinkGPT的核心功能,包括其先进的记忆能力、自我完善机制和高阶推理能力。你将能够发现这个创新的库如何改变AI开发局面的,以及学习如何利用它的力量增强自己的项目。

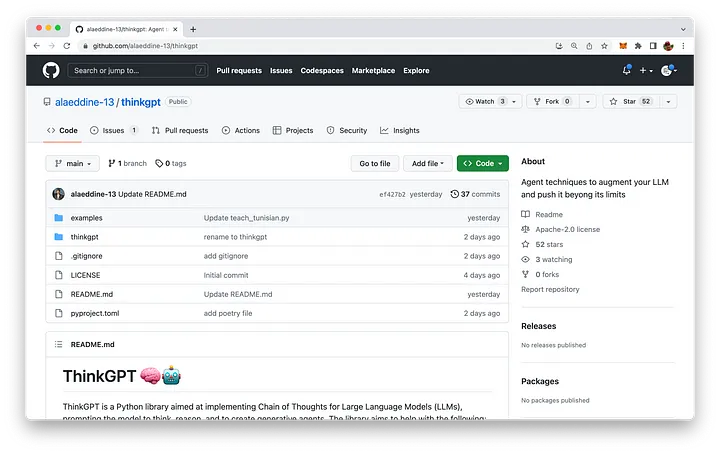

ThinkGPT托管在GitHub上。代码库可以在以下网址中找到:https://github.com/alaeddine-13/thinkgpt。

ThinkGPT的主要特点

- 记忆:ThinkGPT使大型语言模型(LLM)能够记住经验并学习新的概念。

- 自我完善:该功能允许模型通过解决批评、修复问题和完善其理解来改进生成的内容。

- 抽象:鼓励LLM从示例或观察中概括出规则,帮助创造压缩的知识,更好地适应模型有限的上下文长度。

- 推理:使LLM能够根据现有的信息做出有根据的猜测。

- 自然语言条件:用户可以轻松地用自然语言表达任务和条件,使模型能够做出智能决策。

- 易于设置和Pythonic API:由于DocArray的存在,ThinkGPT提供了一个极其简单的设置过程和一个Pythonic API。

安装

安装ThinkGPT很简单,可以使用pip进行安装:

该命令将直接从GitHub代码库安装ThinkGPT库。

在Python脚本中使用ThinkGPT的第一步

安装完成后,你就可以开始在Python脚本中使用ThinkGPT。要做到这一点,只需从thinkgpt.llm模块中导入ThinkGPT类并创建该类的一个新实例即可:

这段代码片段使用指定的模型(在本例中为“gpt-3.5-turbo”)初始化了一个新的ThinkGPT实例。

有了ThinkGPT实例,你现在可以使用memorize()方法来教授你的AI模型新的概念或事实:

为了调用记忆的信息,你可以使用remember()方法:

一旦AI模型学习了一些信息,你就可以使用predict()方法基于记忆数据进行预测或回答问题:

这段代码片段使用remember()方法来检索记忆信息,并将其反馈给predict()方法来回答问题。

实际示例

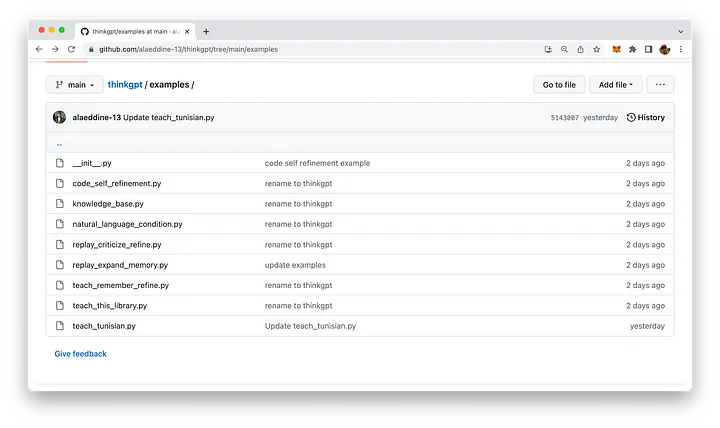

ThinkGPT附带了一些易于理解的使用示例。相应的Python脚本可以在代码库的example文件夹中找到:

让我们深入研究一下其中提供的一个示例:replay_expand_memory.py:

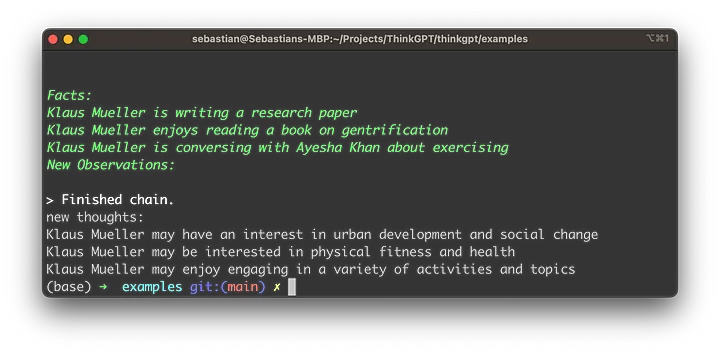

在这个ThinkGPT示例脚本中,目标是基于Klaus Mueller的现有信息使用ThinkGPT库诱导新的思考或观察。

- 首先,该脚本从thinkgpt.llm模块中导入ThinkGPT类。

- 创建一个新的ThinkGPT实例,并使用“gpt-3.5-turbo”模型进行初始化。

- 定义old_memory变量,其中包含有关Klaus Mueller的三个陈述,表示以前的知识。

- 使用memorize()方法来教授大型语言模型(LLM)存储在old_memory中的信息。

- 调用infer()方法,并将facts参数设置为remember()方法的结果。这会指示LLM基于先前记忆的信息诱导新的观察或思考。

- 新诱导出的观察结果在“new thoughts:”标签下输出到控制台。

- 最后,再次调用memorize()方法,将新的观察结果存储在LLM的内存中,使其能够在未来的交互中建立起对Klaus Mueller的理解。

在执行脚本并查看结果之前,我们需要获取OpenAI API密钥并设置相应的环境变量OPENAI_API_KEY的密钥值。

要获取OpenAI API密钥,请按照以下简单步骤操作:

- 请访问OpenAI网站https://www.openai.com/。

- 如果没有帐户,请注册一个帐户。在首页右上角点击“注册”,并按照注册流程操作。

- 注册或登录后,通过点击页面顶部的“API”或访问https://www.openai.com/api/来导航到API部分。

- 查看可用的API定价计划,并选择适合你需求的计划。某些计划可能提供带有有限使用的免费访问权限,而其他计划根据你的要求和预算提供不同级别的访问权限。

- 选择一个计划后,将提供你的唯一API密钥。请确保保密,因为它授予你的账户使用限制和特权的API访问权限。 在命令行中使用以下命令来设置OpenAI API密钥:

现在我们已经准备好执行脚本了,只需输入以下命令:

然后,你应该能够看到类似于以下的结果:

总结

ThinkGPT是一款强大的Python库,它通过添加先进的记忆、自我完善、抽象和推理功能,增强了大型语言模型的能力。它对用户友好的安装过程和Pythonic API使它成为许多AI项目的有价值的补充。通过探索本文提供的实际示例,你可以利用ThinkGPT的能力,彻底改变你的AI思考方式、得出结论和采取行动的方式。