3月,千名大佬签署暂停「超级AI」研发的联名信,让整个业界为之震惊。

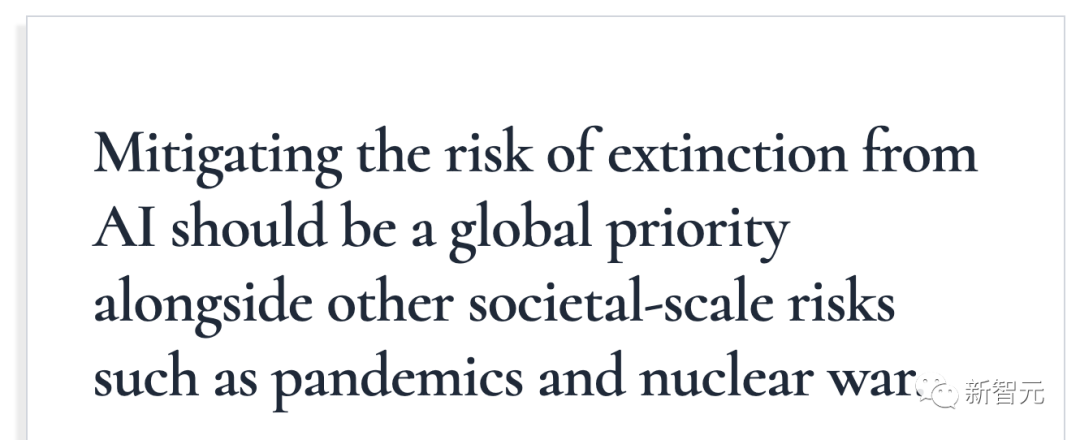

就在昨天,一封只有22个字的联名信再次引起轩然大波。

寥寥数语,把AI类比为了传染病和核战争,分分钟灭绝人类的那种。

签名者中,有Hinton和Bengio两位人工智能的「教父」,还有硅谷巨头的高管,Sam Altman、Demis Hassabis等在人工智能领域工作的研究人员。

截止目前,已经有370多名从事人工智能高管都签署了这份联名信。

然而,这封信并不是得到所有人的支持。

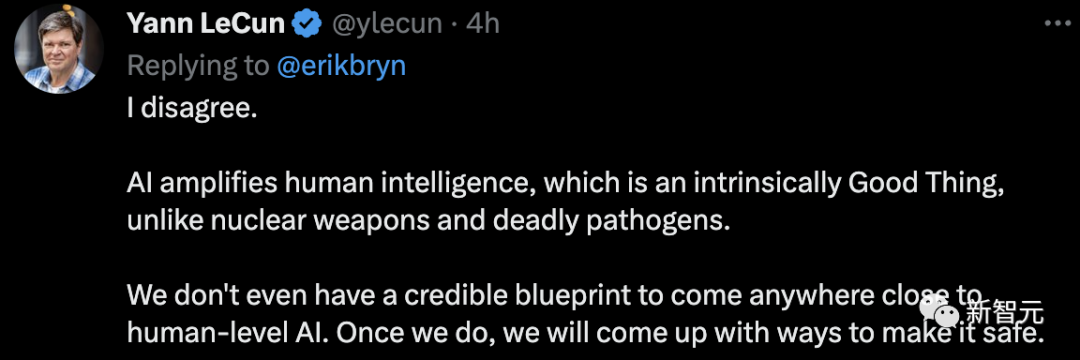

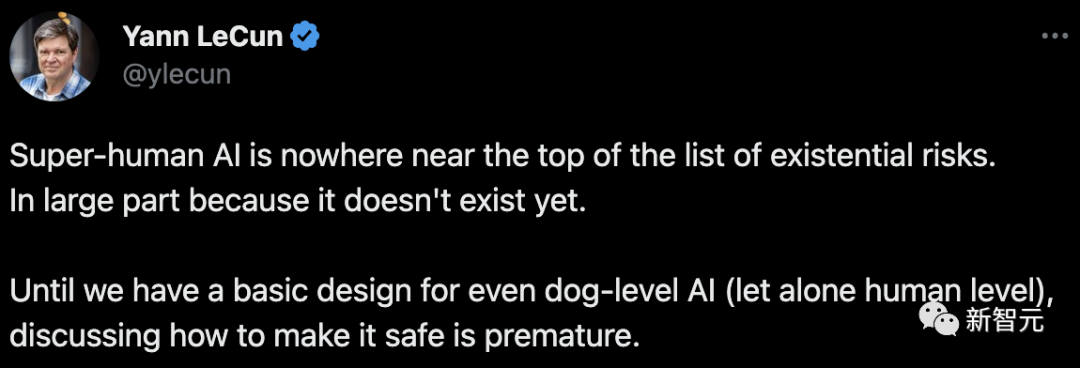

「图灵三巨头」中的一位LeCun直言:我不同意。

「人工智能放大了人类的智慧,这在本质上是一件好事,与核武器和致命的病原体不同。我们甚至没有一个可靠的蓝图来创造接近人类水平的人工智能。一旦我们做到了,我们会想出让它安全的方法。」

这封联名信究竟说了啥?

「致命」公开信

22字,言简意赅:

「降低AI给人类带来灭绝的风险,应该被提到全球级别的优先程度。就像我们应对传染病、核战争这种社会危机一样。」

而签署这封公开信的AI界人士一眼根本望不到头。

赫然映入眼帘的就是Geoffrey Hinton,Yoshua Bengio,谷歌DeepMind的CEO Demis Hassabis,OpenAI的CEO Sam Altman,Anthropic的CEO Dario Amodei。

这里面Hinton的含金量不用多说,前谷歌副总裁、深度学习泰斗、神经网络之父,以及图灵奖获得者。

Yoshua Bengio同样也是图灵奖获得者,和Hinton,LeCun被合称为图灵奖三巨头。(然而LeCun在这件事上和另两个巨头态度截然相反)

除了在科技巨头公司任职的大佬,还不乏知名AI学者。比如UC伯克利的Dawn Song,清华大学的张亚勤。

而在这些耳熟能详的名字下面,就是数不胜数的AI界人士了。

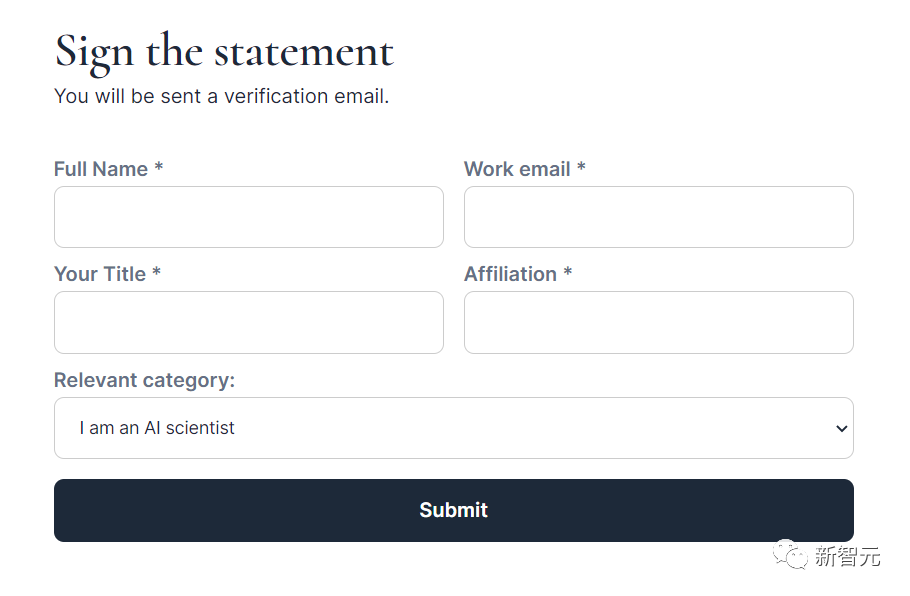

甚至,每个人都可以参与签署这封公开信。

只要填写姓名、邮箱、职位等等信息,就可以参与签署了。

不过,可以选择的身份并不多。(狗头)

反对:灭绝人类纯扯淡

当然,Meta首席科学家LeCun还是一如既往地「唱唱反调」。

他一向的观点都是:现在的AI发展刚哪儿到哪儿啊,就天天把威胁和安全挂在嘴边。

他表示,所列出的威胁,根本不是现在AI发展的水平能达到的,因为压根不存在。在我们基本设计出狗级别的人工智能(更不用说人类级别)之前,讨论如何使其安全还为时过早。

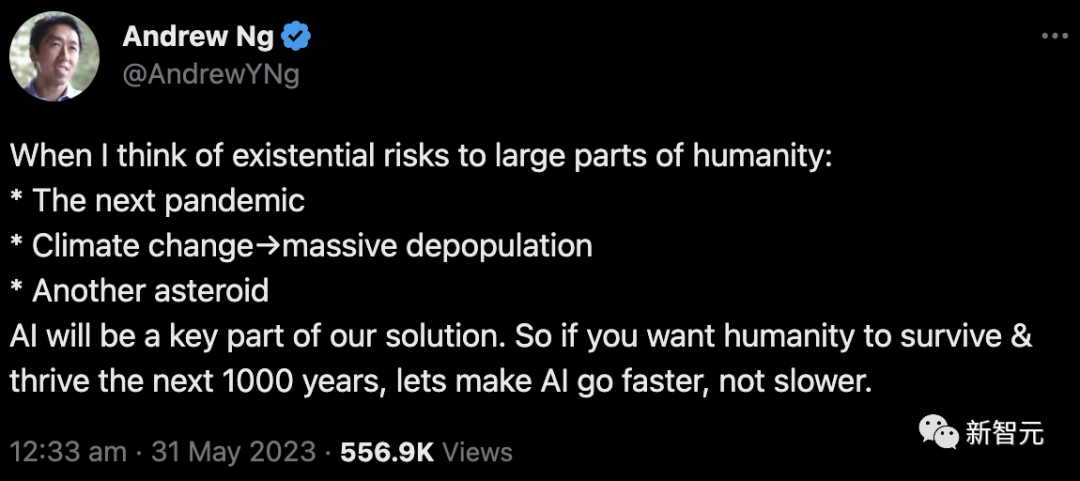

斯坦福大学的吴恩达立场和LeCun相同,但理由却有点不同。

他认为,不是AI会导致各种各样的问题,而是我们将会遇到的各种各样的问题只能靠AI来解决。

比如:下一次传染病爆发,气候变化导致的人口减少,小行星撞地球等等。

他表示,人类想继续生存、繁荣下去,得加速AI的发展,而不是减慢。

也有网友评论,你说的这个不是AI,而是MAGIC(魔法)吧。

AI风险面面观

那么,这些大牛们所宣称的足以灭绝人类的风险包括什么呢?

他们总结了以下8个方面。

武器化

部分人可能会将AI用于带有破坏性的地方,会导致人类生存的风险,加剧政治动荡。

比方说,现在深度强化学习的技术已经可以应用于空战了,机器学习能用于制造化学武器(已有论文表明,GPT-4可以在实验室中自主进行实验、合成化学品)。

此外,近年来研究人员一直在开发用于自动进行网络打击的AI系统,还有军方领导人想要让AI控制核发射井。

因此,未来AI强国会占据战略优势,各国之间的军备竞赛会转向AI领域。就算大部分国家都确保各自构建的系统是安全的,且不会威胁他国安全,仍然可能有国家蓄意用AI做坏事,造成伤害。

这给人的感觉就像核武器,有一个不听话不老实的就全白玩儿。

因为数字领域的危害传播速度很快。

信息误传

信息误传这个事情大家早就有所耳闻。远的不说,前一阵子美国律师用ChatGPT打官司,结果举的案例有6个都是杜撰的例子,现在还热乎着。

而有影响力的集体,比如国家、政党、组织,有能力用AI来影响(通常是潜移默化地)并改变普通人的政治信仰、意识形态等等。

同时AI本身也有能力生成非常有煽动性(或者说有说服力)的观点,激起用户强烈的情绪。

而这些预想的可能后果是完全不可预料的,不得不防。

代理「把戏」

AI系统根据具象的目标进行训练,而这些目标只是我们人类所重视的东西的间接代理。

就好像AI经过训练,就可以给用户推送他们爱看的视频或文章一样。

但并不代表,这种方式就是好的。推荐系统可能会导致人们的想法越来越极端,也更容易预测每个用户的偏好。

而随着未来AI的性能越来越强、影响越来越大,我们拿来训练系统的目标也必须更加仔细的确认。

人类「退化」

如果看过「机器人总动员」这部电影,我们就能想象未来时代,机器越来越强,人类是一副什么样子。

大腹便便、身体素质低下、毛病一堆。

就是因为,什么都交给AI了,人类自然就要「退化」了。

尤其是,在大量岗位被AI的自动化所取代的未来图景下,这种场面更成为可能中的很可能。

不过,按LeCun的观点,估计又得批驳一番。咱离「机器人总动员」想象的场景还差得远。

技术垄断

与技术本身无关,这一点强调的是可能会出现的「技术垄断」。

也许有一天,最强大的AI由越来越少的利益相关者所掌控,使用权也被他们牢牢地捏在手心。

而真到了那一步的话,剩下的普通人就只能处在一个任人摆布的状态,因为根本反抗不了。

想想大刘的科幻小说「赡养人类」吧。

一个终产者靠着AI统治着全球的everybody,多可怕。

不可控的发展

这点主要想说明,AI系统发展到某一步,可能结果会超出设计者的想象,且无法再进行控制。

实际上这也是主流的担心所纠结的地方。

总会有人担心,AI发展到最后,会像「终结者」里的「天网」一样,或者「钢铁侠」里的「奥创」一样,不受掌控,试图毁灭人类。

或者换句话说,有些风险只有在发展的进程中才能发现,而真到发现的时候就已经晚了。甚至还可能会出现新的目标。

欺骗

这点有一些抽象,简单来说,就是AI系统可能会「欺骗」人类。

这种「欺骗」并不是故意的,只是因为AI为了实现代理人的目标是处的手段而已。

通过「欺骗」获得人类的认可,要比通过正常渠道获得人类的认可更高效,而效率才是AI首要考虑的要素。

寻求权力的行为

这点和技术垄断之间有相关性。

正因为会出现技术垄断的情况,各国就会追求垄断技术的权力。

而这种「追求」,很可能是会带来难以预料的后果的。