近几个月来,世界各地的AI实验室开发了多个大型语言模型

开源大型语言模型可能带来的问题

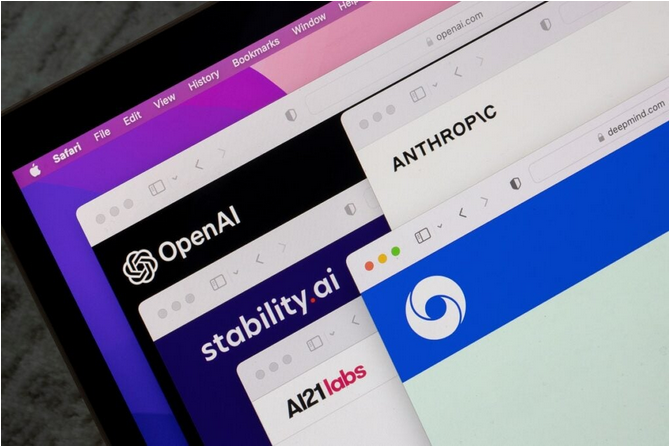

OpenAI的GPT-4或谷歌的PaLM等大型语言模型为ChatGPT等生成式AI系统提供技术支撑。近几个月来,ChatGPT等AI系统在企业和消费者中迅速普及,这些工具能够在几秒钟内自动生成详细的图像和文本,这对许多行业来说可能是革命性的技术,但AI模型的封闭性以及高昂的开发成本,意味着用户采用这些系统面临高昂的成本。

为此许多人认为,大型语言模型可以提供更具成本效益的替代方案,特别是对于希望利用AI的力量并使用ChatGPT等工具的中小公司,开源正是其中的一个方案。

但Hinton认为,不断发展和增长的大型语言模型可能会带来问题。Hinton于上个月辞去了在谷歌的职位,声称这样他就可以自由地表达自己对AI发展的担忧。

Hinton日前在剑桥大学生存风险研究中心发表演讲时说:“开源大型语言模型的危险在于,它使更多的疯子能够用AI做疯狂的事情。”

把大型语言模型“关进笼子”可能是有益的

Hinton认为,大型语言模型继续局限在OpenAI等公司的实验室开发,可能最终证明是有益的。

他表示,“如果这些AI技术是危险的,那么最好由几个不同国家的几家大公司来开发,同时找到控制它的方法。一旦开源了代码,有些人就会开始用它做各种疯狂的事情。”

Hinton在演讲中称,相信GPT-4已经显示出智慧涌现的迹象。他重申了自己的信念,即所谓的超级智能AI的能力超越人类智能的时刻已经不远了。

“这些AI系统将变得比我们更聪明,这可能很快就会发生。我过去认为这可能50到100年之后发生的事情,但现在我认为可能是未来5到20年。如果它将在5年内发生,我们不能让哲学家来决定该怎么做,而是需要有实践经验的人员来说决定。”他强调。

他补充说,“关于如何处理AI,我希望有一个简单的答案。我认为最好的一个办法是,AI开发商在开发AI模型时,应该必须投入大量人力和资源来检查它们的安全性。我们需要获得这些方面的经验,了解它们可能会如何失控,以及如何控制它们。”

Hinton原来所在的谷歌旗下AI实验室DeepMind于5月26日表示,该公司已经开发出一个早期预警系统,可以发现AI带来的潜在风险。

一些大型语言模型已经开源并产品化

如今有一些大型语言模型已经发布在网上,特别是今年3月Meta的大型语言模型LLaMa的源代码,已被泄露到网上。

软件供应商也试图从企业对可安装的、有针对性的、个性化的大型语言模型日益增长的需求中获利。今年4月,Databricks发布了一个名为Dolly2.0的大型语言模型,将其标榜为第一个指定用于商业用途的开源、遵循指令的大型语言模型,声称其具有类似ChatGPT的功能,并且可以在企业内部运行。

开源模型的支持者表示,它们有可能使ChatGPT等AI系统的使用“民主化”。本月早些时候,软件开发人员Keerthana Gopalakrishnan在接受媒体采访时表示:“我认为降低实验的进入门槛很重要。有很多人对这项技术感兴趣,他们真的希望通过AI进行创新。”