众所周知,谷歌就像人工智能领域的「黄埔军校」,自深度学习兴起后培养出了整整一代机器学习研究人员和工程师。很长一段时间里,谷歌就是领先 AI 技术的代名词。

人们已经习惯跟随谷歌的脚步,使用其提出的新技术和工具作为研究基础,谷歌也走出过大批人才,成为了各家研究机构和公司的骨干。然而最近,在 ChatGPT 的冲击下,谷歌决定不这么干了。

据华盛顿邮报报道,今年二月,长期担任谷歌人工智能主管的杰夫・迪恩(Jeff Dean)向其员工宣布了一项令人震惊的政策转变:谷歌以后将不得不推迟与外界分享自己的工作成果。

多年来,Jeff Dean 麾下的 Google AI 像大学的计算机系一样,鼓励研究人员大量发表学术论文。根据 Google Research 的网站,他们自 2019 年以来推出了近 500 项研究。

但去年底 OpenAI 开创性的 ChatGPT 改变了整个科技领域的现状。Jeff Dean 在公司研究部门的季度会议上表示,这家背靠微软的创业公司大量阅读 Google AI 提交的论文与谷歌保持同步。这样的「指责」并不奇怪,事实上,大语言模型的重要基础,ChatGPT 中的 T —— transformer 是谷歌 2017 年的一项研究。

Transformer 自提出以来,一直是自然语言处理(NLP)领域研究的大方向,是 AI 目前这一波突破的源头。然而谷歌认为这种情况必须改变,据两名知情人士透露,谷歌将规定自己的人工智能发现只有在实验室工作转化为产品后才能分享论文。

新的政策变化是谷歌内部更大转变的一部分。长期以来,这家科技巨头一直被认为是 AI 领域的领导者,但现在却陷入了需要追赶别人的境地 —— 谷歌需要抵御一群灵活的 AI 竞争对手,保护自己的核心搜索业务和股价,以及潜在的未来。

在专栏文章、播客和电视节目中,谷歌 CEO 桑达尔・皮查伊 (Sundar Pichai) 敦促我们需要对人工智能保持谨慎。「在社会层面上,它可能会造成很大的伤害,」他在 4 月份的「60 分钟」节目中警告说,并描述了生成式 AI 如何加速虚假图像和视频的创作。

但与高管们透露出的风向正相反的是,最近几个月,根据对 11 名现任和前谷歌员工的采访,谷歌已对 AI 业务进行了全面改革,目标是快速推出产品。

它降低了向少数群体推出实验性人工智能工具的门槛,在公平等领域制定了一套新的评估指标和优先事项。皮查伊在一份声明中表示,谷歌还把 DeepMind 和 Google Brain 进行了合并,以「加速在人工智能方面的进步」。这个新部门将不会由 Jeff Dean 管理,而是由 DeepMind 的首席执行官哈萨比斯管理,DeepMind 在一些人看来拥有更新鲜、更有活力的品牌。

在上周早些时候的一次会议上,哈萨比斯表示,人工智能可能比大多数其他人工智能专家预测的更接近人类智能水平,「我们可能只需要几年,也许…… 十年后就可以实现。」

在谷歌加快步伐的同时,包括著名公司、研究人员和行业资深人士在内的各路声音都在呼吁人工智能开发人员放慢脚步,并警告该技术的发展速度已经过快。

Geoffrey Hinton 是 AI 技术的先驱之一,他于 2013 年加入谷歌,最近刚刚宣布离开公司。Hinton 最近一直在媒体上警告通用人工智能有逃避人类控制的危险。皮查伊和 OpenAI、微软的首席执行官在上周四还会见了白宫官员,世界各地的监管机构也正在讨论如何围绕该技术制定新规则。

上周,人工智能先驱 Geoffrey Hinton 辞去了谷歌副总裁的职务,表示担心技术的快速进步会导致大量失业和错误信息泛滥。

喜忧参半:有人支持,有人因沮丧转而离职

对于谷歌员工来说,在发表相关 AI 研究之前需要额外批准意味着可能会在生成式 AI 的闪速世界中被别人「抢发」。这种政策也可能被用来悄悄地压制那些有争议的论文,比如 2020 年谷歌 Ethical AI 团队负责人 Timnit Gebru 和 Margaret Mitchell 共同撰写的关于大语言模型危害的研究。

不得不承认的一点是,谷歌在 2022 年失去了很多顶级 AI 研究者,转投被视为更前沿的初创企业。这种人才外流的部分原因在于对谷歌没有采取一些明智的决策而感到沮丧,比如未将聊天机器人纳入搜索等。

一位前谷歌研究者表示,获得论文发表批准可能需要与高级职员反复进行严格的审查。很多科学家带着能够在自身领域进行更广泛研究的承诺来到谷歌工作,但随后又因为发表研究的限制离开了谷歌。

不过在季度会议的直播中,Jeff Dean 的声明也得到了一些员工的正面回应。他们纷纷表达了乐观的态度,希望这一转变能够帮助谷歌夺回优势。对于一些研究人员而言,这些他们第一次听到有关发表研究的限制。

Jeff Dean 最新回应:我们并没有停止分享研究

不过,对于华盛顿邮报的这篇报道,Jeff Dean 拿出事实,驳斥了他们的观点。他表示谷歌研究者合作完成的 100 + 篇论文在上周的 ICLR 2023 会议上发表,并担任了大量会议组织和 workshop 演讲者角色。

并且 DeepMind 的同事们也在 ICLR 2023 会议上发表了很多论文和演讲。

不过,有人质疑 Jeff,认为这 100+ 篇论文是滞后指标,并问 Jeff 是否能断言谷歌和 DeepMind 未来的研究交流像过去一样强大?比如哈萨比斯已经公开表示 DeepMind 未来将不会分享太多。

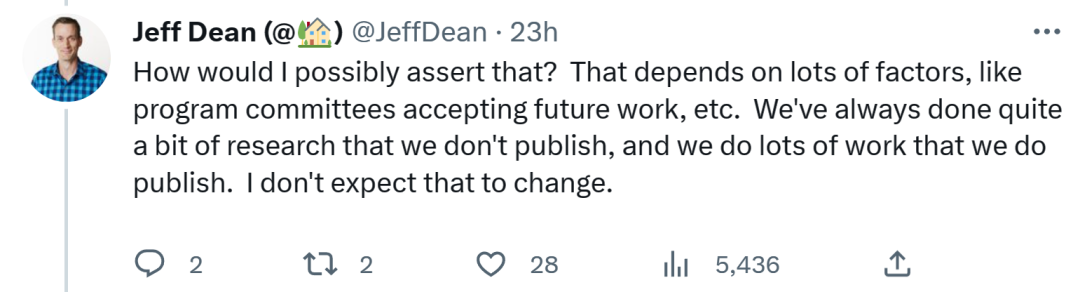

Jeff Dean 回答称,这是决不可断言的事情。新研究发表取决于很多因素,就像大会接收论文一样,我们有很多工作不会发表,也有很多发表了出来。我认为情况不会改变。

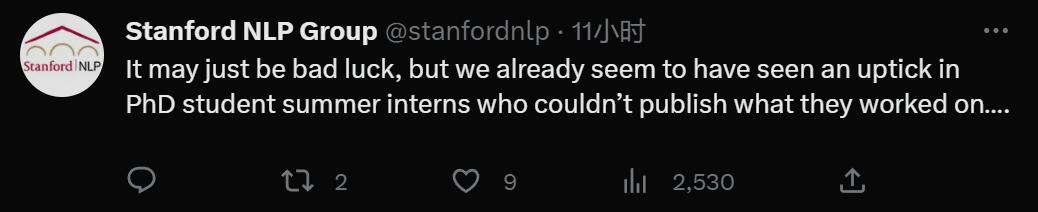

斯坦福 NLP 的账号反驳表示,看起来夏季实习的 PhD 学生有的已经不好发表论文了。

还有人认为,Jeff Dean 如果能直接否认华盛顿邮报报道的观点,才更有说服力。

最后正如一位网友所言,「未来需要担心的不是发表论文,它们肯定会凭借着强大的影响力继续存在。更需要担心的是发布代码和模型,以及最近几年高影响力论文似乎退化的趋势。」