微软最近发表了一篇有关HuggingGPT的论文。原文地址:HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face[1]。本文是对该论文的解读。

HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face 翻译成中文就是:HuggingGPT: 在Hugging Face中使用ChatGPT和它的朋友们解决AI任务。

它的朋友们是什么?通过对论文的阅读,应该就是GPT4为代表的大语言模型以及各种各样的专家模型。本文说的专家模型是相对于通用模型而言的,是特定领域的模型,比如医疗领域的模型,金融领域的模型等等。

Hugging Face是一个开源机器学习社区和平台。

通过对下面几个问题可以快速了解论文的主要内容。

- HuggingGPT背后的理念是什么,它的工作原理是什么?

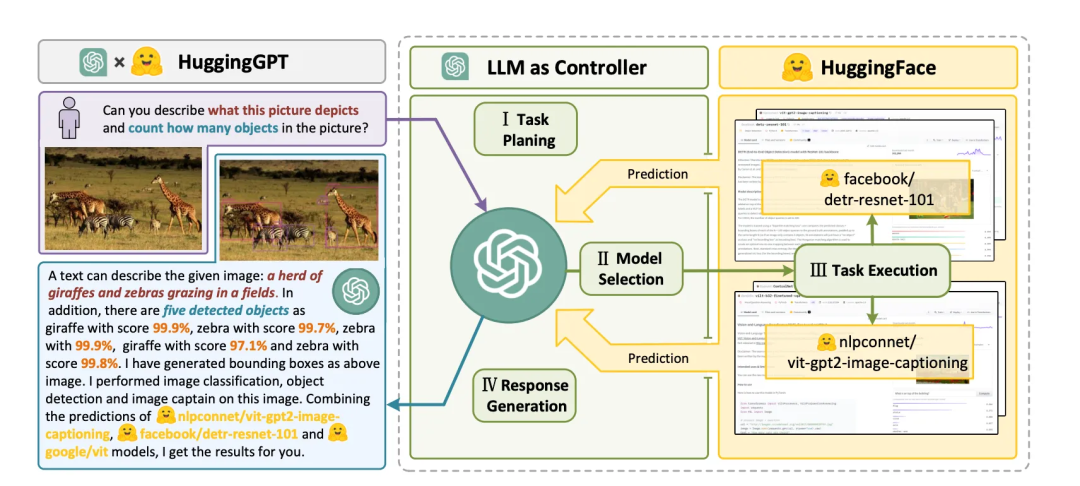

- HuggingGPT背后的理念是使用大语言模型(LLM)作为控制器来管理AI模型和解决复杂的AI任务。HuggingGPT的工作原理是利用LLM在理解和推理方面的优势来剖析用户请求并将其分解为多个子任务。然后,根据专家模型的描述,HuggingGPT为每个任务分配最适合的模型,并整合不同模型的结果。HuggingGPT的工作流程包括四个阶段:任务规划、模型选择、任务执行和响应生成。您可以在PDF文件的第4页和第16页找到更多信息。

- HuggingGPT背后的理念是什么,它的工作原理是什么?

- HuggingGPT背后的理念是使用大语言模型(LLM)作为控制器来管理AI模型和解决复杂的AI任务。HuggingGPT的工作原理是利用LLM在理解和推理方面的优势来剖析用户意图和将任务分解为多个子任务。然后,根据专家模型的描述,HuggingGPT为每个任务分配最适合的模型,并整合不同模型的结果。HuggingGPT的工作流程包括四个阶段:任务规划、模型选择、任务执行和响应生成。您可以在PDF文件的第4页和第16页找到更多信息。

- HuggingGPT如何利用语言作为通用接口来增强AI模型?

- HuggingGPT利用语言作为通用接口来增强AI模型,方法是使用大语言模型(LLM)作为控制器来管理AI模型。LLM可以理解和推理用户的自然语言请求,然后将任务分解为多个子任务。基于专家模型的描述,HuggingGPT为每个子任务分配最适合的模型,并整合不同模型的结果。这种方法使HuggingGPT能够涵盖许多不同模态和领域的复杂AI任务,包括语言、视觉、语音和其他具有挑战性的任务。您可以在PDF文件的第1页和第16页找到更多信息。

- HuggingGPT如何利用大语言模型来管理现有的AI模型?

- HuggingGPT使用大语言模型作为接口来路由用户请求到专家模型,有效地结合了大语言模型的语言理解能力和其他专家模型的专业知识。大语言模型充当计划和决策的大脑,而小模型充当每个特定任务的执行者。这个模型之间的协作协议为设计通用AI模型提供了新的方法。(第3-4页)

- HuggingGPT可以解决什么样复杂的AI任务?

- HuggingGPT可以解决涵盖语言、图像、音频和视频等各种模态的广泛任务,包括检测、生成、分类和问答等各种形式的任务。HuggingGPT可以解决的24个任务示例包括文本分类、物体检测、语义分割、图像生成、问答、文本转语音和文本转视频。(第3页)

- HuggingGPT可以与不同类型的AI模型一起使用,还是仅限于特定模型?

- HuggingGPT不限于特定的AI模型或视觉感知任务。它可以通过大语言模型组织模型之间的合作来解决任何模态或领域的任务。在大语言模型的规划下,可以有效地指定任务过程和解决更复杂的问题。HuggingGPT采取更开放的方法,根据模型描述分配和组织任务。(第4页)

可以用现在很火的微服务架构,云原生架构的概念类比来理解,HuggingGPT就是controller,可以用GPT4来实现,负责处理自然语言的输入,分解,规划,调度,所谓调度,就是调度给worker,也就是其他的大语言模型(LLM)和专家模型(特定领域模型),最后worker将处理的结果返回给controller,由controller整合结果,转化成自然语言返回给用户。

HuggingGPT的工作流程包括四个阶段:

- 任务规划:使用 ChatGPT 分析用户的请求,了解他们的意图,并将其拆解成可解决的任务。

- 模型选择:为了解决计划的任务,ChatGPT 根据描述选择托管在 Hugging Face 上的 AI 模型。

- 任务执行:调用并执行每个选定的模型,并将结果返回给 ChatGPT。

- 生成响应: 最后使用 ChatGPT 整合所有模型的预测,生成 Response。

引用链接

[1] HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face: https://arxiv.org/pdf/2104.06674.pdf