为了训练ChatGPT,微软可谓下了足够多的血本。

ChatGPT消耗的总算力约为3640PF-days,假如每秒计算一千万亿次,需要计算3640天。

微软将3万多个英伟达A100芯片连起来,为OpenAI耗资数亿美元量身打造了超算。

要是这么耗下去,微软腰包恐怕也吃不消。

其实,取代英伟达芯片的计划,已经从2019年起,就开始在公司内部秘密展开了。

The Information报道称,大约在5年前,微软就开始研发一种芯片,内部代号「雅典娜」(Athena),300人共同研发。

而最初的计划,是用台积电的5nm工艺打造。

自研Athena,挑战英伟达

不用多说,「雅典娜」是专为训练大型语言模型(LLM)而设计的。

而现在,微软想要把GPT-4能力全部装进包括Bing、Microsoft 365和GitHub在内的全家桶中,必定需要大量的算力支持。

让人震惊的是,开发类似于Athena这种芯片的成本,可能约为每年1亿美元。

在训练模型时,研究人员可以借助「雅典娜」的功能来处理新数据,同时,还能进行推理。

这样一来,以前处理人工智能软件必须使用专用计算机的局面就得到缓解了,毕竟,专门用来跑AI的计算机从来都不够用。

因为,之前只有英伟达才生产这种芯片,而供货量的缺少也就使得整个科技行业都感受到了这种短缺。

也正因如此,微软才不得不专门为一部分内部团队提供专用芯片。

此前,研究公司SemiAnalysis曾估算,ChatGPT每日烧70万美元,每查询一次,就需要0.36美分。

如果「雅典娜」具有竞争力,就能够将每颗芯片的成本降低1/3。

Forrester Research的高级云分析师Tracy Woo表示,AI的爆火让各大公司都涌入其中,而芯片的缺乏不仅给供货商带来压力,还给AI科技公司带来了压力。

像谷歌和亚马逊这样大体量的科技公司有足够的资本设计和开发属于自己的芯片,其它的公司也得眸足劲儿紧跟步伐。

说回到微软的「雅典娜」。

其实微软的AI芯片项目发布的时机纯属偶然,并不是蓄谋已久。

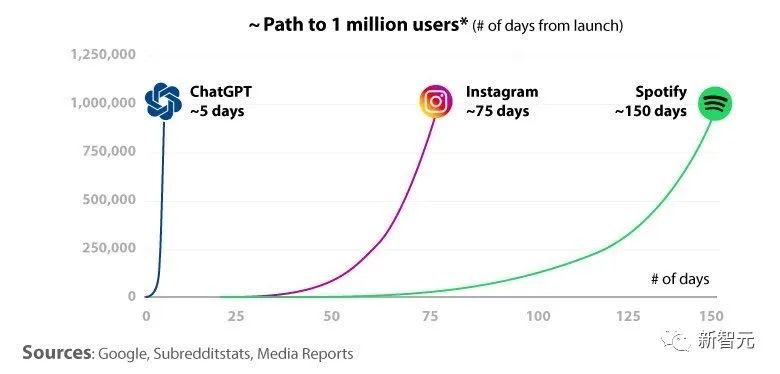

今年年初,OpenAI和微软对于LLM的训练有了质的飞跃。知情人士表示,ChatGPT的发布引爆了网络,也正因如此,微软才急匆匆地加快了「雅典娜」的问世。

要知道,ChatGPT的用户已经超过1亿了。

据预测,微软可能最早在明年大面积应用「雅典娜」,范围包括微软内部和OpenAI。他们还在犹豫的是,要不要把「雅典娜」提供给Azure云计算服务的客户。

微软方面表示,大多数客户不需要训练自己的LLM,因此也就不需要芯片加持。

然而如果真要给的话,微软可得干过英伟达。毕竟,英伟达的芯片已经辛勤耕耘十五载,畅销所有开发者。

研究公司SemiAnalysis的首席分析师Dylan Patel表示,ChatGPT的运营成本大概是每天70万美元,大概每次查询0.36美分。而这些成本的主要来源,就是服务器,实在是太贵了。

但如果OpenAI用上自己研发的「雅典娜」,还能pk过英伟达的话,那么成本能直降三分之一。

他进一步表示,微软未来还希望在所有旗下的应用程序中都使用LLM,比如Bing、Office 365、GitHub等等。而如果继续使用目前的硬件进行部署,那每年得花数百亿美元。

此外,微软自研芯片还有另一个数据支撑。

微软的高层预测了究竟需要多少图形处理单元来支撑AI工作。而其中一位知情者表示,完全依赖英伟达的芯片的话,成本高的吓人。

虽说去年微软和英伟达刚刚达成了一个建设超算的合作项目,但在芯片这方面,「雅典娜」还是和英伟达的产品存在竞争关系。

不过,对于这一敏感话题,英伟达拒绝置评。