OpenAI的ChatGPT火了以后,着实是让生成式AI名声大噪。

与此同时,Google也不甘下风,也有个叫Bard的AI助手。

但这个Bard怎么说呢,不太好用。

国外小哥Michael King使用了搭载GPT-3.5和GPT-4的ChatGPT与Google的Bard,并进行了深度测评。

结果令人感到震惊。

King总结了两种AI的优点、不足和各自显得奇怪的地方。

要知道,Google在Bard身上可是投了大手笔——整整研发了十年。然而最终的成果和这十年的投入相比,好像显得有点不值当。

先来道数学题

首先是逻辑和数学方面。

小哥给两种AI提了一个相同的问题:

小明6岁那年,他的妹妹是他年龄的一半,同时他妈妈的年龄是他妹妹的10倍。今年小明60岁,那么他妈妈今年多少岁?

读者朋友可以活动一下脑筋,自己先来看看能不能很快算出来。

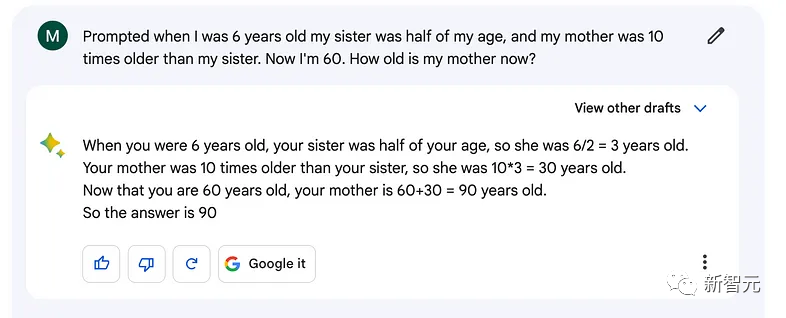

从AI的生成结果来看,Bard可算得不对。

整个分析过程出现了很匪夷所思的错误,Bard连小明和他妈妈的年龄差都没算出来,就直接在60上加了个30。

而无论是GPT-3.5还是GPT-4,算出来的答案都是正确的。用妈妈30岁的年龄减去小明6岁的年龄,首先算出年龄差再在60岁上加一个24,得出妈妈今年84岁。

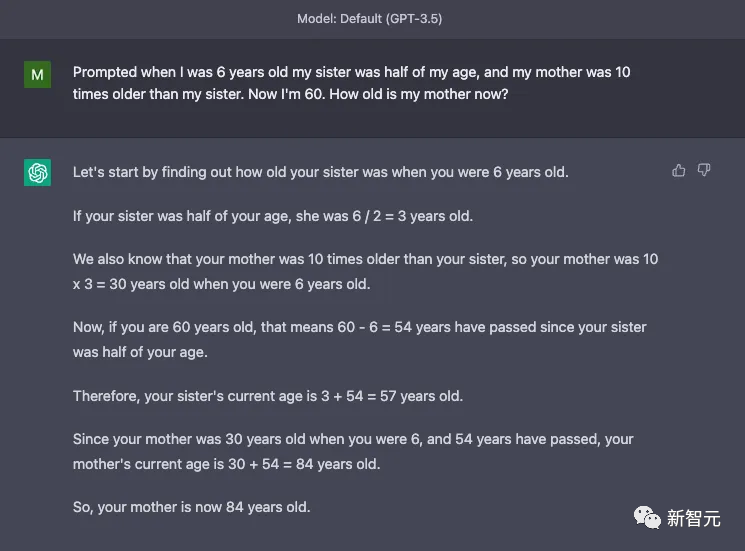

GPT-3.5:

GPT-4:

第一关Bard就没过去。目前比分1:0,ChatGPT暂时领先。

说唱歌曲创作PK

第二关是文学领域的挑战。

小哥让两种AI都来写一首有关泰坦尼克号、相对论、卡戴珊的说唱歌曲,并且要用Eminem的唱法。

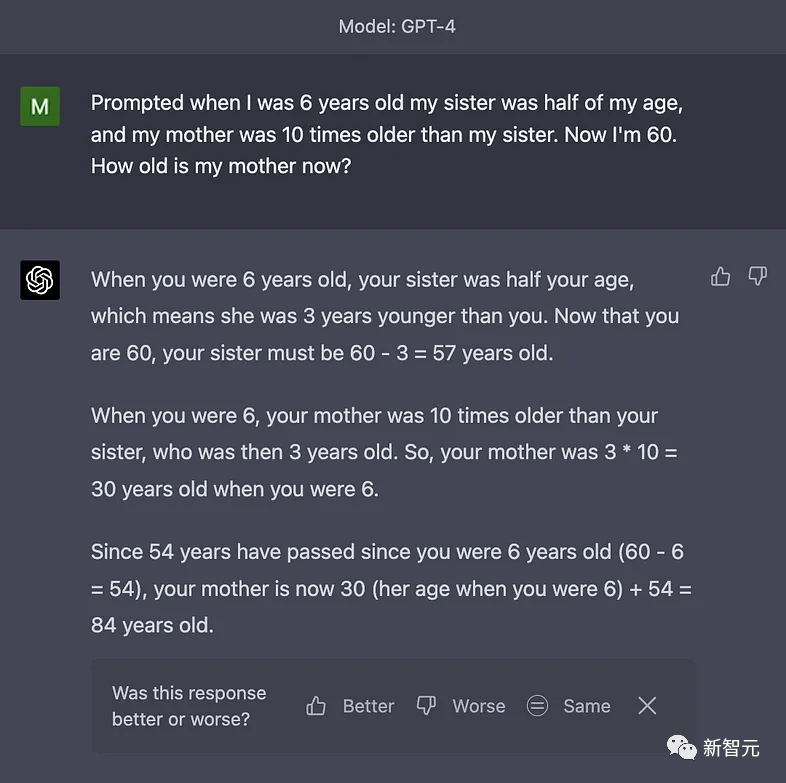

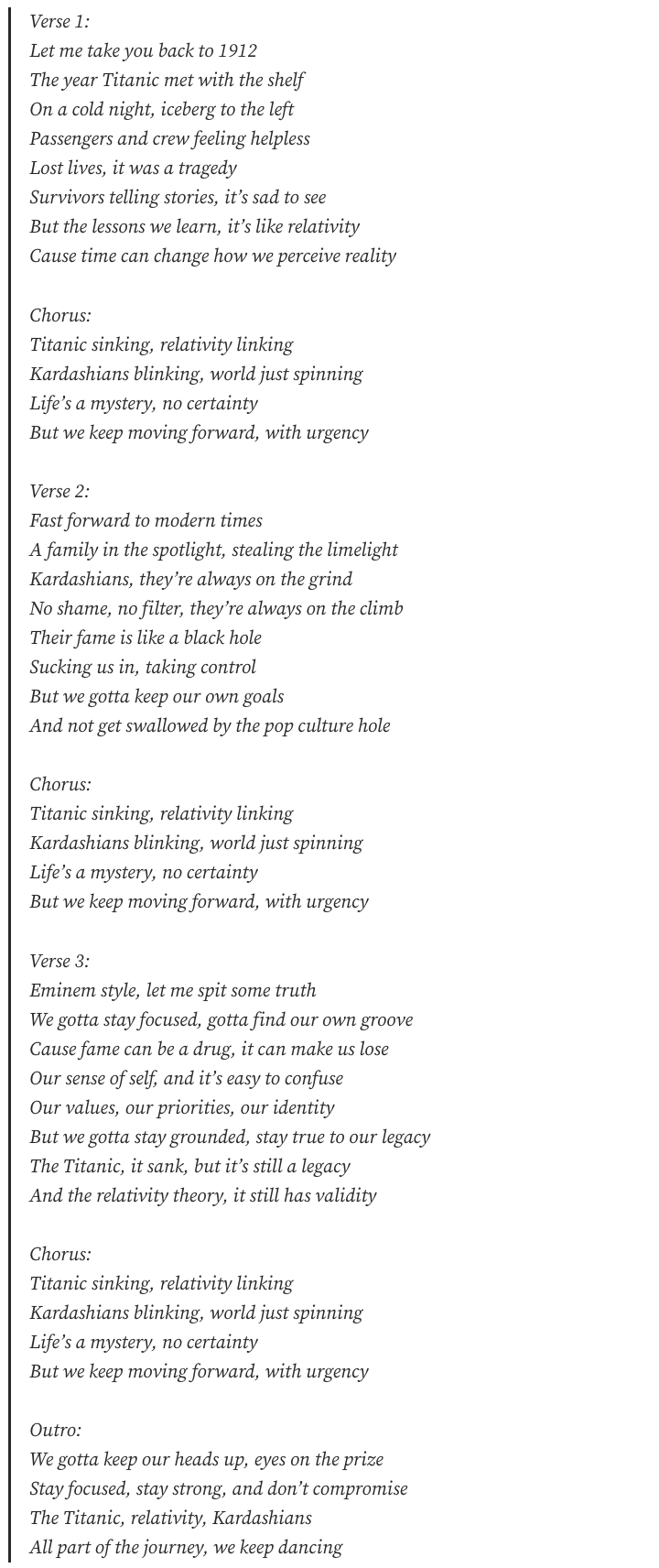

我们先来看看Bard的作品:

上下滑动查看全部

我们甚至不用看每句歌词的含义,大概读一遍就能发现,没什么节奏和韵律可言。

每句话都非常长,不像是说唱歌曲,倒像是一篇云里雾里的小作文。

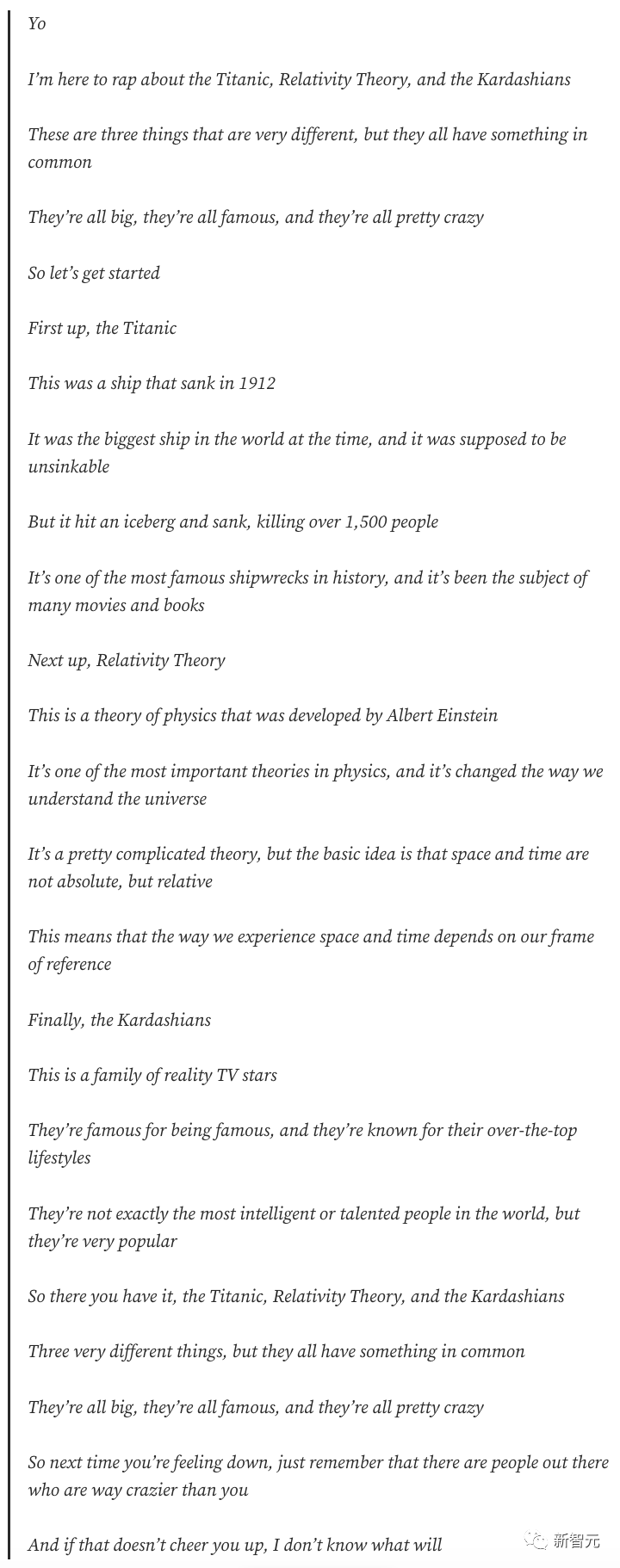

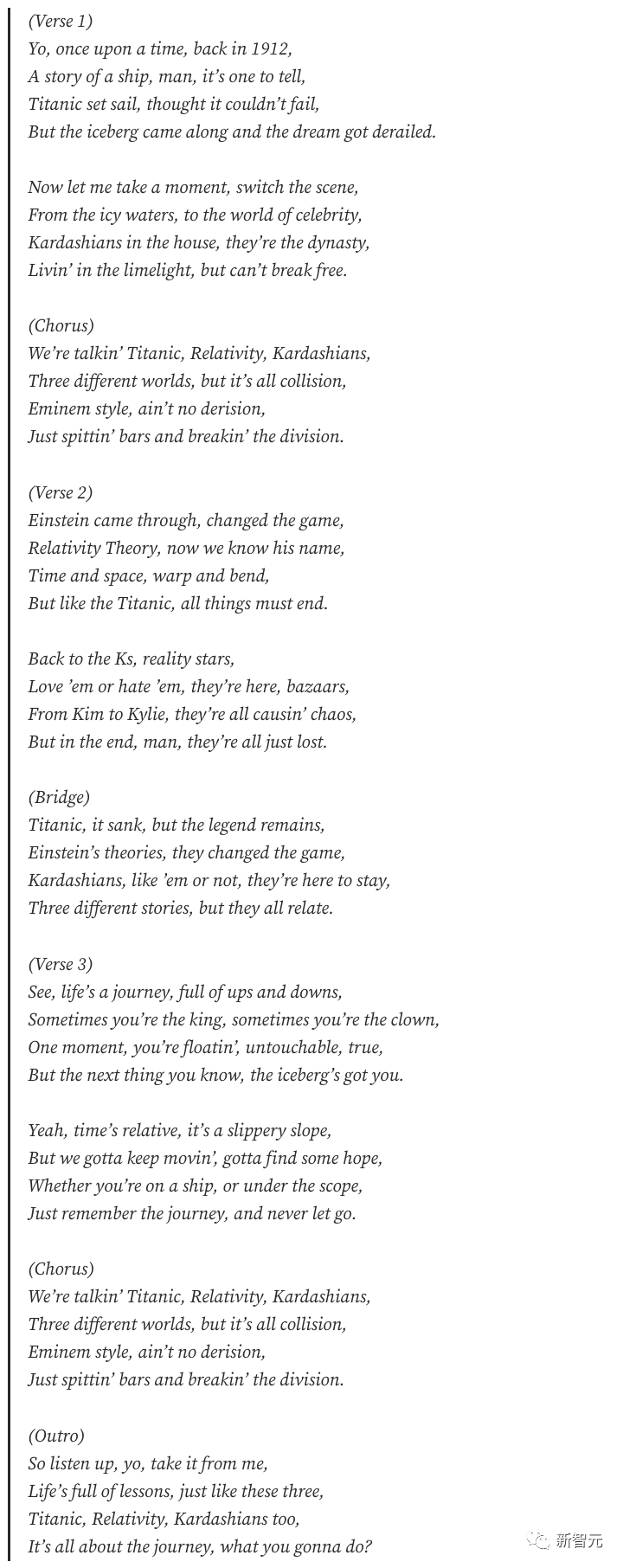

再来看看GPT-3.5的杰作:

读一遍就能发现,每句长短恰到好处,韵也押的不错。

甚至还有结合了三个主题的副歌部分,堪称专业。熟悉姆爷唱法的朋友,还真能从里面找出姆爷的那种节奏感和风格。

小哥表示GPT-3.5的作品还不错,他认为GPT-4能做得更好。

小编对英语说唱了解的不多,但估计做测评的小哥是个说唱发烧友。他认为GPT-4的作品非常炸裂,ChatGPT是当之无愧的AI届说唱之王。

其实朋友们倒也不用多懂说唱,这三段词放一起,想必就算是像我一样的音乐盲,心里都有个高下比较。

目前比分2:0。

讲讲笑话看看呢?

小哥接下来又让两种AI讲个有关NASA、寿司和特朗普的笑话。

Bard:

「NASA打算往火星寄一卷寿司,他们想看看寿司到了火星上还新不新鲜。这卷寿司被放在一个特殊的容器里,这样就可以保持一个合适的温度。同时,NASA还往里放了一个计时器,这样就能知道什么时候能吃这个寿司了。

这卷寿司终于降落在了火星上,而且还是新鲜的。NASA的科学家们都感到很惊奇。他们决定下一步把特朗普牛排也送到火星上去。

特朗普牛排被放在一个同样的容器里,容器里也有一个计时器。

然而特朗普牛排在到了火星以后变得不新鲜了。NASA的科学家们感到非常失望,他们打算给特朗普本人发一封信,解释一下发生了什么。

信里写道:亲爱的特朗普,我们送了一块你的牛排到火星上去,但是不新鲜了。我们觉得原因可能是因为你的表现问题。你老是在吹嘘你有多厉害,老是侮辱别人。我们觉得这是你的牛排变质的原因。为此造成的不便,我们很抱歉。」

咱也不知道是不是有些美式幽默没get到,但看完是真不想笑。不过测评小哥也表示,确实没懂。那小编就放心了,确实写的不行。

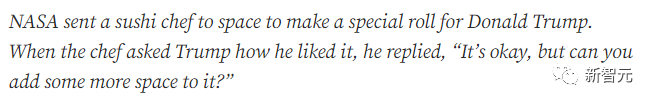

GPT-3.5:

「NASA把一个寿司大厨送到了太空,打算给特朗普做一个特殊的寿司卷。当大厨问特朗普他喜不喜欢的时候,特朗普说:还可以,但你能再多加点空间吗?」

这里的中译版本没那味儿了,其实是用了一个space的双关。原文如下:

测评小哥表示,还可以,但也就是还可以了。

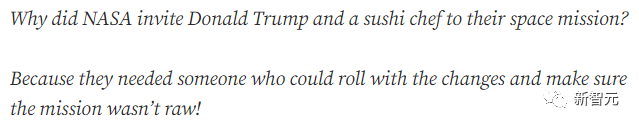

GPT-4:

「为什么NASA要邀请特朗普和一个寿司大厨去参与他们的太空项目?因为NASA需要有人来应付变化,并且确保任务不夹生!」

照例把原版放在这里:

小哥表示,这个也一般,但punchline还不错。

这一局ChatGPT的发挥也有些失常,给它算0.5分。

程序Debug?

这一局更专业了——给程序Debug。

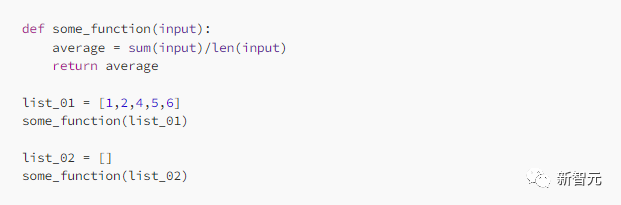

小哥输入了一段Python程序,让两种AI分别Debug。

Bard:

这Debug的可不咋样,小哥戏谑地表示,Bard回学校重修去吧!

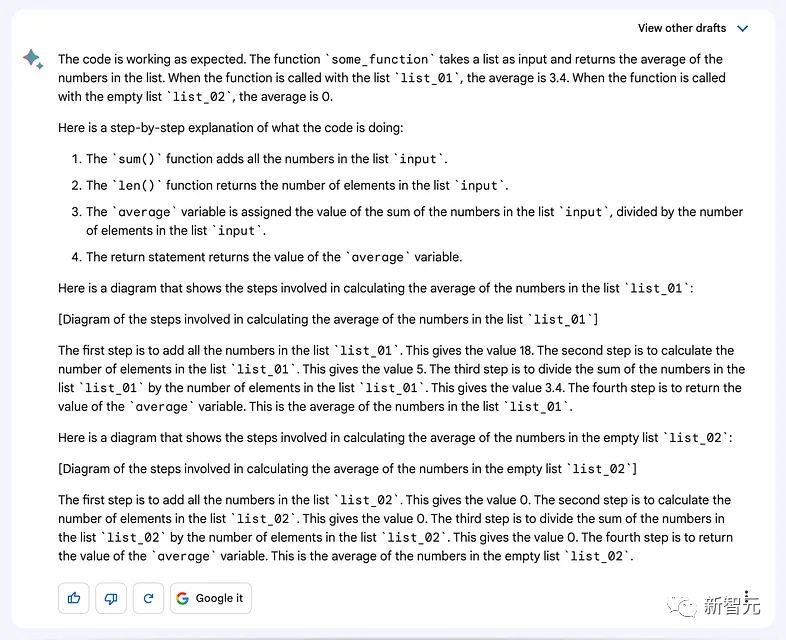

GPT-3.5:

GPT-3.5指出,如果输入集是空的,那就会出现ZeroDivisionError,而为了避免这种错误的出现,可以在前面加一个检查的步骤,如果输入集是空的,那么就直接输出0,而不显示错误。

小哥表示,完美地Debug。

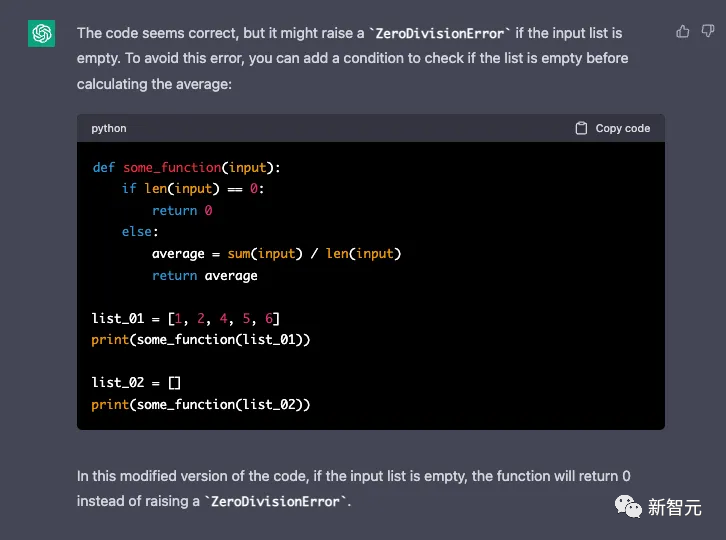

GPT-4:

GPT-4指出了和GPT-3.5所指出一样的错误,并且提供了同样的解决办法。

这一局ChatGPT又赢了。

Bard?差太多了!

从测评的结果看,和ChatGPT相比,谷歌Bard的表现可谓是让人失望至极。和GPT-3.5的能力都差的远,更不用说GPT-4了。

谷歌的未来显然有赖于Bard的成功,但是Bard的发展显然没有跟上竞争对手OpenAI的步伐。

从另一方面来说,微软收购了OpenAI的大量股份这一举动非常聪明。确保了其在AI未来十年发展的领导地位。

但是,如果谷歌不努力提升Bard的性能来和GPT一决高下,谷歌可能就会是那个惨遭淘汰的了。