斯坦福大学以人类为中心的人工智能研究所(HAI)发布了2023年人工智能指数,该指数分析了人工智能的影响和进展。这份数据驱动的报告深入探讨了人工智能相关的热门主题,如研究、伦理、政策、舆论和经济学。

这项研究的主要发现包括人工智能研究如何扩展到模式识别、机器学习和计算机视觉等专业领域。报告指出,自2010年以来,人工智能出版物的数量增加了一倍多。同时,人工智能行业应用超越学术界,并引用了32个由行业生产的重要机器学习模型,而学术界仅生产了3个。研究将此归因于训练这些大型模型所需的大量资源。

传统的人工智能基准,如图像分类基准ImageNet和阅读理解测试SQuAD,不再足以衡量技术的高速进展,导致出现了新的基准,如BIG bench和HELM。HAI副主任兼人工智能指数指导委员会成员Vanessa Parli在斯坦福大学的一篇文章中解释说,许多人工智能基准已经达到饱和点,几乎没有改进,研究人员必须根据社会希望如何与人工智能互动来开发新的基准。她给出了ChatGPT的例子,以及它如何通过许多基准测试,但仍然经常给出错误的信息。

偏见和错误信息等道德问题是该报告审查的人工智能的另一个方面。随着流行的生成人工智能模型的兴起,如DALL-E 2、Stable Diffusion,当然还有ChatGPT,对人工智能的道德滥用正在增加。报告指出,根据存储人工智能滥用的独立数据库AIAAIC,自2012年以来,人工智能事件和争议的数量增加了26倍。此外,对人工智能伦理的关注正在迅速增长,因为研究发现,自2021以来,提交给FAccT人工智能伦理会议的提交数量翻了一番多,而自2018年以来,提交数量增加了10倍。

大型语言模型的规模越来越大,费用也成为天价。该报告以2022年发布的谷歌PaLM模型为例,指出该模型的成本比2019年的OpenAI GPT-2高160倍,规模大360倍。总体而言,模型越大,培训成本就越高。该研究估计,Deepmind的Chinchilla模型和HuggingFace的BLOOM的训练成本分别为210万美元和230万美元。

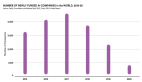

在全球范围内,目前AI的私人投资与2021-2022年相比下降了26.7%,初创公司的AI融资也有所放缓。然而,在过去十年中,人工智能投资大幅增加。报告显示,与2013年相比,2022年人工智能的私人投资额增加了18倍。采用新人工智能举措的公司数量也出现了平稳期。报告称,2017年至2022年间,采用人工智能的公司比例翻了一番,但最近趋于平稳,约为50-60%。

另一个令人感兴趣的话题是政府对人工智能的日益关注。人工智能指数分析了127个国家的立法记录,发现2022年有37项包含“人工智能”的法案成为法律,而2016年只有一项。研究发现,自2017年以来,美国政府已将人工智能相关合同支出增加了2.5倍。法院也看到了人工智能相关法律案件的激增:2022年,有110起此类案件与民事、知识产权和合同法有关。

人工智能指数还深入研究了皮尤研究中心关于美国人对人工智能的看法的一项调查。在一项针对10000多名小组成员的调查中,45%的人表示对人工智能在日常生活中的使用感到喜忧参半,37%的人表示他们感到担忧多于兴奋。只有18%的人感到兴奋而不是担忧。在主要的犹豫中,74%的人表示非常或有点担心人工智能被用来为人类做出重要决定,75%的人对人工智能被用于了解人们的想法和行为感到不安。