生命未来研究所(Future of Life Institute)发布了一封公开信,呼吁暂停某些形式的人工智能研究六个月。该组织以“对社会和人类的严重风险”为由,要求人工智能实验室暂停对比GPT-4更强大的人工智能系统的研究,直到可以在它们周围设置更多的“安全护栏”。

生命未来研究所在3月22日的公开信中写道:“具有与人类竞争的人工智能系统会给社会和人类带来巨大风险。”“先进的人工智能可能代表着地球生命史的深刻变化,应该以相应的谨慎和资源进行规划和管理。不幸的是,这种水平的规划和管理并没有实现。”

该研究所认为,如果没有人工智能治理框架——比如阿西洛马人工智能原则(Asilomar AI Principles,是著名的阿西莫夫的机器人三大法则的扩展版本。这23条准则由该研究所牵头制定。)——我们就缺乏适当的检查机制来确保人工智能以有计划和可控的方式发展。这就是我们今天面临的情况。

信中写道:“不幸的是,这种水平的规划和管理并没有发生,尽管最近几个月人工智能实验室陷入了一场失控的竞赛,以开发和部署越来越强大的数字思维,而没有人——甚至他们的创造者——能够理解、预测或可靠地控制这些思维。”

在人工智能研究人员没有自愿暂停的情况下,生命未来研究所敦促政府采取行动,防止对大型人工智能模型的持续研究造成伤害。

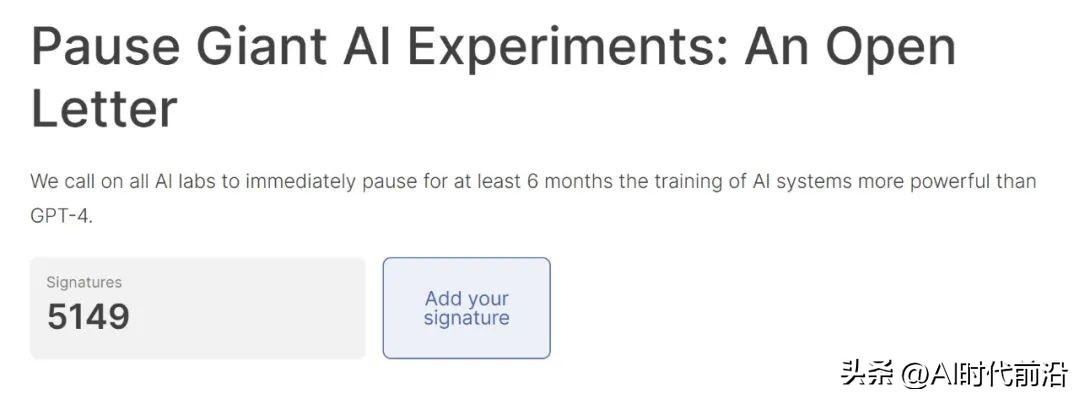

顶尖的人工智能研究人员在是否暂停研究的问题上存在分歧。5000多人签名支持这封公开信,其中包括图灵奖得主Yoshua Bengio、OpenAI联合创始人埃隆·马斯克和苹果联合创始人史蒂夫·沃兹尼亚克。

然而,并不是每个人都相信禁止研究比GPT-4更强大的人工智能系统符合我们的最大利益。

“我没有签署这封信,”Meta首席人工智能科学家、图灵奖得主Yann LeCun(2018年与Bengio和Geoffrey Hinton一起获得图灵奖)在推特上说。“我不同意它的前提。”

LeCun、Bengio和Hinton被美国计算机协会(ACM)称为“深度学习革命之父”,他们在十多年前通过对神经网络的研究掀起了当前的人工智能热潮。当年,深度神经网络是世界各地人工智能研究人员的主要关注点。

随着谷歌2017年发表的Transformer论文,人工智能研究进入了超速状态。很快,研究人员注意到大型语言模型意外出现的能量财富,例如学习数学的能力、思维链推理和指令遵循。

2022年11月下旬,当OpenAI向世界发布ChatGPT时,公众尝到了这些LLM能做什么的滋味。从那时起,科技界一直致力于在他们所做的一切中实施LLM,而建造更大、更强大的模型的“军备竞赛”也获得了额外的动力,正如3月15日GPT-4的发布。

尽管一些人工智能专家对LLM的负面影响表示担忧,包括撒谎倾向、私人数据披露风险以及对就业的潜在影响,但它并没有使公众对新人工智能功能的巨大需求降温。英伟达首席执行官黄仁勋(Jensen Huang)称,我们可能正处于人工智能的转折点。但精灵似乎已经从瓶子里出来了,不知道它下一步会去哪里。