与ChatGPT聊天很有趣,而且信息量很大 —— 与它闲聊可以探索一些新的想法。但这些都是比较随意的用例,新奇感很快就会减弱,特别是当人意识到它能产生幻觉的时候。

如何以更高效的方式使用ChatGPT呢?在OpenAI发布GPT3.5系列API后,可以做的事情远不止是闲聊。QA(问答)是企业和个人使用的一个非常有效的用例 —— 用自然语言向机器人询问自己的文件/数据,它可以通过从文件中检索信息并生成回应来快速回答。可以把它用于客户支持、综合用户研究、个人知识管理等等。

向机器人询问与文件相关的问题。使用稳定扩散法生成的图像。

本文将探讨如何根据自己的数据建立问答聊天机器人,包括为什么有些方法行不通,以及如何利用llama-index和GPT API以高效的方式建立一个文档问答聊天机器人的步骤指南。

(如果只想知道如何建立问答聊天机器人,可以直接跳到“逐步建立文档问答聊天机器人”部分)

探索不同的方法

当ChatGPT问世时,可以想到把它作为自己工作的一个助手,从而节省自己的时间和精力等。

首先想到的是用自己的数据对GPT模型进行微调来实现这个目标。但是,微调需要花费相当多的钱,而且需要一个有实例的大数据集。也不可能在文件有变化时每次都进行微调。更为关键的一点是,微调根本不可能让模型“知道”文档中的所有信息,而是要教给模型一种新的技能。因此,对于(多)文档质量保证来说,微调并不是一个好办法。

第二个方法是通过在提示中提供上下文来进行提示工程。例如,可以在实际问题之前附加原始文档内容,而不是直接问问题。但是GPT模型的注意力是有限的 —— 它只能接受提示中的几千字(大约4000个标记或3000字)。只要有成千上万的客户反馈邮件和数百个产品文档,就不可能给它提示中的所有背景。如果向API传递一个长的上下文,也是很昂贵的,因为定价是基于使用的代币的数量。

由于提示符对输入标记的数量有限制,想出了这样一个主意来解决问题:首先使用一种算法来搜索文档并挑选出相关的摘录,然后只将这些相关的语境与问题一起传递给GPT模型。在过程中需要使用一个简单、便捷的gpt-index(现在改名为LlamaIndex)的库。

从文件中提取相关部分,然后将其反馈给提示。

在下一节中,将给出一个使用LlamaIndex和GPT在自己的数据上建立一个问答聊天机器人的分步教程。

逐步建立文档问答聊天机器人

在这一节中,将用LlamaIndex和GPT(text-davinci-003)在现有文档的基础上建立一个问答聊天机器人,这样就可以用自然语言提出关于文档的问题,并从聊天机器人那里得到答案。

前提条件

在开始本教程之前,需要做一些准备:

- OpenAI API密钥,可以在https://platform.openai.com/account/api-keys找到。

- 一个文件数据库。LlamaIndex支持许多不同的数据源,如Notion、Google Docs、Asana等。在本文中将只使用一个简单的文本文件进行演示。

- 一个本地的Python环境或一个在线的Google Colab笔记本。

工作流程

工作流程很简单,只需要几个步骤:

- 1.用LlamaIndex为你的文档数据建立一个索引。

- 2.用自然语言查询该索引。

- 3.LlamaIndex将检索相关部分并将其传递给GPT提示。

- 4.向GPT询问相关的上下文并构建一个回应。

LlamaIndex所做的是将原始文档数据转换成一个矢量的索引,这对查询来说是非常有效的。它将使用这个索引,根据查询和数据的相似性,找到最相关的部分。然后,它将把检索到的内容插入到它将发送给GPT的提示中,这样GPT就有了回答问题的背景。

设置

首先需要安装库。只需在终端或谷歌Colab笔记本上运行以下命令。这些命令将同时安装LlamaIndex和OpenAI。

接下来将在python中导入这些库,并在一个新的.py文件中设置OpenAI API密钥。

构建索引并保存

在安装了所需的库并将其导入后,将需要构建一个文档的索引。

为了加载文档,可以使用LllamaIndex提供的SimpleDirectoryReader方法,或者可以从字符串中加载它。

LlamaIndex还提供各种数据连接器,包括Notion、Asana、Google Drive、Obsidian等。可以在https://llamahub.ai/找到可用的数据连接器。

加载完文档后,就可以用以下方法简单地构建索引了:

如果想保存索引并加载它以便将来使用,可以使用以下方法:

查询索引并获得响应

查询索引很简单:

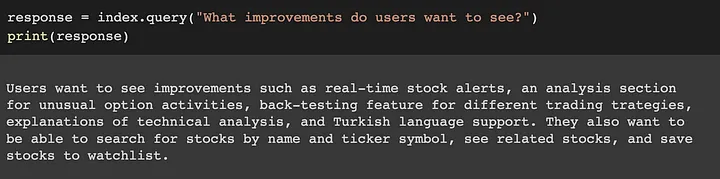

一个回应的例子。

然后就可以得到答案了。在幕后,LlamaIndex将接收提示,在索引中搜索相关块,并将提示和相关块传递给GPT。

一些高级用法的说明

上面的步骤只是展示了使用LlamaIndex和GPT回答问题的一个非常简单的入门用法。但可以做得比这更多。事实上,可以配置LlamaIndex来使用不同的大型语言模型(LLM),为不同的任务使用不同类型的索引,用一个新的索引来更新现有的索引,等等。如果有兴趣,可以在https://gpt-index.readthedocs.io/en/latest/index.html,阅读他们的文档。

总结

本文中展示了如何结合使用GPT和LlamaIndex来构建一个文档问答聊天机器人。虽然GPT(和其他LLM)本身就很强大,但如果把它与其他工具、数据或流程结合起来,它的力量也会被大大增强。