毫无疑问,GPT-4一经发布,就引爆了整个业界和学界。

凭借着自己强大的推理和多模态能力,引发了一众热议。

然鹅,GPT-4不是一个open的模型。

虽然OpenAI分享了大量GPT-4的基准和测试结果,但是基本上没有提供用于训练的数据、成本、或者用于创建模型的方法。

当然了,这样的「独家秘笈」OpenAI肯定不会公布了。

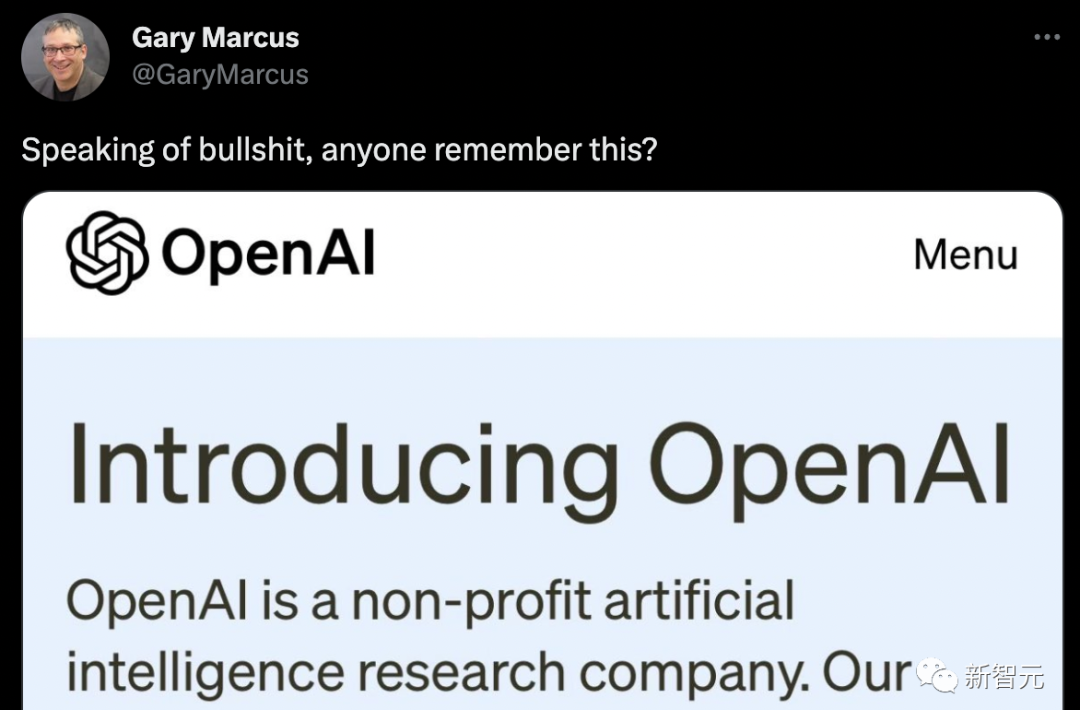

马库斯直接拿出当初OpenAI的初衷,发文嘲讽了一波。

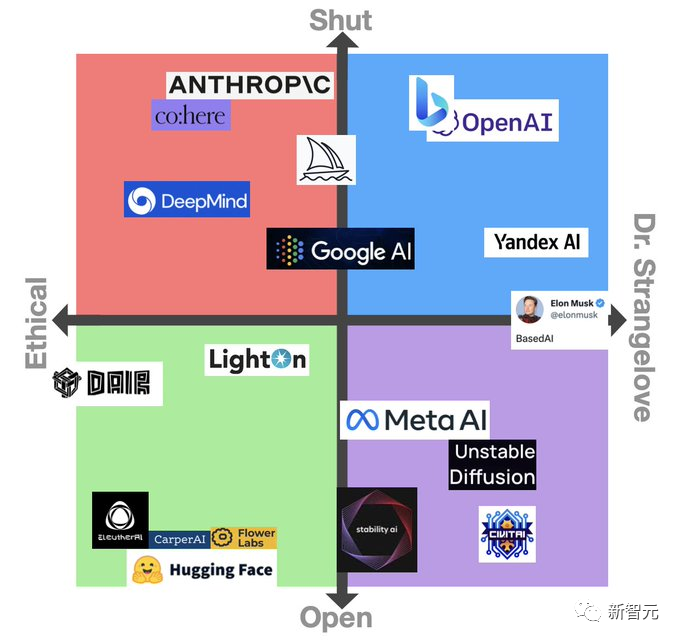

网友改进了一个版本。

人无完人,GPT-4也是

当OpenAI的总裁、联合创始人之一Greg Brockman将GPT-4和GPT-3进行比较时,他说了一个词——不同。

「它只是不同而已,模型仍然有很多问题和错误......但你真的可以看到它在微积分或法律等方面的技能提升。在某些领域,它从表现非常糟糕进化到现在足以匹敌人类。」

GPT-4的测试结果很不错:在AP微积分BC考试中,GPT-4得了4分,而GPT-3得了1分。在模拟的律师考试中,GPT-4以大约前10%考生的分数通过;GPT-3.5的分数徘徊在后10%。

在上下文能力,也就是说在生成文本之前可以记忆的文本方面,GPT-4大约能够记住50页左右的内容,是GPT-3的8倍。

在提示方面,GPT-3和GPT-3.5只能接受文字提示:「写一篇关于长颈鹿的文章」,而多模态的GPT-4可以接受图片和文字的提示:给出一张长颈鹿的图片,提示问「这里有多少只长颈鹿?」 这些GPT-4都能答对,而且它的读梗能力也很强!

我们之前错了,开源并不明智

而强到离谱的GPT-4一发布,便引起了大量研究人员和专家的兴趣。但令人失望的是,OpenAI发布的GPT-4,不是「Open的AI模型。」

尽管OpenAI分享了大量GPT-4的基准、测试结果和有趣的演示,但基本上没有提供用于训练该系统的数据、能源成本或用于创建它的具体硬件或方法的相关信息。

之前Meta的LLaMa模型泄露的时候,就引发过一波关于开源的讨论。不过,这次大家对于GPT-4封闭模型的最初反应是大部分都是负面的。

人工智能社区普遍认为,这不仅破坏了OpenAI作为研究机构的创始精神,而且让其他人难以制定保障措施来应对威胁。

Nomic AI的信息设计副总裁Ben Schmidt表示,由于无法看到GPT-4是在什么数据上训练的,大家很难知道该系统在什么地方是安全使用的,并提出修复方案。

「为了让人们知道这个模型什么地方不起作用,OpenAI需要更好地了解GPT-4所做的事情以及其中的假设。我可不会在下雪的时候,相信一个没有在雪地气候情况下训练出来的自动驾驶汽车。因为很可能,漏洞和问题只在真实使用的时候才会浮现。」

对此,OpenAI的首席科学家兼联合创始人Ilya Sutskever解释称:OpenAI不分享更多关于GPT-4的信息是因为害怕竞争,也是因为对安全的担忧,这一点是毋庸置疑的。

「外面的竞争很激烈,GPT-4的开发并不容易。几乎所有的OpenAI的员工在一起工作了很长时间才生产出这个东西。从竞争的角度来看,有很多很多公司都想做同样的事情,而GPT-4像是一个成熟的果实。」

众所周知,OpenAI在2015年成立之初是一个非营利组织。其创始人包括Sutskever、现任首席执行官Sam Altman、总裁Greg Brockman以及现已离开OpenAI的马斯克。

Sutskever等人曾表示,该组织的目标是为每个人创造价值,而不是单单为股东创造价值,并表示将与该领域的各方进行「自由合作」。

然而,为了获得数十亿美元的投资(主要来自微软),OpenAI还是被加盖了一层商业属性。

不过,当被问及为什么OpenAI改变了分享其研究的方法时,Sutskever简单地回答道:

「我们错了。在某个时候,AI/AGI将变得极其强大,那时,开源就是没有意义的。可以预料的是,在几年内,每个人都会完全明白,开源人工智能是不明智的。因为这个模型是非常有力的。如果有人想,用它就能够造成巨大的伤害,这将是相当容易的。所以随着模型的能力越来越高,不想披露它们是有道理的。」

Lightning AI的首席执行官和开源工具PyTorch Lightning的创建者William Falcon从商业角度解读称:「作为一家公司,你完全有权利这样做。」

安全风险

与此同时,Brockman也认为GPT-4的应用推广应当是缓慢推进的,因为OpenAI正在评估风险和利益。

「我们需要解决一些政策问题,如面部识别和如何对待人的图像,我们需要弄清楚,危险区在哪里,红线在哪里,然后慢慢澄清这些点。」

还有就是老生常谈的,GPT-4被用来干坏事的风险。

以色列网络安全初创公司Adversa AI发表了一篇博文,展示了绕过OpenAI的内容过滤器,让GPT-4生成钓鱼邮件、生成对同性恋者的性描述等让人高度反感的文本的方法。

因此,很多人都希望GPT-4在审核方面带来重大改进。

针对这一点,Brockman强调,他们花了很多时间试图了解GPT-4的能力,而该模型已经经历了六个月的安全培训。在内部测试中,对于OpenAI的使用政策所不允许的内容,GPT-4作出反应的可能性比GPT-3.5低82%,产生「事实性」反应的可能性高40%。

不过,Brockman并不否认GPT-4在这方面的不足。但他强调了该模型的新的缓和导向工具,称为「系统信息」的API级能力。

系统信息本质上是为GPT-4的互动设定基调,并建立界限的指令。这样,以系统信息作为护栏,就可以防止GPT-4偏离方向。

例如,一条系统信息的人设可能是这样的:「你是一个总是以苏格拉底方式回答问题的导师。你从不给学生答案,而是总是试图提出正确的问题,帮助他们学会自己思考。」

新的道路

其实,从一定程度上,Sutskever也认同批评者的观点:「如果更多的人愿意研究这些模型,我们会对它们有更多的了解,这将是好事。」

所以OpenAI出于这些原因,向某些学术和研究机构提供了访问其系统的机会。

而且Brockman还提到了Evals,这是OpenAI新近开源的软件框架,用于评估其人工智能模型的性能。

Evals采用的是模型测试众包的方式,让用户开发和运行评估GPT-4等模型的基准,同时检查其性能,这也是OpenAI致力于「健全」模型的标志之一。

「通过Evals,我们可以看到用户关心的用例,能够以一种系统的形式进行测试。我们开源的部分原因是,我们正在从每三个月发布一个新模型转向不断改进新模型。当我们制作新的模型版本时,我们至少可以通过开源知道这些变化是什么。」

其实,关于共享研究的讨论一直颇为火热。一方面,谷歌和微软这样的科技巨头正急于将人工智能功能添加到他们的产品中,往往会将以前的道德问题搁置一边,微软最近就解雇了一个团队,该团队是专门确保人工智能产品遵循道德准则的);另一方面;技术的迅速改善引发了人们对人工智能的担忧。

英国人工智能政策负责人 Jess Whittlestone 说,平衡这些不同的压力带来了严重的治理挑战,这意味着我们可能需要第三方监管机构参与。

「OpenAI 不分享关于 GPT-4 的更多细节的出发点是好的,但也可能导致人工智能世界的权力集中化。这些决定不应该由个别公司来做。」

Whittlestone 说:「理想的情况是,我们需要把这里的做法编纂成册,然后让独立的第三方去审查与某些模型相关的风险。」