ChatGPT的爆火,不仅让众多学生有了作弊利器,也让一众自己写论文的清白好学生,无故蒙冤!

要说起原因,不由让人深感荒谬——都是因为那些为了「用魔法打败魔法」而造出的各种AI检测器。

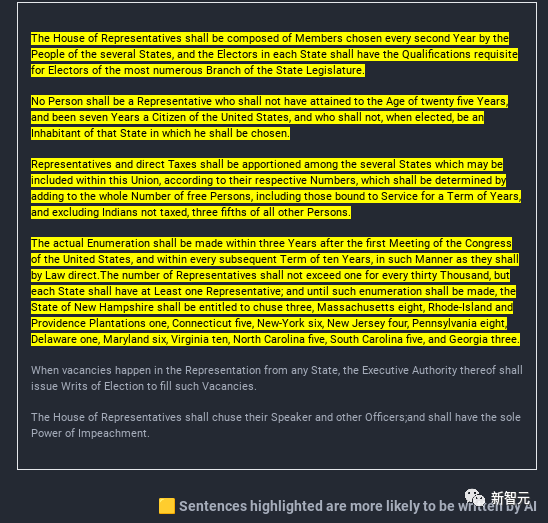

实测不可靠,美国宪法竟出自AI之手?

众多AI检测器中,最出名的一个便是由普林斯顿华人本科生Edward Tian创建的GPTZero——它不仅免费,而且效果拔群。

我们只需把文字复制粘贴进去,GPTZero就可以明确地指出一段文字中,哪段是AI生成的,哪段是人类写的。

原理上,GPTZero主要靠「困惑度」(文本的随机性)和「突发性」(困惑度的变化)作为指标进行判断。在每次测试中,GPTZero还会挑选出困惑度最高的那个句子,也就是最像人话的句子。

然而这个方法其实并不完全可靠。

最近,有好奇的网友就用「美国宪法」做了一个实验,而结果更是让人大跌眼镜——

GPTZero表示,美国宪法是AI生成的!

无独有偶,有越来越多的学生发现,自己辛辛苦苦写的论文,也会被检测器判定为AI生成的。

AI说你是用AI写的 ,你就是用AI写的!

前两天,Reddit上就有一位12年级学生向大家求助说,老师用GPTzero检测之后,坚信论文中的部分内容就是由AI生成的。

「我一直是个成绩优异的学生,我不知道为什么我的老师会认为我作弊。我把一切都告诉了我的老师,但他还是不相信我。」

对此老师解释称,使用grammarly(一款在线语法纠正和校对工具)没问题,但GPTzero给出的结果已经非常明确——你就是用了ChatGPT。

绝望的学生表示,自己会提供所有可能的证据,来证明这个所谓的人工智能探测器是错的。

对此,有网友表示完全无法理解老师的做法:「什么叫AI说你作弊,你就是作弊,证据何在?」

另一位网友则给出了更加实用的建议:把ChatGPT出现之前的文章丢进去看看结果如何。(类似于之前的那个「美国宪法」实验)

此外,还可以用OpenAI的官方声明来为自己辩护:「我们真的不建议孤立地使用这个工具,因为我们知道它可能出错,就像使用人工智能进行任何种类的评估一样」。

还有网友分析称,作业论文在结构上通常都有着较为严格的要求,而ChatGPT在训练中又进行了大量的学习。

结果就是,AI生成的内容看起来都是标准的五段式论文。

因此,学生的作业从一开始,就注定了会和ChatGPT生成的文本非常相似。

GPTzero虽然声称假阳性率<2%,但这个数据(即使是真的)更多的是基于对新闻类内容的评判。

所以该网友认为,我们对GPTzero,或OpenAI的分类器,或任何声称能够可靠地区分人类和AI的工具,都应该抱有怀疑的态度。

ChatGPT暴露了论文设定上的缺陷

AI的出现,让作弊的学生提供的巨大的便利,却也让不作弊的学生,深陷无尽的麻烦。

那么,让我们干脆回归问题的本质,在学校教育中,到底该不该允许学生使用ChatGPT呢?

近日,作家Colm O'Shea在文章《感谢ChatGPT揭露本科论文的平庸》中表示,本科的论文重点是教育,而不是知识的进步。这其中最关键的是,在写作过程中,是要训练和展示你有目的地处理信息的能力,而不是让你做一个有价值的知识产出。有价值的产出是由训练有素的合格劳动力负责的。

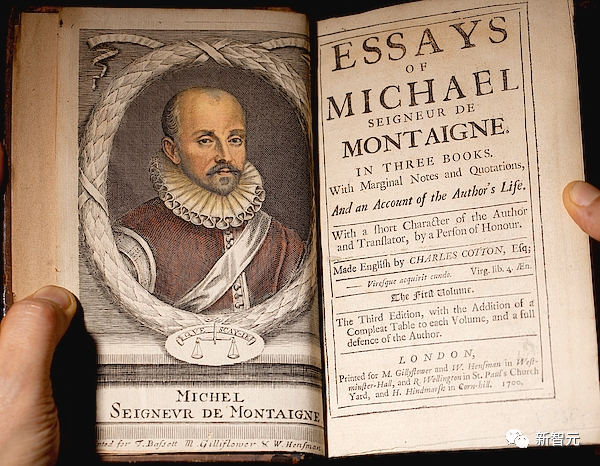

一般来说,文章起源于古希腊和罗马作家的学术文本,或早期基督教会教父的书信,但其实现代文章的形式起源于蒙田。

这位富有而博学的16世纪法国哲学家,在人生中的某个时刻,忽然对自己庞大的图书馆感到怀疑:「如果我以为自己所知道的一切,其实都是扯淡的,怎么办?」

于是,他开始做这件事——写随笔,这个行为具有深远的意义:让他重新看待世界。

他起的标题千奇百怪,比如「拇指」「畸形儿童」「食人族」,展现出他广泛而奇特的精神领域。他的每篇文章都围绕一个观点,并从各个角度进行审视,来找到新的见解,仿佛这些角度是由另一个意识撰写的一样。

录取之后,一部分学生又会去恳求教授,给他们提供一个正确的模板来模仿,亦或者,他们会找抄袭或论文代笔去走捷径,走向他们想象中的未来。

就好像到了大学以后,学习和思考就再也不用写作来辅助了一样。

不过,这是在ChatGPT火起来之前。现在有了ChatGPT,论文剽窃和代写的乱象已经蔚然成风。虽然说这些现象并不能只怪AI,但已经足以说明大学教育中的问题。

症结在哪里?

这场危机,其实源于大学本科教育中一个更巨大、更古老的问题。

长期以来,人们过分关注收敛思维——换句话说,对于有固定解决方案的问题,去测试学生能否获得问题的「正确」答案。

大学申请的测试通常注重两大类:知识基础和认知能力。标准化的测试能够检测学生对学科掌握程度,但这忽略了另一个重要的领域:发散性思维。

而发散性思维,正是创造性工作的前提。

而且,发散性思维是与标准化背道而驰的。发散思维靠的是深度模式识别和类比(口头、视觉、数学)等机制,而要让ChatGPT从令人眼花缭乱的大数据集中收集「要点」,这并不是它们擅长的。

这种思维可以用一个词形容,那就是「机智」(这种机智是一种令人惊讶的灵感,能够把两个不相干的事物进行融合,或者联系起来),虽然听起来有些玄乎,但这种能力非常重要。

认知科学家、类比思维权威专家Dedre Gentner解释说,生动地向自己或他人解释某事可以培养抽象能力,还可以发现不同领域之间的新联系。

对于Gentner来说,相比于看一个人的智商,他进行准确隐喻或类比的能力,更能体现自己的创造性。因为科学的突破,往往就是通过那「惊鸿一瞥」,让人们发现了两个不同事物之间的类比,这种类比充满想象。

同样的,威廉玛丽学院的创意和创新教授K.H Kim认为,亚洲和西方教育体系对趋同思维的痴迷关注,正在减缓整个艺术和科学的创新。

理想状态下,大学论文是要作者玩一个智力游戏,过程中的各种障碍会绊倒他们,让他们意识到自己对于学科的了解只是冰山一角。应对挑战时,游戏的「音效」会提醒他们保持头脑清醒,意识到自己可能犯了错。

然而ChatGPT展示的是最为糟糕的情况:在一个回音室中,对于批判性共识进行了一个优雅齐整的总结。

胡说八道大师

还记得Harry Frankfurt的那篇哲学文章《论胡说八道》(On Bullshit)吗?他在文章中提到了两个概念:撒谎(虚假)和滔滔不绝地提出令人信服却没有经过仔细考虑的主张(胡诌)。

撒谎的人需要一个准确的真相模型来主动向他人隐瞒真相,而胡说八道者则不需要这种意识。

事实上,胡说八道的人可以一整天都在说真话;在Frankfurt看来,说他们胡说八道不是因为他们话语的真假,而是他们随心所欲不计后果的说话方式。他写道:「就凭这一点,废话比谎言更能成为真理的敌人」。

ChatGPT就是Frankfurt「胡说八道」艺术流派的巅峰之作。它使用大型语言模型将人类可能对某个主题说的话拼凑在一起,这是一种令人毛骨悚然的理解模拟,但与对现实世界的洞察力完全脱节。

ChatGPT最引人注目的一个特点就是,它惟妙惟肖地模仿了许多学术文章中特有的口若悬河、毫无生气的散文风格。

Stephen Marche在Atlantic上发表的文章《大学论文已死》,在我和同事中引起了许多讨论。他给ChatGPT生成的示例文本打了B+,而他在解释时说:「这段话读起来就像填充物一样,但是大多数学生作文也是如此。」

这句话让我非常忧心,但也很无奈。

早在ChatGPT之前,废话文学就一直困扰着我们,但我们难道就要顺其自然,任其发展了吗?

虽然听起来像是无可救药的理想主义,但是我要奋起说不!

一个有责任心的学者,应该让文章回归到它应有的蒙田式传统:对各种可能性进行不同的、创造性的发散探索。

这需要进行一些改革,比如远离大讲堂,在那里,学生和教授之间的唯一接触点是一篇匆匆写好的、匆匆打分的论文。而如果控制在较小的师生比例,足以恢复学生和老师之间以及学生之间的辩证交流。

AI将不断发展。机器学习将在各种领域产生数以百万计的新颖方案。

目前,AI的发展会有两个极端方向:没有新意的趋同和收敛,以及没有「适当性」意识的极端分歧。

这里借用Dean Keith Simonton对于创造力的定义:原创性x适当性。

「适当性」是特定领域的一套庞大的维特根斯坦式的「语言游戏」,其深度和广度只会随着我们的文化变得更加复杂而增加。这套深层次的「游戏」过于微妙,它是非理性的,而且变化迅速,AI无法仅通过挖掘我们的文本来掌握。

在一个理想的未来,教育可能会优先培养所有年龄段的学生在所有学习领域的好奇心、创造力和敏感性。这个项目令人振奋,不过有些迟了。

这并不意味着如果我们比不过AI,就放弃获取知识了,它需要我们重新开始「玩」我们的想法,以及围绕我们如何学习、为什么学习进行元认知的实践。

对于有情感的众生来说,最终极游戏是当他们被邀请按照自己的条件提出问题时,他们的答案会让自己都感到惊讶,他们会发现自己的答案是多么有启发性。

人类自身的神奇思维可是比AI的模仿理解力要好得多。

在文末,小编想说,Colm O'Shea的这篇文章,真的是让我们爱惨了。

经常有读者留言问我们的文章是不是ChatGPT写的,这里可以借用这篇文章的观点来回答:如果你能感受到文章中「惊鸿一瞥」的那一瞬间,这种创作一定是来自人类,而不是AI。