哈喽,大家好。

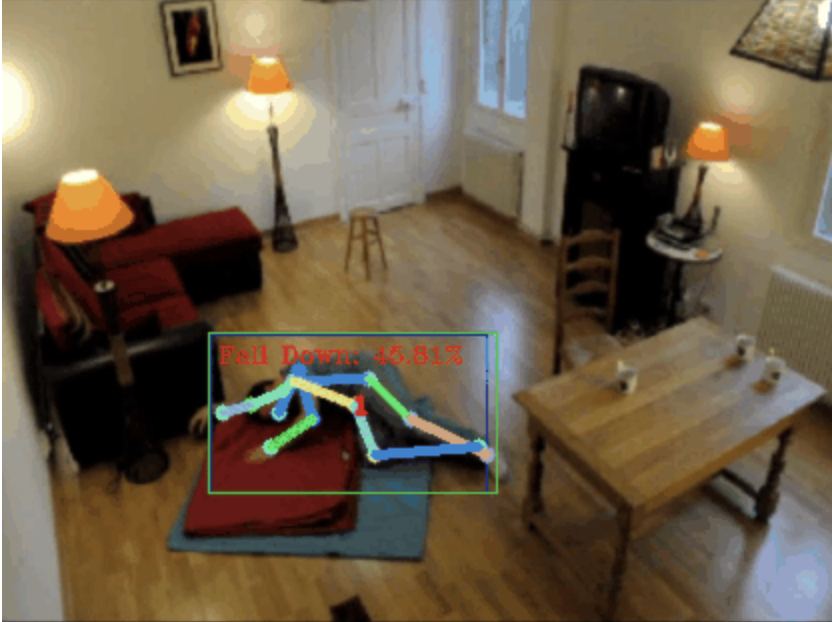

今天给大家分享一个摔倒检测项目,准确地说是基于骨骼点的人体动作识别。

大概分为三个步骤

- 识别人体

- 识别人体骨骼点

- 动作分类

项目源码已经打包好了,获取方式见文末。

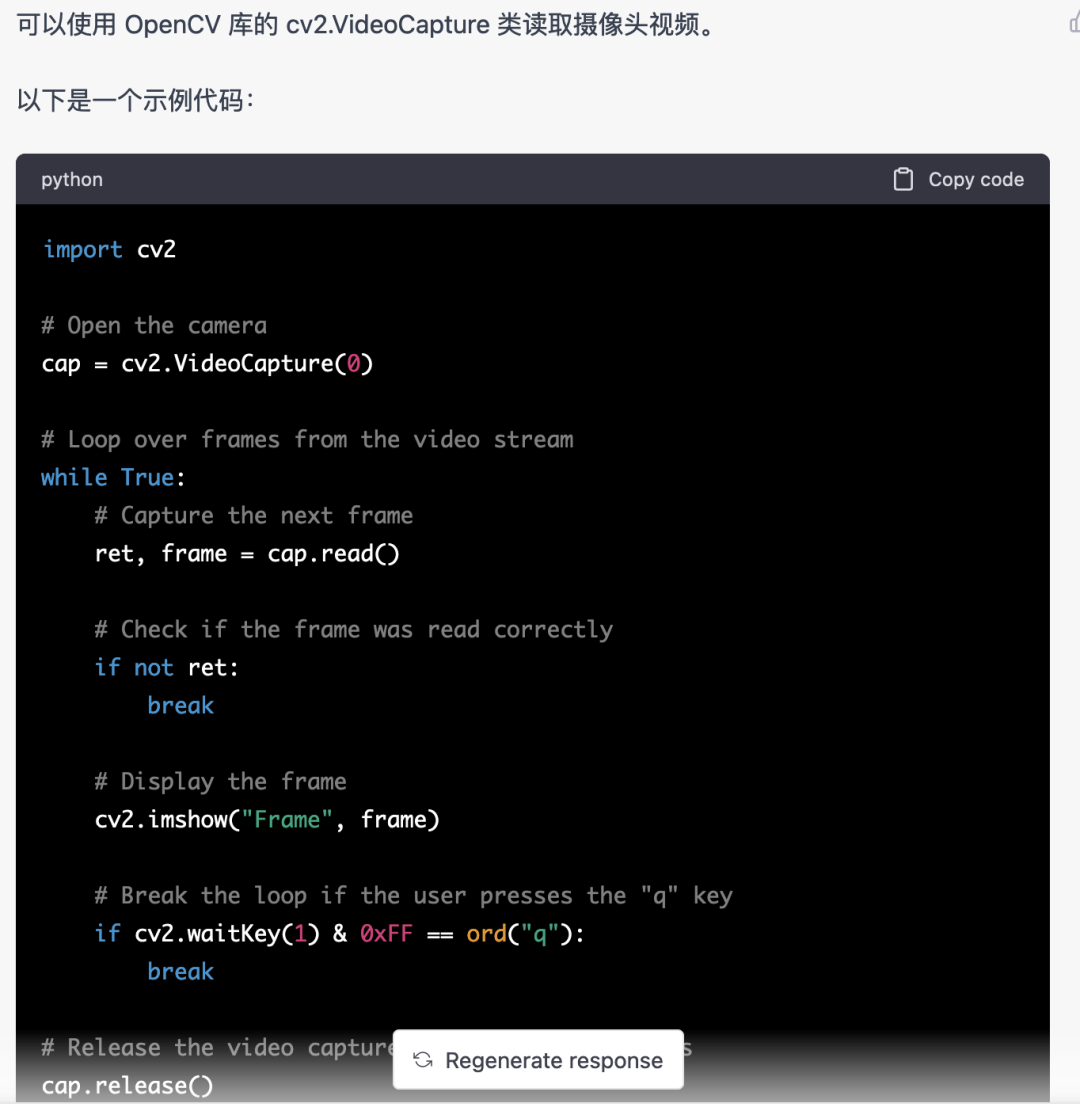

0. chatgpt

首先,我们需要获取监控的视频流。这段代码比较固定,我们可以直接让chatgpt完成

chatgpt写的这段代码是没有问题的,可以直接使用。

但后面涉及到业务型任务,比如:用mediapipe识别人体骨骼点,chatgpt给出的代码是不对的。

我觉得chatgpt可以作为一个工具箱,能独立于业务逻辑,都可以试着交给chatgpt完成。

所以,我觉得未来对程序员的要求会更加注重业务抽象的能力。扯远了,言归正传。

1. 人体识别

人体识别可以用目标检测模型,比如:YOLOv5,之前我们也分享过好多训练YOLOv5模型的文章。

但这里我没有用YOLOv5,而是用mediapipe。因为mediapipe运行速度更快,在 CPU 上也能流畅地运行。

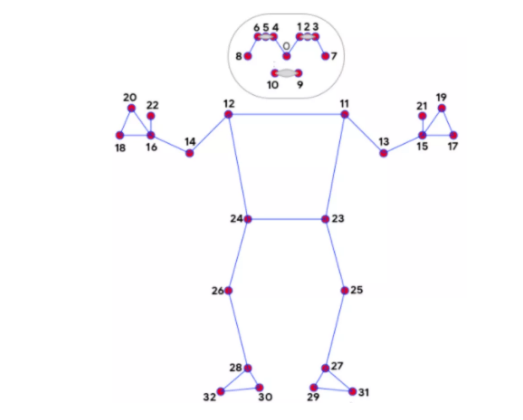

2. 骨骼点识别

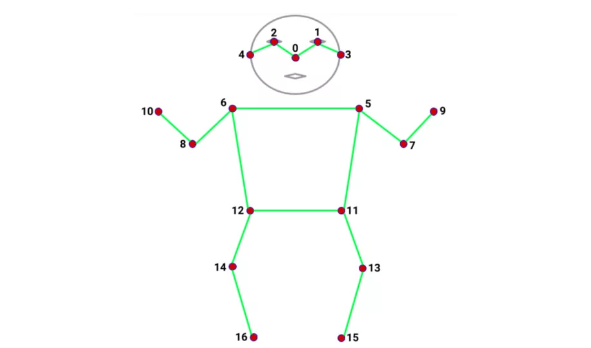

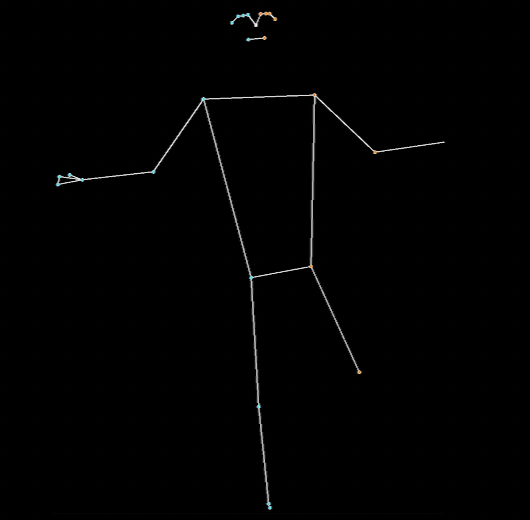

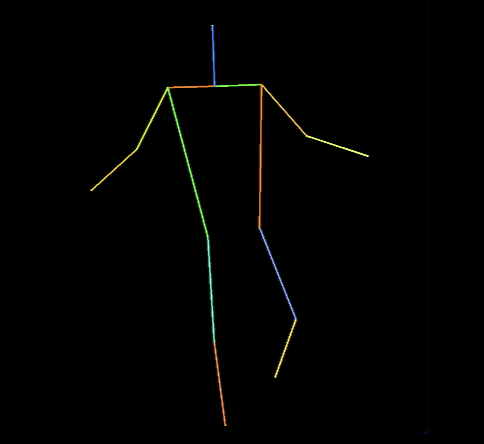

识别骨骼点的模型有很多,如:alphapose、openpose,每种模型识别出来的骨骼点个数和位置都有所差异。比如下面这两种:

mediapipe 32个骨骼点

coco 17个骨骼点

骨骼点的识别我仍然使用mediapipe,除了速度快,另一个优势是mediapipe识别的骨骼点多,有 32 个,能满足我们的使用。因为下面要用的人体动作分类,强依赖于骨骼点。

3. 动作识别

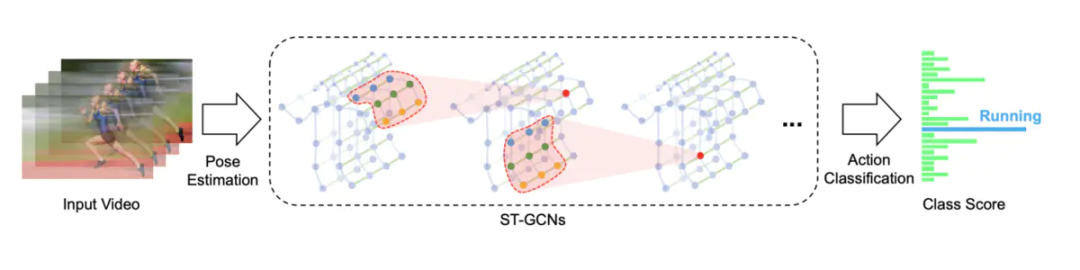

动作识别使用的是基于骨架动作识别的时空图卷积网络,开源方案是STGCN(Skeleton-Based Graph Convolutional Networks)

https://github.com/yysijie/st-gcn

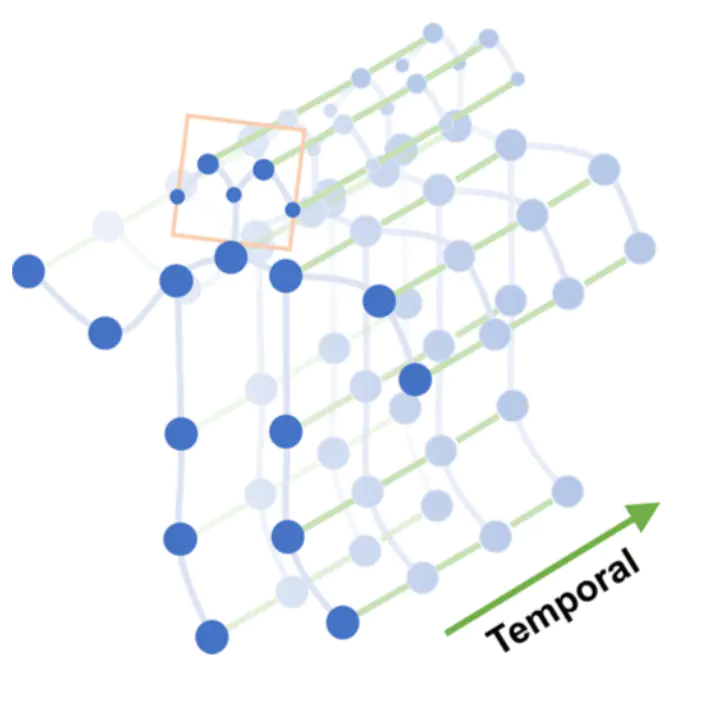

一组动作,如:摔倒,由 N 帧组成,每一帧可以构造出以骨骼点坐标组成的空间图,骨骼点在帧之间连接起来就构成时间图,骨骼点的连接和时间帧的连接便可以构造一张时空图。

时空图

在时空图上进行多层图卷积运算,便可生成更高层次的特征图。然后输入到SoftMax分类器进行动作分类(Action Classification)。

图卷积

本来我打算训练STGCN模型的,但遇到的坑实在是太多了,最后直接用了别人训练好的模型。

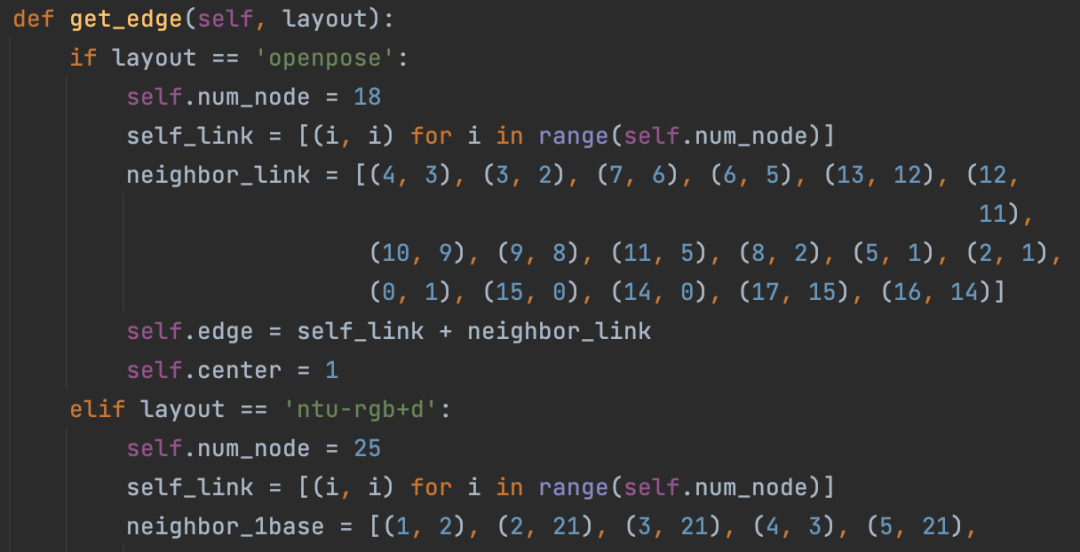

坑1. STGCN 支持 OpenPose 识别的骨骼点,有数据集Kinetics-skeleton可以直接用。坑的地方在于OpenPose安装太麻烦,需要一堆步骤,挣扎后放弃。

坑2. STGCN 还支持 NTU RGB+D数据集,该数据集有 60 个动作分类,如:起立、行走、摔倒等。这份数据集的人体包含 25 个骨骼点,只有坐标数据,原始视频基本搞不到,所以没办法知道这 25 个骨骼点对应哪些位置,以及用什么模型能识别出这 25 个骨骼点,挣扎后放弃。

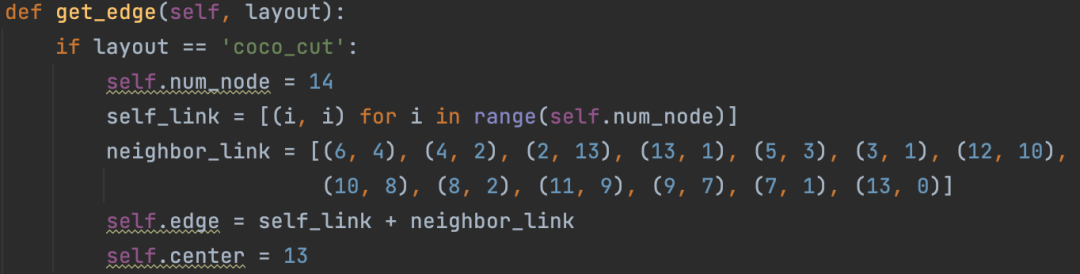

上面两个大坑,导致没法直接训练STGCN模型,找了一个开源的方案,它用的是alphapose识别 14 个骨骼点,同时修改STGCN源码支持自定义骨骼点。

https://github.com/GajuuzZ/Human-Falling-Detect-Tracks

我看了下mediapipe包含了这 14 个骨骼点,所以可以用mediapipe识别的骨骼点输入他的模型,实现动作分类。

mediapipe 32个骨骼点

选出14个关键骨骼点

14个骨骼点提取代码:

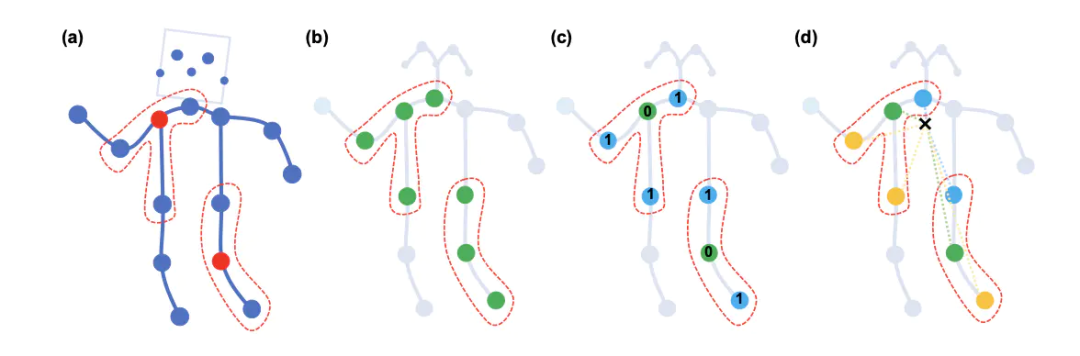

STGCN原始方案构造的空间图只支持openpose18个骨骼点和NTU RGB+D数据集25个骨骼点

修改这部分源码,以支持自定义的14个骨骼点

模型直接使用Human-Falling-Detect-Tracks项目已经训练好的,实际运行发现识别效果很差,因为没有看到模型训练过程,不确定问题出在哪。

有能力的朋友可以自己训练模型试试,另外,百度的Paddle也基于STGCN开发了一个跌倒检测模型,只支持摔倒这一种行为的识别。

当然大家也可以试试Transformer的方式,不需要提取骨骼点特征,直接将 N 帧图片送入模型分类。

关于STGCN的原理,大家可以参考文章:https://www.jianshu.com/p/be85114006e3 总结的非常好。

需要源码的朋友留言区回复即可。

如果大家觉得本文对你有用就点个 在看 鼓励一下吧,后续我会持续分享优秀的 Python+AI 项目。