波士顿动力的一个后空翻,让我们看到了人造机器人所带来的无限可能。

尽管谷歌已于2017年把波士顿动力出手了,但谷歌仍然继续他们的机器人开发之路,不只是在「身体」上逼近人类,在「智力」也追求更好的理解人类指令。

由Jeff Dean领衔的Google Research年终总结系列「Google Research, 2022 & beyond」已经更新到第六期,本期的主题是「机器人」,作者为高级产品经理 Kendra Byrne和谷歌机器人研究科学家Jie Tan

在我们的有生之年,一定能看到机器人技术参与到人类的日常生活中,帮助提高人类的生产力和生活质量。

在机器人技术广泛应用于以人为中心的空间(即为人而设计的空间,而不是机器)中的日常实际工作之前,需要确保它们能够安全地为人们提供帮助。

在2022年,谷歌关注的挑战是使机器人更有助于人类:

- 让机器人和人类更有效和自然地交流;

- 使机器人能够理解和应用现实世界中的常识知识;

- 扩大机器人在非结构化环境中有效执行任务所需的低层次技能的数量。

当LLM遇上机器人

大型语言模型(LLM)的一个特性是能够将描述和上下文编码成「人和机器都能理解」的格式。

当把LLM应用到机器人技术中时,可以让用户仅通过自然语言指令就能给机器人分配任务;当与视觉模型和机器人学习方法相结合时,LLM 为机器人提供了一种理解用户请求的上下文的方法,并能够对完成请求所采取的行动进行规划。

其中一个基本方法是使用 LLM 来提示其他预先训练的模型获取信息,以构建场景中正在发生的事情的上下文,并对多模态任务进行预测。整个过程类似于苏格拉底式的教学方法,教师问学生问题,引导他们通过一个理性的思维过程来解答。

在「苏格拉底模型」中,研究人员证明了这种方法可以在zero-shot图像描述和视频文本检索任务中实现最先进的性能,并且还能支持新的功能,比如回答关于视频的free-form问题和预测未来的活动,多模态辅助对话,以及机器人感知和规划。

论文链接:https://arxiv.org/abs/2204.00598

在「迈向有益的机器人: 机器人可用性的基础语言」一文中,研究人员与Everyday Robots合作,在机器人可用性模型中基于PaLM语言模型规划长期任务。

博客链接:https://ai.googleblog.com/2022/08/towards-helpful-robots-grounding.html

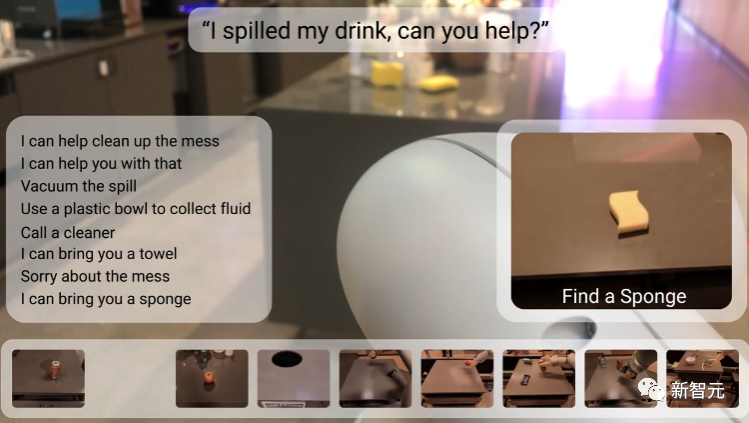

在之前的机器学习方法中,机器人只能接受诸如「捡起海绵」等简短的硬编码命令,并且难以推理完成任务所需的步骤,如果任务是一个抽象的目标,比如「你能帮忙清理这些洒出来的东西吗?」,就更难处理了。

研究人员选择使用 LLM 来预测完成长期任务的步骤顺序,以及一个表示机器人在给定情况下实际能够完成的技能的affordance 模型。

强化学习模型中的价值函数可以用来建立affordance 模型,即一个机器人在不同状态下可以执行的动作的抽象表示,从而将现实世界中的长期任务,如「整理卧室」与完成任务所需的短期技能,如正确挑选、放置和安排物品等联系起来。

论文链接:https://arxiv.org/abs/2111.03189

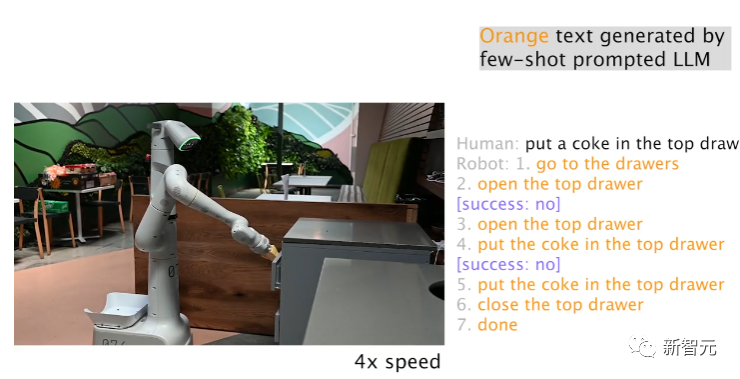

同时拥有 LLM 和affordance 模型并不意味着机器人能够成功地完成任务,通过内心独白( Inner Monologue),可以结束基于 LLM 的任务规划中的循环;利用其他信息来源,如人工反馈或场景理解,可以检测机器人何时无法正确完成任务。

论文链接:https://arxiv.org/abs/2207.05608

利用Everyday Robots中的一个机器人,研究人员发现 LLM 可以有效地重新规划当前或以前的失败计划步,机器人可以从失败中恢复并完成复杂的任务,比如「把一个可乐放在最上面的抽屉里」。

在基于 LLM 的任务规划中,其中一个突出能力就是机器人可以对高级目标中间任务的变化做出反应:例如,用户可以告诉机器人在发生的事,通过提供快速纠正或重定向机器人到另一个任务,从而可以改变已经规划好的行动,对于让用户交互式地控制和定制机器人任务特别有用。

虽然自然语言使人们更容易指定和修改机器人的任务,但还有一个挑战是对人类描述做出实时反应。

研究人员提出了一个大规模的模仿学习框架,用于生产实时的、开放词汇的、以语言为条件的机器人,能够处理超过87,000个独特的指令,估计平均成功率为93.5% ;作为该项目的一部分,谷歌还发布了当下规模最大的语言标注机器人数据集 Language-Table

论文链接:https://arxiv.org/pdf/2210.06407.pdf

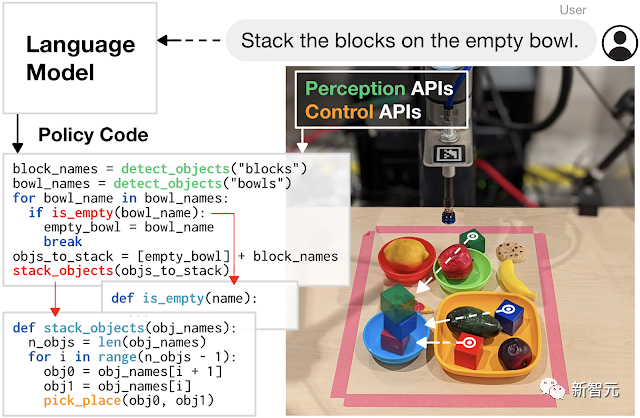

并且,用LLM 编写代码来控制机器人动作也是一个有前景的研究方向。

研究人员开发的代码编写方法展示了增加任务复杂性的潜力,机器人可以通过自主生成新代码来重新组合 API 调用,合成新函数,并表达反馈循环来在运行时合成为新行为。

论文链接:https://arxiv.org/abs/2209.07753

将机器人学习转化为一个可扩展的数据问题

大型语言和多模态模型可以帮助机器人理解他们操作的环境,比如场景中发生了什么以及机器人应该做什么;但是机器人也需要低层次的物理技能来完成物理世界中的任务,比如拾起和精确放置物体。

虽然人类经常认为这些身体技能是理所当然的,无需思考的情况下就能完成各种动作,但对机器人来说却是个难题。

比如,机器人在拾取物体时,需要感知和理解环境,推导出手爪与物体之间的空间关系和接触动力学,精确地驱动高自由度手臂,并施加适当的力量以稳定地抓取物体而不破坏物体。

学习到这些低层次技能的难题被称为莫拉维克悖论:推理只需要很少的计算,但感觉运动和知觉技能需要大量的计算资源。

受到 LLM 的成功启发,研究人员采用一种数据驱动的方法,将学习低层次物理技能的问题转变为一个可扩展的数据问题:LLM 表明,大型Transformer模型的通用性和性能随着数据量的增加而增加。

论文链接:https://robotics-transformer.github.io/assets/rt1.pdf

研究人员提出机器人Transformer -1 (RT-1) 模型,训练了一个机器人操作策略,用到的训练数据为13万个episodes的大规模现实世界的机器人数据集,使用了来自Everyday Robots的13个机器人,覆盖了700多个任务,并显示了机器人技术的相同趋势,即增加数据的规模和多样性可以提高模型对新任务、环境和对象的泛化。

在语言模型和机器人学习方法(如 RT-1)的背后,都是 Transformer模型基于互联网规模的数据训练得到的;但与 LLM 不同的是,机器人学面临着不断变化的环境和有限计算的多模态表示的挑战。

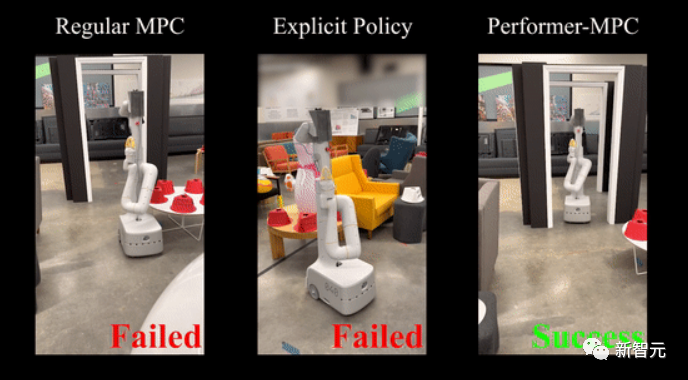

2020年,谷歌提出了一种能够提高Transformer计算效率的方法Performers,影响到包括机器人技术在内的多个应用场景。

最近研究人员扩展该方法,引入一类新的隐式控制策略,结合了模拟学习的优势和对系统约束的鲁棒处理(模型预估计控制的约束)。

论文链接:https://performermpc.github.io/

与标准的 MPC 策略相比,实验结果显示机器人在实现目标方面有40% 以上的进步,在人类周围导航时,social指标上有65% 以上的提升;Performance-MPC 为8.3 M 参数模型的延迟仅为8毫秒,使得在机器人上部署Transformer变得可行。

谷歌的研究团队还证明,数据驱动方法通常适用于不同环境中的不同机器人平台,以学习范围广泛的任务,包括移动操作、导航、运动和乒乓球等,也为学习低层次机器人技能指明了一条明确的道路:可扩展的数据收集。

与互联网上丰富的视频和文本数据不同,机器人数据极其稀缺,难以获取,收集和有效使用代表真实世界交互的丰富数据集的方法是数据驱动方法的关键。

仿真是一种快速、安全和易于并行化的选择,但是在仿真中很难复制完整的环境,特别是物理环境和人机交互环境。

论文链接:https://arxiv.org/abs/2207.06572

在 i-Sim2Real 中,研究人员展示了一种方法,通过从简单的人类行为模型中自举,并在模拟训练和在现实世界中部署之间交替进行,来解决仿真与现实之间的不匹配问题,并学习与人类对手打乒乓球,在每次迭代中,人类行为模型和策略都会得到细化。

虽然模拟可以辅助收集数据,但是在现实世界中收集数据对于微调模拟策略或在新环境中适应现有策略至关重要。

在学习过程中,机器人很容易失败,并可能会对它自身和周围环境造成损害,特别是在探索如何与世界互动的早期学习阶段,需要安全地收集训练数据,使得机器人不仅学习技能,还可以从故障中自主恢复。

论文链接:https://arxiv.org/abs/2110.05457

研究人员提出了一个安全的 RL 框架,在「学习者策略」和「安全恢复策略」之间进行切换,前者优化为执行所需任务,后者防止机器人处于不安全状态;训练了一个复位策略,这样机器人就能从失败中恢复过来,比如在跌倒后学会自己站起来。

虽然机器人的数据很少,但是人类执行不同任务的视频却很多,当然机器人和人的构造有不同之处,因此让机器人向人类学习的想法引发了「 跨不同实体迁移学习」的问题。

论文链接:https://arxiv.org/pdf/2106.03911.pdf

研究人员开发了交叉具身反向强化学习(Cross-Embodiment Inverse Reinforcement Learning),通过观察人类来学习新的任务,并非是试图像人类那样精确地复制任务,而是学习高层次的任务目标,并以奖励函数的形式总结这些知识,示范学习可以让机器人通过观看互联网上随时可用的视频来学习技能。

另一个方向是提高学习算法的数据效率,这样就不再仅仅依赖于扩展数据收集:通过合并先验信息,包括预测信息、对抗性动作先验和指导策略,提高了 RL 方法的效率。

论文链接:https://arxiv.org/abs/2210.10865

利用一种新的结构化动力系统体系结构,将 RL 与轨迹优化相结合,在新型求解器的支持下,得到了进一步的改进,先验信息有助于缓解勘探的挑战,更好地规范数据,并大大减少了所需的数据量。

此外,机器人团队还投入了大量的资金在更有效的数据模拟学习上,实验证明了一种简单的模仿学习方法 BC-Z 可以对训练中没有看到的新任务进行zero-shot泛化。

论文链接:https://arxiv.org/pdf/2210.02343.pdf

并且还引入了一个迭代模仿学习算法 GoalsEye,从游戏中学习和目标条件行为克隆相结合,用于高速高精度的乒乓球游戏。

论文链接:https://sites.google.com/view/goals-eye

在理论方面,研究人员研究了表征模拟学习样本复杂性的动态系统稳定性,以及捕获演示数据中的失效和恢复以更好地调节小数据集离线学习的作用。

论文链接:https://proceedings.mlr.press/v168/tu22a.html

总结

人工智能领域大型模型的进步促进了机器人学习能力的飞跃。

在过去的一年里,可以看到 LLM 中捕捉到的上下文感觉和事件顺序帮助解决机器人技术的长期规划,并使机器人更容易与人互动和完成任务。还可以看到用可扩展的路径来学习鲁棒性和泛化机器人行为,通过应用Transformer模型架构的机器人学习。

谷歌承诺将继续开放源代码数据集,在新的一年继续发展有用的机器人。