来自浙江大学、北京大学、哈佛医学院、剑桥大学及西湖大学的交叉研究团队在NeurIPS 2022 Datasets and Benchmarks 发布数据集METS-CoV,是首个从医学角度标注新冠社交媒体文本的命名实体(NER)和目标实体情感分析(TSA)的数据,可帮助研究人员使用自然语言处理模型从社交媒体文本中挖掘更有价值的医学信息。

发表会议:NeurIPS 2022

论文地址:https://arxiv.org/abs/2209.13773

GitHub地址:https://github.com/YLab-Open/METS-CoV

实验室主页:https://ylab.top

引言

近年来,新冠肺炎(COVID-19)的爆发对人们的生活产生了严重影响,给公共卫生安全带来了巨大挑战。为了评估疫情对公众的影响,流行病学专家及医学研究人员一般通过临床随访、问卷调查和应用程序跟踪等方式开展研究,但仍存在样本规模小和即时性差等问题。

而社交媒体由于用户群庞大、用户参与度高且信息传播速度快,已成为公众发表其对新冠相关话题的评论和感受的重要渠道,使得开展大规模、低成本的新冠疫情追踪研究成为可能。

进一步地,通过社交媒体平台(如Twitter)跟踪和分析人们的观点,可以推动医学研究的发展及公共卫生管理政策的指定,因此具有极大的研究价值。

然而,现有自然语言处理(NLP)工具一般面向通用领域开发,对文本的质量有着较为严格的要求,而社交媒体文本不同于正式文本,一般并不遵循严格的排版和语言规则,语言风格更加随意,这加大了现有NLP工具的分析难度,导致其准确性下降。

此外,现有的NLP工具并非专门为医学或公共卫生研究而设计,因此难以满足流行病学专家对于新冠相关主题分析的需求。

换言之,目前NLP工具之所以在新冠相关社交媒体文本上表现不佳,其根本原因在于缺乏从医学角度设计和标注的新冠相关社交媒体文本数据集。

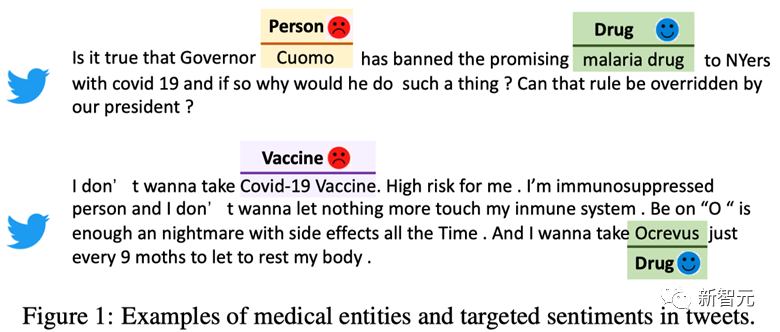

另一方面,对于在社交媒体文本上开展的新冠相关研究,最重要的分析目标之一是找到用户讨论的实体(包括通用实体类型和医学实体类型)及对它们的观点或态度。

对应于两个基本的NLP任务:命名实体识别(NER)和目标实体情感分析(TSA)。

NER旨在从非结构化文本中提取实体信息,而TSA旨在预测用户对目标实体的情感极性。尽管目前已有不少面向通用领域或者特定领域如新闻、电商的NER和TSA数据集,但面向医疗领域社交媒体文本的数据集仍然空缺,这也加大了在社交媒体文本上进行细粒度分析并开展新冠相关研究的难度。

在本文中,来自浙江大学、北京大学、哈佛医学院、剑桥大学及西湖大学的交叉研究团队在NeurIPS 2022 Datasets and Benchmarks 发布数据集METS-CoV,是首个从医学角度标注新冠社交媒体文本的命名实体(NER)和目标实体情感分析(TSA)的数据,旨在帮助研究人员使用自然语言处理模型从社交媒体文本中挖掘更有价值的医学信息。

该数据集包含10,000条推文,对4种医学实体类型(疾病、药物、症状和疫苗)和3种通用实体类型(人、地点和组织)进行了人工标注。

此外,为了研究用户对特定实体的态度,标注人员还对人、组织、药物和疫苗四种实体的情感极性进行了标注。

与其他NER和TSA数据集不同,METS-CoV是从公共卫生研究的角度构建的,有助于自然语言处理工具在医疗领域的定制化开发,从而促进计算社会科学(特别是流行病学)研究的开展。

例如,使用基于METS-CoV数据集训练的NER和TSA模型,研究人员可以追踪公众对新冠疫苗接种的态度,以制定更有效的疫苗政策;可以追踪公众在新冠传播的不同阶段的心理状况,提供解决全球心理健康危机的潜在解决方案等。

为了保证数据集的质量,研究者设计了详细的标注指南,使用的标注人员均具有医学相关教育背景。

进一步地,基于METS-CoV数据集,研究者对NER和TSA任务上所采用的经典机器学习模型和最先进的深度学习模型进行了性能基准测试。测试结果表明,现有模型在METS-CoV数据集上还有较大的提升空间。

数据集描述

数据收集与标注

研究者收集了从2020年2月1日到2021年9月30日期间用户发表的新冠推文,所有推文均通过Twitter的官方API获取,严格遵守平台的数据安全政策。

在进行数据预处理时,研究者首先删除了非英语推文、转推以及包含URL的推文(它们通常是第三方消息的重述,不能直接反映用户的意图和态度),然后,使用症状关键词列表来筛选与医学相关的推文。预处理完成后,还剩下2,208,676条推文。

METS-CoV的标注过程可以划分为两个阶段:命名实体标注和目标实体情感标注。相应的,METS-CoV数据集可以按照任务类型划分为两个数据子集,即METS-CoV-NER数据集和METS-CoV-TSA数据集。

所有标注工作均通过YEDDA标注平台(https://github.com/jiesutd/YEDDA)完成,所有的标注者都具有医学教育背景,如医学、公共卫生和制药科学等。

在进行命名实体标注时,研究者首先根据公共卫生研究的需求,定义了 7 种实体类型,包括 3 种通用实体类型和 4 种医学实体类型,接着,从预处理的推文中随机采样了 6,000 条推文进行命名实体标注。

然后使用这 6,000 条已标注数据训练基于 BERT 的命名实体识别模型,由该模型完成其余推文的标注。为了在数据集中包括更多的医学实体,研究者从模型标注的推文中筛选了 4,000 条包含药物或疫苗实体的推文,由标注人员进行人工校验并加入到数据集中。

最终,构建好的METS-CoV-NER数据集中一共包含了 10,000 条推文。

进一步地,研究者选择了人、组织、药物和疫苗四种实体作为目标实体并从METS-CoV-NER数据集中筛选出包含目标实体的推文,标注人员根据目标实体所在的上下文标注其情感极性。

情感极性标签一共有3种:积极、消极和中性。最终,METS-CoV-TSA数据集中一共包含5,278条推文。

数据集统计信息

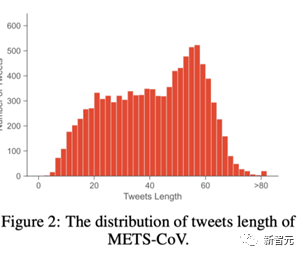

大多数推文的长度都小于80个token。其中,长度为50左右的推文占比最高。

METS-CoV中推文长度的分布情况

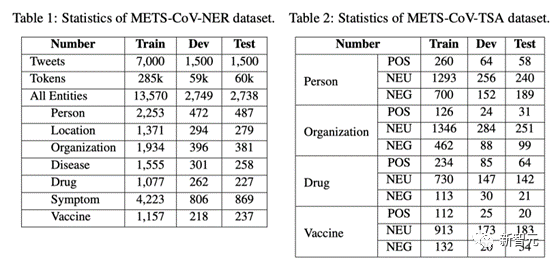

推文总数为10,000条, 一共标注了19,057个实体,平均每个推文中包含了1.91个实体。在所有实体中,症状实体的出现频率最高,这是由于在预处理阶段使用了症状关键词列表进行数据预过滤。

除了症状实体以外,其他六种实体类型的比例均衡。

METS-CoV-NER数据集的统计信息

在METS-CoV-TSA数据集的统计信息中可以发现,中性情感占据的比例最高。对于药物实体来说,用户的正面情感明显高于负面情感,而对于疫苗实体,用户的正负面情感比例相近。

模型基准测试

在本文中,研究者系统评估了统计机器学习模型、神经网络、通用领域大规模预训练语言模型(PLM)以及新冠相关的PLM四大类模型在METS-CoV-NER和METS-CoV-TSA上的性能,并进行了深入的分析和讨论。

命名实体识别

baseline模型

包括CRF、WLSTM、CCNN、CLSTM、BERT、RoBERTa、BART、BERTweet-covid19和COVID-TWITTER-BERT。所有实验使用NCRF++(https://github.com/jiesutd/NCRFpp)完成。模型的超参数使用Yang等人(2018a)的默认设置。

数据处理

按照70:15:15的比例将数据集划分为训练集、验证集和测试集,统计结果见表1。

实验结果:研究者使用micro-F1来评估所有的模型,表3展示了测试结果。从该表中可以发现,COVID-TWITTER-BERT性能表现最佳,平均micro-F1值为83.88,显著优于基于CRF或BiLSTM(及其变体)的传统NER模型和通用领域PLM。

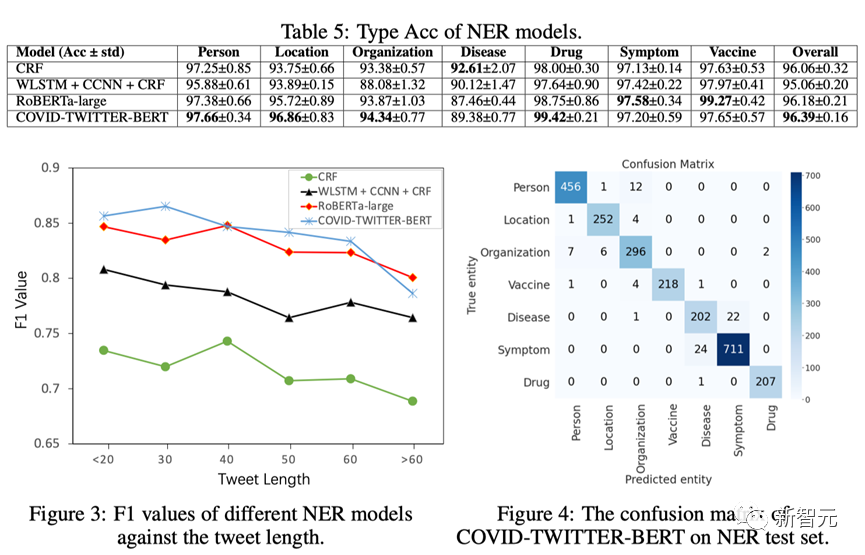

进一步地,研究者从统计机器学习、神经网络、通用领域PLM和新冠相关PLM四大类别中选择每个类别中表现最佳的模型,即CRF、WLSTM+CCNN+CRF、RoBERTa-large和COVID-TWITTER-BERT,采用Span F1和Type Accuracy(Type Acc.)两大指标来评估它们的性能。

Span F1表示NER中实体范围的正确性,而Type Acc.指标则表示预测实体中范围和类型均预测正确的实体占所有预测实体的比例。

如表4和表5所示,COVID-TWITTER-BERT在两个指标上的平均表现最佳,其次是RoBERTa-large。

具体来说,COVID-TWITTER-BERT在人物和组织实体上的表现比RoBERTa-large更好,在Span F1方面分别提高了3.72%和2.53%。对于Type Acc指标,COVID-TWITTER-BERT在四种实体类型(人物、地点、组织和药物)上的表现最好。这些结果验证了在新冠相关推文上对语言模型进行增量预训练的有效性。

此外,研究者还探究了推文长度对模型性能的影响:如图3所示,当推文长度较短(少于40个token)时,所有模型的表现都更好,而处理的推文越长,模型的性能越差。研究者还计算了COVID-TWITTER-BERT模型在测试集上的混淆矩阵。

从图4中可以发现,在大多数情况下,COVID-TWITTER-BERT可以正确提取实体。但是,在识别症状和疾病实体时容易出现混淆,因为这两类实体通常具有相似的表达和上下文语境。以上实验和分析表明,COVID-TWITTER-BERT可以被视为METS-CoV- NER数据集的一个强基线模型,尽管如此,现有模型在该数据集上的性能表现仍有很大的提升空间。例如,疾病和组织实体的F1值仍然较低。

目标实体情感分析

baseline模型

SVM、ASGCN、LSTM、TDLSTM、MemNet、IAN、MGAN、TNet-LF、BERT-base-uncased+AEN/LCF/BERT-SPC/depGCN/kumaGCN/dotGCN,COVID-TWITTER-BERT+BERT-SPC/depGCN/kumaGCN/dotGCN。模型的超参数均采用与原论文一致的设置。

数据处理

TSA训练数据集是NER训练数据集的子集,仅保留包含目标实体的推文。采用类似的方式可以构建TSA的开发集和测试集。

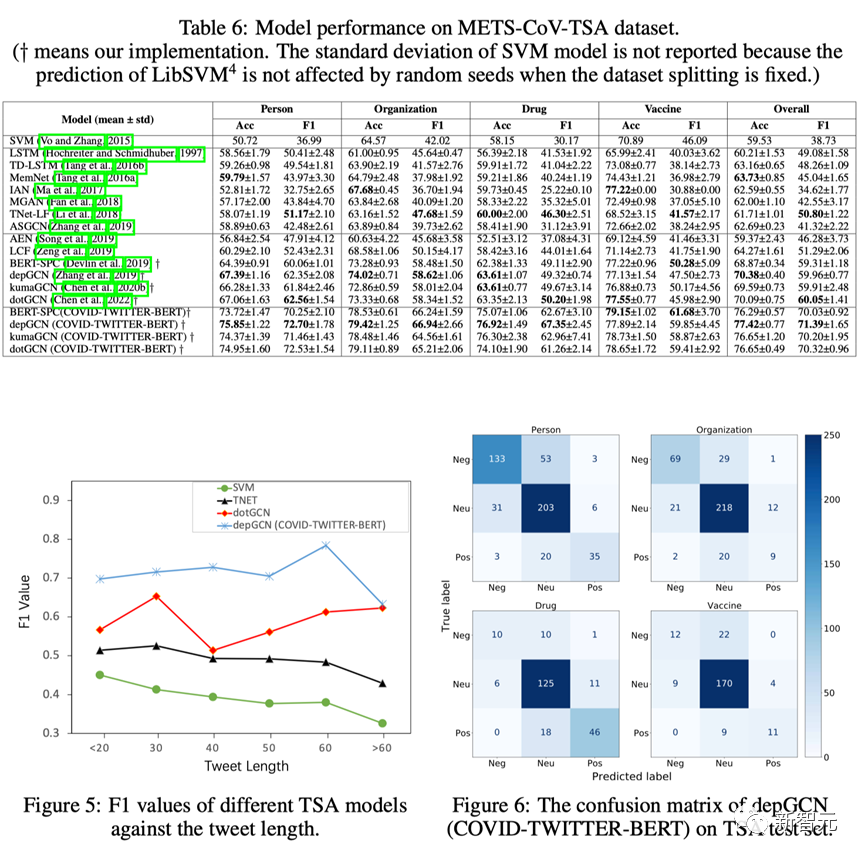

实验结果:研究者使用正确率(Acc.)和F1值来评估所有的基线模型,实验结果如表6所示:将COVID-TWITTER-BERT作为特征提取器的模型明显优于其他类型的模型。

具体来说,与基于BERT的depGCN相比,基于COVID-TWITTER-BERT的depGCN模型在人物实体上表现最佳,其Acc.和F1值分别提高了8.46%和10.35%。

对于组织实体,基于COVID-TWITTER-BERT的depGCN模型性能最优,准确率和F1值相较于其他模型至少提高了5.4%和8.32%。

对于药物实体,基于COVID-TWITTER-BERT的depGCN模型显著优于其他模型,与基于BERT的depGCN相比,其准确率和F1值分别提高了13.31%和18.03%。

对于疫苗实体,基于COVID-TWITTER-BERT的BERT-SPC模型表现最佳,与其他模型相比其准确率和F1值分别提高了1.6%和11.4%。

研究者从各类模型中筛选出最佳模型,即SVM,MemNet,depGCN(BERT-base)和depGCN(COVID-TWITTER-BERT)并探索了推文长度对这四种模型的影响。

如图5所示,推文长度对不同TSA模型的影响存在明显差异。对于SVM和TNET,F1值随着推文长度的增加而逐渐下降。对于dotGCN,当推文长度在20到40之间时,F1值会有一定程度的波动,之后,F1值会随着推文长度的增加而提高。对于depGCN(COVID-TWITTER-BERT),当推文长度小于50时,F1值保持稳定,然后增加到0.8,最后降至约0.6。

最后研究者对平均性能表现最佳的模型,即depGCN(COVID-TWITTER-BERT),进行了深入分析,计算其在测试集上的混淆矩阵(图6)。

结果显示,对于所有的目标实体,大部分的混淆是由于积极(消极)和中性之间的误分类引起的。

总而言之,虽然可以利用在新冠推文上增量预训练的模型(例如COVID-TWITTER-BERT)来进一步改善现有TSA模型在METS-CoV-TSA数据集上的性能,但是情感极性的区分效果欠佳,亟需开发更加强大且稳健的TSA模型以更加准确地识别出目标实体的情感极性。

结论

在本文中,研究者构建了首个面向新冠相关推文的医学实体识别和情感分析数据集METS-CoV,该数据集从医学研究的角度构建。

充分考虑了医学领域的特点,因此可以帮助研究人员使用自然语言处理模型从推文中挖掘有价值的医学信息。

此外,研究者以该数据集为基础,对目前最先进的NER模型和TSA模型进行了全面的性能评估。

实验结果表明,METS-CoV是一个具有挑战性的数据集,现有模型尚未在该数据集上取得令人满意的性能表现。

除了数据集之外,研究者还开源了标注指南、基准模型和源代码,希望借此鼓励更多的研究人员参与到医学相关数据集和模型的构建工作中来,为推动医学社交媒体研究的发展贡献力量。