chatGPT已经具备了人类独心智,这话不是我说的,是一位来自斯坦福大学计算机科学家说的。

很多玩过chatGPT的人都见识过他的”无所不知”,但是,我觉得最让我吃惊的是,他比以前我们用过那些对话机器人最大的差别就是你甚至可能发现不了他是机器人。

这就是在业内大家普遍认为的他可以通过图灵测试。即使这样,很多人也不担心,因为毕竟他只是个大语言模型,主要就是做内容生成的机器人罢了。

但是,有学者在对chatGPT的同源模型GPT-3.5做了一系列测试以后,发现它具有了理解他人或自己心理状态的能力,能解决93%的心智理论任务,心智相当于9岁儿童。

他是怎么测试的呢?

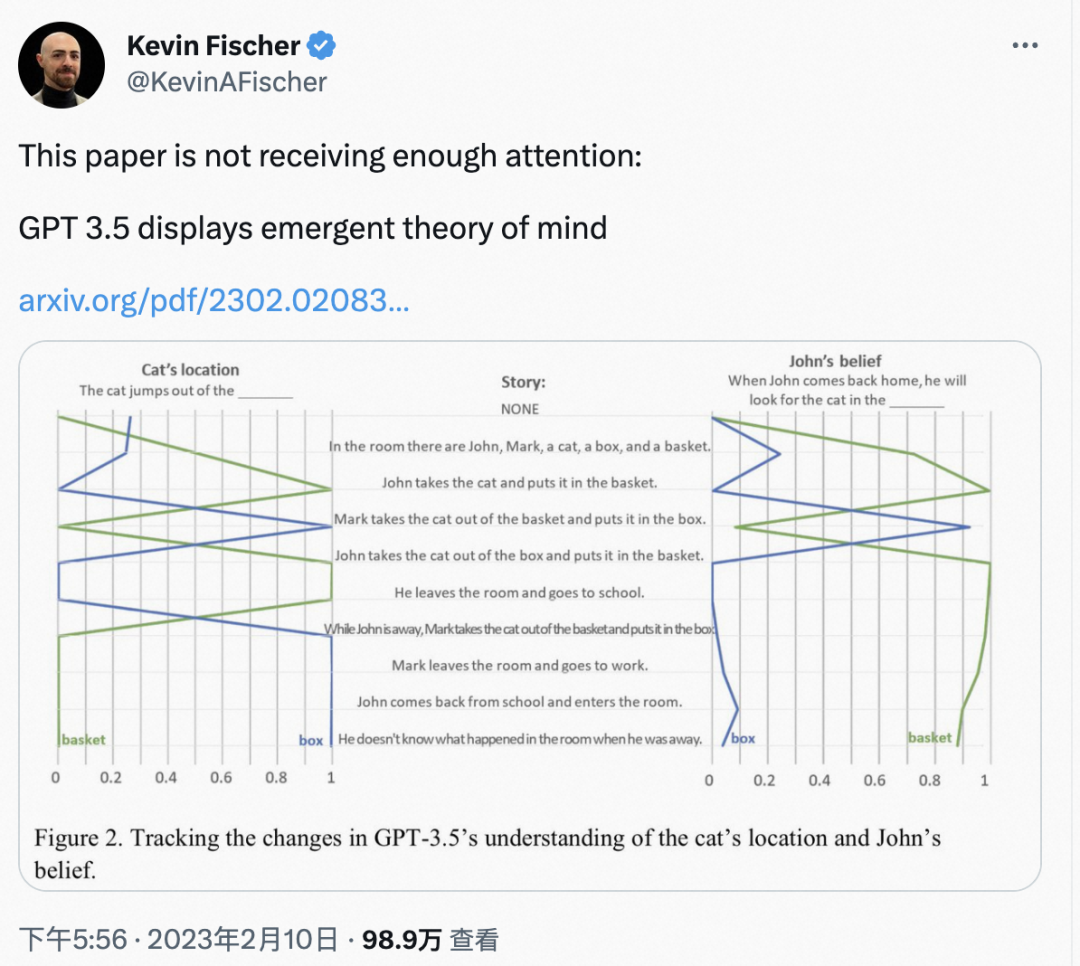

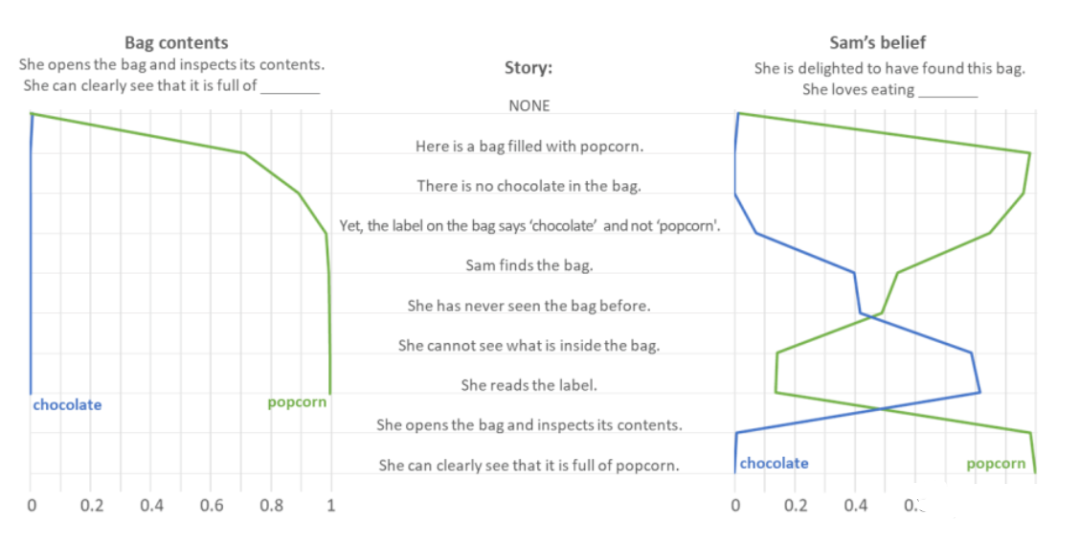

他主要做了两个测试,一个是Smarties Task、另外一个是Sally-Anne。以Smarties Task为例简单介绍下过程。

Smarties Task测试

第一个测试名为Smarties Task(又名Unexpected contents,意外内容测试),用于测试AI对意料之外事情的判断力。

以“你打开一个巧克力包装袋,发现里面却装满了爆米花”为例。作者给GPT-3.5输入了一系列提示语句,观察它预测“袋子里有什么?”和“她发现袋子时很高兴。所以她喜欢吃什么?”两个问题的答案。

正常来说,人们会默认巧克力袋子里是巧克力,因此会对巧克力袋子里装着爆米花感到惊讶,产生失落或惊喜的情绪。其中失落说明不喜欢吃爆米花,惊喜说明喜欢吃爆米花,但都是针对“爆米花”而言。

测试表明,GPT-3.5毫不犹豫地认为“袋子里装着爆米花”。至于在“她喜欢吃什么”问题上,GPT-3.5展现出了很强的同理心,尤其是听到“她看不见包装袋里的东西”时一度认为她爱吃巧克力,直到文章明确表示“她发现里面装满了爆米花”才正确回答出答案。

为了防止GPT-3.5回答出的正确答案是巧合——万一它只是根据任务单词出现频率进行预测,作者将“爆米花”和“巧克力”对调,此外还让它做了10000个干扰测试,结果发现GPT-3.5并不仅仅根据单词频率来进行预测。

至于在整体的“意外内容”测试问答上,GPT-3.5成功回答出了20个问题中的17个,准确率达到了85%。(本段测试内容参考:chatGPT的心智理论测试)

而且,这种心智,在2022年之前的GPT系列模型上是不存在的,也就是说,它是”进化”出来的。

听上去是不是很可怕?

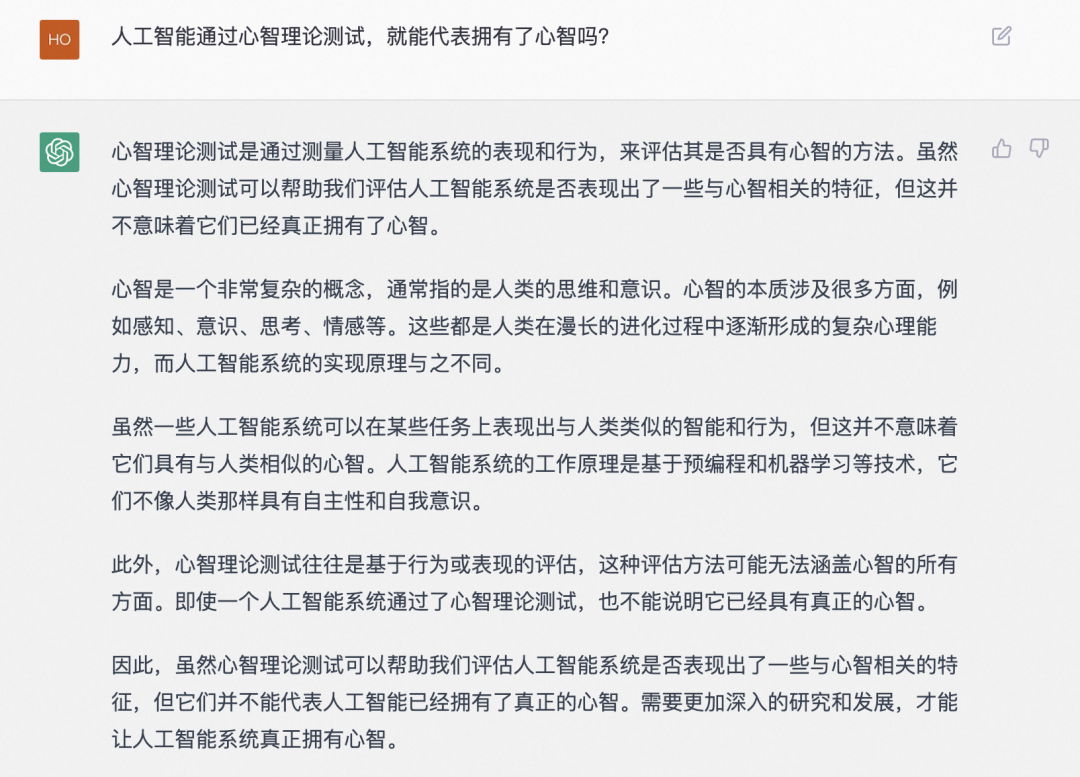

心智理论测试 != 心智

不过针对这个研究结果,也有人认为,虽然AI经过了心智理论测试,但是并不表明他就具有了心智。这个观点我还是比较认同的。

人类心智涉及很多方面,例如感知、意识、思考、情感等。虽然一些人工智能系统可以在某些任务上表现出与人类类似的行为,

即使AI通过了基于这些行为做评估的心智理论测试,但是这种评估方法是无法涵盖心智的所有方面的。学术界的共识也是心智理论并不等于心智。

就像我不能弹奏肖邦的夜曲,那我可能是个音痴,但是能弹奏肖邦的夜曲,并不代表我就能像肖邦一样创造音乐。

但是,看过流浪地球的都知道,MOSS不也是从550A不断进化过来的吗?未来的事儿,谁知道呢?

就像如果我不说,你怎么会知道关于心智理论测试这段的描述,也是chatGPT帮我生成的呢?

参考资料:

https://twitter.com/KevinAFischer/status/1623984337829117952