「ChatGPT克星」,升级了!

没错,就是之前华人小哥Edward Tian所打造出来的那个GPTZero,几秒内就能摸清文字是人类还是AI写的。

而时隔近一个月,小哥所推出的版本名叫GPTZeroX,并且他还说:

这是专门为教育工作者打造的AI模型。

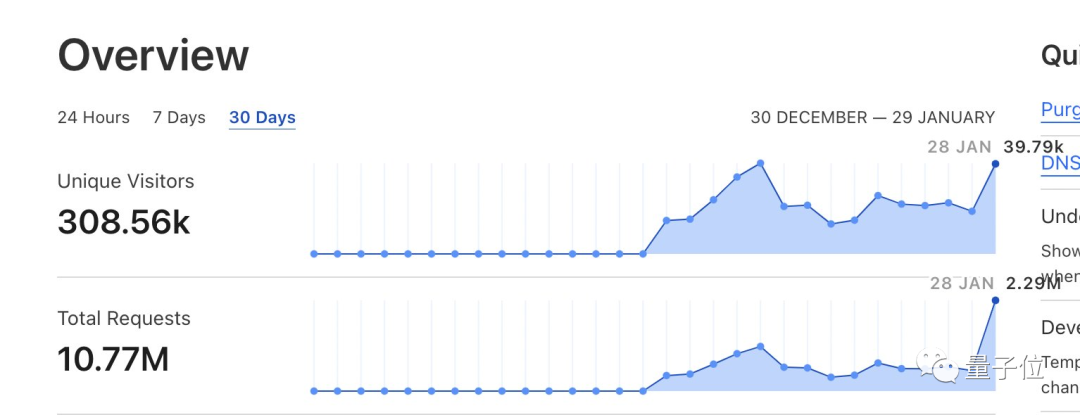

消息一出,立即吸引了大批网友涌入,一天之内便有40万的访问量和220万的服务请求。

那么这一次,这位「ChatGPT克星」又带来了哪些新能力?

混写也能测,还支持Word等格式

升级的一大特点,就是GPTZeroX可以检测出来“人类+AI”混写的文字内容。

例如我们先把一段人类写的新闻丢进去检测:

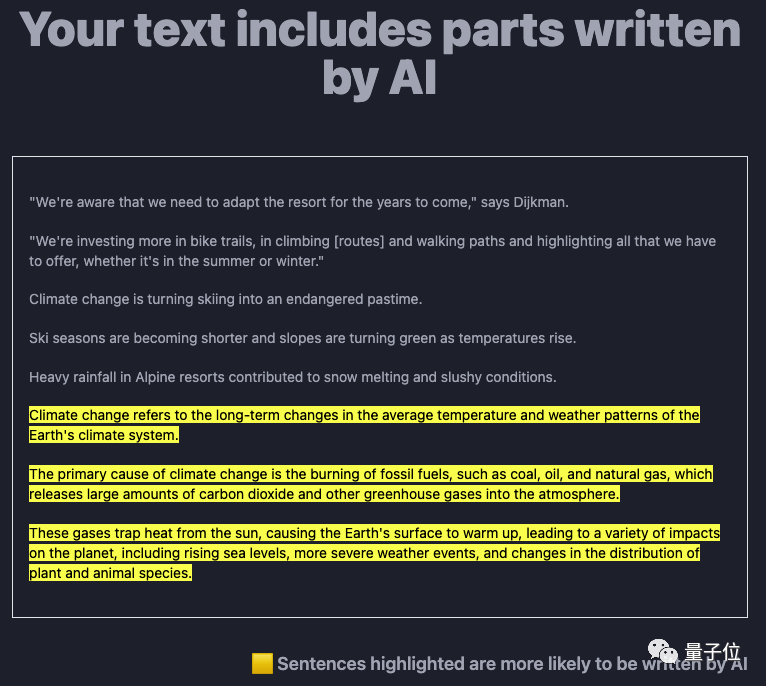

GPTZeroX在短短几秒钟时间内,非常迅速的给出了答案:

Your text is likely to be written entirely by a human.

你的文本很可能完全是由人写的。

接下来,我们再把一段ChatGPT写的文字,丢进刚才那段新闻的后边,来一场混合检测:

这一次,GPTZero给出的回答是:

Your text includes parts written by AI.

你的文本一部分是由AI编写的。

并且ChatGPT生成的内容还会用黄色高亮标记出来。

小哥对此表示:

这是教育工作者一直想要的一个关键功能。

但老师们检查学生作业的时候,一段一段的把文字复制粘贴进来也相当繁琐的工作了。

于是乎,这位小哥还贴心地推出了另一个新功能——可批量导入文件,支持Word、PDF和TXT等格式。

并且网站在介绍这个功能时,是这么描述的

:

除此之外,为了防止服务发生崩溃,小哥还搞了一个Python API,是已经完成压力测试的那种。

最后,小哥还贴心地说了一句:

我承诺,本网站对个体教师和教育工作者,保持免费!

怎么做到的?

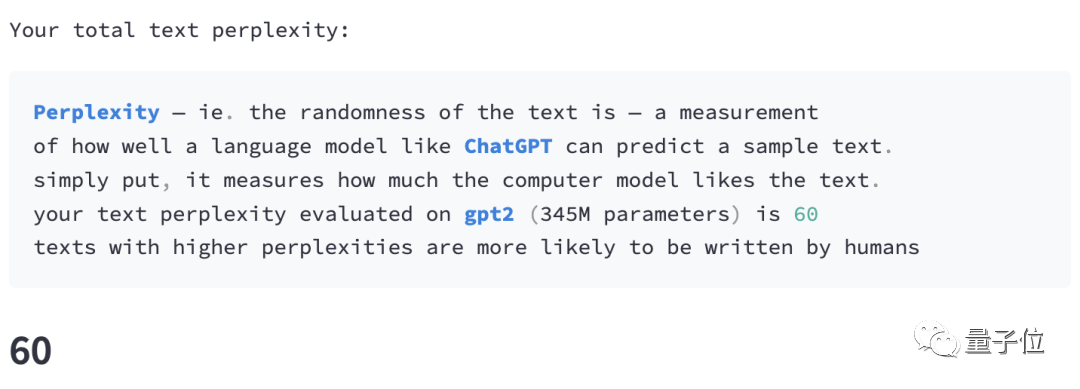

它主要靠“perplexity”,即文本的“困惑度”作为指标来判断所给内容到底是谁写的。

NLP领域的朋友们都知道,这个指标就是用来评价一个语言模型的好坏的。

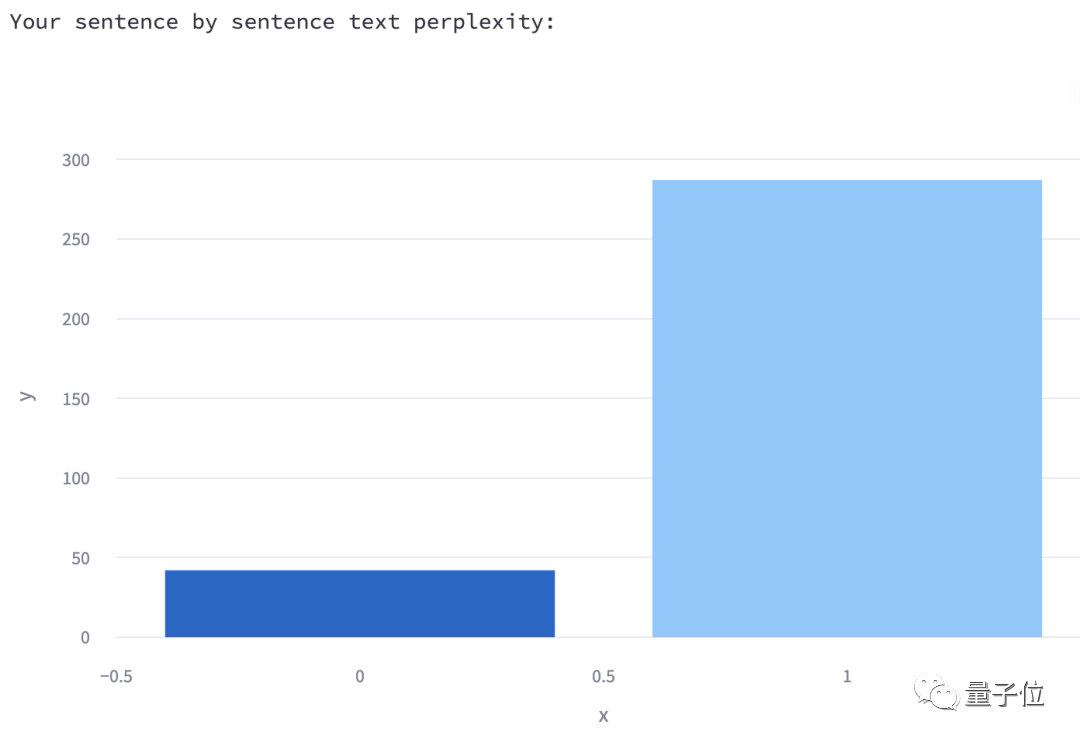

在这里,每当你喂给GPTZero一段测试内容,它就会分别计算出:

1、文字总困惑度

这个值越高,就越可能出自人类之手。

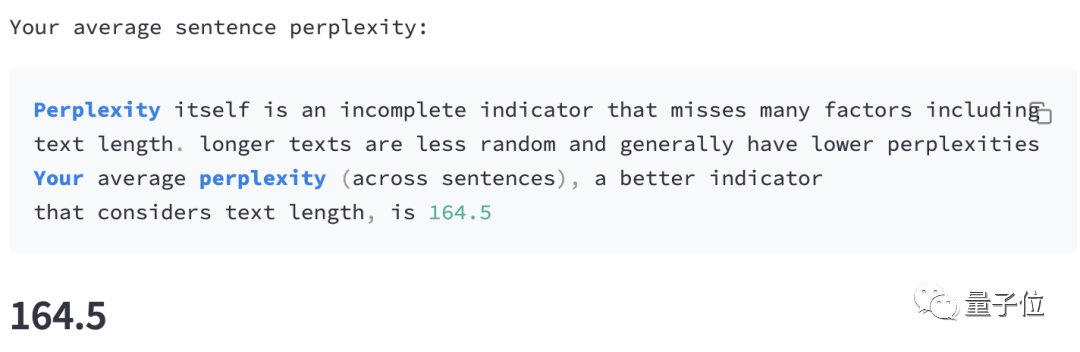

2、所有句子的平均困惑度

句子越长,这个值通常就越低。

3、每个句子的困惑度

通过条形图的方式呈现,鼠标悬浮到各个方块就可以查看相应的句子是什么(这里就两块,因为我此时输入的测试内容就俩句子)。

之所以要绘制这样的条形图,作者也作出了解释:

根据最新的一些研究:人类书写的一些句子可能具有较低的困惑度(前面说过,人类的困惑度是比较高的),但随着继续写,困惑度势必会出现峰值。

相反,用机器生成的文本,其困惑度是均匀分布的,并且总是很低。

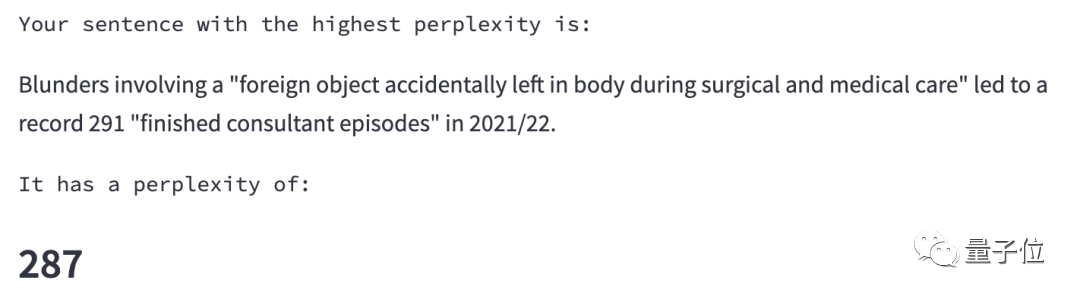

除此之外,GPTZero还会挑出困惑度最高的那个句子(也就是最像人写的):

反ChatGPT之风正盛

正所谓道高一尺魔高一丈,在ChatGPT尽显十八般武艺之际,诸如小哥GPTZero一样“用魔法打败魔法”的工具、研究也在层出不穷。

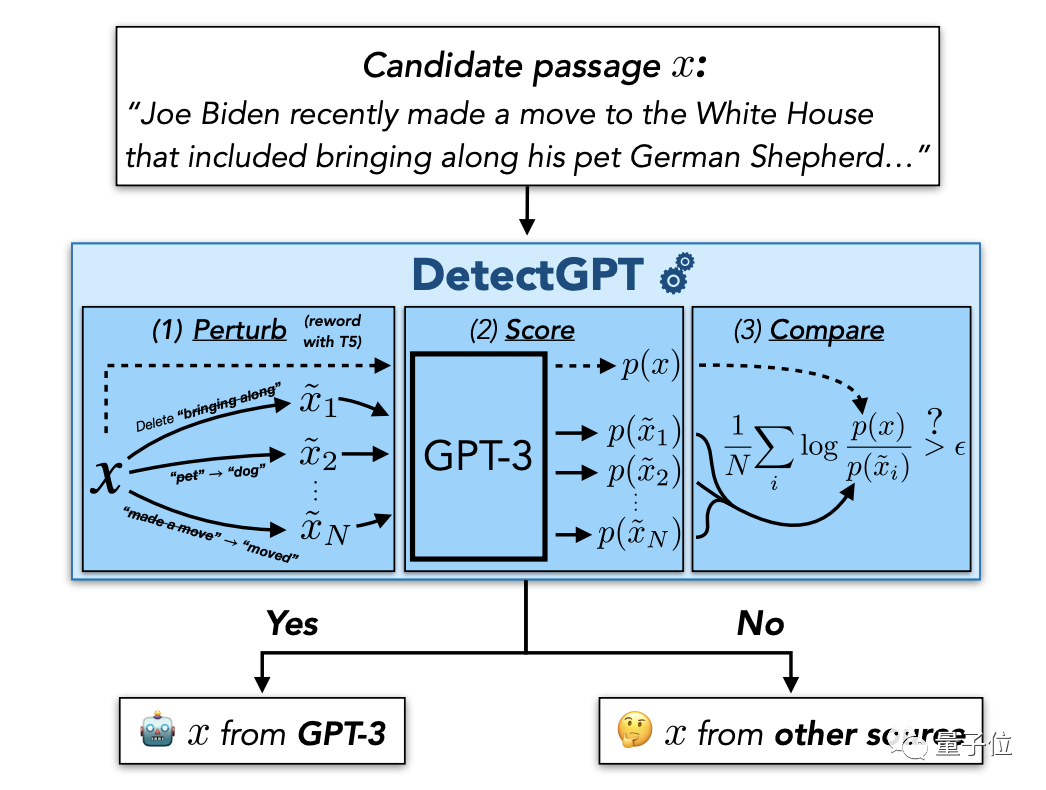

例如最近斯坦福大学为了不让学生借助ChatGPT之力来写论文或作弊,推出了“反侦察”神器——DetectGPT。

这种方法既不需要训练单独的分类器,也不需要收集真实或生成的段落的数据集,是一种基于概率曲率的零样本方法。

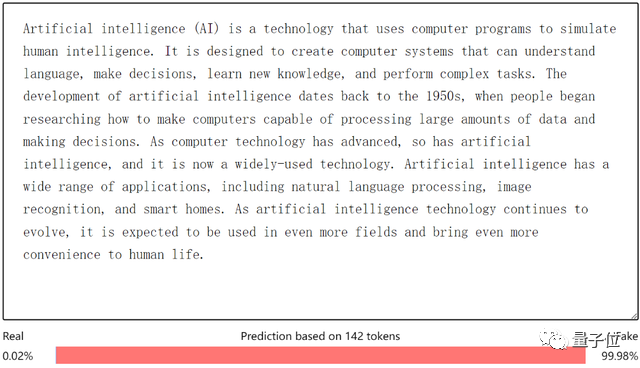

除此之外,就连OpenAI自己也联合哈佛等高校机构联合打造了一款检测器:GPT-2 Output Detector。

作者们先是发布了一个“GPT-2生成内容”和WebText(专门从国外贴吧Reddit上扒下来的)数据集,让AI理解“AI语言”和“人话”之间的差异。

随后,用这个数据集对RoBERTa模型进行微调,就得到了这个AI检测器。其中人话一律被识别为True,AI生成的内容则一律被识别为Fake。

(RoBERTa是BERT的改进版。原始的BERT使用了13GB大小的数据集,但RoBERTa使用了包含6300万条英文新闻的160GB数据集。)

……

嗯,看来ChatGPT在大步向前迈的同时,顺便还推动了“反ChatGPT”研究的发展。

参考链接:[1] https://twitter.com/edward_the6/status/1619874139954905090[2] https://arxiv.org/abs/2301.11305