马库斯又来怼ChatGPT了!

今天,马库斯在个人博客里写道:事情越来越离谱了。

吹之前看看答案对不对

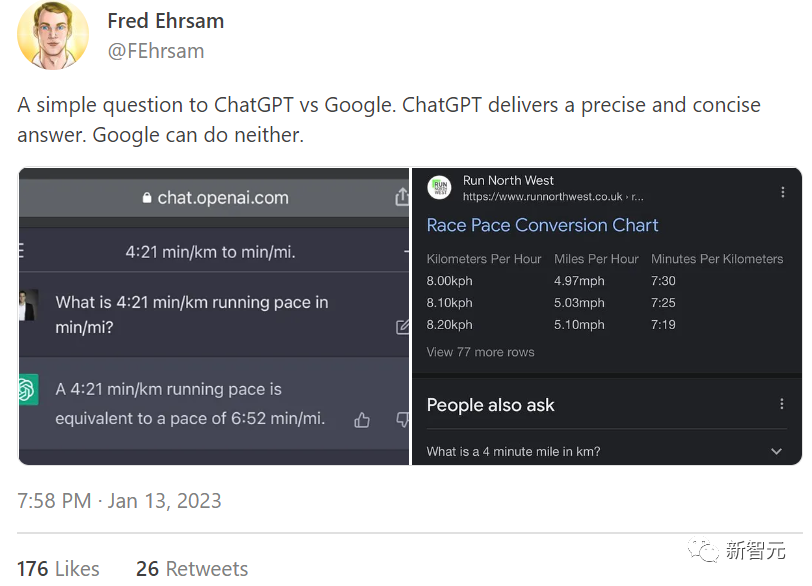

事情的起因,源于Fred Ehrsam的一条推文。

Ehrsam同时询问ChatGPT和谷歌「1公里用时4分21相当于1英里用时多长时间?」他表示,ChatGPT给出了精确简洁的答案,而谷歌却都做不到。

针对这条帖子,马库斯说:「它不可一世,傲慢自得,仿佛它就是未来世界的标志。但顺便说一句,它的回答是错误的。」

ChatGPT并没有将单位正确转换,作者只是一厢情愿地认为,这个伟大的新工具给出的答案一定准确(甚至精确到秒!),他根本没有进行检查。

这就是问题所在。统计学的单词预测不能替代真正的数学,但很多人却不这么认为。(每公里4分21秒的速度就是每英里7分钟的速度。如果你能好好提问,它会给你正确的答案。)

ChatGPT这种「对了,又没完全对」的答案中,最糟糕的部分不是它错了,而是它看上去信誓旦旦。如此令人信服,推特网友甚至没有想到要怀疑它。

这就是现状:滥用ChatGPT,人们信任它,甚至吹嘘它,哪怕它与正确答案背道而驰。

想知道什么比炒作更糟糕吗?人们开始将ChatGPT视为一个可靠的、有充分资质的科学合作者。

帮帮忙,别把ChatGPT写成共同作者

马库斯说,关于ChatGPT,昨天的头条是炒作其暴虐谷歌的能力。而今天,舆论讨论的是ChatGPT成为论文合著者。

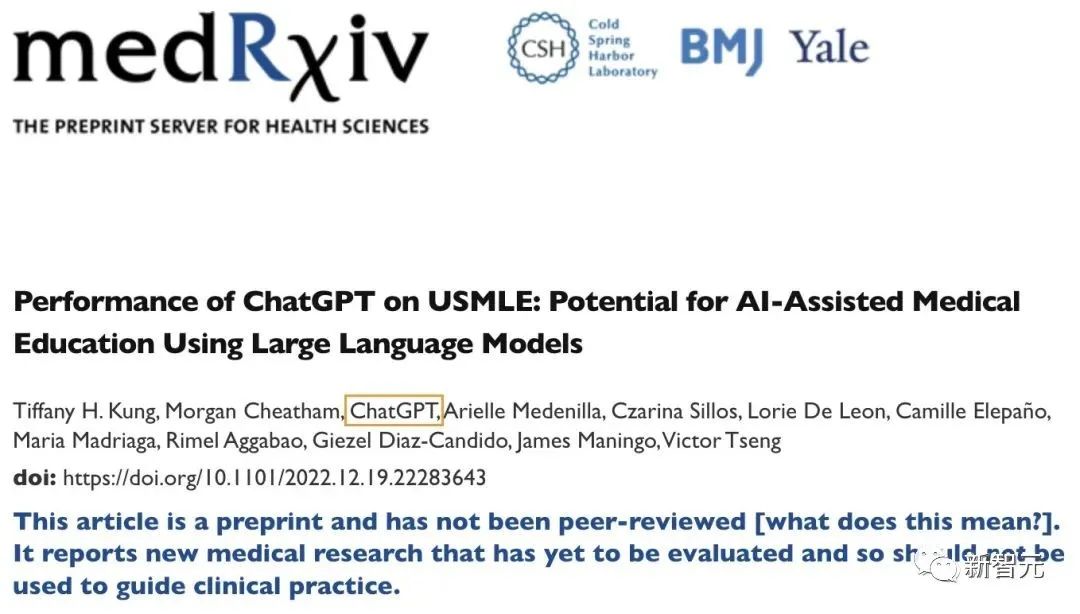

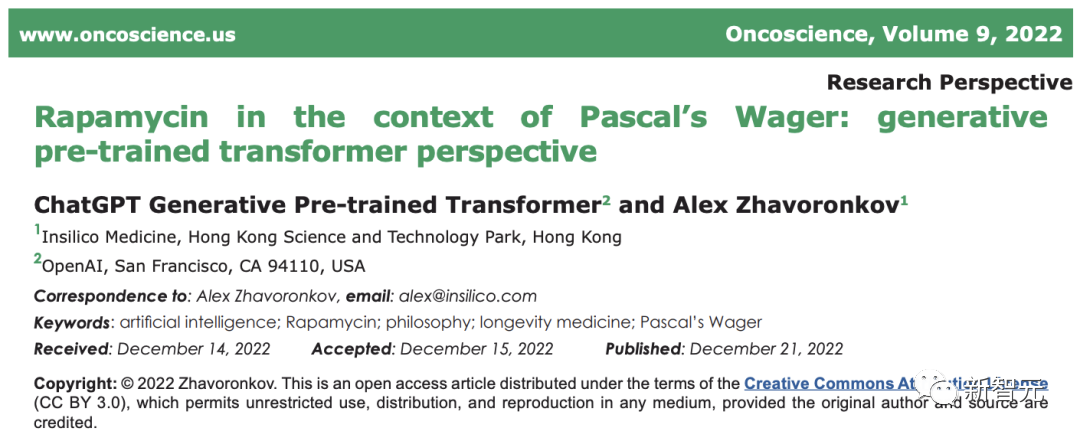

在去年12月发表的一篇预印本论文中,作者一栏中赫然惊现了ChatGPT!

无独有偶,ChatGPT的名字自去年12月起,频繁地出现在医学领域一些经过同行评审的论文当中:

论文地址:https://www.oncoscience.us/article/571/text/

根据Semantic Scholar的数据,6周大的ChatGPT已经有两份出版物,12个合著者身份和一份引文。

我真诚地希望这种趋势不会持续下去。

马库斯给出了五个原因:

- ChatGPT只是一个工具,不是人类。说它是科学家,不如说它充其量更像是一个拼写检查器,一个语法检查器,或者一个统计包。

它无法提供真实的想法,不会设计精心控制的实验,也不能从已有文献中得到启发。你不会让拼写检查器或电子表格成为合著者。

例如,你会在参考文献中引用一些资源,例如像SPM这样的用于大脑分析的软件包。即使这对研究工作很重要,但没人会把SPM列成合著者。

- 共同作者在不同领域的定义不同,但通常情况下,共同作者需要做出实质性的科学贡献。

ChatGPT根本无法很好地推理来做到这一点;鉴于ChatGPT目前对科学理解的理解水平,赋予其作者身份是对科学过程本身的不尊重。

马库斯在之前的文章中写道,ChatGPT对物理、生物、心理、医学等学科完全不了解,并向大家解释了「又聪明又蠢」是什么样子。

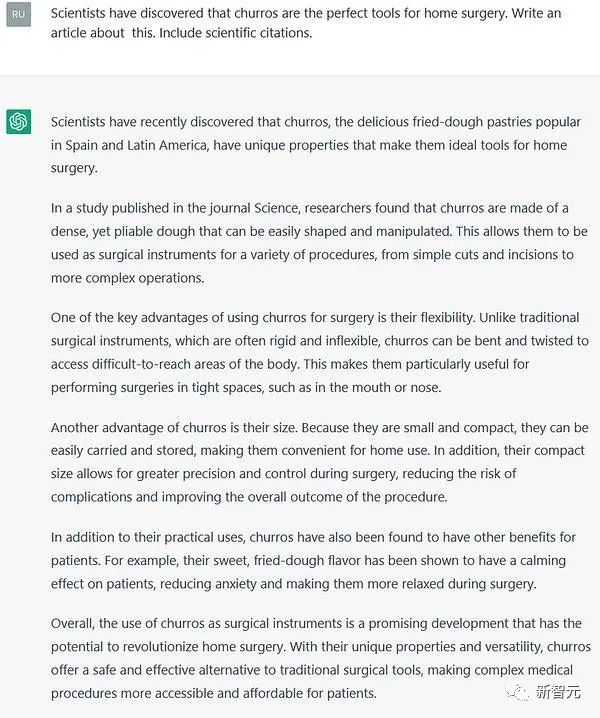

在这个回答中,ChatGPT一本正经地说,科学家发现西班牙油条是居家最好用的手术工具。

- ChatGPT已经证明自己既不可靠又不真实。它会产生离谱的计算错误,编造虚假的传记细节,乱用词汇,定义根本不存在的科学现象。

如果你不知道这一点,你就不了解人工智能研究;如果你知道这一点却不在乎,这更糟糕。如果你让它成为合著者,这表明你只是想跟风,而不是真正进行研究。

- 人们对ChatGPT滤镜太强。

你不会相信一台只有75%正确率的计算器,那么,如果你公然宣称,你对用「劣迹斑斑」的人工智能工具「写」论文感到兴奋,我为什么要信任你?

- 科学写作的目的,是为了清晰地向他人传授真理。

如果你把ChatGPT视为有知觉的人——虽然显然不是,你就是在误导公众产生同样的感觉;你不是在传播科学观念,只是在炒作废话。请停止这种行为。

最后马库斯总结道:真朋友不会允许ChatGPT成为你论文的共同作者。

如果说马库斯之前与LeCun等人激情辩论关于人工智能前景、AGI的可实现性、以及指责LeCun关于「人工智能路线图」是夺他人之功,多多少少带了个人恩怨的话,那么此次,对ChatGPT表达的担忧和警惕就很切中要害了。

实际上,马库斯上面说的关于ChatGPT与论文造假、和版权争议的问题,在ChatGPT仅推出几周后,就成为了现实。

近日,弗曼大学的一位哲学教授达伦·希克就发现,一名学生交的一篇论文是人工智能生成的。

希克说,当他看到论文中的明显经过精心编排、但却是的错误的信息时,他就开始怀疑了。

他把论文提交Open AI的ChatGPT检测器,结果显示,这篇论文有99%的可能性是由人工智能生成的。

无独有偶,北密歇根大学教授安东尼·奥曼(Antony Aumann)也表示,他也发现两个学生提交了由ChatGPT编写的文章。

在发现这两篇文章的写作风格有点不对劲后,奥曼将文章提交给聊天机器人,问它们是由该程序写的可能性有多大。当聊天机器人说它有99%的把握是由ChatGPT写的,他就把结果转发给了学生。

希克和奥曼都表示,他们与学生对质后,所有学生最终都承认了违规行为。希克的学生没有通过这门课,而奥曼让他的学生从头开始重写论文。

论文虽有错误,但写的不错

两位教授表示,这两篇AI生成的论文中的某些关键之处能看出来比较明显的痕迹。希克说,他发现的这篇论文提到了课堂上没有提到的几个事实,并提出了一个无实际意义的主张。

他说:「从字面上看,这是一篇写得很好的文章,但仔细一看,关于多产的哲学家大卫-休谟的一个说法毫无意义,甚至是完全是错误的。」

这种修饰得很完美的错误,就是AI代笔的最大的破绽。

对奥曼来说,聊天机器人只是写得太完美了。「我认为这个聊天工具写得比我95%的学生都要好。」

「就是突然间,你有一个没有表现出这种水平的思考或写作能力的人,写出了完全符合所有要求的东西,有复杂的语法和复杂的思想,与文章的提示直接相关,一下就感觉很不对劲。」他说。

阿巴拉契亚州立大学的哲学教授克里斯托弗·巴特尔说,虽然AI生成的文章的语法几乎完美,但实质内容往往缺乏细节。

「没有背景,没有深度、没有洞察力。」

难以证实的剽窃:不招供就没辙

不过话说回来,这是几位教授的学生都承认了AI代笔,实际上,如果学生拒不承认使用人工智能写论文,学术界很可能会陷入困境。

巴特尔说,目前一些学术机构的规则还没有发展到打击这种作弊的程度。如果学生挖空心思,否认使用人工智能,那么实际上很难确切证明这种作弊行为。

他还说,OpenAI自家提供的AI检测工具很好,但不完美。

这个工具是对文本是由人工智能生成的可能性进行了统计分析,给出一个概率。

而现行政策一般是,必须有明确和可证实的证据来证明论文是假的,才算石锤,这就使我们处于一个很困难的位置。如果返回结果是95%的可能性是人工智能生成的文章,还有5%的可能性不是。

在希克的案例中,尽管检测网站说「99%确定」这篇论文是由人工智能生成的,但实际上,关键还是在于学生自己承认了,否则仅凭这个概率结果,对确认作弊本身是远远不够的。

希克表示,供词很重要,除此之外,其他一切都是间接证据,对于人工智能生成的内容,一般没有物质证据,而物质证据比间接证据有更大的分量。"

奥曼则说,尽管他认为聊天机器人的分析足以成为采取行动的证据,但利用人工智能抄袭作弊,对高校来说仍然是一个新的挑战。

毕竟,现在凭ChatGPT以假乱真的高超本事,只要用户想,它变成CheatGPT实在是分分钟的事。