过去几年,在自动驾驶和 VR 等应用的推动下,使用 2D 和 3D 传感器(如 RGB 传感器、LiDARs 或雷达)进行人体姿态估计取得了很大进展。但是,这些传感器在技术上和实际使用中都存在一些限制。首先成本高,普通家庭或小企业往往承担不起 LiDAR 和雷达传感器的费用。其次,这些传感器对于日常和家用而言太过耗电。

至于 RGB 相机,狭窄的视野和恶劣的照明条件会对基于相机的方法造成严重影响。遮挡成为阻碍基于相机的模型在图像中生成合理姿态预测的另一个障碍。室内场景尤其难搞,家具通常会挡住人。更重要的是,隐私问题阻碍了在非公共场所使用这些技术,很多人不愿意在家中安装摄像头记录自己的行为。但在医疗领域,出于安全、健康等原因,很多老年人有时不得不在摄像头和其他传感器的帮助下进行实时监控。

近日,CMU 的三位研究者在论文《DensePose From WiFi》中提出,在某些情况下,WiFi 信号可以作为 RGB 图像的替代来进行人体感知。照明和遮挡对用于室内监控的 WiFi 解决方案影响不大。WiFi 信号有助于保护个人隐私,所需的相关设备也能以合理的价格买到。关键的一点是,很多家庭都安装了 WiFi,因此这项技术有可能扩展到监控老年人的健康状况或者识别家中的可疑行为。

论文地址:https://arxiv.org/pdf/2301.00250.pdf

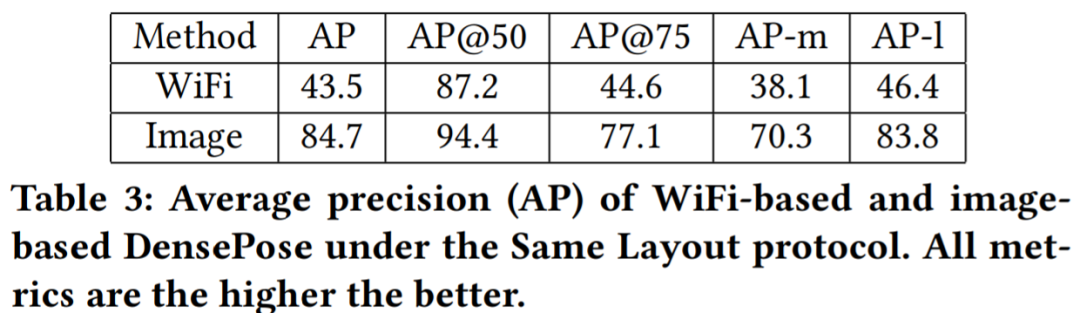

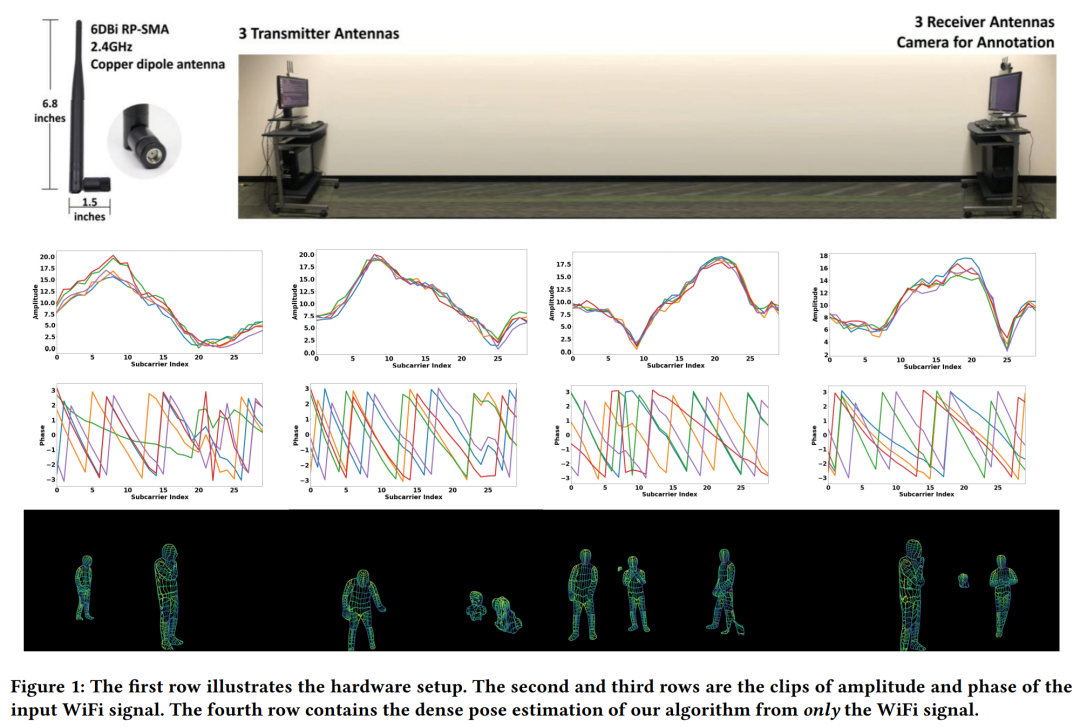

研究者想要解决的问题如下图 1 第一行所示。给定 3 个 WiFi 发射器和 3 个对应的接收器,能否在多人的杂乱环境中检测和复原密集人体姿态对应关系(图 1 第四行)?需要注意的是,很多 WiFi 路由器(如 TP-Link AC1750)都有 3 根天线,因此本文方法中只需要 2 个这样的路由器。每个路由器的价格大约是 30 美元,意味着整个设置依然比 LiDAR 和雷达系统便宜得多。

为了实现如图 1 第四行的效果,研究者从计算机视觉的深度学习架构中获得灵感,提出了一种可以基于 WiFi 执行密集姿态估计的神经网络架构,并实现了在有遮挡和多人的场景中仅利用 WiFi 信号来估计密集姿态。

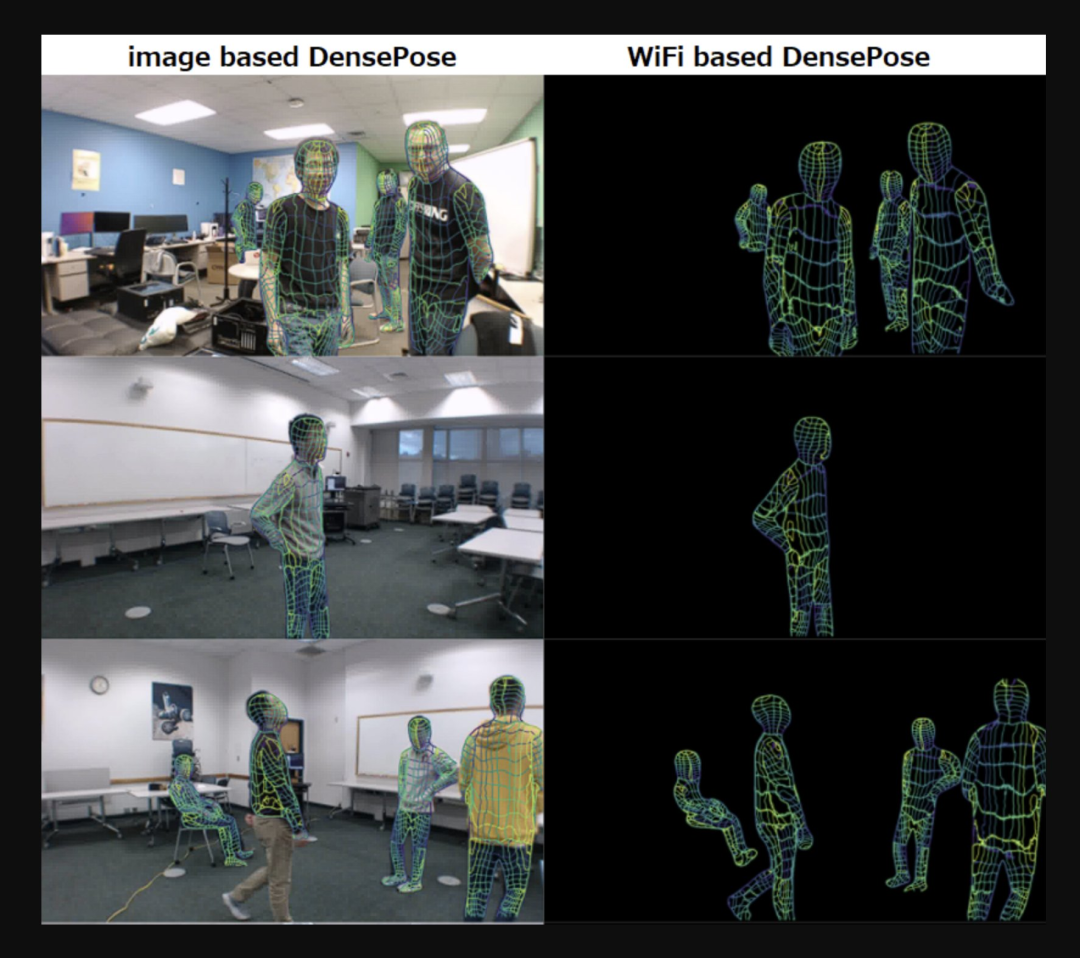

下图左为基于图像的 DensePose,图右为基于 WiFi 的 DensePose。

图源:推特 @AiBreakfast

另外,值得一提的是,论文一二作均为华人。论文一作 Jiaqi Geng 在去年 8 月取得了 CMU 机器人专业硕士学位,二作 Dong Huang 现为 CMU 高级项目科学家。

方法介绍

想要利用 WiFi 生成人体表面的 UV 坐标需要三个组件:首先通过振幅和相位步骤对原始 CSI( Channel-state-information,表示发射信号波与接收信号波之间的比值 )信号进行清理处理;然后,将处理过的 CSI 样本通过双分支编码器 - 解码器网络转换为 2D 特征图;接着将 2D 特征图馈送到一个叫做 DensePose-RCNN 架构中(主要是把 2D 图像转换为 3D 人体模型),以估计 UV 图。

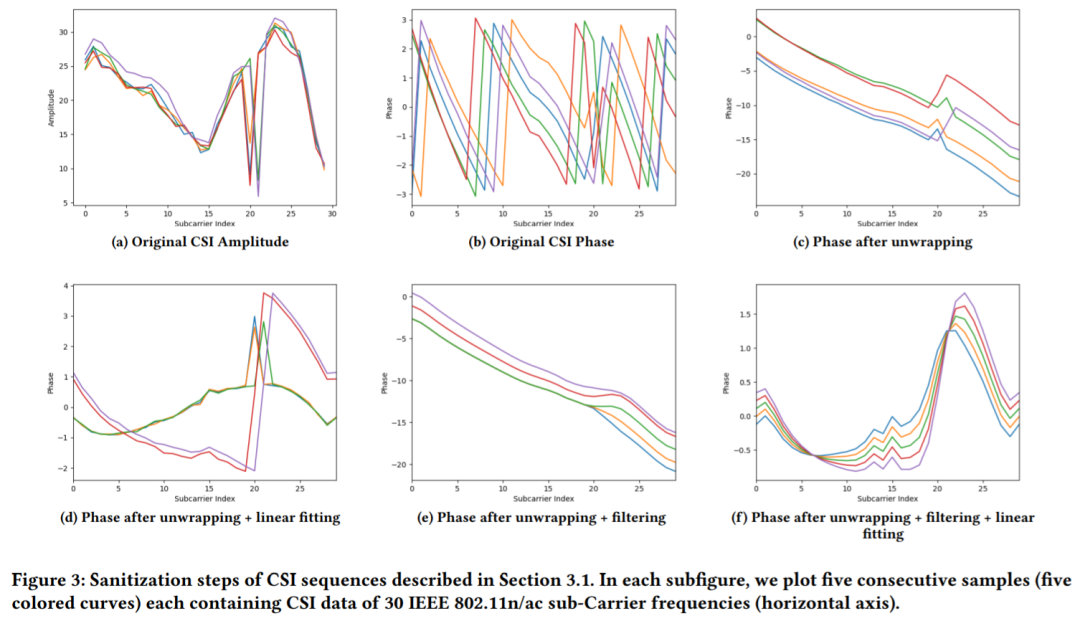

原始 CSI 样本带有噪声(见图 3 (b)),不仅如此,大多数基于 WiFi 的解决方案都忽略了 CSI 信号相位,而专注于信号的幅度(见图 3 (a))。然而丢弃相位信息会对模型性能产生负面影响。因此,该研究执行清理(sanitization)处理以获得稳定的相位值,从而更好的利用 CSI 信息。

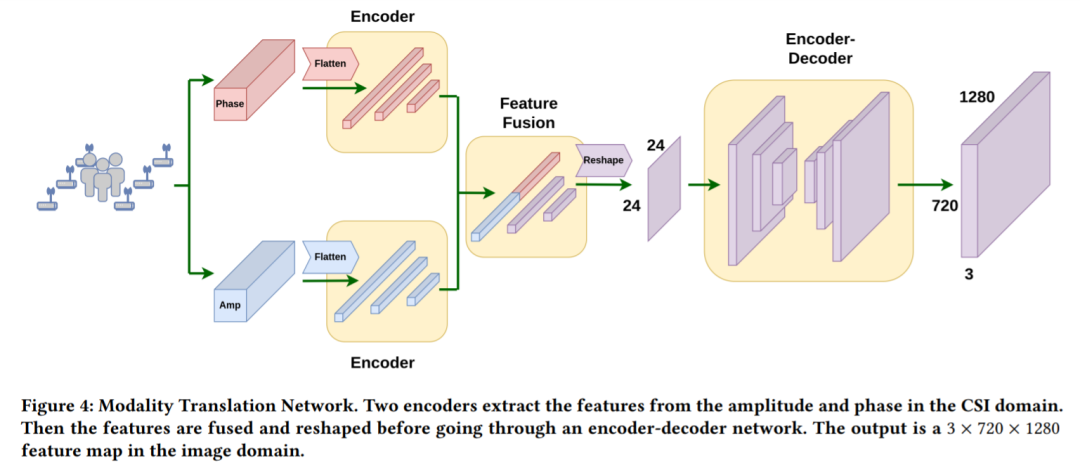

为了从一维 CSI 信号中估计出空间域中的 UV 映射,首先需要将网络输入从 CSI 域转换到空间域。本文采用 Modality Translation Network 完成(如图 4)。经过一番操作,就可以得到由 WiFi 信号生成的图像域中的 3×720×1280 场景表示。

在图像域中获得 3×720×1280 场景表示后,该研究采用类似于 DensePose-RCNN 的网络架构 WiFi-DensePose RCNN 来预测人体 UV 图。具体而言,在 WiFi-DensePose RCNN(图 5)中,该研究使用 ResNet-FPN 作为主干,并从获得的 3 × 720 × 1280 图像特征图中提取空间特征。然后将输出输送到区域提议网络。为了更好地利用不同来源的互补信息,WiFi-DensePose RCNN 还包含两个分支,DensePose head 和 Keypoint head,之后处理结果被合并输入到 refinement 单元。

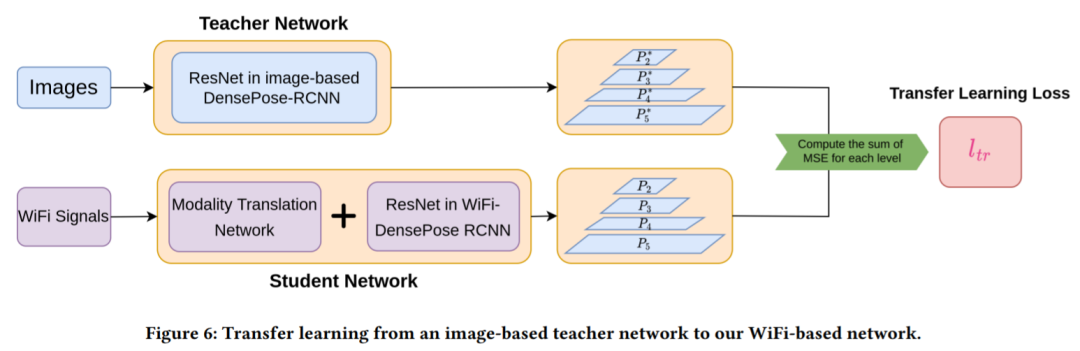

然而从随机初始化训练 Modality Translation Network 和 WiFi-DensePose RCNN 网络需要大量时间(大约 80 小时)。为了提高训练效率,该研究将一个基于图像的 DensPose 网络迁移到基于 WiFi 的网络中(详见图 6)。

直接初始化基于 WiFi 的网络与基于图像的网络权重无法工作,因此,该研究首先训练了一个基于图像的 DensePose-RCNN 模型作为教师网络,学生网络由 modality translation 网络和 WiFi-DensePose RCNN 组成。这样做的目的是最小化学生模型与教师模型生成的多层特征图之间的差异。

实验

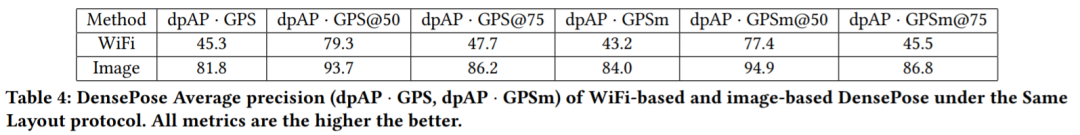

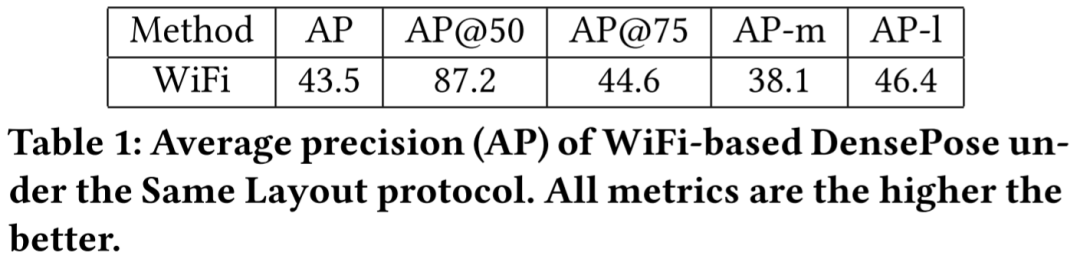

表 1 结果显示,基于 WiFi 的方法得到了很高的 AP@50 值,为 87.2,这表明该模型可以有效地检测出人体 bounding boxes 的大致位置。AP@75 相对较低,值为 35.6,这表明人体细节没有得到完美估计。

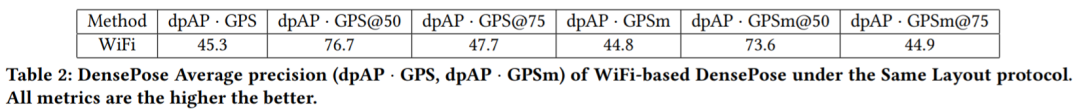

表 2 结果显示 dpAP・GPS@50 和 dpAP・GPSm@50 值较高,但 dpAP・GPS@75 和 dpAP・GPSm@75 值较低。这表明本文模型在估计人体躯干的姿势方面表现良好,但在检测四肢等细节方面仍然存在困难。

表 3 和表 4 的定量结果显示,基于图像的方法比基于 WiFi 的方法产生了非常高的 AP。基于 WiFi 的模型 AP-m 值与 AP-l 值的差异相对较小。该研究认为这是因为离相机远的人在图像中占据的空间更少,这导致关于这些对象的信息更少。相反,WiFi 信号包含了整个场景中的所有信息,而不管拍摄对象的位置。