作为当前全球最负盛名的 AI 学术会议之一,NeurIPS 是每年学界的重要事件,全称是 Neural Information Processing Systems,神经信息处理系统大会,通常在每年 12 月由 NeurIPS 基金会主办。

大会讨论的内容包含深度学习、计算机视觉、大规模机器学习、学习理论、优化、稀疏理论等众多细分领域。

今年 NeurIPS 已是第 36 届,于 11 月 28 日至 12 月 9 日举行,为期两周。

第一周将在美国新奥尔良 Ernest N. Morial 会议中心举行现场会议,第二周改为线上会议。

来自IBM研究中心等学者讲述关于大模型的鲁棒性,非常值得关注!

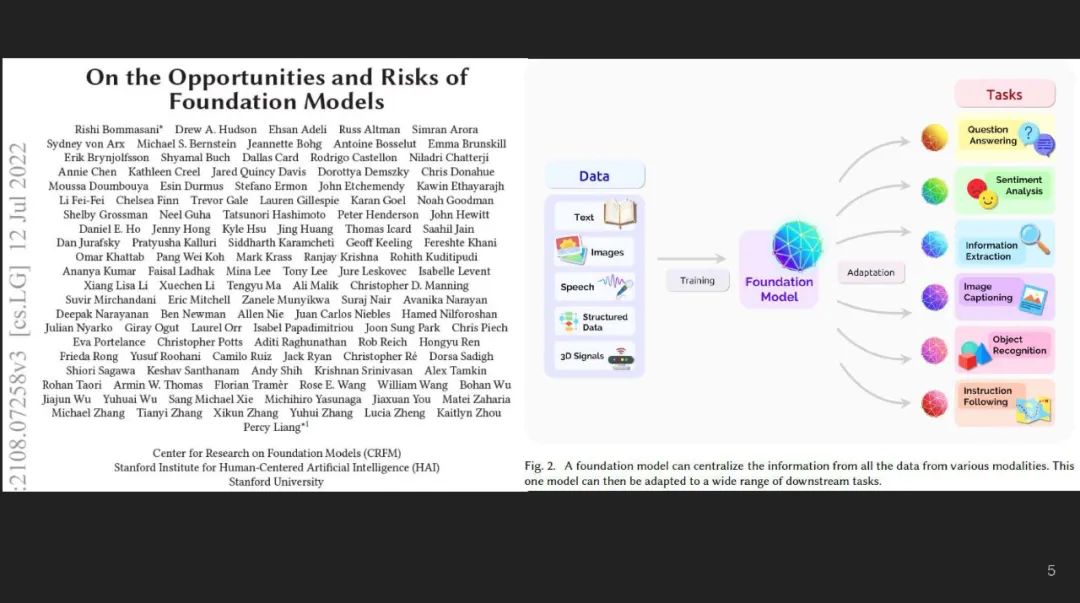

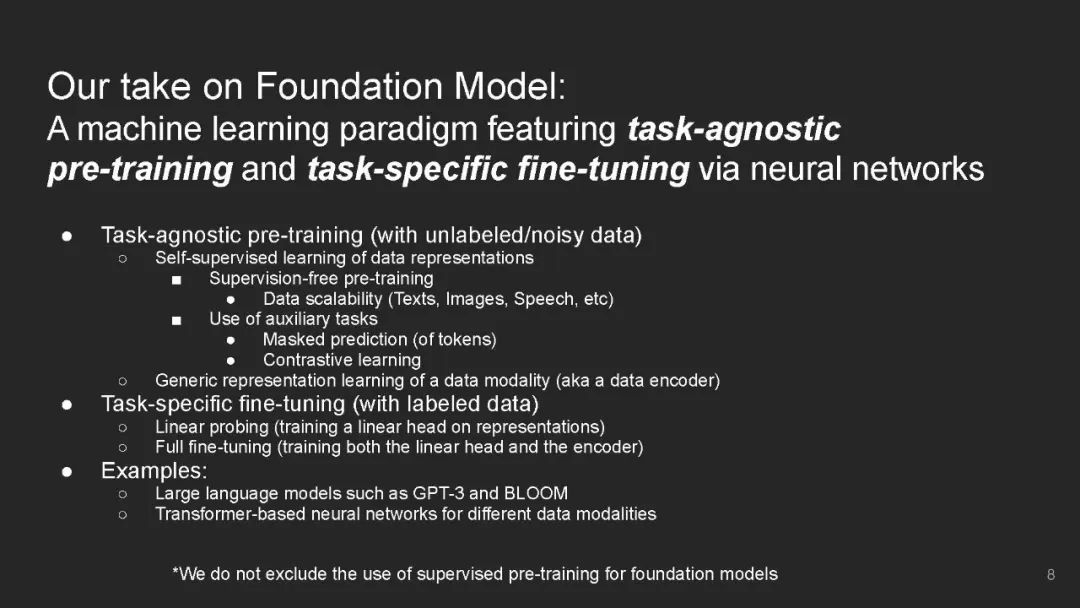

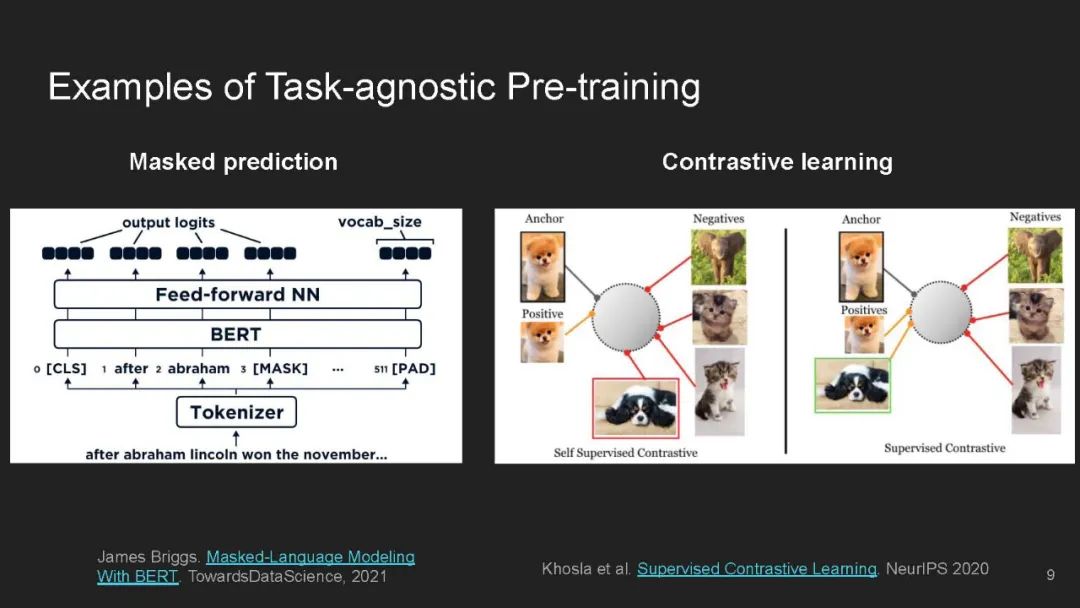

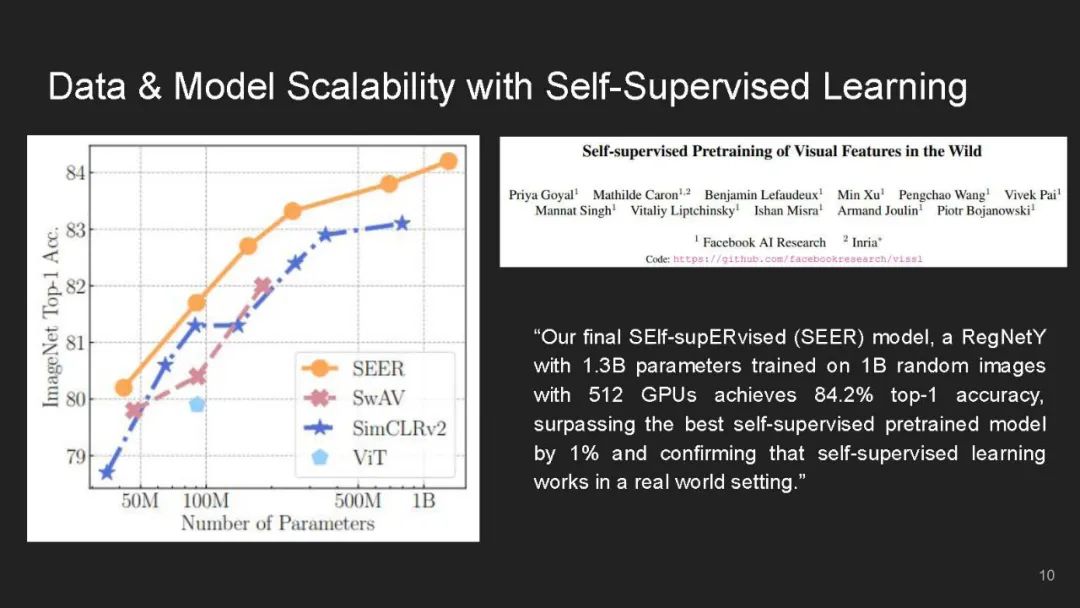

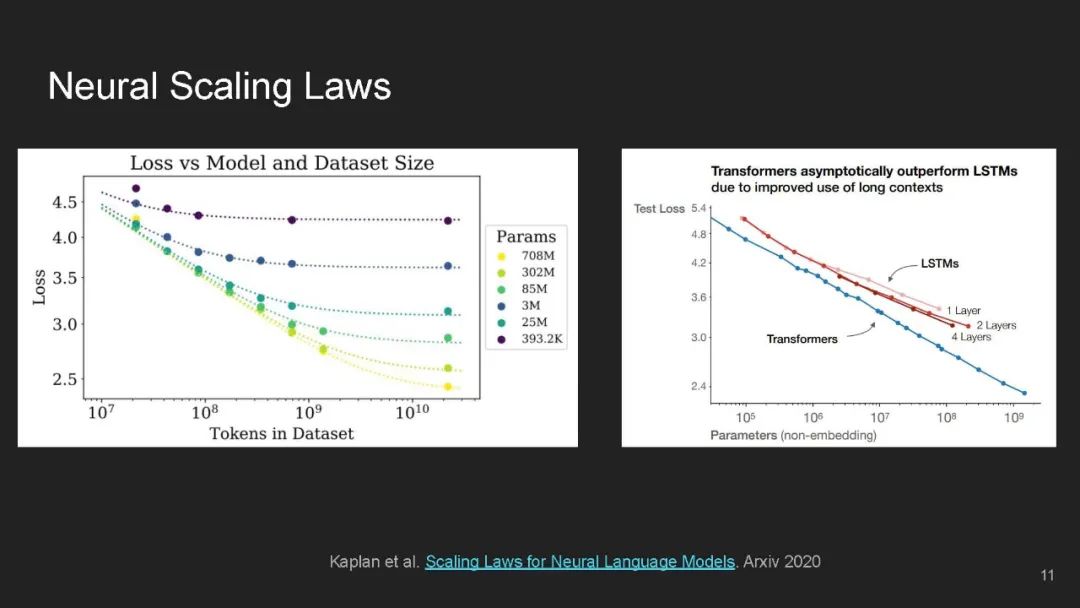

基础模型采用深度学习的方法,在大规模无标签数据上进行预训练,并通过特定任务的监督进行微调,正成为机器学习的主流技术。

虽然基础模型在学习一般表示和跨领域和数据模式的少次/零次泛化方面有很多希望,但同时由于使用了过多的数据量和复杂的神经网络架构,它们在鲁棒性和隐私性方面提出了前所未有的挑战和相当大的风险。

本教程旨在提供一个类似coursera的在线教程,包含全面的讲座,一个实践和交互式的Jupyter/Colab实时编码演示,以及一个关于基础模型中可信性的不同方面的小组讨论。

https://sites.google.com/view/neurips2022-frfm-turotial

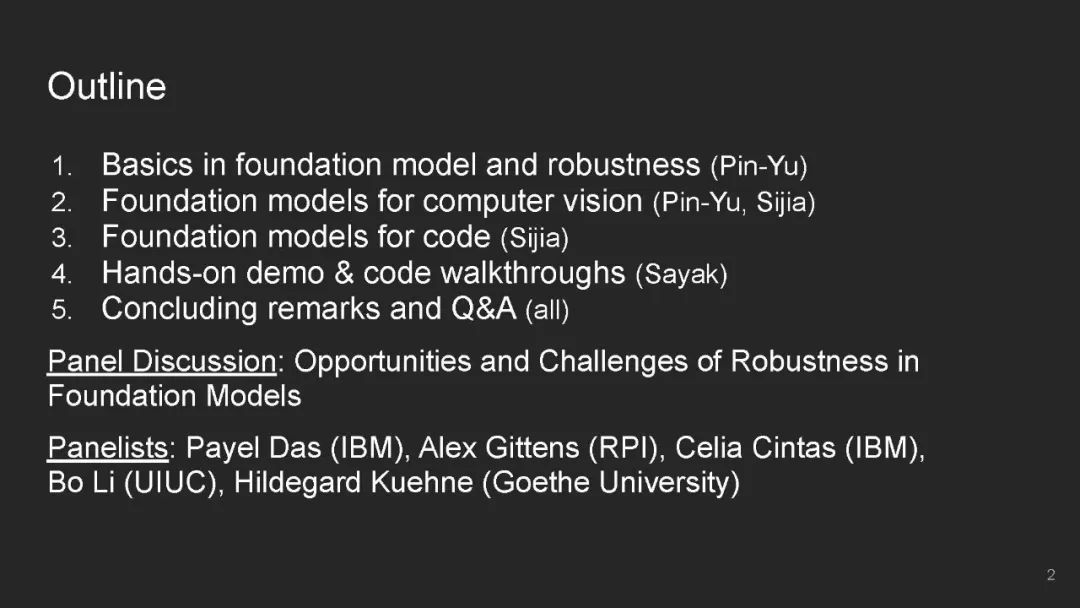

目录内容:

- Basics in foundation models and robustness

- Deep dive on foundation models for computer vision

- Deep dive on foundation models for code

- Hands-on code walkthrough

- Concluding Remarks

- Q&A

- Panel discussion

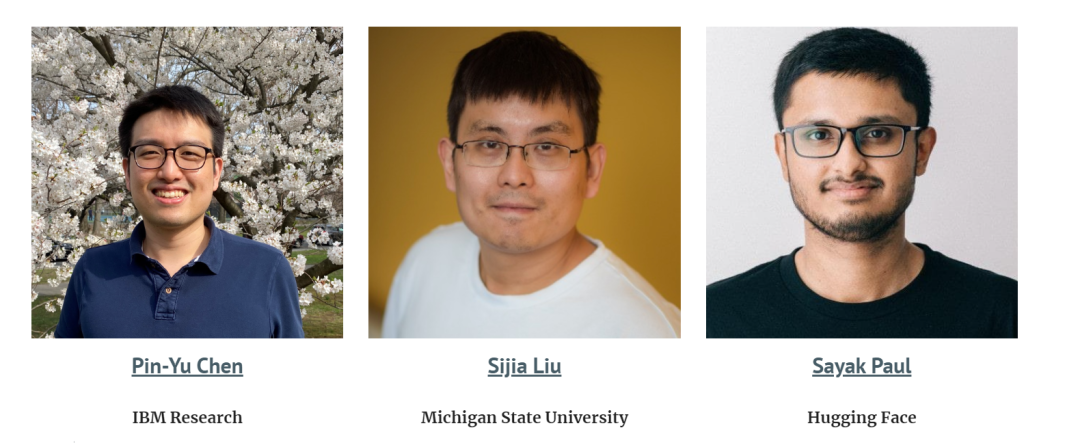

讲者:

现实世界的机器学习系统需要对分布变化鲁棒——它们应当在与训练分布不同的测试分布上工作良好。

诸如资源不足国家的贫困地图 [Xie et al. 2016; Jean et al. 2016]、自动驾驶汽车 [Yu et al. 2020a; Sun et al. 2020a]、医学诊断 [AlBadawy et al. 2018; Dai and Gool 2018] 这样的高风险应用都需要模型良好的泛化到训练数据中没有见过的环境中,例如,测试样例来自不同的国家,处于不同的驾驶条件,或来自不同的医院。

先前的工作已经表明:即使是对目前最先进的模型,这些分布变化也会导致性能的大幅下降 [Blitzer et al. 2006; Daumé III 2007;Sugiyama et al. 2007; Ganin and Lempitsky 2015; Peng et al. 2019; Kumar et al. 2020a; Arjovskyet al. 2019; Szegedy et al. 2014; Hendrycks and Dietterich 2019; Sagawa et al. 2020a; Recht et al.2019; Abney 2007; Ruder and Plank 2018; Geirhos et al. 2018; Kumar et al. 2020b; Yu et al. 2020b;Geirhos et al. 2020; Xie et al. 2021a; Koh et al. 2021]。

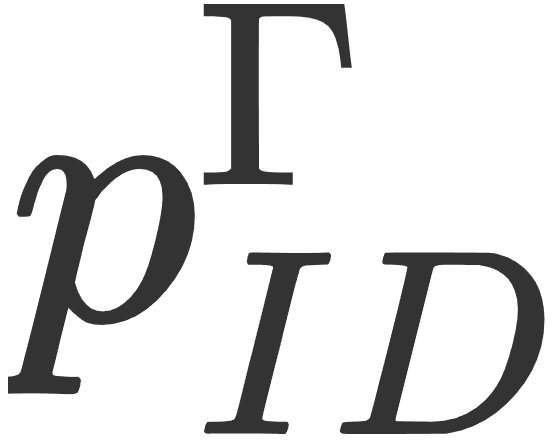

一个基础模型在采样自分布 的大量不同的无标签数据集上进行训练,然后可以被适配到许多的下游任务中。

的大量不同的无标签数据集上进行训练,然后可以被适配到许多的下游任务中。

对于每一个下游任务 ,基础模型在带标签的从训练分布

,基础模型在带标签的从训练分布 中采样的分布内(in-distribution, ID)训练数据上进行训练,然后在分布外(out-of-distribution, OOD)的测试分布

中采样的分布内(in-distribution, ID)训练数据上进行训练,然后在分布外(out-of-distribution, OOD)的测试分布 上进行评价。

上进行评价。

例如,一个贫困地图预测模型 [Xie et al. 2016; Jean et al. 2016] 可以在全世界的无标签卫星数据中学习所有国家的有用特征,然后在带标签的来自尼日利亚的样例上进行微调,最终在缺乏带标签样例的马拉维上进行评价。

我们认为:1)基础模型在鲁棒性方面是一个特别具有前途的方法。现有工作表明了在无标签数据上进行预训练是一种有效的、通用的提高在 OOD 测试分布上准确性的方法,这与限制于有限的分布变化的许多鲁棒性干预措施相反。

然而,我们同样讨论了 2)为什么基础模型可能无法总是应对分布变化,例如某些由于伪相关性或随时间改变的分布变化。

最后,3)我们概述了几个利用和提高基础模型鲁棒性的研究方向。

我们注意到,基础模型提高下游任务性能的一个方法是为适配模型提供归纳偏置(通过模型初始化),这些偏置是在下游训练数据之外的多种数据集上学习得到的。

然而,同样的归纳偏置也可能从预训练数据中编码有害关联,并在分布变化的情况下导致表示和分配危害。