最近,斯坦福HAI研究所和斯坦福监管、评估和治理实验室联合发布了《美国人工智能战略三大支柱的实施挑战》白皮书,系统性地评估了美国在人工智能方面的进展情况。

白皮书主要围绕着AI创新和可信AI的三大支柱:

1. 2020年《政府中的人工智能法案》;

2. 关于「人工智能领导能力」的行政命令;

3. 关于「政府中的人工智能」的行政命令。

总体而言,这些行政命令和《政府中的人工智能法》对于确保美国的人工智能国家战略至关重要,简单来说就是「在未来十年对世界其他国家的竞争优势」。

作者在200多个联邦机构中,全面检查了每项要求的实施状况之后发现,虽然美国在人工智能的创新上已经取得了很多进展,但也面临着一定的问题:

- 所有要求中只有不到40%的要求可以被公开核实为已经实施。

- 88%的受访机构未能提供确定与人工智能有关的监管机构的人工智能计划。

- 大约一半或更多的机构没有按照《政府中的人工智能命令》的要求,提交人工智能用例清单。

概要

人工智能(AI)的变革潜力是一种不争的事实。

为了获得「第四次工业革命」或「第三次数字革命浪潮」的优势,各国正在优先努力重组其公共和私营部门,资助研究和开发(R&D),并建立释放人工智能创新的结构和政策。

在美国,白宫和国会通过增加研发投资来促进人工智能创新及其值得信赖的部署,探索通过国家人工智能研究资源来增加公平获得人工智能相关资源的机制,资助全国各地的国家人工智能研究所,通过CHIPS和科学法案将2800亿美元用于国内半导体制造和「未来产业」,并在白宫的国家人工智能倡议办公室协调人工智能政策。

一、人工智能国家战略:行政命令和立法

虽然人工智能领导令寻求推动美国所有部门的技术突破,但其他两项工作侧重于联邦政府对人工智能的使用。

行政命令 13859

人工智能领导令发起了美国人工智能倡议,以「集中联邦政府的资源发展人工智能,以提高美国的繁荣,加强美国的国家和经济安全,并改善美国人民的生活质量。」

具体而言,它寻求加快联邦政府的努力,通过强调人工智能研发、人工智能相关数据和资源、监管指导和技术标准、人工智能劳动力、公众对人工智能的信任以及国际参与等多管齐下的方法,建立美国在人工智能领域的领导地位所需的基础设施、政策基础和人才。

此外,「协调的联邦政府战略」是必要的,而且人工智能「将影响几乎所有行政部门和机构的任务」,人工智能领导命令进一步授权各机构追求六个相关的战略目标,以「促进和保护美国在人工智能方面的进步」。

行政命令 13960

政府中的人工智能命令指示联邦机构利用「人工智能的潜力来改善政府运作」。认识到「人工智能的持续采用和接受将在很大程度上取决于公众的信任」,政府中的人工智能命令阐明了联邦机构在设计、开发、获取和使用人工智能时应执行的九项原则。

这些原则规定,人工智能应该是(a)合法的,(b)性能驱动的,(c)准确、可靠和有效的,(d)安全、可靠和有弹性的,(e)可理解的,(f)负责和可追踪的,(g)定期监测的,(h)透明的,和(i)负责的。

2020《政府中的人工智能法》

该法试图「通过向联邦机构提供资源和指导,确保整个联邦政府对人工智能的使用是有效的、有道德的和负责任的。」这包括建立一个人工智能职业系列,呼吁为机构使用、采购、人工智能的偏见评估和缓解提供正式指导,并在总务管理局(GSA)内创建一个卓越中心,以支持政府采用人工智能。

二、总体执行情况

作者研究了两个行政命令和《政府中的人工智能法》中每个部门的规定的执行情况。

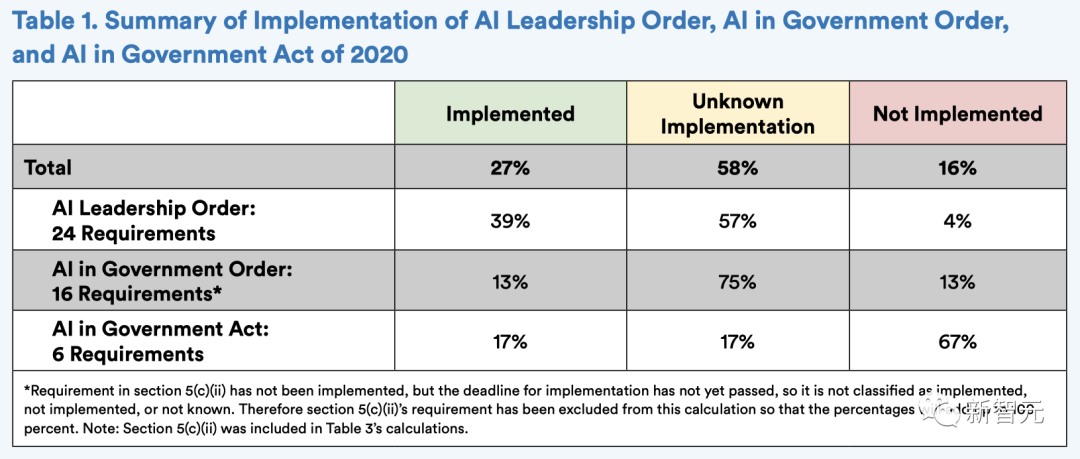

在上述两条行政命令和《2020年政府人工智能法案》中,作者发现45项要求中的11项,即大约27%,已经实施。

然而,45项要求中有7项(16%)没有在截止日期前实施,其余26项要求(58%)无法确认是完全实施还是未实施。

同样,在已经开始执行的要求中,具体执行情况也不确定。包括努力使人工智能研发更容易获得数据和源代码,更好地利用和创建新的人工智能相关的教育和劳动力发展计划,并确保各机构的充分参与,进一步实施值得信赖的人工智能。

《政府中的人工智能法案》的四项有截止日期的要求都没有实施:

- 人事管理办公室(OPM)应在2021年5月前向国会提交一份建立人工智能职业系列的计划;

- OMB应在2021年10月前发布一份关于人工智能采购、减少歧视性影响或偏见的备忘录;

- 各机构应在2022年4月前公开发布与之相一致的计划;

- OPM应在2022年7月前创建一个人工智能职业系列,并估计每个联邦机构的人工智能相关劳动力需求。

在已经实施的措施中,许多都迟于计划中的时间表。例如,国家科学和技术委员会(NSTC)的人工智能专职委员会在截止期限后16个月,才向总统提交了关于更好地利用云计算技术的报告。

三、机构的AI计划

如上所述,这些行政命令和法案的一个重要焦点是「减少使用人工智能技术的障碍,以促进其创新应用」,同时保护公民自由、隐私、美国价值观以及美国经济和国家安全。

因此,这些法令强调审查监管人工智能的适当作用,希望「避免不必要地阻碍人工智能创新和增长的监管或非监管行动」。有两项要求对实现这一目标至关重要:

1. 要求OMB向各机构负责人发布一份备忘录,就各机构应如何监管人工智能提供指导;

2. 要求拥有「监管权」的机构制定并公开发布一项计划(「机构人工智能计划」),以便与OMB提供的指导「实现一致」。

2020年11月17日,OMB发布了《行政部门和机构负责人关于人工智能应用监管指南的备忘录》(OMB M-21-06),敦促机构采取「监管方法,促进创新和增长,产生信任,同时保护美国的核心价值观」。

备忘录划定了10条人工智能应用管理原则,以指导各机构对人工智能的监管和非监管方法,确定了在监管不合适的情况下的非监管方法,以及建议各机构采取的行动,以减少部署和使用人工智能的障碍。

各机构被要求在2021年5月前提交计划(遵守人工智能领导令的最后期限),并在其机构网站上公开发布他们的计划。

目前,在41个被评估的机构中,只有5个(13%)使用OMB AI条例备忘录提供的模板发布了AI计划。这些机构是能源部(DOE)、卫生与公众服务部(HHS)和退伍军人事务部(VA),以及环境保护局(EPA)和美国国际发展署(USAID)。

剩下的36个机构还没有公布本机构的人工智能计划。

四、AI用例清单

政府中的人工智能命令的重点是促进联邦政府内可信赖的人工智能的发展、采用和获取。

为此,它要求各机构「准备一份人工智能的非机密和非敏感用例的清单」,并与联邦首席信息官委员会(CIO委员会)、其他机构以及公众分享。

然而,公开披露人工智能用例清单一直是个问题。

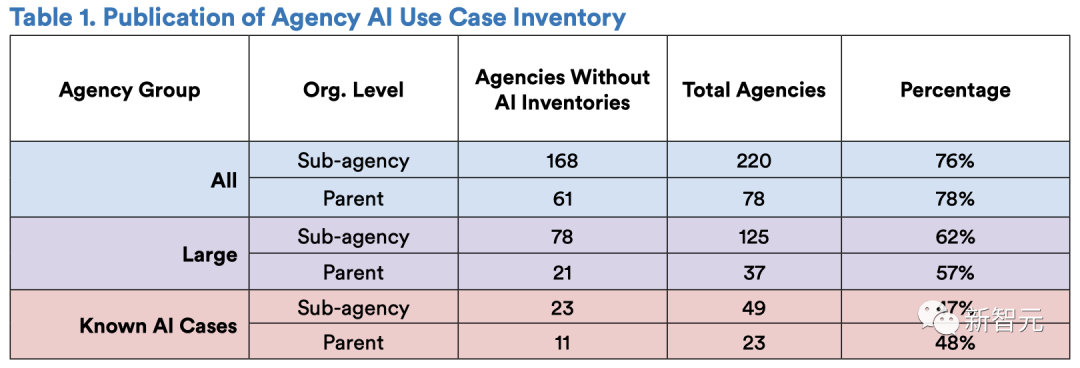

在220个被确定为可能需要遵守这一要求的机构中,有168个机构没有独立的人工智能用例清单或将其人工智能用例纳入其上级机构的清单中。在对78个上级机构进行检查中,只有17个公布了人工智能用例清单。

也就是说,在所有220个上级和下级机构中,76%的机构没有公布清单,78%的机构在上级评估中没有公布清单。

此外,在已知有人工智能用例的49个上级和下级机构中,47%的机构没有公布人工智能用例清单(23个上级和下级机构)。在最窄的一组机构中,即23个在母公司层面上有已知人工智能用例的大型机构,只有11个公布了人工智能清单。

这些清单本身体现了在实施过程中面临的挑战。

首先,机构没有披露人工智能用例,即使这些用例已经被公开记录在案。

第二,机构在实施人工智能用例清单方面的不一致指向了三个尚不清晰的关键点。

- 没有响应:

对于那些没有公布清单的机构,目前还不清楚他们是断言他们没有使用人工智能,还是仅仅没有履行这一要求。

- 机构结构:

除了NIST的清单,所有公布的清单都是在上级机构层面上公布的(例如,商务部或能源部,而不是国家海洋和大气局或电力局公布的清单)。但不清楚的是,清单中未列出的子机构是否没有相关的用例,或者它们是否对假定的上级机构的报告要求没有做出反应。

- AI的定义:

在2019财政年度NDAA中提供的人工智能的定义,并被纳入政府指令中的人工智能,可能是相当广泛的,这可能使各机构在为清查目的而将特定技术归类为「人工智能」时更难遵守。

第三,机构清单通常包含现有的透明度倡议,但有很大的差异。

五、总结

整体而言,作者认为美国人工智能战略的三大支柱,人工智能领导令、政府人工智能令和政府人工智能法,在实际操作上还不够理想。

目前的要求在很多机构看来就是「没有资金支持的任务」。对此,国会应该为各机构提供资源,以充沛人员并培养技术专长,进而制定战略性人工智能计划。

如果不提供适当的资源并授权高级人员履行这些职责,就很可能会影响美国在人工智能方面的领先地位。

作者介绍

Christie Lawrence是斯坦福大学法学院和哈佛大学肯尼迪学院的法学博士/MPP候选人,也是斯坦福监管、评估和治理实验室(RegLab)的成员。她曾是国家人工智能安全委员会(NSCAI)的研究和分析主任,并曾在斯坦福以人为本的人工智能研究所、哈佛大学贝尔弗中心的网络项目、国务院工作,并担任管理顾问。她拥有杜克大学的公共政策学士学位。

Isaac Cui是斯坦福大学法学院的法学博士一年级学生,是RegLab的成员,也是斯坦福大学的Knight-Hennessy学者。他在波莫纳学院获得了物理学和政治学学士学位,并在伦敦政治经济学院获得了应用社会数据科学硕士学位和监管硕士学位,在那里他是马歇尔学者。

Daniel E. Ho是斯坦福大学William Benjamin Scott和Luna M. Scott的法学教授、政治学教授和斯坦福经济政策研究所的高级研究员。他是国家人工智能咨询委员会(NAIAC)的指定成员,斯坦福大学以人为本人工智能研究所(HAI)的副主任,行为科学高级研究中心的教师研究员,以及监管实验室的主任。他在耶鲁大学法学院获得法学博士学位,在哈佛大学获得博士学位。