arXiv论文“Insertion of real agents behaviors in CARLA autonomous driving simulator“,22年6月,西班牙。

由于需要快速prototyping和广泛测试,仿真在自动驾驶中的作用变得越来越重要。基于物理的模拟具有多种优势和益处,成本合理,同时消除了prototyping、驾驶员和弱势道路使用者(VRU)的风险。

然而,主要有两个局限性。首先,众所周知的现实差距是指现实和模拟之间的差异,阻碍模拟自主驾驶体验去实现有效的现实世界性能。其次,缺乏关于真实智体(人类)行为的实证知识,包括后补司机或乘客以及其他道路使用者,如车辆、行人或自行车手。

智体模拟通常是预编程确定、概率随机或基于真实数据生成的,但并不表示与特定模拟场景交互的真实智体行为。本文提出一个初步框架,实现真实智体和模拟环境(包括自主车辆)之间的实时交互,并从多个视图的模拟传感器生成合成序列数据,用于训练依赖行为模型的预测系统。

该方法将沉浸式虚拟现实(VR)和人体运动捕捉(HMC)系统与CARLA集成,用于自动驾驶。其中描述硬件和软件架构,并讨论所谓的行为差距。

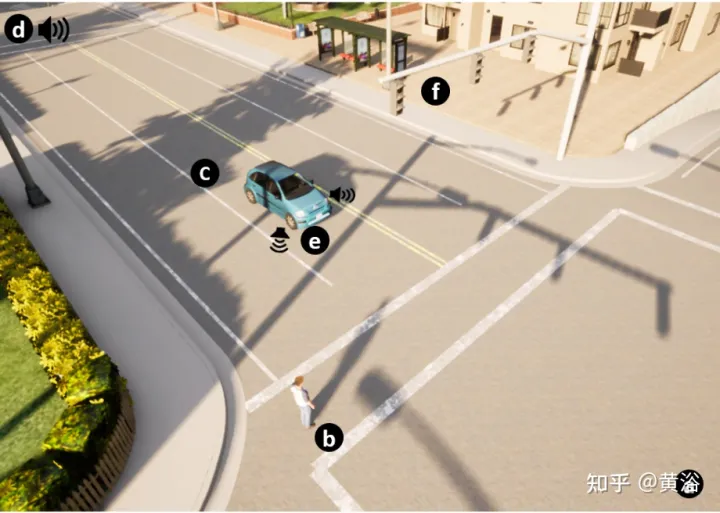

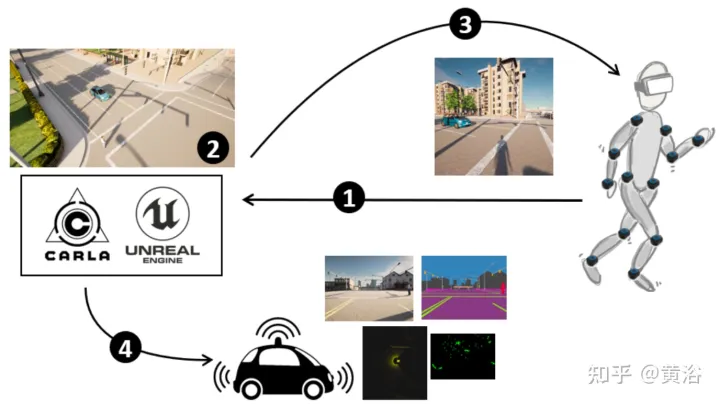

如图所示是该方法概览:(1) CARLA- UE配有头部(VR耳机)和身体(动作捕捉系统)姿势。(2) 生成场景,包括自动驾驶车辆和数字化的行人。(3) 为行人提供环境(通过VR耳机)。(4) 自动车辆传感器感知环境,包括行人。

下面介绍CARLA自动驾驶模拟器中浸入式VR系统的功能。

通过利用UE4提供的功能和外部硬件(如VR眼镜和一组运动传感器)进行行为和交互研究,实现完全行人浸入。

CARLA开源模拟器是在UE4上实现的,UE4提供了高质量的渲染、逼真的物理环境和互操作插件的生态系统。CARLA模拟动态交通场景,并提供UE4创建的虚拟世界与场景内运行的道路智体之间的接口。CARLA被设计成一个服务器-客户端系统来实现这一点,服务器运行模拟程序并渲染场景。客户端和服务器之间的通信通过sockets完成。

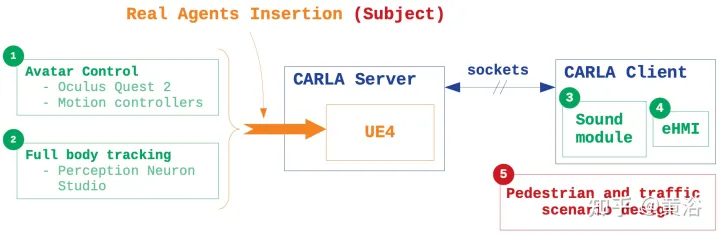

在模拟中插入真实智体行为的主要特征基于五点(如图所示):1)Avatar控制:CARLA blueprint库,收集所有角色和属性的架构,修改行人blueprint,在人和虚拟世界之间创建浸入可移动的VR界面;2) 身体跟踪:用一组惯性传感器和专有的外部软件通过真实场景捕捉主体运动以及运动感知,通过.bvh文件将Avatar的运动集成到模拟器中;3) 声音设计:由于CARLA是一个无音频模拟器,在环境中引入位置声音,增强沉浸感;4) eHMI集成:实现自动驾驶车辆状态和意图信息的通信,做交互研究;5) 场景模拟:在CARLA客户端内设计交通场景,控制车辆和行人的行为。

道路使用者之间的通信是交通环境中的一个重要因素。实验中为自动驾驶车辆提供了外部人机界面(eHMI),将其状态和意图传达给实际道路使用者。

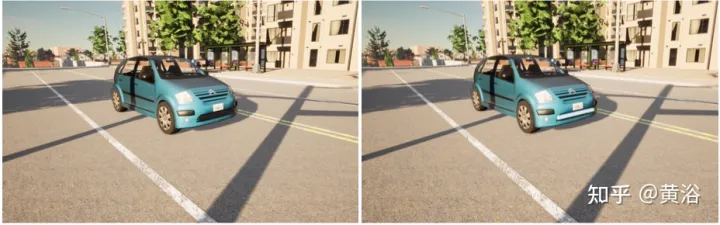

如图所示,提出的eHMI设计由沿汽车前部的光带组成。左图无eHMI,右图带eHMI。这可以研究当行人轨迹与虚拟场景车辆轨迹汇聚时,界面对决策的影响。

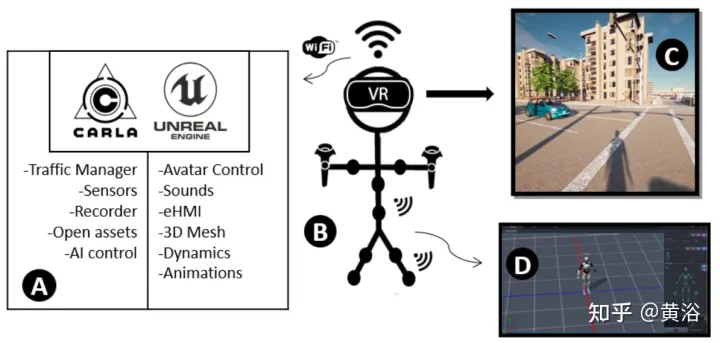

整个系统架构如图:

CARLA提供了不同的选项来模拟交通和特定的交通场景。用交通管理模块填充具有真实城市交通状况的模拟。每辆车的控制在特定线程执行。通过同步消息传递管理与其他层的通信。

通过设置强制特定行为参数来控制交通流。例如,可以允许汽车超速、忽略红绿灯条件、忽略行人或强制改变车道。

主体集成到包括一个城市3-D模型地图的模拟器。每个地图都基于一个OpenDRIVE文件,描述完整注释的道路布局。该功能允许设计自己的地图,在真实和虚拟环境中再现相同的流量场景,评估模拟器真实行为的集成,并能够通过比较交互结果来进行现场研究。

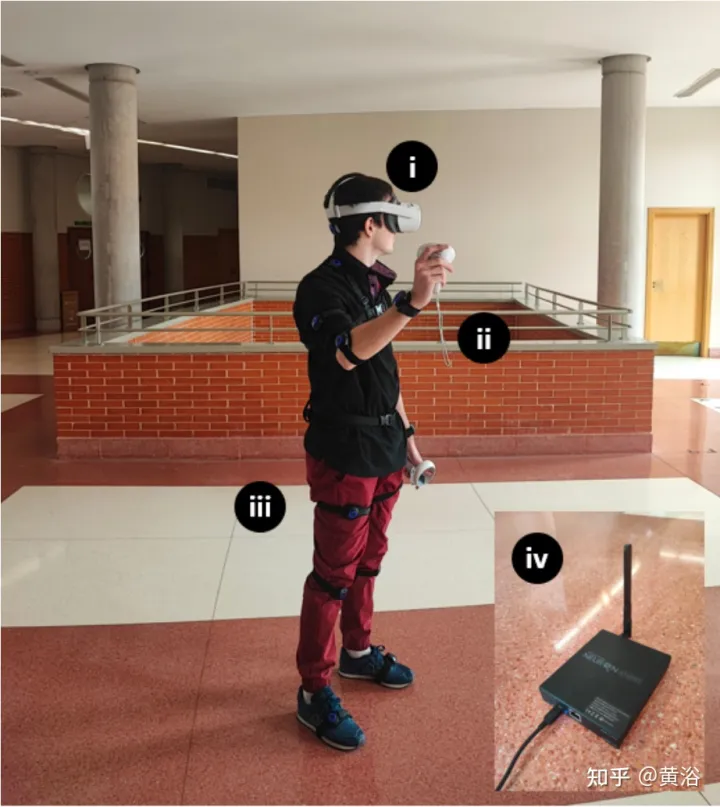

硬件设置如图:在实验过程中,用Oculus Quest 2作头戴式设备(HMD),Meta创建,6GB RAM处理器、两个可调1832 x 1920透镜、90Hz刷新率和256 GB的内存。Quest 2具有Wi-Fi 6、蓝牙5.1和USB Type-C连接、SteamVR支持和3D扬声器。对于全身跟踪,用带有惯性跟踪器的PNS封装解决方案。该套件包括独立的VR耳机、2个运动控制器、17个Studio惯性人体传感器、14组straps、1个充电箱和1个Studio收发器。

由于CARLA build和Quest 2仅依赖Windows,VR Immersion System目前依赖UE4.24和Windows 10操作系统。用TCP sockets插件,编辑器的所有参与者位置和其他有用参数从Python API发送,集成每个参与者的声音或自动驾驶车辆的eHMI。”VR Preview”在HMD启动游戏。Perception Neuron Studio与Axis Studio合作,Axis Studio一次支持最多3个主题,同时支持23个身体和手指传感器。

如图是交互交通状况的模拟:(a) 3D世界设计。(b) 行人匹配执行者Avatar。(c) 自动驾驶汽车。(d) 环境声音和智体声音。(e) eHMI。(f) 交通灯和交通标志。