arXiv论文“Trajectory-guided Control Prediction for End-to-end Autonomous Driving: A Simple yet Strong Baseline“, 2022年6月,上海AI实验室和上海交大。

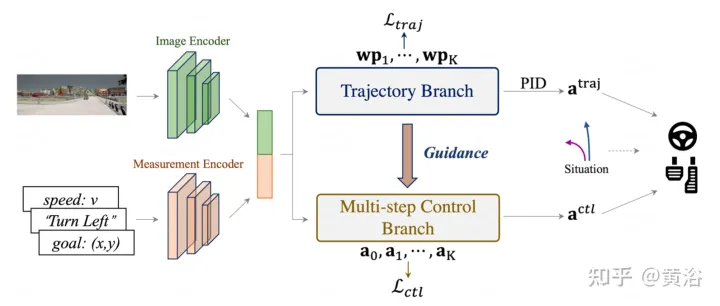

当前的端到端自主驾驶方法要么基于规划轨迹运行控制器,要么直接执行控制预测,这跨越了两个研究领域。鉴于二者之间潜在的互利,本文主动探索两个的结合,称为TCP (Trajectory-guided Control Prediction)。具体来说,集成方法有两个分支,分别用于轨迹规划和直接控制。轨迹支路预测未来轨迹,而控制支路涉及一种新的多步预测方案,推理当前动作和未来状态之间的关系。这两个支路相连,以便控制支路在每个时间步从轨迹支路接收相应的引导。然后将两个分支输出融合,实现互补优势。

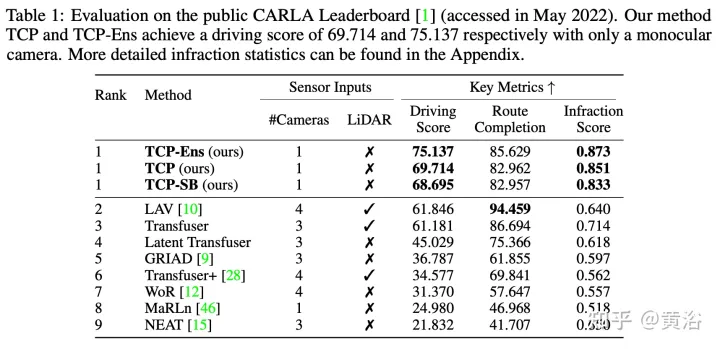

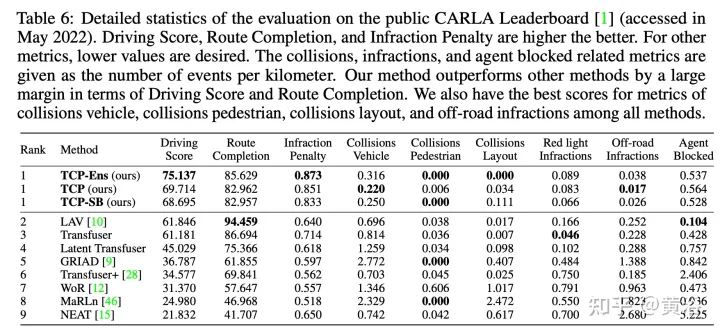

在具有挑战性场景的闭环城市驾驶环境中使用Carla模拟器进行评估。即使单目摄像机输入,该方法在CARLA官方排行榜排名第一。源代码和数据将开源:https://github.com/OpenPerceptionX/TCP

选择Roach(“End-to-end urban driving by imitating a reinforcement learning coach“. ICCV, 2021)作为专家。Roach是由RL训练的一个简单模型,具有特权信息,包括道路、车道、路线、车辆、行人、交通灯和车站,所有这些都被渲染为2D BEV图像。与手工规则(hand-crafted)专家相比,这种基于学习的专家可以传递除直接监督信号外的更多信息。具体来说,有一个特征损失,这迫使学生模型的最终输出头之前的潜特征与专家相似。一个价值损失也被添加为学生模型的辅助任务,以预测预期回报(return)。

如图所示,整个架构由输入编码阶段和两个后续分支组成:输入图像i通过基于CNN的图像编码器,例如ResNet,生成特征地图F。同时,导航信息g与当前速度v串联形成测量输入m,然后基于MLP的测量编码器将m作为其输入并输出测量特征jm。编码特征然后由两个分支共享,用于后续轨迹和控制预测。具体来说,控制支路是一种新的多步预测设计,具有来自轨迹支路的引导。最后,采用了一种基于场景的融合方案,将两种输出范式的最佳者结合起来。

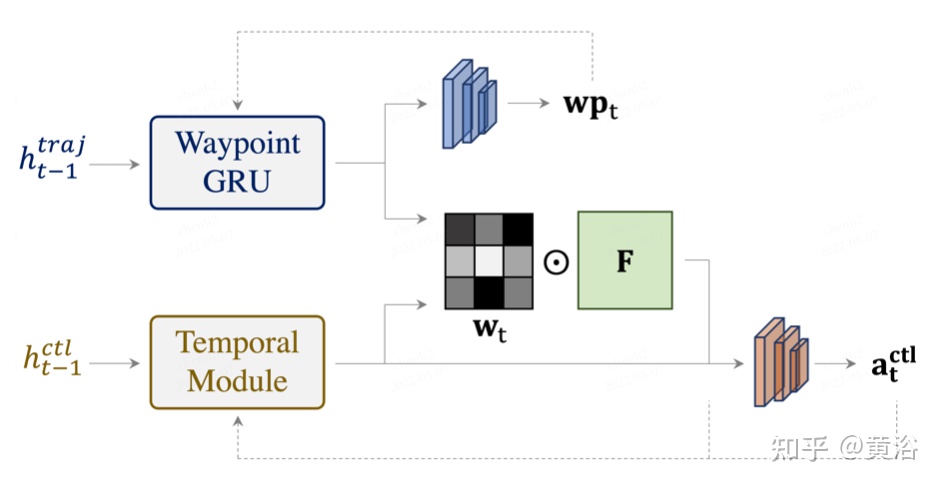

如图所示,TCP通过学习注意图来寻求轨迹规划分支的帮助,从编码的特征图中提取重要信息。两个分支(轨迹和控制)之间交互增强了这两个密切相关输出范式的一致性,并进一步阐述了多任务学习(MTL)精神。具体地说,利用图像编码器F在时间步长t提取2D特征图 ,来自控制分支和轨迹分支的相应隐藏状态用于计算注意图。

信息表示特征被输入到策略头中,该策略头在所有时间t步之间共享,预测相应的控制动作。注意,对于初始步骤,仅用测量特征来计算初始注意图,并将注意图像特征与测量特征相结合,形成初始特征向量。为了保证特征确实描述该步骤的状态并包含用于控制预测的重要信息,在每个步骤中添加了一个特征损失,以便初始特征向量也接近专家的特征。

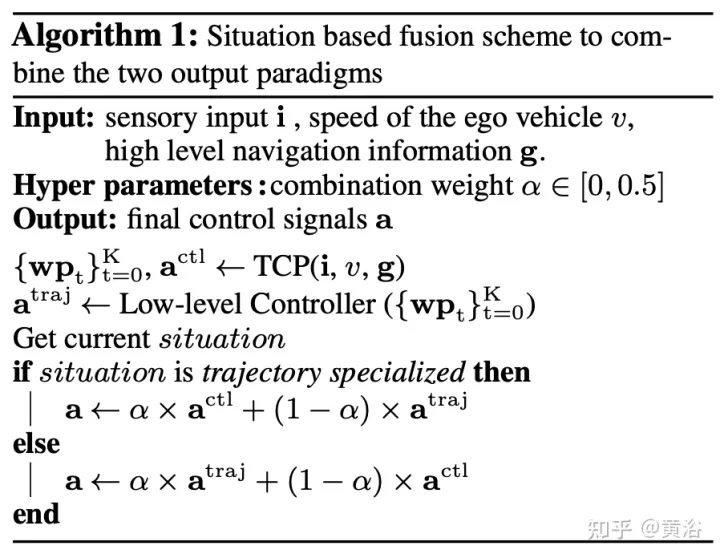

TCP框架有两种形式的输出表示:规划轨迹和预测控制。为了进一步结合,设计了一种基于场景的融合策略,如算法1伪代码所示。

具体来说,将α表示为组合权重,其值在0到0.5之间,根据先验belief,在某种情况下一种表示更适合,通过权重α取平均值,将轨迹和控制预测的结果结合起来,更合适的一个占据更多权重(1 − α)。注意,组合权重α确实不需要是常数或对称的,这意味着可以在不同的情况下将其设置为不同值,或者针对特定的控制信号设置为不同值。在实验中,根据自车是否拐弯来选择场景,这意味着,如果拐弯,场景是控制特有的,否则是轨迹特有的。

实验结果如下: