目录

- Language models generalize beyond natural proteins

- A high-level programming language for generative protein design

- DOC: Improving Long Story Coherence With Detailed Outline Contro

- Scalable Diffusion Models with Transformers

- Point-E: A System for Generating 3D Point Clouds from Complex Prompts

- Reprogramming to recover youthful epigenetic information and restore vision

- Training Robots to Evaluate Robots: Example-Based Interactive Reward Functions for Policy Learning

- ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

论文 1:Language models generalize beyond natural proteins

- 作者:Robert Verkuil 、 Ori Kabeli 等

- 论文地址:https://www.biorxiv.org/content/10.1101/2022.12.21.521521v1.full.pdf

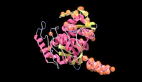

摘要:研究者专注于两个蛋白质设计任务:指定结构的固定骨架设计;从模型中采样结构的无约束生成。尽管语言模型仅针对序列进行训练,但该研究发现它们能够设计结构。在该研究的实验结果中,一共生成了 228 种蛋白质,设计成功的比率是 152/228(67%)。

在 152 个实验成功的设计中,有 35 个与已知的天然蛋白质没有明显的序列匹配。

对于固定主干设计,语言模型成功为 8 个经过实验评估的人工创建的固定主干目标生成了蛋白质设计。

对于不受约束生成的情况,采样的蛋白质涵盖了不同的拓扑结构和二级结构组成,结果具有很高的实验成功率 71/129(55%)。

下图 1 是 ESM2 模型设计蛋白质的总体流程:

推荐:该研究发现 ESM2 语言模型通过学习深层语法,就能生成天然蛋白质以外的新蛋白质。

论文 2:A high-level programming language for generative protein design

- 作者:Brian Hie 、 Salvatore Candido 等

- 论文地址:https://www.biorxiv.org/content/10.1101/2022.12.21.521526v1.full.pdf

摘要:FAIR 研究者从模块化和可编程性入手,将两者置于更高的抽象层次,蛋白质设计者只需要重新组合高级指令,然后在生成模型上执行指令即可。

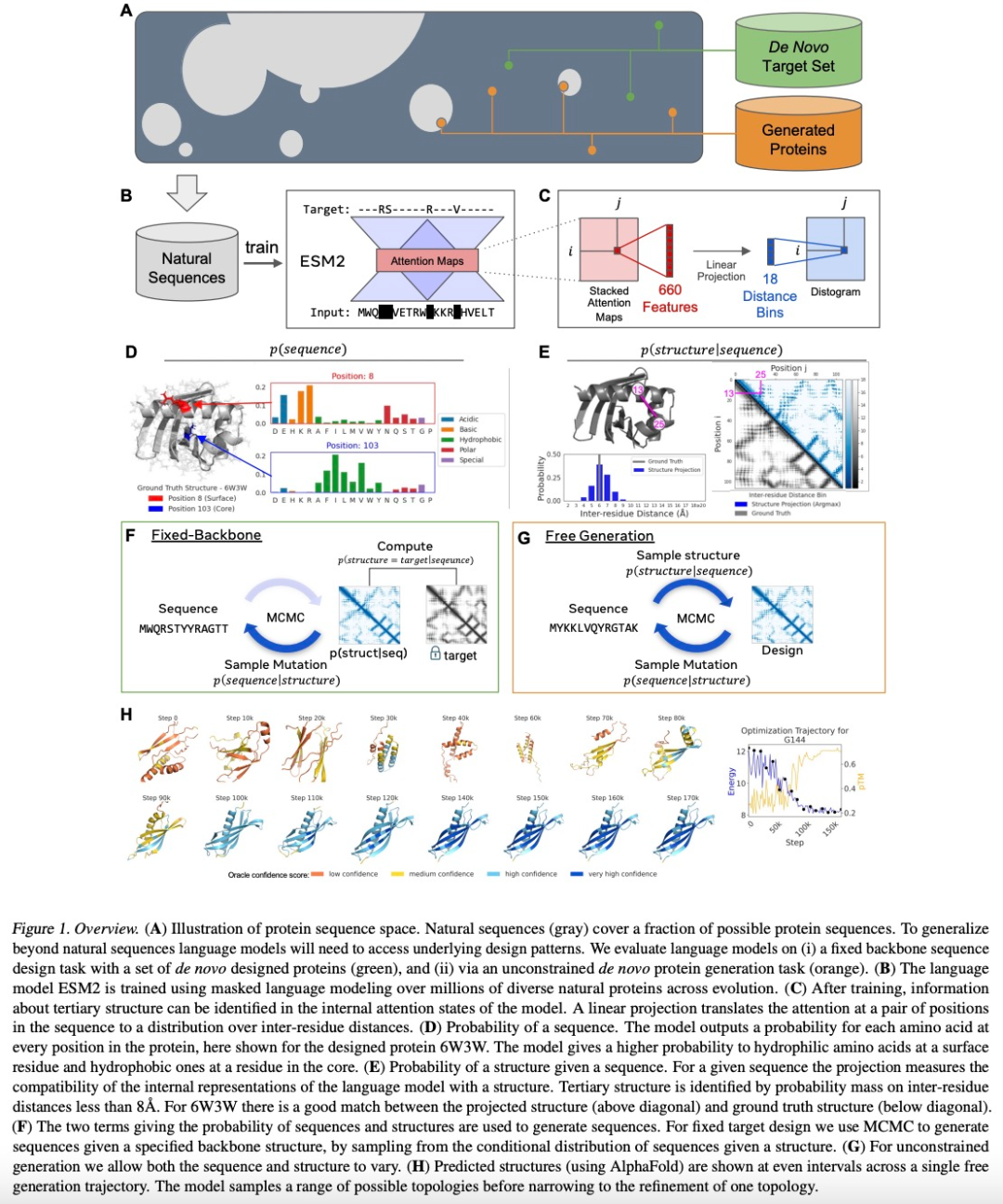

他们提出的生成蛋白质设计的编程语言,允许设计人员指定直观、模块化和分层的程序。该编程语言首先需要一个语法树 (图 1A),由末端符号 (即树的叶子) 和非末端符号 (即树的内部节点) 组成,前者对应一个独特的蛋白质序列 (在蛋白质中可能重复),后者支持分层组织。

此外还需要一个基于能量的生成模型。首先,蛋白质设计器指定一个高级程序,该程序由一组按层次组织的约束组成(图 1A)。然后,该程序编译为一个能量函数,用于评估与约束的兼容性,约束是任意的且不可微的(图 1B)。最后通过将原子级结构预测(由语言模型支持)合并到能量函数中,可以生成大量复杂的蛋白质设计(图 1C)。

推荐:编程生成复杂和模块化的蛋白质结构。

论文 3:DOC: Improving Long Story Coherence With Detailed Outline Contro

- 作者:Kevin Yang 、 Dan Klein 等

- 论文地址:https://arxiv.org/pdf/2212.10077.pdf

摘要:前段时间,模仿人类写作过程的语言模型 Re^3 发布,该模型不需要微调大模型,而是通过设计 prompt 来生成一致性强的故事。

现在,该研究团队又提出了一个生成故事的新模型 DOC。论文作者 Kevin Yang、田渊栋也在推特上发文宣传了 DOC 模型,表示 DOC 比 Re^3 生成的故事更加连贯、有趣。

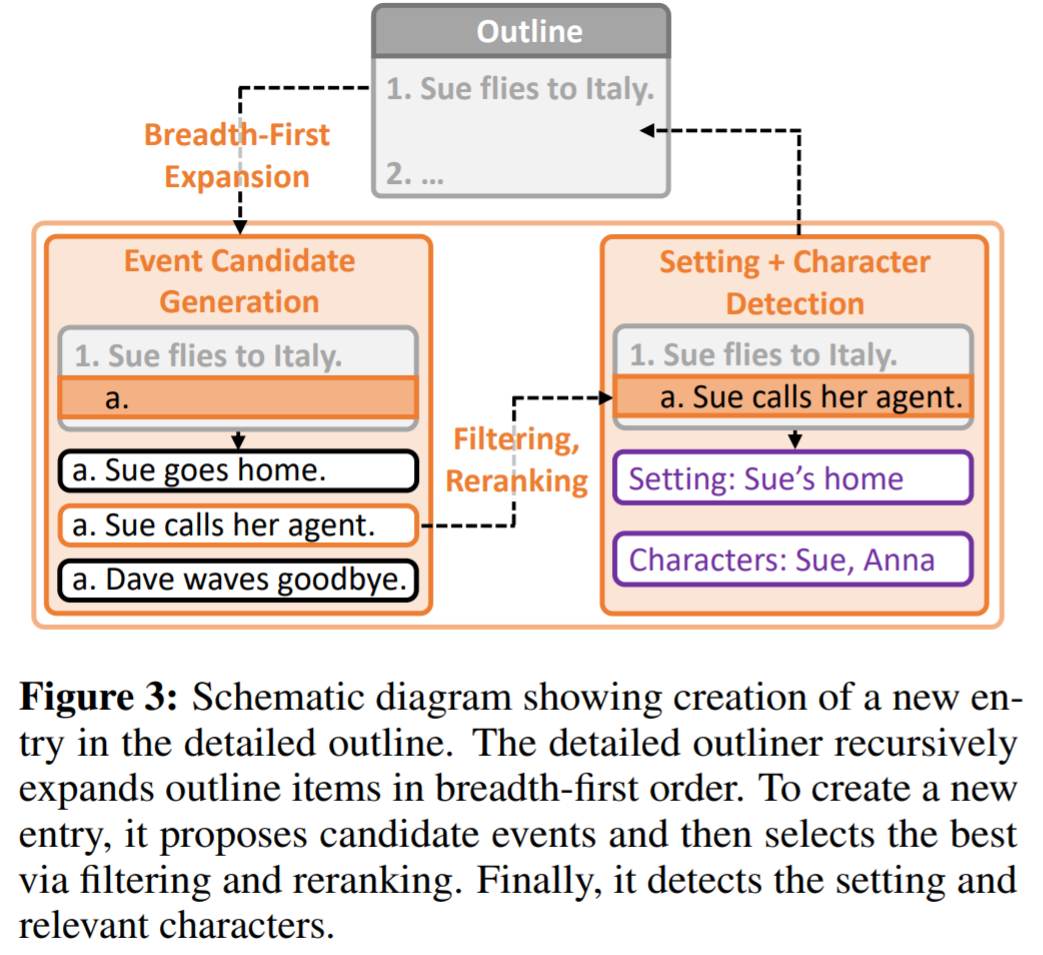

DOC 框架意指详细大纲控制(Detailed Outline Control),用于在自动生成数千字长故事时提高情节的连贯性。DOC 由两个互补的组件组成:详细大纲组件(Detailed Outliner)、详细控制器(Detailed Controller)。

Detailed Outliner 负责创建详细的、分层结构的大纲,将写作创意从起草转移到规划阶段。Detailed Controller 则通过控制故事段落与大纲细节对齐,确保生成结果遵循详细的大纲。

该研究对模型自动生成故事的功能进行了人工评估,DOC 在多个指标上获得了大幅增益:情节连贯性(22.5%)、大纲相关性(28.2%)和趣味性(20.7%),大大优于 Re^3 模型。此外,DOC 在交互式生成环境中更易于控制。

推荐:田渊栋等原班人马又一新作:AI 生成长篇故事,数千字长文也能连贯、有趣。

论文 4:Scalable Diffusion Models with Transformers

- 作者:William Peebles 、谢赛宁

- 论文地址:https://arxiv.org/pdf/2212.09748.pdf

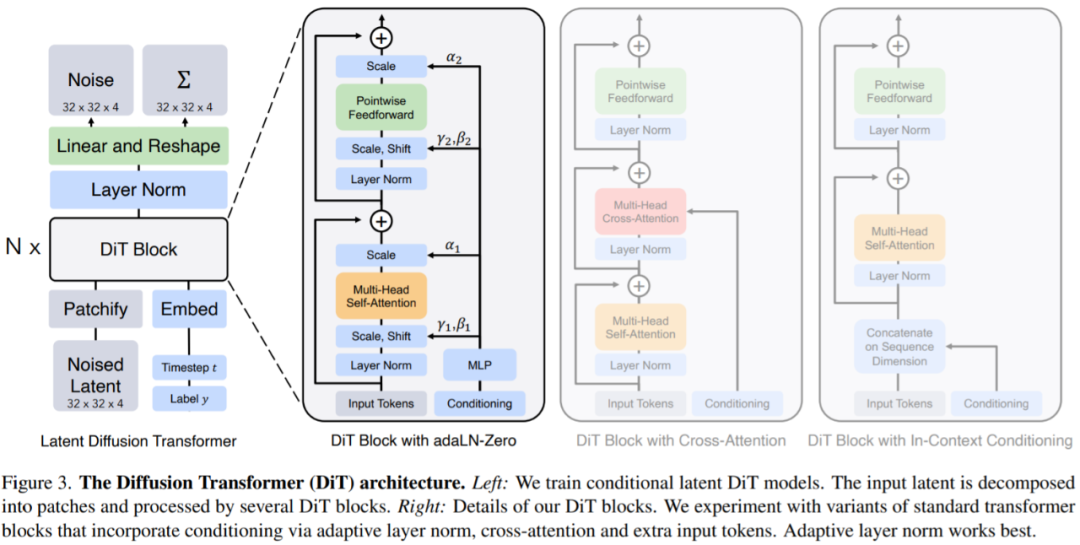

摘要:本文中来自 UC 伯克利的 William Peebles 以及纽约大学的谢赛宁撰文《 Scalable Diffusion Models with Transformers 》,目标是揭开扩散模型中架构选择的意义,并为未来的生成模型研究提供经验基线。该研究表明,U-Net 归纳偏置对扩散模型的性能不是至关重要的,并且可以很容易地用标准设计(如 transformer)取代。

该研究专注于一类新的基于 Transformer 的扩散模型:Diffusion Transformers(简称 DiTs)。DiTs 遵循 Vision Transformers (ViTs) 的最佳实践,有一些小但重要的调整。DiT 已被证明比传统的卷积网络(例如 ResNet )具有更有效地扩展性。

具体而言,本文研究了 Transformer 在网络复杂度与样本质量方面的扩展行为。研究表明,通过在潜在扩散模型 (LDM) 框架下构建 DiT 设计空间并对其进行基准测试,其中扩散模型在 VAE 的潜在空间内进行训练,可以成功地用 transformer 替换 U-Net 主干。本文进一步表明 DiT 是扩散模型的可扩展架构:网络复杂性(由 Gflops 测量)与样本质量(由 FID 测量)之间存在很强的相关性。通过简单地扩展 DiT 并训练具有高容量主干(118.6 Gflops)的 LDM,可以在类条件 256 × 256 ImageNet 生成基准上实现 2.27 FID 的最新结果。

推荐:统治扩散模型的 U-Net 要被取代了,谢赛宁等引入 Transformer 提出 DiT。

论文 5:Point-E: A System for Generating 3D Point Clouds from Complex Prompts

- 作者:Alex Nichol、Heewoo Jun 等

- 论文地址:https://arxiv.org/abs/2212.08751

摘要:OpenAI 开源的 3D 模型生成器 Point-E 引发了 AI 圈的新一轮热潮。根据与开源内容一并发布的论文介绍,Point-E 可以在单块 Nvidia V100 GPU 上在一到两分钟内生成 3D 模型。相比之下,现有系统(如谷歌的 DreamFusion)通常需要数小时和多块 GPU。

Point-E 不输出传统意义上的 3D 图像,它会生成点云,或空间中代表 3D 形状的离散数据点集。Point-E 中的 E 是「效率」的缩写,表示其比以前的 3D 对象生成方法更快。不过从计算的角度来看,点云更容易合成,但它们无法捕获对象的细粒度形状或纹理 —— 这是目前 Point-E 的一个关键限制。

为了解决这一问题,OpenAI 团队训练了一个额外的人工智能系统来将 Point-E 的点云转换为网格。

推荐:三次元的文本到图像 AI 成了:单 GPU 不到一分钟出货,OpenAI 出品。

论文 6:Reprogramming to recover youthful epigenetic information and restore vision

- 作者:Yuancheng Lu、Benedikt Brommer

- 论文地址:https://www.nature.com/articles/s41586-020-2975-4

摘要:2020 年 12 月 2 日,顶级科学期刊《Nature》的封面上,出现了几个令人惊奇的词汇:「Turning Back Time」(时光倒流)。

登上封面的研究来自于哈佛大学医学院终身教授 David Sinclair 的团队。尽管文章只有寥寥数页,却展示了全新的前景 —— 利用基因治疗诱导神经节细胞重编程,恢复年轻的表观遗传信息,从而使得视神经能在损伤后再生,并逆转青光眼和衰老造成的视力下降。

David Sinclair 表示,团队的研究目标始终是减缓和逆转人体衰老,通过解决病因而不是症状来治疗疾病。

在 2020 年这项研究的基础上,David Sinclair 的团队正使用名为「REVIVER」的年龄逆转技术在非人类灵长类动物身上进行测试,以观察看它是否安全并能像小鼠一样治疗失明。

最新的研究则来自 David Sinclair 及其领导的 60 人团队,他表示,衰老就像 CD 上可以擦掉的划痕,或者系统里损坏的软件,只需重新安装即可实现逆转,就像《Lifespan》书中所说的那样。

在预印版论文中,作者表示所有生物都会随时间推移丢失遗传信息,逐渐丧失细胞功能。使用被称为 ICE(用于表观基因组的可诱导变化)的转基因小鼠系统,研究人员证明了修复非诱变 DNA 断裂的过程加速了与年龄相关的生理、认知和分子变化,包括表观遗传的侵蚀, 细胞能力丧失、细胞衰老等。

研究人员称,通过异位表达进行的表观遗传重编程可恢复年轻基因表达的模式。

推荐:逆转衰老的研究。

论文 7:Training Robots to Evaluate Robots: Example-Based Interactive Reward Functions for Policy Learning

- 作者:Kun Huang、Edward Hu、Dinesh Jayaraman

- 论文地址:https://openreview.net/pdf?id=sK2aWU7X9b8

摘要:通常来说,物理相互作用有助于揭示不太明显的信息,例如我们可能会拉一下桌腿来评估它是否稳固,或者把一个水瓶倒过来检查它是否漏水,该研究建议可以通过训练机器人来自动获得这种交互行为,以评估机器人尝试执行技能的结果。这些评估反过来作为 IRF(interactive reward functions),用于训练强化学习策略以执行目标技能,例如拧紧桌腿。此外,即使完全训练完成之后,IRF 也可以作为改进在线任务执行的验证机制。对于任何给定的任务, IRF 训练非常方便,并且不需要进一步的规范。

评估结果表明,IRF 可以实现显着的性能改进,甚至可以通过访问演示或精心设计的奖励来超越基线。比如下图中,机器人必须先关门,然后旋转对称的门把手才能完全锁住门。