自 2017 年首次举办以来,CoRL 已经成为了机器人学与机器学习交叉领域的全球顶级学术会议之一。CoRL 是面向机器人学习研究的 single-track 会议,涵盖机器人学、机器学习和控制等多个主题,包括理论与应用。

2022年的CoRL大会于12月14日至18日在新西兰奥克兰举行。

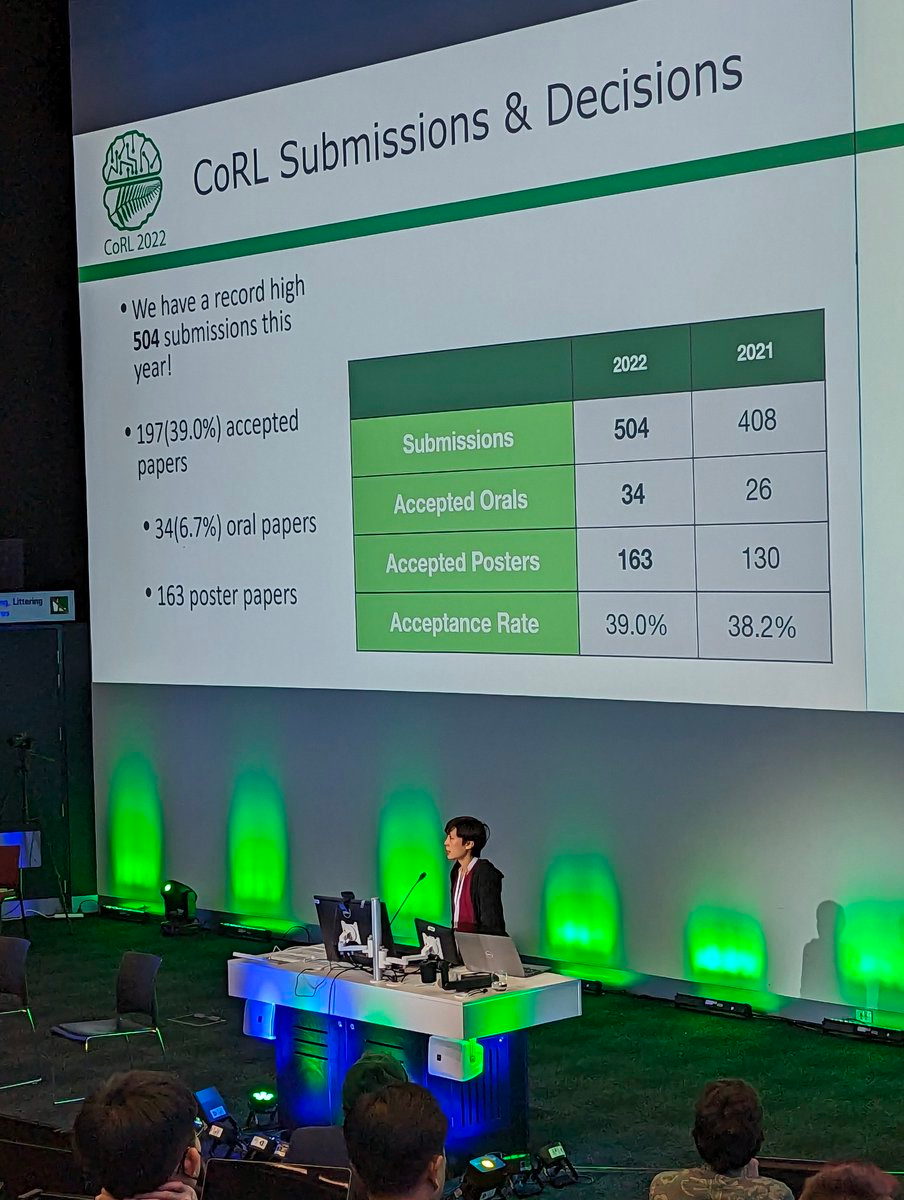

本届大会共收到504篇投稿,最终接收34篇Oral论文、163篇Poster论文,接收率为39%。

目前,CoRL 2022 公布了最佳论文奖、最佳系统论文奖、特别创新奖等全部奖项。宾夕法尼亚大学GRASP实验室硕士、上海交通大学校友Kun Huang获得了大会最佳论文奖。

最佳论文奖

获得本届大会最佳论文奖的是来自宾夕法尼亚大学的一项研究。

- 论文标题:Training Robots to Evaluate Robots: Example-Based Interactive Reward Functions for Policy Learning

- 作者:Kun Huang、Edward Hu、Dinesh Jayaraman

- 论文链接:https://openreview.net/pdf?id=sK2aWU7X9b8

论文摘要:通常来说,物理相互作用有助于揭示不太明显的信息,例如我们可能会拉一下桌腿来评估它是否稳固,或者把一个水瓶倒过来检查它是否漏水,该研究建议可以通过训练机器人来自动获得这种交互行为,以评估机器人尝试执行技能的结果。这些评估反过来作为IRF(interactive reward functions),用于训练强化学习策略以执行目标技能,例如拧紧桌腿。此外,即使完全训练完成之后,IRF也可以作为改进在线任务执行的验证机制。对于任何给定的任务, IRF训练非常方便,并且不需要进一步的规范。

评估结果表明,IRF 可以实现显着的性能改进,甚至可以通过访问演示或精心设计的奖励来超越基线。比如下图中,机器人必须先关门,然后旋转对称的门把手才能完全锁住门。

门锁(door locking)评估示例演示

门锁(door locking)评估示例演示

下面实验的目的是将 3 个视觉上相同的块堆叠成一个稳定的塔,其中的一个小方块明显比其他两块重,所以最佳策略是将它放在底部。

堆叠评估示例演示

堆叠评估示例演示

为了检查算法的鲁棒性和通用性,该研究使用具有 9 个关节的 D'Claw 在真实机器人拧紧实验中对其进行测试。此任务的目的是将4-prong阀门顺时针旋转约 180° 进入拧紧状态(阀门底座上的白线)。

作者介绍

本次获得CoRL 2022最佳论文奖的作者共有三位,分别是Kun Huang、Edward Hu、Dinesh Jayaraman 。

Dinesh Jayaraman为宾夕法尼亚大学GRASP实验室的助理教授,他领导着感知、行动和学习(PAL)研究小组,致力于计算机视觉、机器学习和机器人技术的交叉问题研究。

Kun Huang为宾夕法尼亚大学GRASP实验室硕士,在Dinesh Jayaraman教授的指导下研究强化学习。他在密歇根大学获得了计算机科学学士学位,在那里他与 Dmitry Berenson 教授一起研究机器人感知。Kun Huang本科毕业于上海交通大学,研究兴趣包括机器人与现实世界的应用。Kun Huang 在硕士期间曾在 Waymo 实习,毕业后将加入 Cruise 担任机器学习工程师。

领英主页:https://www.linkedin.com/in/kun-huang-620034171/

Edward S. Hu 为宾夕法尼亚大学GRASP实验室的博士生,师从Dinesh Jayaraman教授。他的主要研究兴趣包括基于模型的强化学习等。Edward在南加州大学获得了计算机科学硕士和学士学位,在那里他与Joseph J. Lim教授一起研究机器人的强化和模仿学习。

最佳论文入围名单

此次会议共有3篇论文入围最佳论文奖项,除了最终得奖的论文以外,其他2篇分别是:

- 论文标题:Learning Agile Skills via Adversarial Imitation of Rough Partial Demonstrations

- 作者:Chenhao Li、Marin Vlastelica、Sebastian Blaes、Jonas Frey、Felix Grimminger、Georg Martius

- 论文链接:https://arxiv.org/pdf/2206.11693.pdf

- 论文标题:Supercharging Imitation with Regularized Optimal Transport

- 作者:Siddhant Haldar 、 Vaibhav Mathur、Denis Yarats、Lerrel Pinto

- 论文链接:https://arxiv.org/pdf/2206.15469.pdf

最佳系统论文奖

获得本届大会最佳系统论文奖的是来自CMU、UC伯克利的一项研究。

- 论文标题:Legged Locomotion in Challenging Terrains using Egocentric Vision

- 作者:Ananye Agarwal,Ashish Kumar,Jitendra Malik, Deepak Pathak

- 论文链接:https://arxiv.org/pdf/2211.07638.pdf

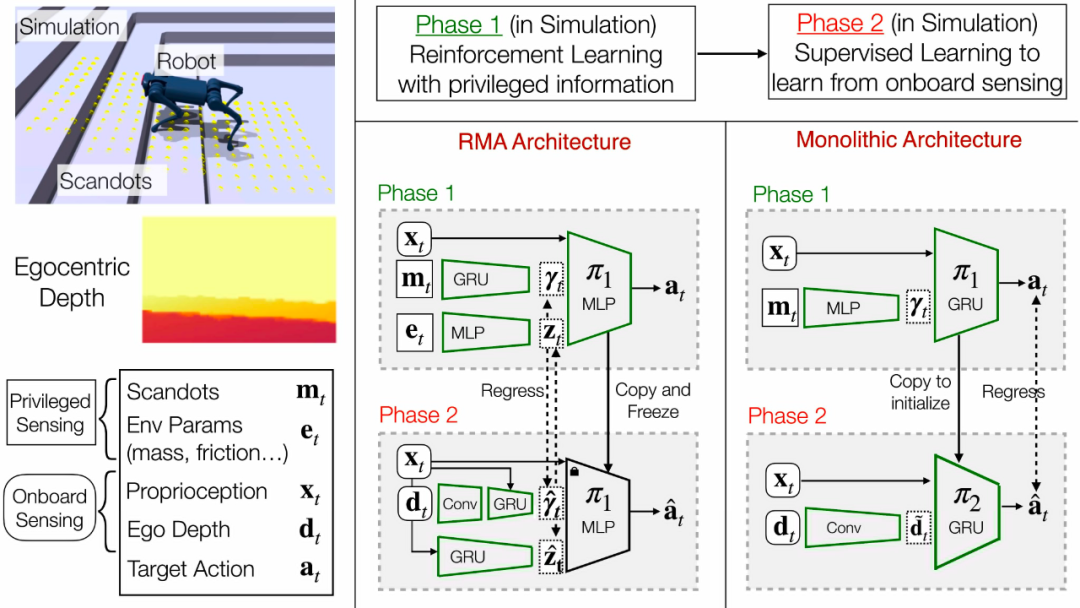

论文摘要:动物能够利用视觉进行精确而敏捷的运动,而复制这种能力一直是机器人技术的一个长期目标。传统的方法是将这个问题分解为海拔测绘和落脚点规划阶段(foothold planning phase)。然而,海拔测绘很容易受到故障和大面积噪声的影响,需要专门的硬件而且在生物学上是不可行的。

在本文中,研究者提出了第一个能够穿越楼梯、路边、垫脚石和空隙的端到端运动系统,并在一个中等大小、使用单个正面的深度摄像头的四足机器人上展示了这一结果。由于机器人体积小,需要发现其他地方没有的专门的步态模式。摄像头需要掌握记住过去的信息的策略,以估计身后脚下的地形。

研究者在模拟环境中训练了机器人的策略。训练分为两个阶段:首先使用强化学习训练一个具有低计算成本的深度图像变体的策略,然后将其提炼为使用监督学习的深度的最终策略。

最终的策略可迁移到现实世界,并能够在机器人有限的计算能力上实时运行。它可以穿越大量的地形,同时对诸如湿滑表面和岩石地形等干扰具有鲁棒性。

垫脚石和空隙

机器人能够跨过各种配置的吧台凳,并调整步长以跨过大间隙。由于后脚附近没有摄像头,机器人必须记住吧台凳的位置并在相应的位置放置后脚。

楼梯和路边

该机器人能够爬上24厘米高、30厘米宽的楼梯。策略适用于各种照明条件下的不同楼梯和路边。在分布不均匀的楼梯,机器人最初会被卡住,但最终能够使用爬升行为跨过这些障碍。

非结构化地形

机器人可以穿越不属于其训练类别之一的非结构化地形,显示了系统的泛化能力。

黑暗中的移动

深度相机使用红外光投射图案,即使在几乎没有环境光的情况下也能准确估计深度。

鲁棒性

策略对大力量(从高处投掷 5 公斤重物)和湿滑表面(水倒在塑料布上)具有鲁棒性。

作者介绍

这项研究共有四位作者。

Jitendra Malik现为UC伯克利电气工程和计算机科学系Arthur J. Chick教授,他的研究领域包括计算机视觉、人类视觉的计算建模、计算机图形学和生物图像分析等。

本次获奖研究的作者之一Ashish Kumar是他的博士生。

Deepak Pathak现为卡内基梅隆大学助理教授,他在加州大学伯克利分校获得博士学位,研究的主题包括机器学习、机器人和计算机视觉。

本次获奖研究的作者之一Ananye Agarwal是他的博士生。

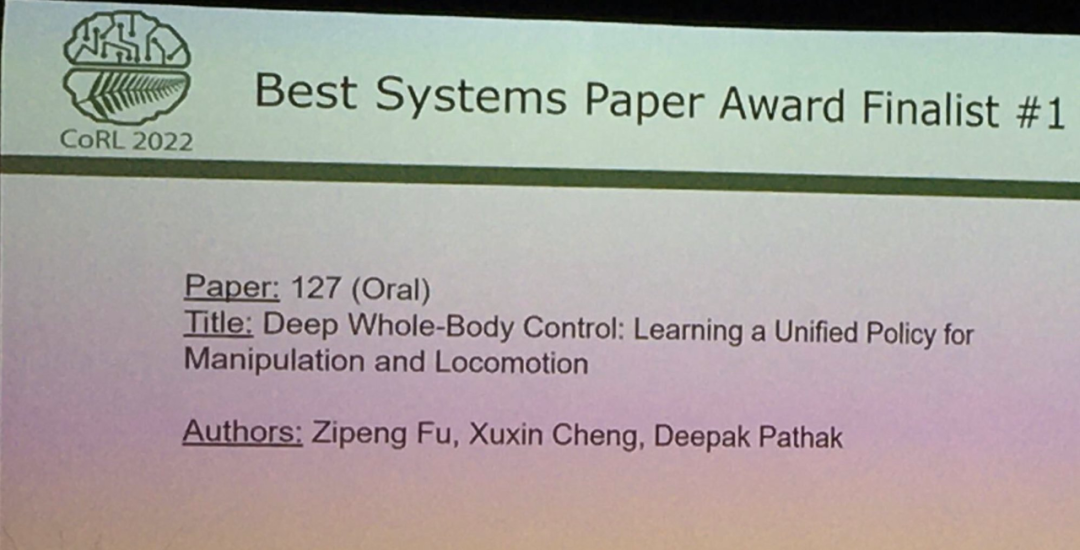

此外,Deepak Pathak还有一项研究在本次大会最佳系统论文奖的入围名单之内。

- 论文标题:Deep Whole-Body Control: Learning a Unified Policy for Manipulation and Locomotion

- 作者:Zipeng Fu, Xuxin Cheng, Deepak Pathak

- 论文链接:https://arxiv.org/abs/2210.10044

特别创新奖

这次大会还评选出了特别创新奖,这项研究由谷歌的多位研究者共同完成。

- 论文标题:Do As I Can, Not As I Say: Grounding Language in Robotic Affordances

- 作者:Brian Ichter 、 Anthony Brohan 、Michael Ahn 等

- 论文链接:https://arxiv.org/pdf/2204.01691.pdf

论文摘要:大型语言模型可以编码关于世界的大量语义知识,这样的知识对机器人非常有用。然而,语言模型存在这样一个缺点,即对真实世界缺乏经验,这使得其在给定任务上很难利用语义进行决策。

来自谷歌的研究者建议通过预训练技能来提供大型语言模型在现实世界的基础,这些技能用于约束模型,以提出既可行又适合上下文的自然语言操作。机器人可以充当语言模型的「手和眼睛」,而语言模型提供关于任务的高级语义知识。该研究展示了低级技能如何与大型语言模型相结合,以便语言模型提供有关执行复杂和时间扩展指令的过程的高级知识,而与这些技能相关的值函数提供了将这些知识连接到特定物理环境所需的基础。

研究者将大型语言模型(LLM)与机器人的物理任务组合到一起时用到了这样一个原则:除了让 LLM 简单地解释一条指令之外,还可以用它来评估单个动作对完成整个高级指令有帮助的概率。简单来说,每个动作可以有一个语言描述,我们可以通过 prompt 语言模型让它给这些动作打分。此外,如果每个动作都有一个相应的 affordance 函数,可以量化它从当前状态(比如学到的价值函数)获得成功的可能性。两个概率值的乘积就是机器人能成功地完成一个对于指令有帮助的动作的概率。根据这个概率将一系列动作排序,选取概率最高的一个。

下图示例展示的是机器人帮助拿苹果: