以往我们说,云计算颠覆性地改变了人类的生活和工作方式。现在,人们对于云计算性价比的追求越来越高。

企业用户希望通过云来获得更强的数据处理能力、更快的响应速度和更低的成本,且不增加能耗。如何实现“高性能、高安全性和低成本”一个都不能少呢?作为连续11年在云基础设施和平台服务Gartner魔力象限 (CIPS) 被评为领导者的厂商,亚马逊云科技的看法是:芯片创新是最底层的创新,是最具颠覆性的创新,也是改变云计算游戏规则的能力。

亚马逊全球副总裁、亚马逊云科技大中华区执行董事张文翊曾表示,云计算技术和服务的实际效果,主要基于底层的性能。发生在底层的创新,往往是最具颠覆性的。系统架构和芯片这种底层的创新升级,不仅能让客户的云体验有质的跃升,还能改变传统IT行业的游戏规则。

第五代虚拟化芯片Nitro

首先,云服务的计算资源如何才能更好地满足用户的工作负载要求,让用户不必担心云计算资源底层的网络、存储和安全控制的复杂性?Amazon Nitro就是亚马逊云科技给出的最佳答案。

从2017年起,为了让用户的应用能够获得更佳的性能表现,亚马逊云科技自研了Amazon Nitro 系统,将计算、存储、网络等传统负载Offload到专属硬件层面,大幅提升虚拟化及客户实例的性能。Nitro系统全面提升EC2实例的安全表现,并能更好地提升计算、存储和网络的性能。Nitro系统还支持裸金属EC2实例,能够让所有的服务器资源都充分调用到客户的负载上去。

在日前召开的2022亚马逊云科技 re:lnvent 全球大会上,Amazon Nitro v5重磅发布。与第四代相比,第五代Nitro芯片拥有两倍的晶体管数量,两倍的计算性能,两倍的PCI-E带宽,同时内存访问速度提升50%。Nitro v5支持每秒增加60%的数据包,并减少30%的延迟,同时每瓦性能提升40%。第五代Nitro提供专门的I/O功能模块,进一步降低EC2实例的性能负担,从而将更多资源用于工作负载。

Amazon EC2 C7gn实例是首个基于Nitro v5的实例,为网络密集型工作负载提供极佳性能,具有更高的网络带宽、更高的数据包转发性能和更低的延迟。与当前一代网络优化型实例C6gn相比,C7gn为每个CPU提供了多达2倍的网络带宽,从100Gbps提升至200Gbps,同时将每秒数据包转发性能提升50%。

高性能计算服务器CPU芯片Graviton 3E

基于对客户工作负载的深刻理解,亚马逊云科技逆向设计了多种更具有针对性和特定性的自研芯片,不断突破行业传统认知和习惯,加速云计算产业的高速发展。比如基于ARM的Amazon Graviton自研芯片,就打破了传统IT行业依赖独立芯片制造商的格局。为进一步提升性能并降低成本,让更多人有机会上云,亚马逊云科技在去年推出了性能较前代提升25%,能耗降低60%的Graviton 3。而在今年的re:lnvent 全球大会上,亚马逊云科技又推出了Amazon Graviton3E芯片。

Amazon Graviton3E是Gravtion3芯片的定制产品,针对高性能计算工作负载中常见的浮点和矢量运算进行了优化与Gravition3相比,Graviton3在线性代数运算基准测试HPL中性能提升35%;分子动力学测试Gromacs中性能提升12%;金融期权定价工作负载测试中性能提升30%。

Hpc7g实例采用了Graviton3E芯片,与采用Graviton2处理器的当前一代C6gn实例相比,Hpc7g实例的浮点性能提高了2倍,与当前一代Hpc6a实例相比性能提高了20%,让客户能够在多达数万个内核的高性能计算集群中进行复杂的计算。Hpc7g实例还提供高内存带宽和200Gbps的EFA (Elastic Fabric Adapter,弹性结构适配器)网络带宽,可以更快的运行并完成高性能计算应用。客户可以通过开源的集群管理工具Amazon ParallelCluster使用Hpc7g实例,与其它实例类型一起配置Hpc7g实例,这让客户在同一个高能性计算集群中灵活运行不同的工作负载类型。

AI推理芯片Inferentia和训练芯片Trainium

除了 Amazon Graviton系列外,亚马逊云科技还自研了面向机器学习推理和训练的加速芯片Amazon Inferentia和Amazon Trainium,为客户提供更好的性价比。

大型语言模型的出现推动深度学习进入了下一个阶段,但庞大的参数量加大了推理所需的算力和成本。2019年,亚马逊云科技的Inferentia芯片第一代出现在Inf1实例上,为用户提供了性价比优于GPU实例的选项。当时深度学习模型大多是数百万个,而如今某些深度学习模型的参数已经超过数百亿,比如百度的PLATO-XL对话生成模型、亚马逊的AlexaTM等。

为此,亚马逊云科技推出了全新的Inferentia2芯片,最高可支持到1750亿参数的大型深度学习模型。基于Inferentia2芯片的Inf2实例也首次支持分布式推理,将大型模型分布到多个芯片上进行推理。与上一代Inf1实例相比,Inf2可以提供高达4倍的吞吐量和十分之一的延迟,与GPU实例相比更是将能效提高了50%之多。

在AI大模型训练中,从传统的几千参数的Backprop,到百万级的Bert,十亿级的GPT-3、PAML,甚至超大规模的Switch-C,都在对计算芯片提出新的需求,同时在数据网络层面,计算芯片也正面临着新的挑战。

面向下一代计算、内存加速、并行训练及低网络延迟的AI 训练需求,亚马逊云科技推出了Trn1n实例,针对Trn1实例进行了网络优化,增加了1600Gbps EFA 网络功能,使之能够更快地面对超大规模分布式模型训练场景。

网络协议再创新

为了改善高性能计算常用的EFA网络接口性能、Amazon EBS块存储网络性能,以及ENA网络性能,亚马逊云科技还对核心的底层SRD网络协议进行了创新,同时基于SRD网络协议正式推出了高速虚拟网卡ENA Express。

相比于传统的 TCP 单路径路由网络,亚马逊云科技自己的 SRD(Scalable Reliable Datagram )协议使用了多路径路由,这项协议不按顺序传输数据包,但可以在数据包乱序到达时进行整理。

SRD将“以微秒而不是毫秒”重新传输丢弃的数据包,并加速托管在亚马逊云科技上的网络。其性能优于TCP,因为它基于Nitro硬件进行了调整和优化,亚马逊云科技通过 Nitro 系统将计算、网络和存储事务与主机隔离开来,以提升硬件性能。

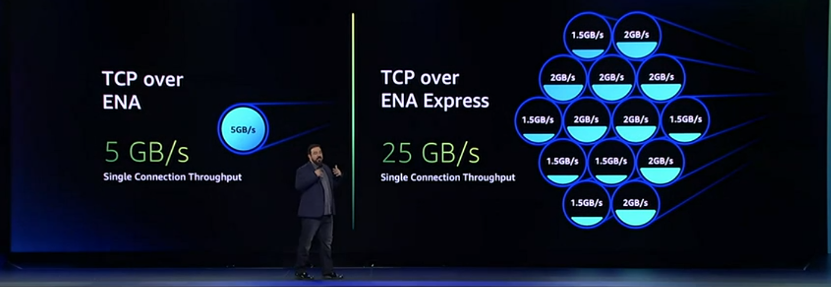

ENA Express以为 Elastic Fabric Adapters 提供支持的SRD协议为基础,将流量的 P99 延迟减少了50%,将 P99.9 延迟减少85%(与 TCP 相比),同时还将最大单流带宽从 5Gbps 到增加到了 25Gbps,可以获得更多的每流带宽和更少的可变性。

结语

在云计算新的发展阶段,云基础设施部署所依赖的芯片,已经成为了各大云厂商提升“内功”的必争之地。亚马逊云科技在虚拟化芯片Nitro、服务器芯片Graviton、AI/ML芯片三条产品线上持续发力,一次又一次地突破技术边界,旨在不需要牺牲安全的情况下,减少成本,同时提高性能,让客户应用更好地在云上持续发展。