运动中的人类新视图合成是一个极具挑战性的计算机视觉问题。

以往的2D图片转三维模型都是在静态的情况下,但如果输入的是一段人类运动的视频,该如何生成自由视角的视频?

如果这个问题解决了,那就可以在AR/VR应用中的自动化实现虚拟化身建模。

现有的一些研究工作通常需要复杂的任务设置,包括多个输入视频、三维监督或预训练模型,这些苛刻的要求都限制了模型的泛化性,无法很好地推广到新用户的输入上。

为了解决这些局限性,Meta提出了一个新视图合成框架HVS-Net,可以从任意人类的未见视图中生成逼真的渲染。视图的捕获过程只需要一个具有稀疏RGB-D的单视图传感器,类似于一个低成本的深度相机。

论文链接:https://www.phongnhhn.info/HVS_Net/img/HVSNet.pdf

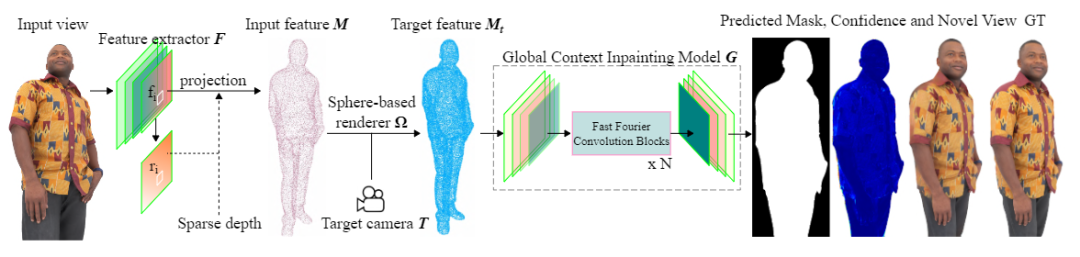

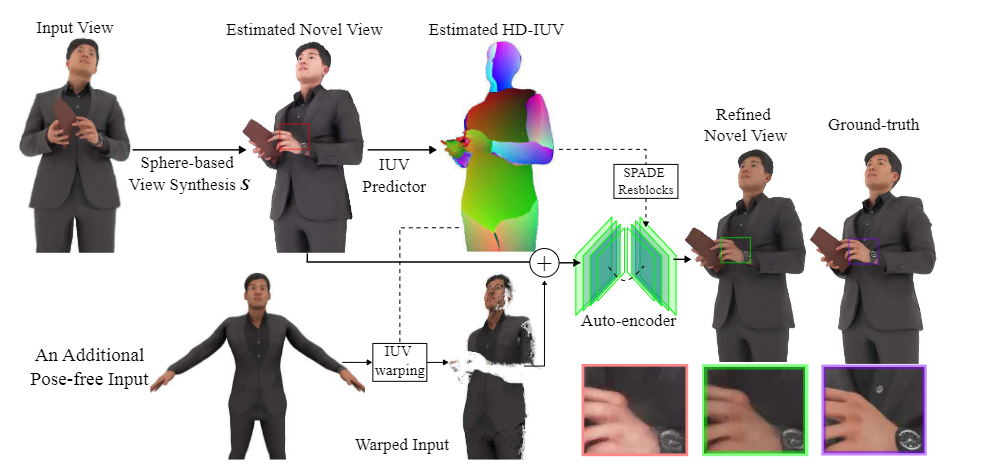

论文中提出了一个架构来学习基于球体(sphere-based)的神经渲染所获得的新视图中的稠密特征,并使用全局上下文绘画模型来创建完整的渲染图。

此外还包括一个增强网络(enhancer network)利用整体保真度,甚至在原始视图的遮挡区域,产生具有精细细节的清晰渲染。

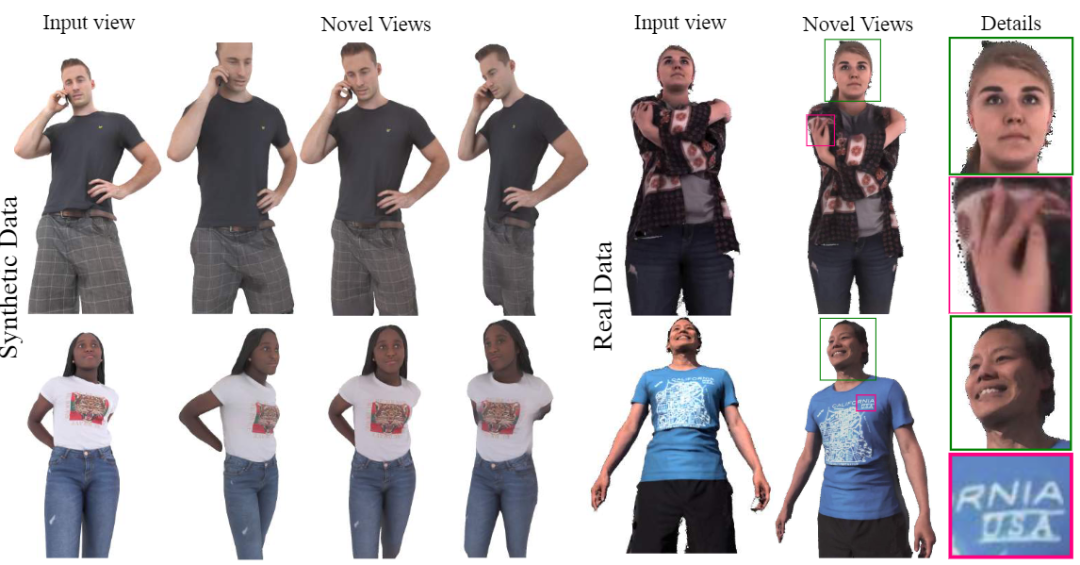

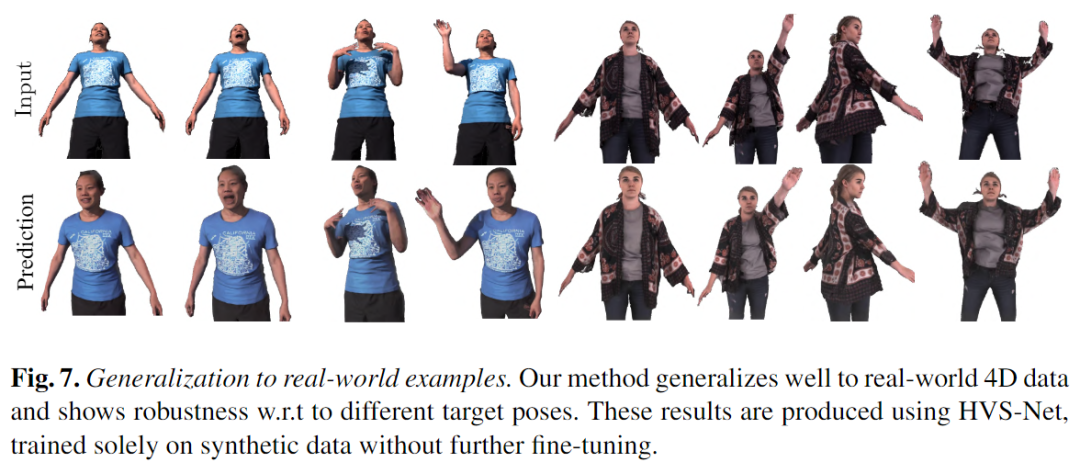

实验结果显示,该方法在单一稀疏的RGB-D输入的情况下仍然可以生成高质量的合成和真实人类的新视图,并且能够泛化到未见过的新人物、新的姿势并忠实地重建面部表情。

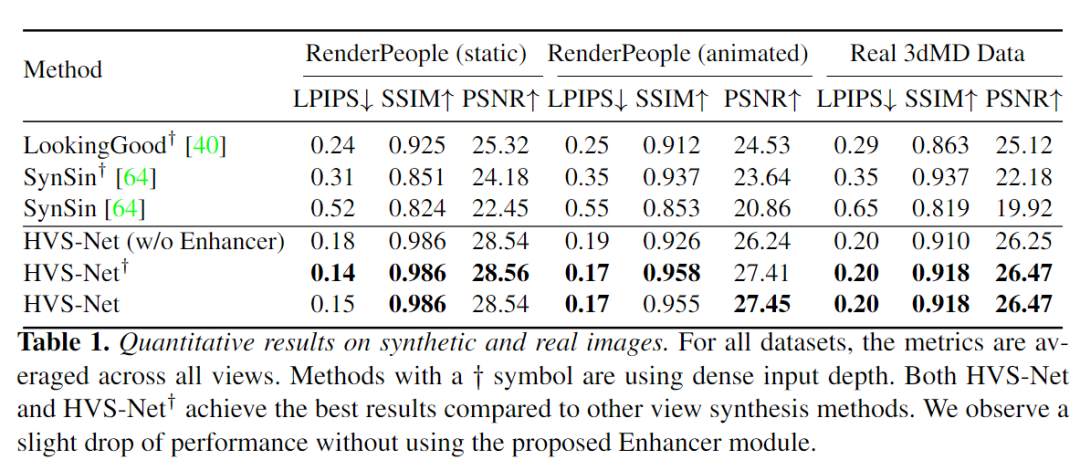

该方法不仅优于先前的人类视图合成方法,而且对不同稀疏度的输入都具有鲁棒性。

一键生成虚拟化身

刚性物体(rigid objects)或动态场景的新视图合成是最近非常活跃的研究课题,在各种任务中都取得了极大的性能提升。

但对运动中的人类的新视图进行合成需要处理具有各种变形的动态场景的方法,特别是在那些具有精细细节的区域,如面部或衣服。

除此之外,常见的动态合成模型通常依赖于多视图输入,需要多个相机拍照,更多的相机参数,推理时间也很长(每帧可能需要几分钟)。

Meta提出的人类新视图合成网络HVS-Net仅使用一个消费级RGB-D传感器就能生成高保真的衣着人类的渲染图像。

网络有如下5个设计目标:

1、在测试时能够对新的人物进行泛化,无需重新训练;

2、能够处理训练集中不包含的新姿势;

3、无论是来自物体还是人物自身的遮挡,模型都应该能够处理;

4、能够捕捉面部表情;

5、给定一个单流、稀疏的RGB-D输入,能够实时生成高保真的图像。

HVS-Net将人的上半身的单一稀疏RGB-D图像和目标摄像机姿势作为输入,并从目标视角生成高分辨率的渲染。

与以前的方法相比,第一个关键区别是HVS-Net利用深度作为一个额外的输入流。

虽然输入的深度是稀疏的和有噪声的,但它仍然使模型能够利用输入视图中的信息,从而简化了新视图的合成。

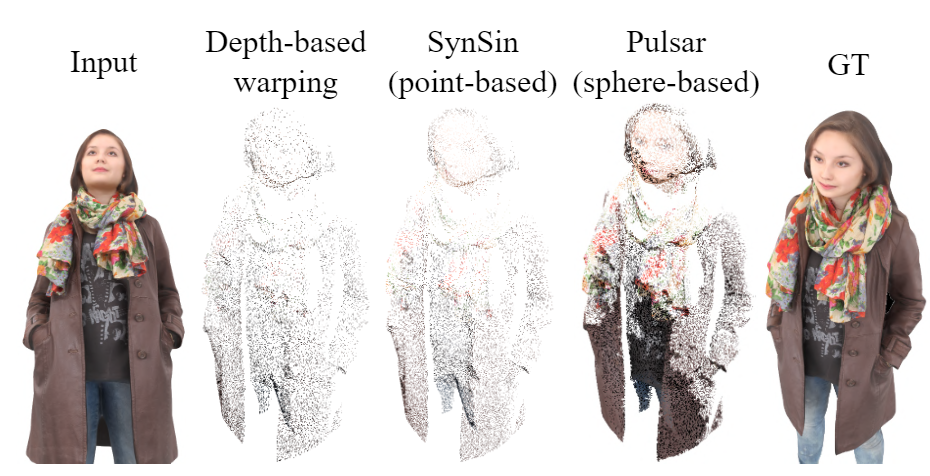

为了说明输入的稀疏性,研究人员选择了一个基于球体的神经渲染器,与简单地从一个视图到另一个视图进行几何扭曲相比,该渲染器使用一个能够学习的半径来创建一个更密集的、扭曲的图像。

即使是被原始传感器正确观察到的像素也是稀疏的,从一个视角看两个相邻的像素,无论它们之间相差多少,只能得到它们各自深度的信号。

这也意味着,如果是从侧面来看,两个像素的深度差距会更大,但这些「间距」不是无限大的,所以可以通过基于球形的渲染器来解决这个问题。

考虑到从原始视点出发的每个像素的深度以及相机参数,这些点自然可以被投影到一个新的视图,这也使得使用基于深度的扭曲或可微分的点或球体的渲染器是开发视图合成的第一步的最佳选择。投影的过程能够自动纠错(除了传感器的噪声),且不受训练误差的影响。

视图合成模型生成目标视图的稠密特征,并使用全局上下文绘画网络渲染来自目标摄像机视图的结果RGB图像。

当与编码器-解码器架构结合并进行端对端训练时,该方法能够合成未见过的个体的新视图,并对主要输入视图中不可见的区域进行绘制。

虽然这种方法在最小的遮挡情况下效果很好,但在有严重遮挡的情况下,无论是人的手在身体前面移动或者拿着某个物体,都很难产生高质量的渲染。

因此,研究人员建议用户额外输入一个无遮挡图像,并通过在两个输入之间建立精确的稠密对应关系,将其扭曲成目标的新视图。

通过训练一个紧凑的Enhancer网络来完善最初估计的新视图,预测新视图和无遮挡图像之间的对应关系,使用一个新的HD-IUV模块对渲染图进行精炼处理,可以呈现出更清晰的结果。

然后利用生成的图像和ground-truth数据对之间的光度(photometric)损失来端到端地训练整个pipeline

此外,模型还使用立体渲染来鼓励近距离的视点之间的视图一致的结果。

为了更好地训练HVS-Net,还需要依靠高质量合成的人类扫描结果,从不同的角度进行捕捉动画和渲染。

这项工作的一个关键贡献是,模型可以很好地推广到由3DMD扫描系统捕获的真实数据,其面部或衣服的细节还原水平之高是前所未有的。

在实验部分,研究人员仅使用合成数据集RenderPeople对该方法进行训练,数据集中的人物穿着各种服装,在某些情况下拿着杯子、袋子或手机等物体,虽然涵盖了各式各样的外观和物体互动情况,但所有这些数据都是静态的,所以姿势空间的覆盖率是不足的。

研究人员通过引入额外的姿势变化来增强数据集,即对所有的网格进行非刚性配准(non-rigid registration)后使用一组预定义的动作将之制作成动画。

最后使用Blender为每帧25个视图合并一套高质量的标准RGB-D渲染图以及对应的IUV图。

除了合成测试集,研究人员还收集了一个真实世界的测试数据集,其中包括运动中的人物的3dMD 4D扫描图。3dMD 4D扫描仪是一个全身扫描仪,可以在60Hz的频率下捕获未配准的体积点云。

真实数据集仅用作测试,以了解该方法在处理合成数据和真实数据之间的领域差距上的能力。

3dMD的数据不包括物体的相互作用,但一般来说噪声比较多,而且有复杂的面部表情。

实验结果证实了HVS-Net中球体半径预测器的有效性,使得模型在输入点云密度方面更加稳健。

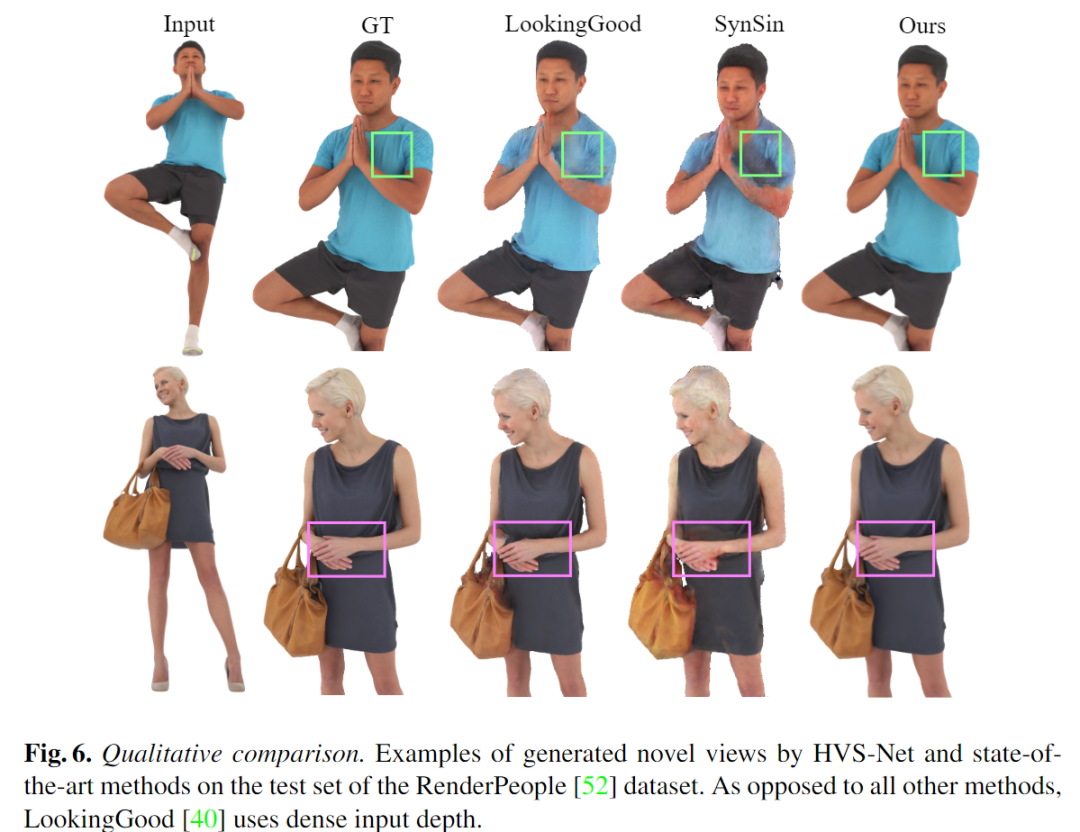

作为对比,尽管使用密集的深度图作为LookingGood的输入,但如果目标姿势与输入视点有很大偏差,该方法仍难以产生真实的结果,而SynSin不仅在遮挡区域表现不佳,而且在人的脖子周围也产生了伪影。

相比之下,HVS-Net方法不仅能够呈现可信的、真实的新视图,而且还能创造出忠实于输入视图的视图,重点是,HVS-Net在输入信息更少的情况下对两个主体的头发进行相当准确的预测。