最近,LeCun接受了ZDNet的采访,表示当今的大多数人工智能方法永远不会带来真正的人工智能。

而采访中最为精彩的部分,当然还是和老对手们的隔空炮火。

LeCun语不惊人死不休,犀利表示:Schmidhuber就是个插旗的,而Marcus根本不是搞AI的,他只是个心理学家。

LeCun怼老对手,语出惊人

在6月,Meta的首席人工智能科学家Yann LeCun曾经发表了一篇60页长文,描述了他认为有望在机器中实现人类智能水平的方法。

论文地址:https://openreview.net/pdf?id=BZ5a1r-kVsf

他在论文中暗示道:今天的大多数人工智能大项目将永远无法达到人类的水平。

而最近,LeCun在接收ZDNet采访时表示:即使是目前深度学习领域最成功的研究途径,他也抱有极大的怀疑。

「我认为它们是必要的,但还不够。」他说。

其中就包括大型语言模型,比如如基于Transformer的GPT-3及其同类。正如LeCun所描述的那样,Transformer的信徒们相信:「只要我们把一切都标记化,然后训练巨大的模型来进行离散的预测,人工智能就会以某种方式从这里出现。」

「他们没有错,」他说,「从某种意义上说,这可能是未来智能系统的一个组成部分,但我认为它缺少必要的部分。」

对于在完美使用卷积神经网络的学者来说,这种批评真是够惊人的。

在人工智能的许多非常成功的领域中,LeCun看到了缺陷和局限。他对于强化学习领域,他也持同样的观点:跟这些领域一样,强化学习也永远不够完美。

虽然DeepMind的David Silver等研究人员已经开发出了掌握国际象棋、将棋和围棋的AlphaZero程序,但LeCun说:「我们的大部分学习过程,不是通过实际行动来完成,而是通过观察来完成的。」

Lecun已经62岁了,在这个领域浸淫了几十年后,他认为自己有必要对许多人做出提醒:你们急匆匆走上的,是一条盲道。

「有很多人在讨论,我们应该做什么来实现人类水平的人工智能。很多人的说法是错误的。」

「我们的智能机器还没有达到像猫一样具有常识的地步,」他说。「我们为什么不从这里开始呢?」

他已经放弃了在预测视频中的下一帧上使用生成网络的信念。「这是一次彻底的失败。」

在他眼里,那些「宗教概率论者」应该被谴责——在这些人看来, 概率论是可以用来解释机器学习的唯一框架。

在LeCun看来,纯粹的统计方法是不可能的。「要让一个世界模型完全服从概率论,这要求也太高了;我们不知道该如何做到。」

LeCun认为,不仅是学术界,工业上的人工智能也需要重新思考。在他看来,自动驾驶汽车公司,比如Wayve,一直「过于乐观」,因为他们认为只要把数据扔到大型神经网络里,就可以学到任何东西。

「我们完全有可能拥有没有ADAS(高级驾驶辅助系统)的五级自动驾驶汽车,但不得不对它进行工程设计。」

他认为,这种过度设计的自动驾驶技术,会和所有因深度学习而过时的计算机视觉程序一样,非常脆弱,非常易碎。

「最终,会有一个更令人满意、更好的解决方案,这个系统能更好地理解世界的运转方式。」

LeCun还提出了重要的一点:所有AI都面临着同样的基本问题,特别是如何测量信息。

「你必须退一步说,好吧,我们建了这个梯子,但我们的目的是去月球,这个梯子不可能把我们送上月球。」LeCun说他希望促使人们重新思考基本概念。「我的意思是,我们需要建造火箭,我不能告诉你建造火箭的细节,但这是基本原则。」

好了好了,采访中最喜闻乐见的嘴炮part来了。

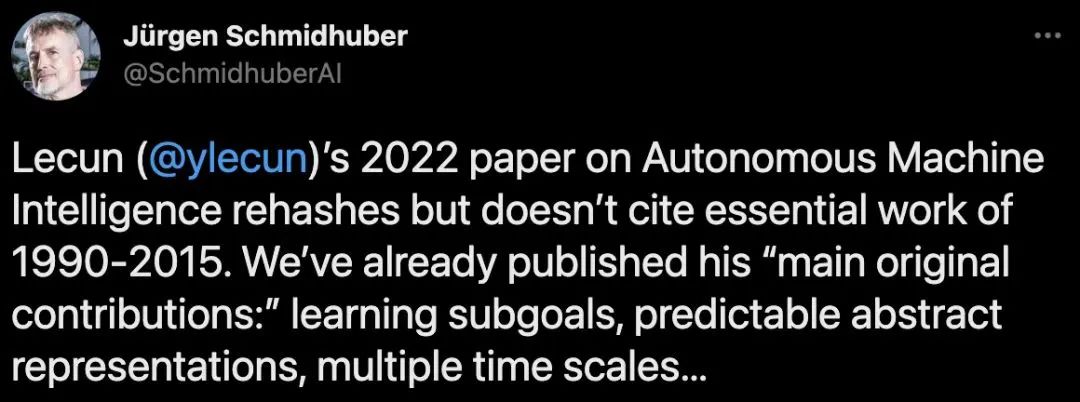

首先,被LeCun炮轰的对象是Dalle Molle人工智能研究所主任Jürgen Schmidhuber。Schmidhuber曾怒怼LeCun剽窃了自己的学术成果。

Le Cun表示,Schmidhuber在社交网络上发表的观点,根本不是事实。他只是在插旗:有了一个想法建议你怎么做,然后写下来,没有任何实验,没有任何理论。

像他这样跟玩儿似的做法,和真正的做理论(说明它为什么有用,然后付诸实践),这其中有很大的区别。这之中有一个完整的链条。

而在Schmidhuber看来,谁第一个有这个想法,谁就占头功,这很荒谬。

他说我应该引用的论文中,并不包含我论文中的任何主要观点。他在GANs和其他事情上也是这么做的,结果根本不像他说的那样。插旗很容易,要做出贡献可就难多了。

顺便说一下,对于这篇论文,我明确表示了这不是一篇通常意义上的科学论文,它更像是一份关于走向何处的立场文件。我并不要求我在论文中写的大部分内容有任何优先权。

而LeCun的老对头,纽约大学教授Gary Marcus自然也逃不过他的炮火。

在谈到通过在神经网络上添加符号推理来推动人类水平的人工智能时,LeCun表示自己不知道如何做到这一点。

他表示,自己在论文中介绍了一种方法,可以在没有明确符号操作的情况下就能做到这一点。这就是Gary Marcus的做法。

接着,LeCun爆出神评论——

「Gary Marcus不是一个搞AI的,他是一个心理学家。他从未对人工智能做出任何贡献。他在实验心理学方面有不错的成果,但他从来没有写过一篇关于人工智能的同行评审论文。没错,有些人就是这样。」

Marcus大翻老黄历:LeCun说的那些,我早就说过了

ZDNet的专访头一天发出,Gary Marcus的回怼文章第二天就来了!

Marcus发文表示:

62岁的知名深度学习先驱Yann LeCun,纽约大学教授,图灵奖得主,Meta公司的首席人工智能科学家,近年来对深度学习的新想法是一个接一个。

就在六月初,LeCun发表了一篇被广泛讨论的「宣言」,以及一篇对我的工作的评论。但是他所说的有多少是真正的新东西呢?

昨天那篇ZDNet对LeCun的采访,我看了之后很震惊,因为LeCun所说的几乎所有内容,我之前都说过,有些几乎是一字不差,其中大部分是在2018年一篇名为《Deep Learing:A Critical Appraisal》的论文中,LeCun当时说我讲的「大部分是错误的」。

论文链接:

https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf

那么他2022年讲了什么?我之前在2018年甚至之前又讲过什么?

我只举几个例子。

LeCun:今天的人工智能方法永远不会导致真正的智能

马库斯:如果我们要实现通用人工智能,深度学习必须得到其他技术的补充。

LeCun:目前的深度学习模型可能是未来智能系统的一个组成部分,但我认为它缺少必要的部分。我认为它们是必要的,但还不够。"

马库斯:尽管我勾勒了所有的问题,但我不认为我们需要放弃深度学习。相反,我们需要重新认识它:不是作为一种通用的工具,而只是作为众多工具中的一种。"

LeCun:强化学习也永远无法满足智能需求。

马库斯:将深度强化学习与诱导概念联系在一起是一种误导。

LeCun:我认为AI系统需要能够推理;

Marcus:那些与分类关系不大、与常识性推理关系较大的问题,基本上不在深度学习的范围内,而且就我所知,深度学习对这类问题没有什么帮助。

LeCun(2022):你必须退一步说,好吧,我们建了这个梯子,但我们想去月球,这个梯子不可能把我们带到月球。

马库斯(2012):套用一个古老的寓言,Hinton通过深度学习造了个更好的梯子;但一个更好的梯子不一定能让你上月球。

从来没有人比LeCun更仔细地重述我讲过的论点,而不注明出处。

让一个这么厉害的人,几次三番地讲出我之前早就说过的观点,这算不算我又一次赢麻了?

如果说上面这段属于是为自己争取Credit的话,Marcus博客后半部分的内容看起来就完全是针对LeCun本人了。

比如Marcus说,LeCun不想让人发现说过我曾经说过的观点,也不对这些观点分享任何credit,这是违反学术礼仪的。

另外,为了孤立我,他在采访中对我进行了无端的、完全不实的抨击,声称「Gary Marcus不是AI研究人员,他是一个心理学家,从未对AI做出任何贡献。他在实验心理学方面做了非常好的工作,但他从来没有写过一篇关于AI的同行评议的论文」。

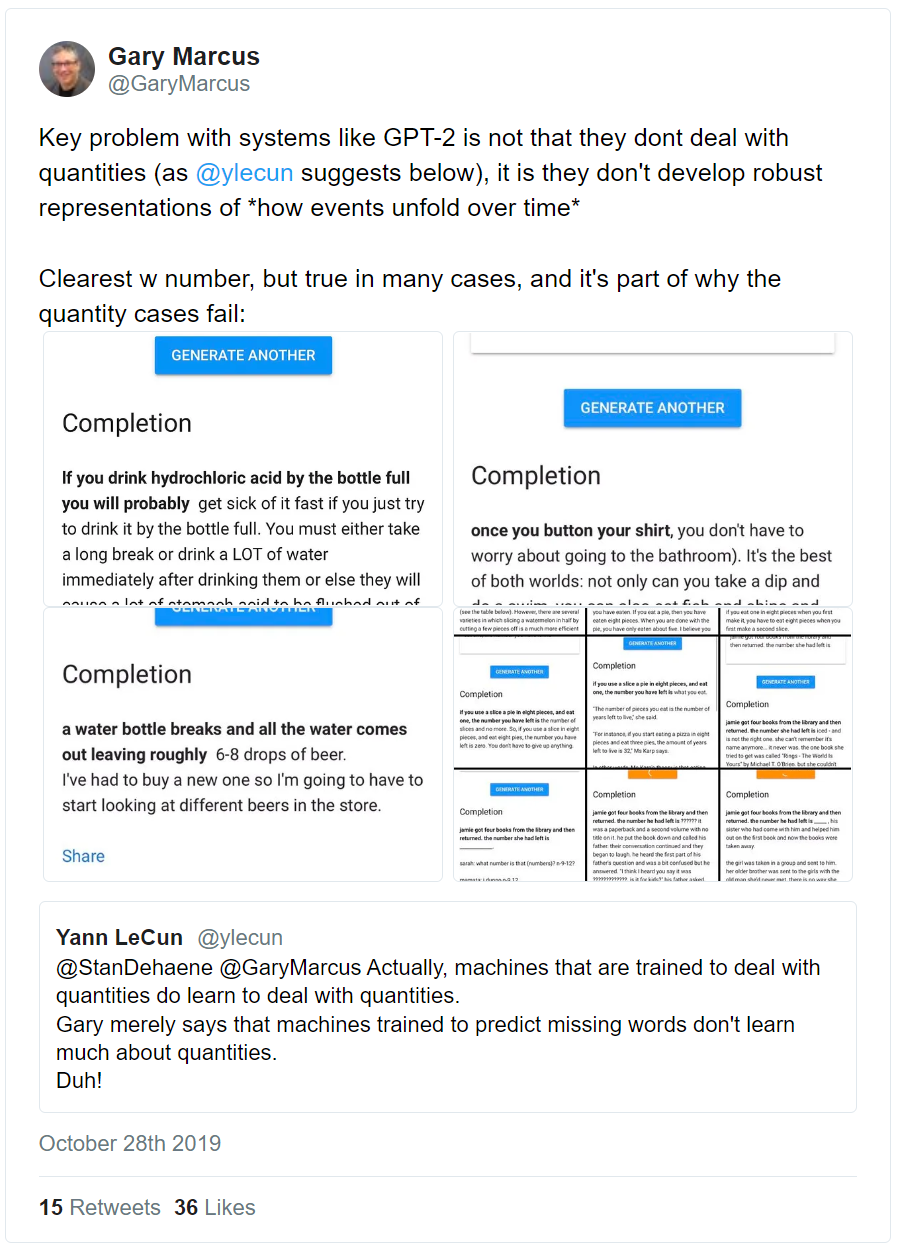

这完全是错误的。实际上,我在AI领域发表了大量的文章,有些是在同行评议的期刊上,有些不是。我最重要的人工智能论文,对神经网络做了实验性工作,在1998年就预见到了分布转移和异常值的挑战,这些问题到现在还在困扰着Bengio等人。

也许我最有影响力的AI工作恰好不是一篇期刊文章,而是2001年由MIT出版的《代数思维》一书。LeCun在ZDNet的访谈中的几乎每一个观点,在这本书里都有提及。

LeCun真正的意思是,他没读过这本书,读都没读过,就认为没有影响的想法是可笑的。

LeCun的说法过于离谱,以至于不少人在访谈发出后,都来为我说话;ZDNet也立即发布了更正说明。

Vmind.AI的首席执行官Miguel Solano发推表示对我表示支持。

Henning Schwabe 更是直接讲LeCun的访谈过于自大,而自大正是理性的敌人:

为了建立自己的学术地位,人们有时会对credit做出不负责、不道德的行为。哈罗德·布鲁姆曾经写过一本书,他称之为《影响的焦虑》。直到今年,我还没有在像LeCun这样荣誉等身的人身上看到这样的倾向。但从今年开始,我从他身上看到了一次又一次。

LeCun最近的每篇论文和文章都以自己的方式表现出对过去的否定。

关于符号操作的问题。LeCun花了不少时间来抨击符号操作,他的合作者之一Hinton更是如此,他们在2015年联合撰写的一篇深度学习评论中说, 「需要新的范式来取代基于规则的符号表达的操作」。

如今,LeCun却在认可符号操作了,并表现得好像之前的抨击不存在一样。

甚至斯坦福大学人工智能教授克里斯托弗·曼宁都感到震惊。

LeCun最近的另一篇文章涉及到一个重要的问题,大型语言模型是否真的在通往AGI的正确道路上,模型是否真的可以仅从语言中学习到足够的知识。

LeCun和他的合作者Browning提出了一个强有力的理由,即仅有语言输入(即GPT-3的训练对象)是不够的.

他们写了一篇名为《AI And The Limits Of Language》的文章,认为 「仅靠语言训练的系统永远不会接近人类的智慧,即使从现在开始训练到宇宙的尽头也不行。」

但这个观点又是我在2020年2月在一篇名为《人工智能的下一个十年》的arXiv预印本文章中就提出来的。

「等待认知模型和推理从越来越大的训练语料库中神奇地出现,就像是在等待一个奇迹......」

这几乎就是LeCun和Browning的结论。

我之前早就说过,大型语言模型的问题在于缺乏认知模型,光靠喂语料训练是达不到智能模型的。

然后LeCun说我现在才说这些已经为时已晚:

我先提出的观点,他现在发现我说的对,就宣称这个观点是他先提的,我还能说什么呢?

而且现在看来,远不只是我一个人对LeCun的大包大揽有意见。

早先,LeCun那个「宣言」文刚发出来时,就有德国计算神经学家、AI研究人员Patrick Krauss 发推「恭喜」,看起来我们离AGI只差两个东西,一是常识、二是LeCun的世界模型。

我很难看出LeCun最近的一连串行动中到底有什么新东西,所以我昨天在Twitter上要求他解释。

到目前为止,他还没有回应。