据研究表明,在数据分析的整个过程中,数据准备会占大约80%的时间。怎样把数据收集起来,并确保数据可直接用于分析展示,是最麻烦、最耗时的事情,这在企业级的数据分析中也被称为是“最脏最累”的活。倘若数据未处理妥当,炫酷好看的可视化展示也毫无意义。

如果你参与过大型企业BI系统的建设,那就一定能有所感触。无数的决策分析系统成为临时的“政绩工程”,一时名声大噪之后却无人问津,大多因为后续数据不准确,无法真正为业务、管理提供实质的服务。这实则为数据分析项目建设的悲哀。

做好数据准备、保证数据质量,都是数据资产管理的范畴。国际数据管理协会(DAMA International)在《DAMA数据管理知识体系指南(原书第2版)》一书中,将数据管理(DM)定义为“为了交付、控制、保护并提升数据和信息资产的价值,在其整个生命周期中制订计划、制度、规程和实践活动,并执行和监督的过程”。

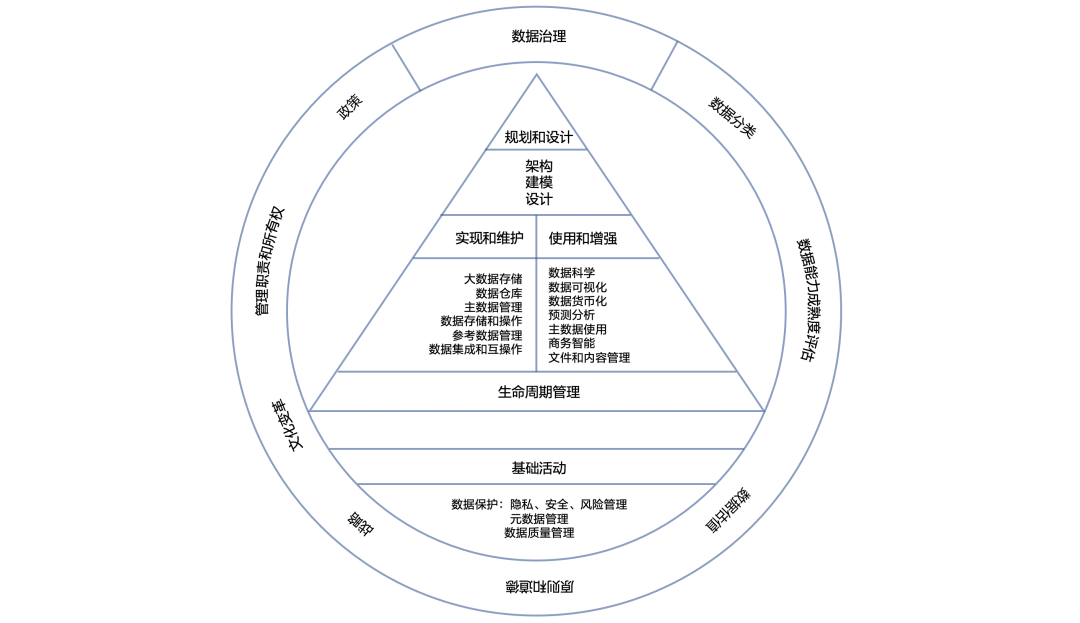

对于数据管理的职能,DAMA将其归为十一大类:数据治理、数据架构、数据建模和设计、数据存储和操作、数据安全、数据集成和互操作、文件和内容管理、参考数据和主数据、数据仓库和商务智能、元数据、数据质量,如图1所示。

▲图1 DAMA数据管理框架

其中,数据架构、数据建模和设计、数据存储和操作、数据集成和互操作、文件和内容管理、参考数据和主数据、元数据管理、数据仓库和商务智能属于“数据准备”的范畴,数据治理、数据安全、数据质量可以统一归类为“数据治理”。

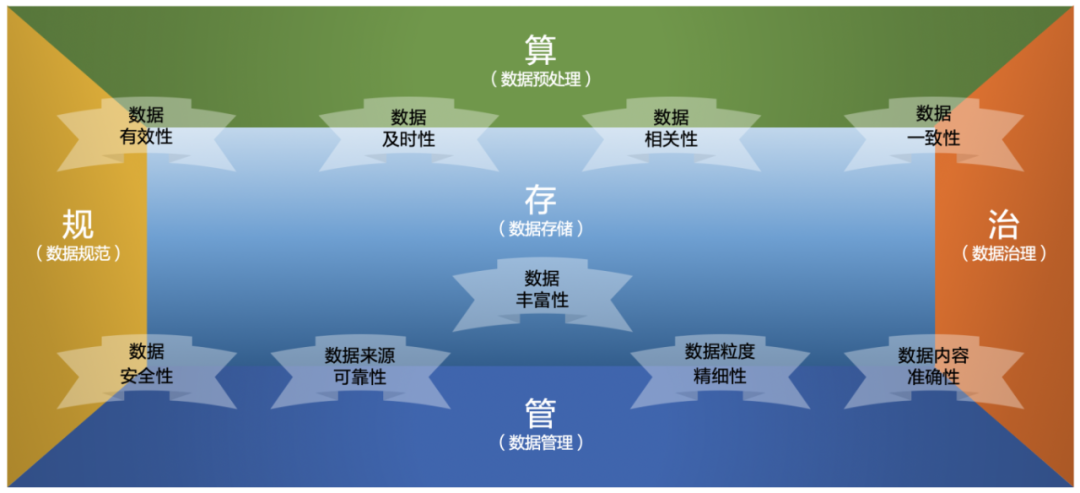

结合DAMA对数据管理职能的分类及内容,可将数据准备分为“管”“存”“算”个层面,将数据治理分为“规”、“治”两个层面,如图2所示。

▲图2 “管” “存” “算” “规” “治”

1.数据之“管”

数据之“管”指狭义的数据管理,是对不同类别的数据采取不同的数据管理模式。这里我们把数据分为四个层次:元数据、主数据、参考数据、一般数据(交易数据)。通过数据之“管”,来确保数据来源的可靠性、数据内容的准确性、数据安全性及数据粒度的精细性。

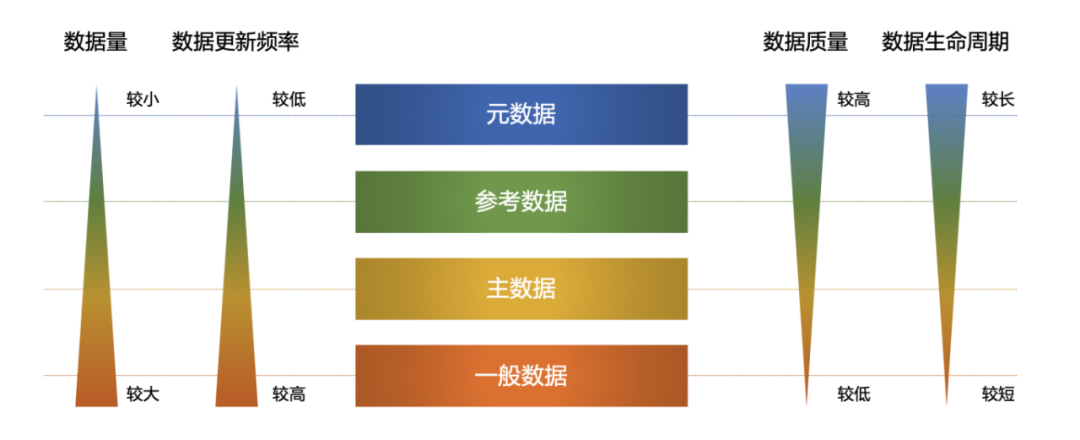

不同的数据,根据其特性在数据量、更新频率、数据质量和生命周期上有不同的特点。从数据的作用及管理的方式上来讲,我们把数据分为四个层次:元数据、主数据、参考数据、一般数据(交易数据),如图3所示。这里提到的数据之“管”,即指管理好这四个层次数据。

▲图3 数据层次

元数据(Metadata):通俗地说就是描述数据的数据,比如数据的名称、属性、分类、字段信息、大小、标签等等。要做好数据的管理,元数据起到了举足轻重的作用。

参考数据(Reference Data):是用于将其他数据进行分类或目录整编的数据,它定义了数据可能的取值范围,可以理解为属性值域,也就是数据字典。参考数据一方面有助于在TP(业务处理)侧提升业务流程的准确性,另一方面在AP(数据分析)侧规范数据的准确性,为多系统综合分析提供有利的保障。

主数据(Master Data):指具有高业务价值的,关于关键业务实体的权威的、最准确的数据,被称为“黄金”数据。通常用于建立与交易数据的关联关系来进行多维度的分析。

一般数据:也就是交易数据。相对来说,我们可以认为元数据、参考数据、主数据为静态数据,而一般数据则是动态数据。它一般随着业务的发生而变化,比如资金交易流水。

2.数据之“存”

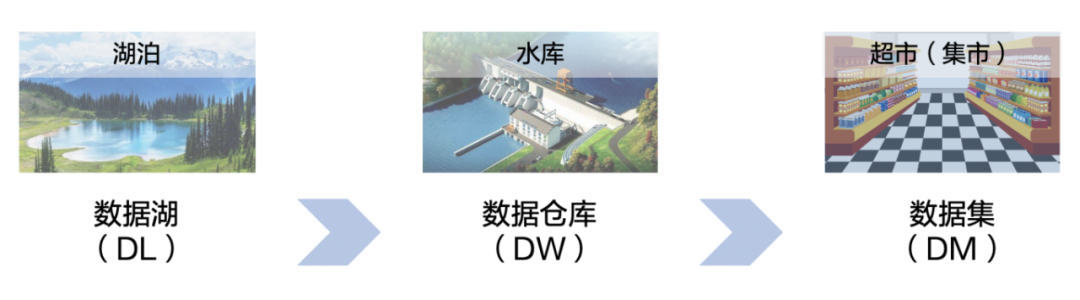

数据之“存”指数据存储,指通过技术手段将数据存储起来。涉及三个关键词是“数据湖”、“数据仓库”和“数据集市”。数据的有效性、及时性、相关性、一致性、安全性、准确性,其来源的可靠性、粒度的精细性,最终都会体现在“存”之上,具备上述条件的数据组合,帮助数据实现了其“丰富性”。

如果把数据比作是源源不断的水,那么,数据湖可以比作湖泊,数据仓库可以比作水库,数据集便是超市。水在不断的加工制造中,最后成为超市中的瓶装水供人直接食用,就好比原始数据经过加工处理最终成为数据集市中直接可用于分析的数据。如图4所示。

▲图4 数据湖、数据仓库和数据集

数据湖、数据仓库和数据集形成了数据存储的三个层次,三者层层递进,各自发挥着其不同的作用。数据湖为非结构化数据分析、机器学习、预测分析提供了丰富的数据土壤;数据仓库通过规范化的管理,为企业、组织系统化的规范数据体系提供了支撑;数据集则将数据场景化,让数据触手可得,实现即席分析。

数据湖(Data Lake,DL),是指一个集中化存储海量的、多个来源、多种类型数据,并可以对数据进行快速加工、分析的平台。数据仓库(Data Warehouse,简称DW或DWH),是为支持决策而产生的数据池,它是整个组织中的各级人员可能感兴趣的、当前和历史的所有类型数据的战略集合。

数据集市(Data Mart,DM),是满足特定的部门或者用户的需求,按照多维的方式进行存储,生成面向决策分析需求的数据集合。

3.数据之“算”

数据之“算”,指的是数据预处理之“算”。为了保证数据分析时数据可用、好用而对数据进行的加工。是指对数据的清洗和加工,包括简单的清洗和处理,也包括通过智能手段如借助算法模型对数据的清洗和加工。

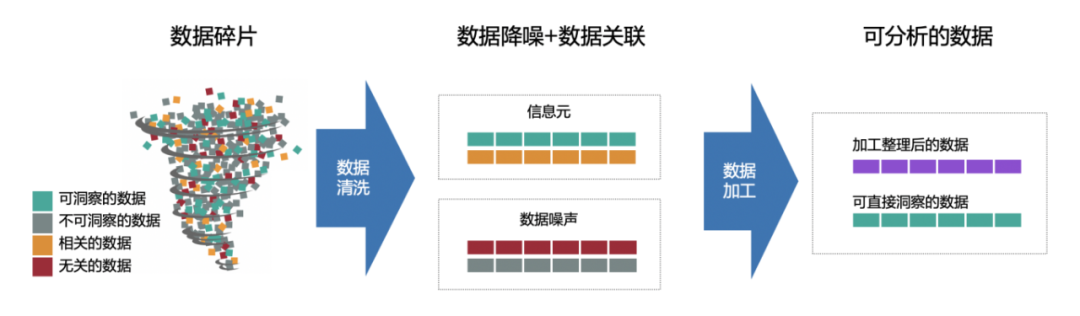

数据预处理的关键链路如图5所示。原始数据纳入数据湖的管理,通常混杂着各种数据。要防止数据湖变为数据沼泽,就需要将数据碎片分门别类,将不可洞察的数据和无关数据归类为数据噪声,留下可洞察的数据和相关的数据,我们称之为“信息元”。这类数据进一步通过数据加工形成整理后的数据,与可直接洞察的数据共同构成了可分析的数据。

▲图5 数据预处理

我们前面提到数据处理大约占了数据分析80%的时间,而在数据处理的过程中,数据清洗几乎会占据40%~70%的时间,且数据质量越差,其占比越高。数据清洗不能被孤立的看待,通过借助对元数据信息、数据分布情况的分析,甚至是根据分析结果的异常性来对数据进行有效的清理,会事半功倍。

所以,数据清洗和数据分析也是相辅相承,互相依赖、互相促进的。常见数据清洗包括对缺失值的处理和异常值的处理。

数据加工包括数据变换、数据结构转换、表间数据处理等。ETL(抽取Extract、转换Transform、加载Load)将上述数据清洗、数据加工的方法串联起来,形成完整的数据之“算”链路体系,是数据准备过程中最重要的一环。04数据之“规”

4.数据之“规”

指数据规范,包括对数据规范的制定和数据管理上的规章制度。“规”是确保数据有效性、安全性的基石。

数据的规范,包括两个层面。一方面针对数据本身,即数据标准;另一方面是数据管理上的规范和制度。我们可以通俗的理解为数据分析中的“法”。

数据标准

数据来源的多样化带来了数据的不一致性,多源系统数据整合的关键首先就是建立数据标准。数据标准的定义应遵循一定的原则,包括唯一性、统一性、通用性、稳定性、前瞻性、可行性“六大特性”和系列化、模块化“两化原则”。

基于上述特性和原则,数据标准从内容层次上可以分为语义标准、数据结构标准和数据内容标准。通过建立语义标准体系,保证整个组织层面关于数据分析的沟通“在一个频道上”;通过建立数据结构体系,统一数据资源目录及数据命名规则以确保数据规整、易查找;通过建立数据内容标准,根据业务梳理数据标签及数据描述规则以提升分析效率。

数据规范

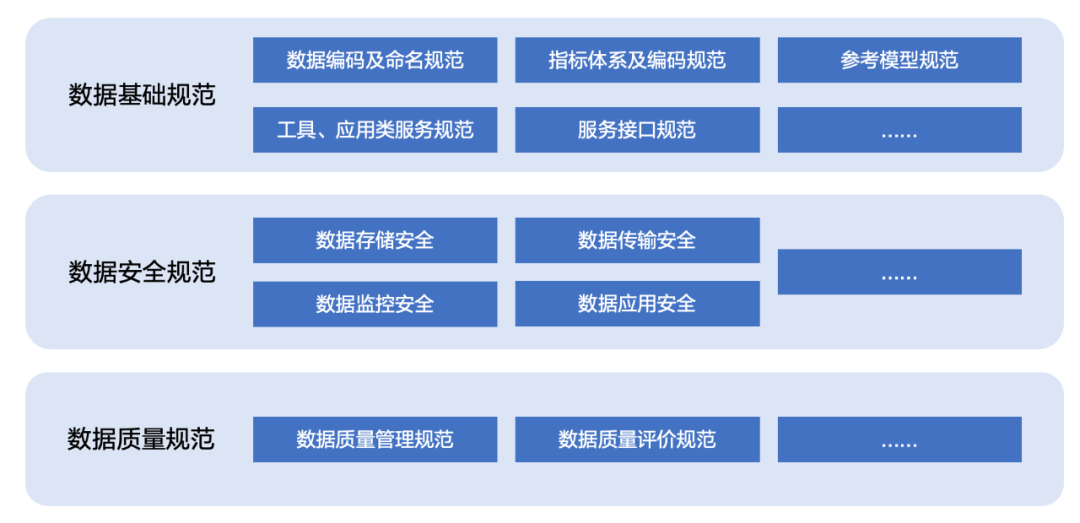

数据标准的执行,需要依赖制度的规范。无体系、无制度的管理无异于一般散沙。数据规范可以大致分为数据基础规范、数据安全规范、数据质量规范三大类,如图7所示。

▲图6 数据规范体系

5.数据之“治”

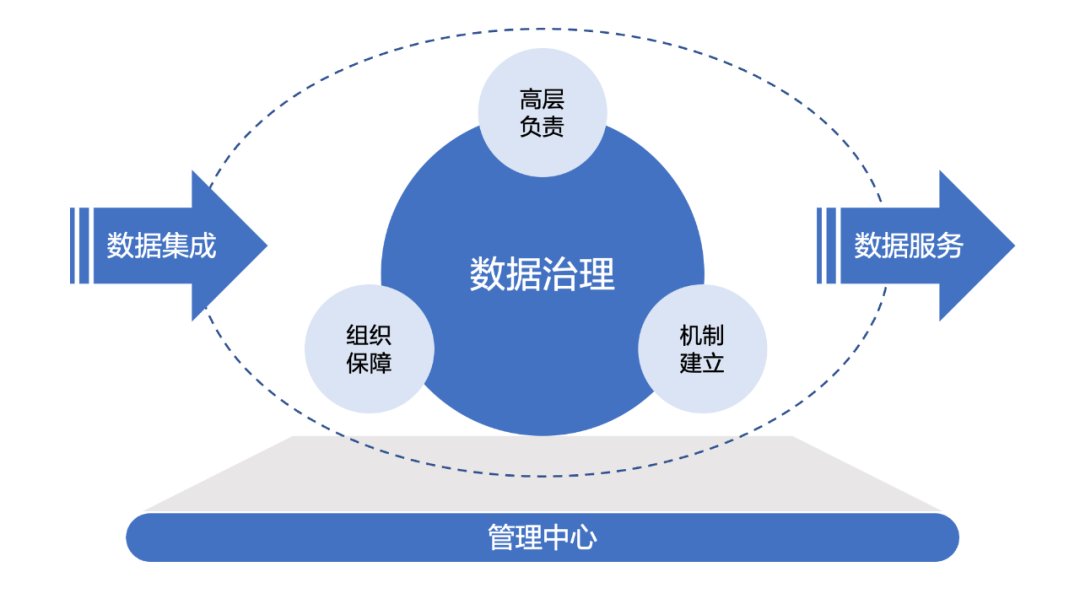

数据之“治”指狭义的数据治理,实质上指数据治理相关的一套方法及体系,包括了实践数据之“规”来确保数据质量的过程和方法。它不仅是技术上的治理工作,更是以有效满足组织各层级管理诉求的有效手段,它应该是包括数据、应用、技术和组织的四位一体均衡的治理体系。数据治理,最重要的目标就是保证数据质量,即数据的一致性及准确性。理论体系总是看起来完美无缺,但应用到实际中,

往往是“理想是丰满的,现实是骨感的”。先不说平台如何搭建、技术如何选择、如何保障安全性,真正深入到工作中,会发现,所有技术上的难题都不是最难的,如何说服各个部门主动配合数据收集工作,是最大的难点。所以,数据治理实质上并不只是技术问题,更是一个管理问题。做好数据治理,一定首先是自上而下的发起,其次是有足够的组织保障,再次是建立切实有效的机制体系。

▲图7 数据治理

数据治理需要依赖强大的统筹能力和管理能力才能得以实现,对于较大型的企业和组织来说,通常都是“吃力不讨好”的活,要真正通过数据治理做出成效,是一件非常困难的事情。所以,这里一再强调的重中之重便是“高层负责”。

高层负责是基础,切实有效地将数据治理落实下去,还需要有合理的“组织保障”。各业务部门的人通常都会被各类事务缠身,对他们来说,数据的梳理、整合一直是被认为重要但确经常无暇关注的事情。建立专门的数据主责部门,负责统一的管理协调工作,再由各业务部门配合各类业务数据的提供和质量保障,才是正解。

数据团队快速的运转离不开“机制建立”。机制需要建立在规范的基础上,不同的是,它更侧重强调管理、监控和流程。因此,不同的企业、组织均需要根据自身的组织架构和文化体系制定适合自己的机制。值得注意的,一方面是各环节责任人的落实,另一方面是需要在全面性和可执行性、规范性和时效性方面做一个平衡。

做好数据资产管理,是数据分析的重要基础和保障。“管”、“存”、“算”、“规”、“治”是各类组织做好数据资产管理可以借鉴的有效手段。其中,“管”、“存”、“算”是业界已经形成的标准的基础知识,可以直接使用;“规”、“治”则在不同的企业、组织中需要因地制宜,选择适合自身的规范制度及治理机制。关于作者:陈雪莹 ,现就职于明源云,曾就职于远光软件,拥有多年企业管理软件实施及数据分析平台产品管理一线从业经历,在数据分析、产品设计及项目管理方面拥有丰富的经验。

本文摘编于《智能数据分析:入门、实战与平台构建》,经出版方授权发布。(书号:9787111710646)转载请保留文章来源。