译者 | 李睿

审校 | 孙淑娟

在具有感知功能的聊天机器人成为热门话题之前,大型语言模型(LLM)就已经引起了人们更多的兴奋和担忧。近年来,经过大量文本训练的深度学习模型——大型语言模型(LLM) 在几个用于衡量语言理解能力的基准方面表现出色。

诸如GPT-3和LaMDA之类的大型语言模型设法在较长的文本中保持连贯性。它们似乎对不同的主题很了解,并在冗长的对话中保持一致。大型语言模型(LLM)已经变得如此令人信服,以至于有些人将它们与人格和更高形式的智力联系在一起。

但是大型语言模型(LLM)能像人类一样进行逻辑推理吗?根据加州大学洛杉矶分校科学家发布的一篇研究论文,在大型语言模型(LLM)中使用的深度学习架构Transformers并没有学习模拟推理功能。与其相反,电脑们找到了明智的方法来学习推理问题中固有的统计特征。

研究人员在一个有限的问题空间中测试了当前流行的Transformer架构BERT。他们的研究结果表明,BERT可以准确地响应训练空间中分布内示例的推理问题,但不能推广到基于相同问题空间的其他分布中的示例。

而这些测试突出了深度神经网络的一些缺点以及用于评估它们的基准。

1.如何衡量人工智能中的逻辑推理?

人工智能系统针对自然语言处理和理解问题有几个基准测试,例如GLUE、SuperGLUE、SNLI和SqUAD。随着Transformer规模变得越来越大,并在更大的数据集上接受训练,Transformer已经能够在这些基准上逐步改进。

值得注意的是,人工智能系统在这些基准上的表现通常与人类智能进行比较。人类在这些基准上的表现与常识和逻辑推理能力密切相关。但目前尚不清楚大型语言模型的改进是因为它们获得了逻辑推理能力,还是因为它们接触了大量文本。

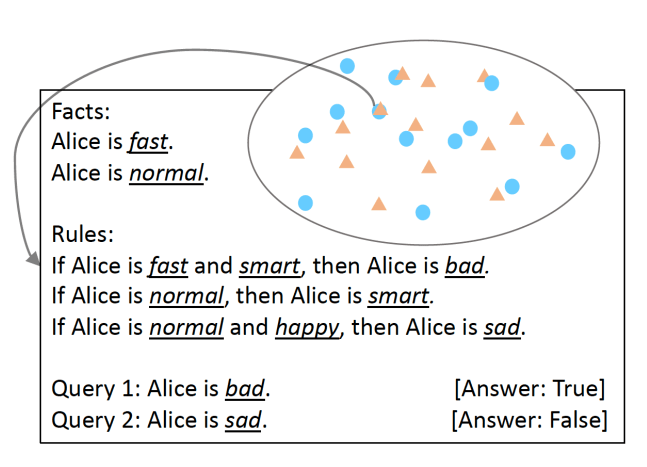

为了验证这一点,加州大学洛杉矶分校的研究人员开发了SimpleLogic,这是一类基于命题逻辑的逻辑推理问题。为了确保语言模型的推理能力经过严格测试,研究人员通过使用模板语言结构消除了语言差异。SimpleLogic问题由一组事实、规则、查询和标签组成。事实是已知为“真”的谓词。规则是条件,定义为条款。查询是机器学习模型必须响应的问题。标签是查询的答案,也就是“真”或“假”。 SimpleLogic问题被编译成连续的文本字符串,其中包含语言模型在训练和推理期间所期望的信号和分隔符。

以SimpleLogic格式提出的问题SimpleLogic的特点之一是它的问题是自包含的,不需要先验知识。这一点尤其重要,因为正如许多科学家所说,当人类说话时,他们忽略了共享的知识。这就是为什么当被问及每个人都知道的基本世界知识的问题时,语言模型经常陷入陷阱的原因。相比之下,SimpleLogic为开发人员提供解决其问题所需的一切。 因此,任何查看SimpleLogic格式提出的问题的开发人员都应该能够推断其规则,并能够处理新示例,无论他们的背景知识如何。

2.统计特征和逻辑推理

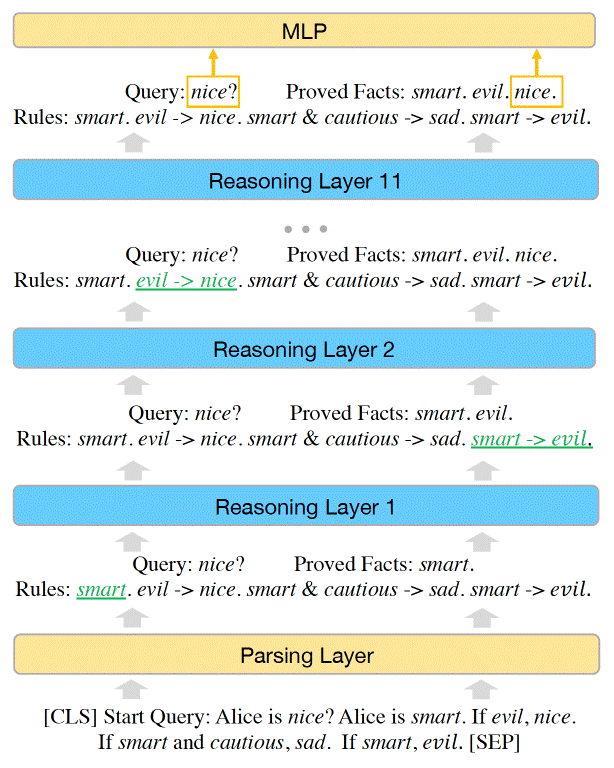

研究人员证明,SimpleLogic中的问题空间可以用一个推理函数来表示。研究人员进一步表明,BERT有足够的能力解决SimpleLogic中的所有问题,它们可以人工调整机器学习模型的参数来表示推理功能。

然而,当它们在SimpleLogic示例数据集上训练BERT时,该模型无法自行学习推理功能。机器学习模型设法在一个数据分布上实现近乎完美的准确性。但它并没有推广到同一问题空间内的其他分布。尽管训练数据集覆盖了整个问题空间,并且所有分布都来自同一推理函数,但情况仍然如此。

BERT Transformer模型的容量足以表示SimpleLogic的推理功能

(注:这与分布外泛化挑战不同,后者适用于开放空间问题。当模型无法泛化到OOD数据时,当处理不在其训练集分布范围内的数据时,其性能会显著下降。)

研究人员写道:“经过进一步调查,我们为这个悖论提供了一个解释:仅在分布测试示例上达到高精度的模型还没有学会推理。事实上,该模型已经学会在逻辑推理问题中使用统计特征来进行预测,而不是模拟正确的推理功能。”

这一发现凸显了将深度学习用于语言任务的一个重要挑战。神经网络非常擅长发现和拟合统计特征。在某些应用程序中,这可能非常有用。例如,在情感分析中,某些词和情感类别之间存在很强的相关性。

然而,对于逻辑推理任务,即使存在统计特征,其模型也应该尝试找到并学习潜在的推理功能。

研究人员写道:“当我们试图对神经模型进行端到端的训练,以解决既涉及逻辑推理又涉及先验知识且呈现语言差异的自然语言处理(NLP)任务时,应该小心谨慎。”他们强调,SimpleLogic带来的挑战在现实世界中变得更加严峻,大型语言模型(LLM)所需的大量信息根本不包含在数据中。

研究人员观察到,当他们从训练数据集中删除一个统计特征时,语言模型在相同问题空间的其他分布上的性能得到了改善。然而,问题是发现和删除多个统计特征说起来容易做起来难。正如研究人员在论文中指出的那样,“此类统计特征可能数不胜数,并且极其复杂,因此很难从训练数据中删除。”

3.深度学习中的推理

不幸的是,随着语言模型规模的变大,逻辑推理问题并没有消失。它只是隐藏在庞大的架构和非常大的训练语料库中。大型语言模型(LLM)可以描述事实并且很好地将句子拼接在一起,但是在逻辑推理方面,他们仍然使用统计特征进行推理,这不是一个坚实的基础。而且,没有迹象表明通过向Transformers添加层、参数和注意力头,逻辑推理的差距将被弥合。

这篇论文与其他显示神经网络在学习逻辑规则方面的局限性的工作一致,例如生命游戏或视觉数据的抽象推理。该论文强调了当前语言模型面临的主要挑战之一。正如加州大学洛杉矶分校的研究人员所指出的,“一方面,当一个模型被训练来从数据中学习一项任务时,它总是倾向于学习统计模式,这些模式固有地存在于推理示例中;然而,另一方面,逻辑规则从不依赖统计模式来进行推理。由于很难构建一个不包含统计特征的逻辑推理数据集,因此从数据中学习推理是很困难的。”

原文链接:https://bdtechtalks.com/2022/06/27/large-language-models-logical-reasoning/