在抓取对方网站、APP 应用的相关数据时,经常会遇到一系列的方法阻止爬虫。

网站APP们这么做的原因,一是为了保证服务的质量,降低服务器负载,二是为了保护数据不被获取。爬虫与反爬虫的斗争经久不衰,

这里给大家总结出了我们在爬取数据时常见的反爬虫手段。

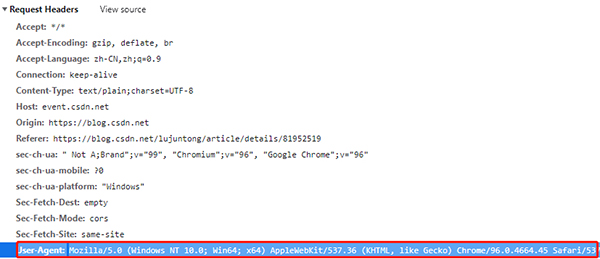

1. User-Agent

网络请求中,User-Agent 是表明身份的一种方式,网站可以通过User-Agent来判断用户是使用什么浏览器访问。不同浏览器的User-Agent是不一样的

例如,我们在windows上面的Chrome浏览器,它的User-Agent是:

但是如果我们使用Python的Requests直接访问网站,除了网址不提供其他的信息,那么网站收到的User-Agent是空。

这个时候网站就知道我们不是使用浏览器访问的,于是它就可以拒绝我们的访问。

from fake_useragent import UserAgent

for i in range(1,11):

ua = UserAgent().random

print(f'第{i}次的ua是', ua)

'''

第1次的ua是 Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.62 Safari/537.36

第2次的ua是 Mozilla/5.0 (Windows NT 6.1; rv:21.0) Gecko/20130401 Firefox/21.0

第3次的ua是 Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_6; es-es) AppleWebKit/533.20.25 (KHTML, like Gecko) Version/5.0.4 Safari/533.20.27

第4次的ua是 Mozilla/5.0 (X11; CrOS i686 4319.74.0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.57 Safari/537.36

第5次的ua是 Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_6; fr-ch) AppleWebKit/533.19.4 (KHTML, like Gecko) Version/5.0.3 Safari/533.19.4

第6次的ua是 Mozilla/5.0 (X11; OpenBSD i386) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/36.0.1985.125 Safari/537.36

第7次的ua是 Mozilla/5.0 (X11; NetBSD) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/27.0.1453.116 Safari/537.36

第8次的ua是 Mozilla/5.0 (X11; Linux i586; rv:31.0) Gecko/20100101 Firefox/31.0

第9次的ua是 Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; Zune 3.0)

第10次的ua是 Mozilla/5.0 (Windows NT 5.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/31.0.1650.16 Safari/537.36

'''

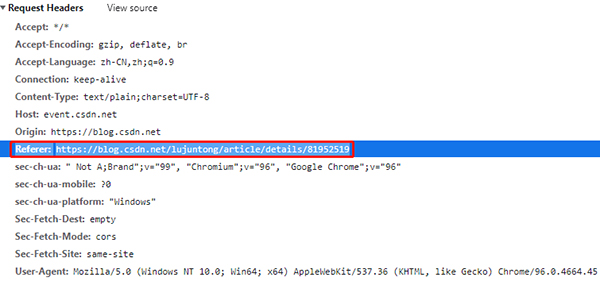

2. Referer

HTTP Referer是header的一部分,当浏览器向web服务器发送请求的时候,一般会带上Referer,表明这个网页是从哪里跳过来的,是网页防盗链的一种方式

有时也被用于反爬虫。如果网站会检查 Referer,请保证你的 Referer 始终是正确的(跳转到此网页之前的网页 URL)。

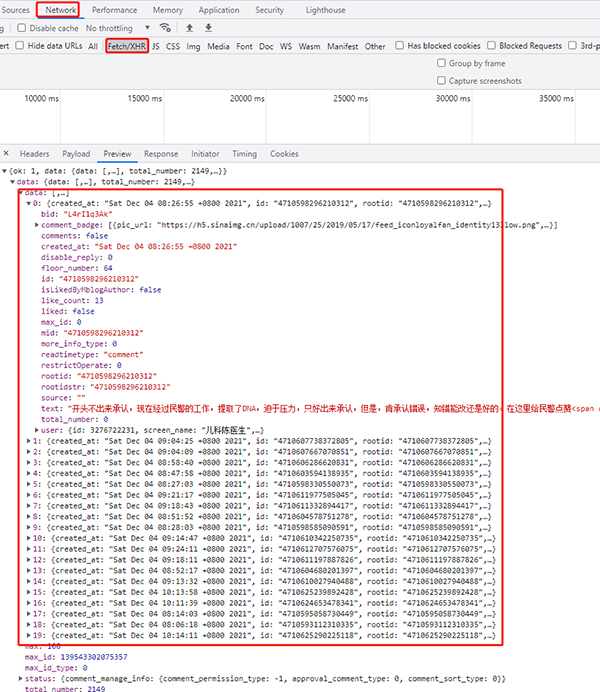

3. Ajax

这个应该不算反爬?当网站使用 ajax 异步获取数据时,我们是无法直接从网页源代码中获取想要的数据的,这个时候要借助 Network 工具栏,分析 API 请求,然后使用 Python 模拟调用 API,直接从 API 中获取数据。(多数都是 POST 类型的请求,也有小部分 GET 的)

当然,也可以使用 Selenium 等自动化测试工具直接渲染网页,再从渲染后的网页源码中解析数据。

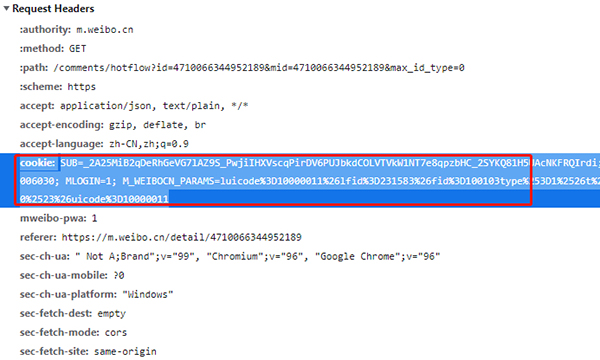

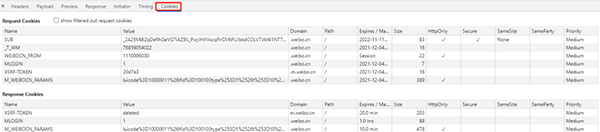

4. Cookie

在网站中,http的请求通常是无状态的(第一个和服务器连接并且登录之后,此时服务器知道是哪个用户,但是当第二次请求服务器时,服务器依然不知道当前请求的是哪个用户),cookie就是为了解决这个问题。

第一次登录服务器后,服务器会返回与刚刚用户相关的数据(也就是cookie)给浏览器,浏览器将cookie保存在本地,当这个用户第二次请求服务器时,就会把上次存储的cookie自动携带给服务器,服务器通过这个cookie就知道当前是哪个用户。

在一些爬虫中,我们在进入一个页面之前需要先登录,比如人人网,我们想要在人人网中浏览主页,就要先注册登录,然后才能浏览,那么在爬虫时,保持登录状态就需要在请求头中加入cookie。

cookies是指网站为了辨别用户身份,进行会话跟踪而储存在本地终端的数据,cookies一般再电脑中的文件里以文本形式储存。cookies其实是有键值对组成的,如下图所示:

5. 验证码

验证码又分很多种,我们说一下比较常见的三种:字母验证码、拼图验证码、点选式验证码。

字母验证码,就是给你一张有若干字母或数字的图片,让你识别出其中内容,并在文本框中输入。比如这个:

这是最简单的验证码,一般编写深度学习模型训练,或直接使用打码平台即可解决。

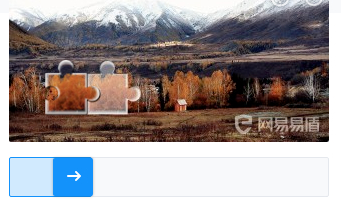

拼图验证码,给定了一张图片和一个滑动组件。当你拖动滑动组件时,图片会出现缺口,拖动滑动组件,补全缺口即可过关。比类似于这种:

比较常见的做法是,通过图片之间的对比,计算拼图缺口的位置,然后使用特定的轨迹拖动滑块,完成验证。

你有两种方法提交验证,一是使用 Selenium 调用浏览器,二是直接破解 JS,使用 POST 模拟提交。

点选式的验证码,会给出一张小图片(有的是图片,有的不是,不同验证码平台不一样),上面顺序显示着几个汉字。再给出一张大图片,上面也有这几个汉字,但汉字的分布是随机的。要求你按照小图片中汉字出现的顺序,点击大图片中的汉字。类似于这种:

最常见的方法是借助打码平台计算相对坐标,然后使用 Selenium 等自动化工具按顺序点击。当然,自己训练模型也是可行的,但比较麻烦。

对于验证码,可以通过OCR来识别图片,Github上面有很多大神分享的代码可以用,可以去看看。

简单的OCR识别验证码:

from PIL import Image

import tesserocr

#tesserocr识别图片的2种方法

img = Image.open("code.jpg")

verify_code1 = tesserocr.image_to_text(img)

#print(verify_code1)

verify_code2 = tesserocr.file_to_text("code.jpg")

6. 代理 IP 池

如果你频繁使用同一个 IP 访问某个网站,可能会被网站认为是恶意攻击,进而 ban 掉你的 IP。这个时候,使用代理 IP 池就是一个很好的方案。

在一些网站服务中,除了对 user-agent 的身份信息进行检测。

也对客户端的 ip 地址做了限制。

如果是同一个客户端访问此网站服务器的次数过多就会将其识别为爬虫。

因而,限制其客户端 ip 的访问。这样的限制给我们的爬虫带来了麻烦,所以使用代理 ip 在爬虫中是非常有必要的。

这里我给大家提供一下两个网站供参考。

66代理:http://www.66ip.cn/6.html

快代理:https://www.kuaidaili.com/free/

7. 请求间隔

两次请求之间,最好设置一定间隔。理由如下:

请求过于频繁,远超出人工频率,容易被识别出来,请不要给对方服务器造成太大压力

且间隔的时间不要定死,在一定范围内波动是个比较合适的选择。过于机械的间隔时长,也可能会让网站认为你是爬虫。

import time

import random

for i in range(1,11):

time = random.random()*5

print(f'第{i}次睡了:', time, 's')

'''

第1次睡了: 0.6327309035891232 s

第2次睡了: 0.037961811128097045 s

第3次睡了: 0.7443093721610153 s

第4次睡了: 0.564336149517787 s

第5次睡了: 0.39922345839757245 s

第6次睡了: 0.13724989845026703 s

第7次睡了: 0.7877693301824763 s

第8次睡了: 0.5641490602064826 s

第9次睡了: 0.05517343036931721 s

第10次睡了: 0.3992618299505627 s

'''

8. 字体反爬

还有一种特殊情况,你在浏览器页面上已经看到了你想要的数据,但是当你查看源码时,根本找不到相关数据或者数据和你看到的不一致。你怀疑这个数据是通过接口异步加载的,但你检查了请求,过程中并没有异步请求数据接口。怎么回事?

你可能遇到了字体反爬。即目标网站通过 CSS 样式、字体映射等方式,完成了对特定数据的隐藏。你无法直接从源码提取相关数据,但却不会影响网页的显示效果。那么,怎么解决呢?

两种方法,第一种,破解字体的映射关系,从源码中提取错误的数据,并通过特定的映射关系把它翻译成正确的数据。第二种就是偷懒的方法了,使用 Selenium 等自动化测试工具渲染页面,截取数据内容图片,并通过 OCR 程序识别图像内容。

9. 正则表达式

对于页面解析最强大的当然是正则表达式,这个对于不同网站不同的使用者都不一样,就不用过多的说明,附两个比较好的网址:

正则表达式入门:

http://www.cnblogs.com/huxi/archive/2010/07/04/1771073.html

正则表达式在线测试:

http://tool.oschina.net/regex/

其次就是解析库了,常用的有两个lxml和BeautifulSoup,对于这两个的使用介绍两个比较好的网站:

lxml:http://my.oschina.net/jhao104/blog/639448

BeautifulSoup:http://cuiqingcai.com/1319.html

对于这两个库,我的评价是,都是HTML/XML的处理库,Beautifulsoup纯python实现,效率低,但是功能实用,

比如能用通过结果搜索获得某个HTML节点的源码;lxml C语言编码,高效,支持Xpath。

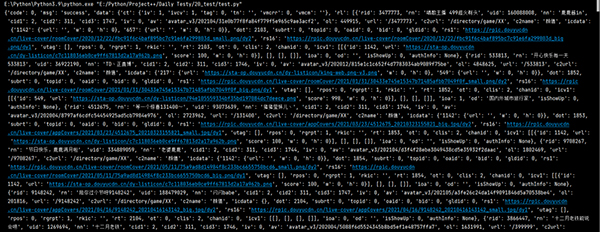

10. pprint

这个是在pycharm中查看的来看效果吧

print()打印,不知道你感觉如何,我一脸懵逼。

import requests

url = 'https://www.douyu.com/gapi/rknc/directory/yzRec/1'

resp = requests.get(url).json()

print(resp)

pprint()打印,这种结构看起来如何呢?

from pprint import pprint

import requests

url = 'https://www.douyu.com/gapi/rknc/directory/yzRec/1'

resp = requests.get(url).json()

pprint(resp)

现在除了使用pprint之外,冰淇淋icecream也是很好的选择