2022年8月6日-7日,AISummit 全球人工智能技术大会如期举办。在7日下午举办的《人工智能前沿探索》分论坛上,西山居AI技术专家黄鸿波带来了《游戏中强化学习与行为树融合实战》的主题分享,详细分享了强化学习在游戏领域产生的价值。

黄鸿波表示,强化学习技术的落地并不在于要把算法改得多牛,而是要将强化学习技术与深度学习、游戏策划相结合,形成一套完备的解决方案,并将其实现。

强化学习让游戏更加智能

强化学习在游戏中的落地,能够让游戏变得更加智能,可玩性变得更高,这就是在游戏中采用强化学习的主要目的。

“强化学习是一种机器学习范式,它训练代理的策略,以便可以做出一系列决策。” 黄鸿波表示,代理的目的是根据对环境的观察来输出动作。这些行动将导致更多的观察和回报。当代理与环境交互时,培训涉及大量的反复试验,并且每次迭代都可以改进策略。

在游戏中,采取行动或执行行为的代理是游戏智能体(Agent)。考虑游戏中的角色或机器人,它必须了解游戏的状态,玩家在哪里,然后基于此观察,应根据游戏的情况做出决定。在强化学习中,决策由奖励决定,奖励在游戏中可以作为高分提供,也可以提供给达到特定目标的新水平。

黄鸿波表示,关于游戏情况的最酷事情是,在游戏的压力下训练了智能体的策略。 例如,它可以了解受到攻击时的处理方式,或如何行为以达到特定目标。

行为树在游戏中的作用

行为树是一个包含逻辑节点和行为节点的树结构体。通常情况下,可以将每一种情况都抽象成一个类型的节点,按照规范去写节点,然后把这些节点连接成一棵树。当用户每次去找一个行为的时候,就会从树的跟节点出发,从各个节点中寻找出一个和当前数据相符合的行为。

简单来说,在AI各模块耦合度较高、粒度较大的情况下,往往一个变动都牵扯到大量的修改,也很容易出现大量的重复代码。而行为树的出现,给了广大游戏开发者提供了一个“方格本”,让AI开发者比较方便的搭建出一整套可复用、好扩展维护的AI框架出来。可以说,强化学习是用训练得来的,行为树是若干个else、if的语句结合。

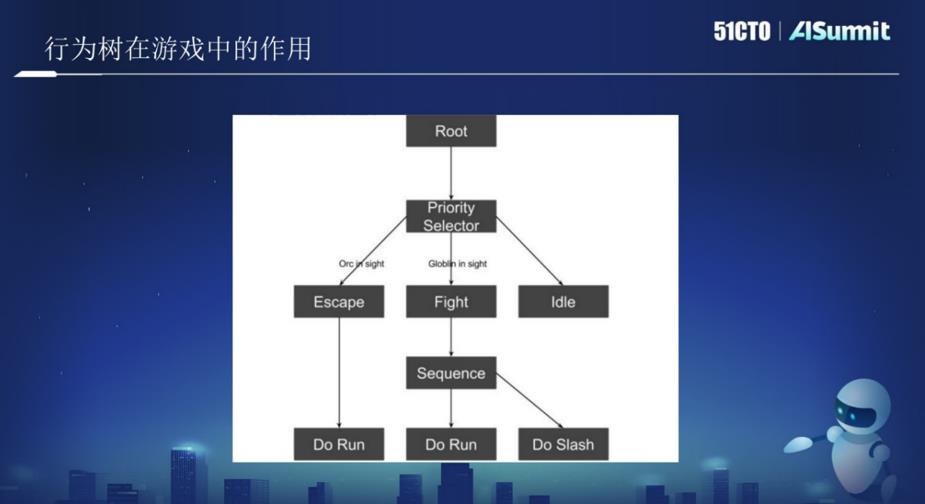

上图所示,图中有一个根节点,往下是一个树节点,树节点中又包括逃跑、攻击、闲逛等。把上图当成一个AI或是机器人,让他在丛林中巡逻。当AI看到一个ORC半兽人,并判断打不过这个ORC,当触发这个条件,AI会逃跑,逃跑就会执行Run动作。当判断比较容易打,就会执行Fight操作。

在上图中,有两个节点,一个是Root,即根节点;一个是Selector节点,即逻辑节点。所有的节点都是按照一定顺序,从左往右执行,这就是一个行为树。因此,只需要写好每个节点里对应的逻辑,就能够让AI执行一些相关动作。若干个行为树,最后就组成了一个游戏。

强化学习和行为树相结合让游戏更加丰富

如何使用强化学习和行为树相结合,让游戏更加丰富呢?这是很多游戏里需要讨论的一个比较难的应用。

在此之前,不妨先讨论什么时候用强化学习比较好,什么情况下用行为树比较好。黄鸿波表示,用行为树没有办法很好达到目标的,就可以用强化学习,例如在FPS(第一人称射击游戏)中,应该用多大火力,应该朝谁开火,应该用什么样的武器等等,是比较难通过行为树来决策的,一般来讲用强化学习实现就会比较好。

什么时候用行为树?例如在游戏中遇到障碍物时需要跳过去,可以选择用强化学习来做,也可以选择用行为树来做。但如果用强化学习来做,训练起来就会很麻烦。由于这种情况下只有一个选择,就是跳过去,因此用行为树就会更加简单。

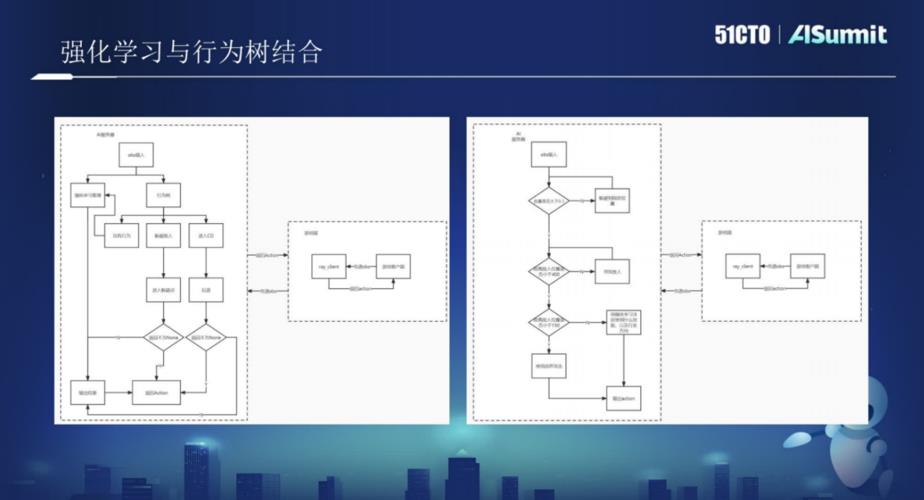

不难发现,如果把强化学习和行为树结合起来用在游戏中,就是一个比较好的方案。黄鸿波表示,强化学习与行为树相结合,有两种比较大的实现方式:一种是以强化学习为主,行为树为辅;另一种是以行为树为主,强化学习为辅。

行为树侧:以行为树为主要的AI运动方式,行为树从游戏客户端接收obs输入,根据自身的目标情况,针对于obs来写相应的行为树行为,在行为树的各个行为中,将一些需要强化学习做决策的节点交给强化学习来进行,那么在这里,就需要强化学习针对一些特定的场景来做相应的训练。

强化学习侧:整体策略则变成了训练若干个模型,每一个模型执行一种策略,然后再嵌入到行为树当中。

黄鸿波表示,这两种不同的实现方式,究竟哪个好,这就需要根据不同的情况、不同的应用、不同的游戏进行不同的考虑,因此不能一概而论。

在接下来的时间里,黄鸿波详细介绍了西山居在强化学习与行为树中采用的技术框架,并结合大量的游戏案例,详细介绍了行为树和强化学习在游戏中是如何进行结合,让游戏变得更加丰富。对案例实践感兴趣的用户,不妨关注AISummit 全球人工智能技术大会的精彩分享视频。(https://aisummit.51cto.com/)