2017年,当名为“Deepfakes”的用户在互联网上首次发布合成视频时,也许不曾想到他已经打开了“潘多拉魔盒”。随着DeepFake技术在缺少监管的状态下野蛮生长至今,已逐渐成为危害经济和社会稳定的存在。无数事实都在时刻提醒我们:眼见未必为实!不能再理所当然地相信互联网上的图像和视频。

Deepfakes技术发展大事记

2014:Deepfakes技术诞生

2014年,“GAN之父”Ian Goodfellow与同事发表了首篇介绍生成对抗网络(GAN)的科学论文,它就是我们今天深入讨论的deepfakes的技术基础。

2015年:GAN越发完善

研究人员开始将GAN与经过图像识别优化的多层卷积神经网络(CNN)相结合。CNN能够并行处理大量数据,而且在显卡上的运行效率特别高。这一组合取代了以往较为简单的GAN代理驱动网络,也让生成结果的可信度迈上新的台阶。

2017年:第一段Deepfakes视频诞生

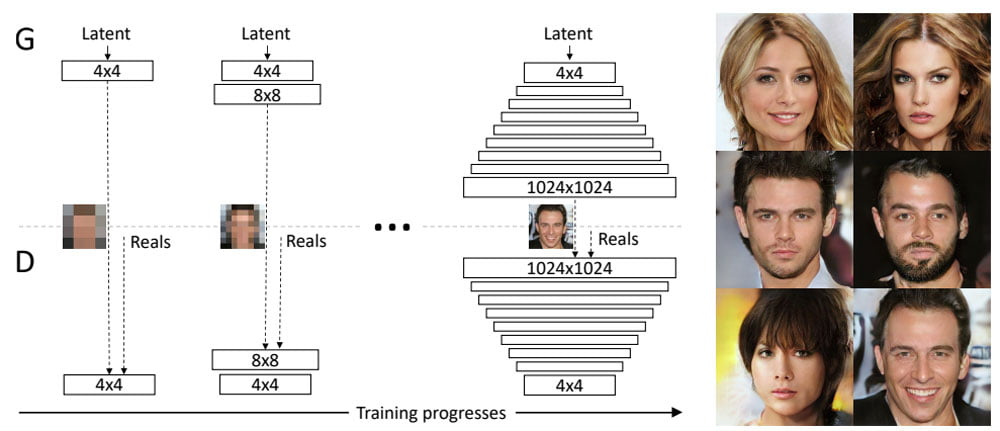

生成器代理通常会生成低分辨率的图像,因为越清晰越容易被检测出问题,只有这样,检查代理才难以检测内容的真伪。Nvidia通过分阶段训练网络:先由伪造AI学习创建低分辨率图像,然后,将分辨率逐渐提升,以此推动Deepfakes仿真能力实现了质的飞跃。自此,Deepfakes一词就成了AI生成图像和视频的代名词。

2018年:Deepfakes登陆YouTube频道

此后,Nvidia研究人员进一步提升GAN控制能力,他们可以针对单一图像特征(例如人像中的“黑发”和“微笑”)做出调整。通过这种方式,可以将训练图像的特征有针对性地转移到AI生成图像上。与此同时,首个专门研究Deepfakes的YouTube频道正式上线,包括了各种类型的视频。

【网络转移可用于控制图像AI,例如仅创建微笑着的人像】

2019年:Deepfakes成为主流

抛开技术进步不谈,2019年是deepfakes正式成为主流的一年。网络上Deepfakes数量快速增加,Deepfakes的技术发展速度超出了预期,技术专家Hao Li甚至大胆预测,Deepfakes将在很快走向完美。

2020年:对Deepfakes提出监管

Facebook在2020年美国大选开始时宣布,将在自家平台上全面禁止deepfakes——讽刺或戏仿性质的Deepfakes除外;YouTube也采取了类似的指导方针;Twitter则开始执行其2019年推出的管理Deepfakes准则;当年8月,TikTok也开始禁止其视频平台违规使用Deepfakes技术。

在这一年,Jigsaw公司正式发布了一款由AI驱动的检测工具Assembler,可帮助管理者检测出Deepfakes图像。高通则投资了一家初创公司,该公司能够以不可撤销的方式将原始照片及视频标记为“原创”,从而降低后续的Deepfakes识别难度。

目前阶段

Deepfakes技术本身仍在继续发展,微软已经正式推出了FaceShifter,能够将模糊的原始图像处理为可信的伪造画面。娱乐巨头迪士尼也开始在电影制作中广泛应用Deepfakes技术,并推出了百万像素级Deepfakes视频制作工具。这一切,都为Deepfakes可能被利用的犯罪活动创造了条件。

今年6月,FBI发布公告,提醒公众警惕在远程求职面试中使用Deepfakes技术假扮成他人的情况。这些职位大多与信息技术、系统开发、数据库以及软件管理相关。如果这些诈骗者成功过关,将有权访问目标企业的敏感数据,包括客户 PII(个人身份信息)、财务数据、公司IT数据库和/或专有信息。

Deepfakes威胁日益增加

经过多年的发展,现在的Deepfakes技术已经从“一眼假”变成真伪莫辨的“实时换脸”,而且门槛极低,只需要通过一款软件,几张图片,即可一键生成。而一系列的网络安全事件也充分表明,Deepfakes引发的信任安全危机可能才刚刚开始。

根据VMware最新发布的《年度全球事件响应威胁报告》显示,去年,使用面部和语音替换技术进行网络攻击的数量增长了13%。其中,电子邮件是Deepfakes攻击的主要传递载体,占整体攻击数量的78%,这与商业电子邮件入侵(BEC)尝试的持续增加有关。

此外,在接受研究人员调查的网络安全专业人士中,有66%的受访人表示他们在过去一年中发现了至少一起此类事件。事实再次证明,Deepfakes技术用于网络攻击已经从理论威胁演变成了现实危害。

早在2019年,美国国土安全部就对Deepfakes技术的应用安全性提出了质疑,称“使用该技术骚扰或伤害他人利益的现象应当引起公众重视”。然而,用于分辨Deepfakes伪造视频的技术目前还尚未成熟。

根据威胁情报公司Sensity发布的一份最新研究报告显示,Deepfakes检测算法和软件有86%的几率会将经Deepfakes伪造处理过的视频认定为“真”。而2022年3月卡内基梅隆大学的研究指出,对比市面上各种Deepfakes技术检测产品的算法和硬件基础发现,其准确度在30%-90%之间浮动。

更重要的是,随着Deepfakes技术的快速发展,也许未来再精密的Deepfakes检测算法也无法准确地识别真伪。这意味着Deepfakes技术将最终改变游戏规则——无论是社交还是娱乐方面。Deepfakes专家Hao Li认为,这种发展趋势是完全有可能的,因为图像的实质不过是辅以适当颜色的像素,AI找到完美的副本只是时间问题。

此外,短视频的盛行,以及Reface或Impressions等应用的普及,使得伪造图像和视频正变得司空见惯。过去,人们坚信“耳听为虚,眼见为实”,而现在,可能正如GAN之父Ian Goodfellow所言,“AI也许正在关闭我们这一代观察世界的大门。”

积极防御Deepfakes应用风险

虽然Deepfakes技术在应用时产生的威胁看起来很严重,不过,我们也并非完全无计可施。FBI在之前的公告中就指出,虽然一些Deepfakes视频处理的极为逼真,但并未达到完美无瑕的程度。通过一些不正常的眨眼、不正常的光线、不协调的声音,以及咳嗽、打喷嚏等动作细节,都可识别出视频的真假。在时长超过10s的视频画面中,发现这些破绽并不难。

同时,企业组织还可以采取多种措施来抵御它们,包括培训和教育、先进技术以及威胁情报等,从而在一定程度上抑制恶意的Deepfakes活动:

- 首先,教育和培训员工有关Deepfakes社交工程攻击(尤其是那些最有针对性的攻击)的知识是降低风险的一个重要因素,而且必须将重点放在财务部门相关员工身上,并且经常性提醒他们注意这种可能性;

- 其次,在技术方面,建议企业组织部署更多的分析系统,以及时发现异常伪造行为等。Deepfakes欺诈活动一般需要时间来设置和执行,这让潜在受害者有足够的时间来发现警告信号并采取行动;

- 除此之外,企业还可以通过随机分配用户指令来实现有效防御。因为Deepfakes创作者无法预测数以千计的可能请求。虽然犯罪分子可以实时操纵Deepfakes,但视频质量会显著下降,因为Deepfakes技术所需的强大处理能力使其无法快速做出反应。在此情况下,反复响应错误的用户可以被标记,并进行进一步调查。