如何实现持续学习,让AI不断片?

近日,来自罗切斯特大学的41岁计算机科学家Christopher Kanan在专访中表示,自己正在构建可以让AI随着时间的推移而不断学习的算法——就像我们人类一样。

灾难性遗忘

众所周知,AI在经过训练之后可以很好地完成「考试范围内」的任务,但是这些算法却不能像人类那样不断用新信息更新知识库。

为了学习哪怕是一个新的东西,算法也必须从头开始训练,而代价就是忘记它之前已经学习过的几乎所有内容。如此带来的问题就是——「灾难性遗忘」(Catastrophic Forgetting)。就像你遇到一个新朋友,你唯一能知道她名字的方法就是重启你的大脑。

之所以会出现这种情况,要归咎于神经网络学习新事物的方式。这些算法的学习需要改变神经元之间的连接强度,然而这同时也代表了过去的知识,因此过多地改变连接就会导致遗忘。

生物神经网络已经进化了数亿年的策略,以确保重要信息保持稳定。但是今天的人工神经网络很难在新旧知识之间取得良好的平衡。当网络看到新数据时,它们的连接很容易被覆盖,这可能导致突然而严重的无法识别过去的信息。

1. 您在哲学方面的学习对你思考研究的方式产生了哪些影响呢?

哲学教会你的是,「如何提出合理的论点」和「如何分析他人的论点?」

我的实验室受到这个问题的启发:如果我们不能做 X,我们怎么能做 Y?

我们会随着时间的推移而学习,但神经网络不会,他的知识量是固定的。那么如果人类未来要想制造通用人工智能,这是必须解决的基本问题。

Kanan的研究笔记

2. 学术界目前对灾难性遗忘的解决进展如何?

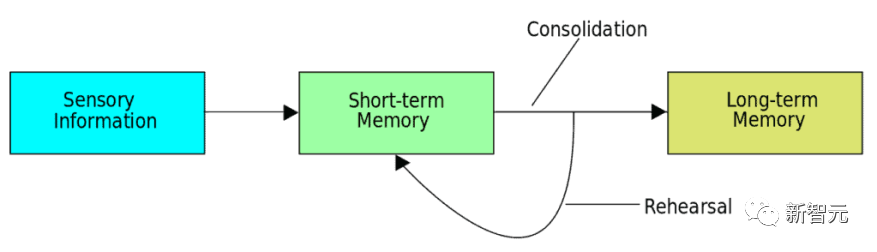

目前最成功的方法叫做重放(Replay),这样可以存储过去的知识,然后在训练过程中用新的数据集重放,这样原始信息就不会丢失。

这个方法的灵感来自我们大脑中的记忆巩固过程(Memory Consolidation),睡眠过程中一天的学习的内容被重新编码,并随着神经元激活而被重放。

换句话说,新的学习并不能完全根除算法过去的知识。

有三种方法可以实现这一点。

- 最常见的方法是「真实回放」,研究人员存储原始输入的子集——例如,用于对象识别任务的原始图像——然后将这些存储的过去图像与学习的新图像混合。

- 第二种方法是重放图像的压缩表示。

- 第三种不太常见的方法是「生成回放」。

在这里,人工神经网络实际上生成了过去经验的合成版本,然后将该合成示例与新示例混合。我的实验室专注于后两种方法。

3. 如果我们能够彻底解决灾难性遗忘,这是否意味着人工智能可以随着时间的推移不断学习新事物?

不完全是。我认为持续学习领域的开放性问题并不是灾难性遗忘。

我真正感兴趣的是:

过去的学习如何让未来的学习更有效率?未来的学习如何纠正过去的学习?这些是很少人衡量的东西,我认为这样做是推动该领域向前发展的关键部分,因为实际上,这不仅仅是忘记一些东西,而是关于如何成为一个更好的学习者。

Christopher Kanan表示:

与现代神经网络相比,我们的头脑中发生的事情肯定要多得多。我们需要建立正确的实验和算法设置来衡量过去的学习是否有助于未来的学习。而目前最大的问题是我们没有很好的数据集来研究持续学习,我们基本上是在使用传统机器学习中使用的现有数据集并将其重新开发。

一般来说,机器学习的常规操作是我们有一个训练集和一个测试集——我们在训练集上训练,在测试集上进行测试。

但持续学习打破了这些规则,它让训练集会随着训练者的学习而发展,因此我们需要一个非常好的持续学习环境。

4. 理想的持续学习环境应该是什么样的?

告诉你它不是什么比告诉你是什么更容易。

我可以告诉你它可能具有的属性。所以现在,让我们假设人工智能算法不是模拟中的具身智能。然后至少,理想情况下,我们正在从视频中学习,或者类似的东西,比如多模态视频流,并希望做的不仅仅是静态图像的分类。

有很多关于这方面的开放性问题。几年前我参加了一个持续学习研讨会,一些像我这样的人说,「我们必须停止使用一个叫做MNIST的数据集,它太简单了。」然后有人说,「好吧,那我们就对星际争霸进行增量学习。」

出于各种原因,我现在也在这样做,但我认为还不足以真正地解决这个问题。毕竟,生活比学习玩星际争霸要丰富得多。

5. 您的实验室如何尝试设计可随时间推移不断学习的算法?

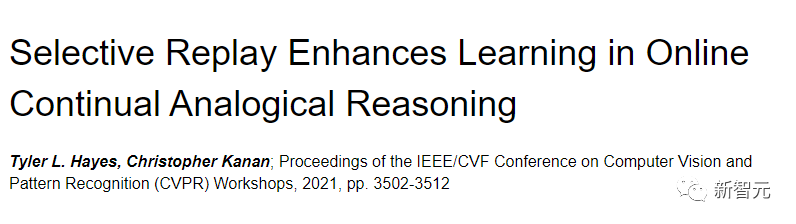

我和我以前的学生Tyler Hayes一起开创了一项有关类比推理的持续学习研究,这篇文章也同时发表在CVPR 2021上。

论文链接:https://openaccess.thecvf.com/content/CVPR2021W/CLVision/html/Hayes_Selective_Replay_Enhances_Learning_in_Online_Continual_Analogical_Reasoning_CVPRW_2021_paper.html

我们认为这将是研究迁移学习(Transfer Learning)理念的好领域,因为我们现在需要使用更复杂的技能来解决更复杂的问题。

具体来说,我们对后向迁移(Backward Transfer)的数据进行了测量,即过去学习的东西在未来对你有多大帮助,反之亦然。

我们发现了很好的迁移证据,比对象识别这样的简单任务重要得多。

6. 你认为人工智能真的会像人类一样学习吗?

我想他们会的。许多极具天赋的人在这个领域朝着这个目标迈进。

但我们需要的是创造力。机器学习社区的很多研究都是在前人研究的基础上做一些小改进,真正变革性的研究不多。

但是这一天一定会到来的,只是时间早晚问题。

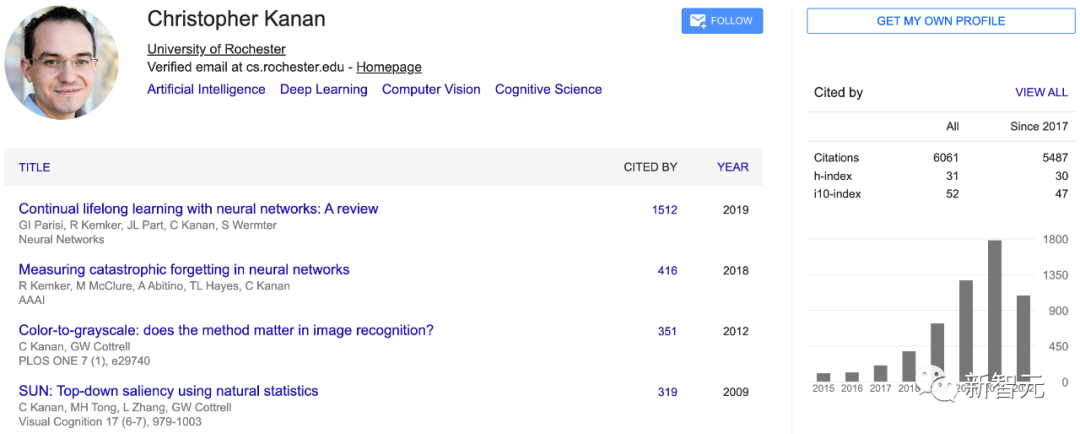

Christopher Kanan

Christopher Kanan是罗切斯特大学计算机科学的终身副教授。主要的工作方向是深度学习的基础研究,包括持续学习,人工智能的偏见,医学计算机视觉,以及语言引导的场景理解。

Kanan曾从事在线持续学习、视觉问题回答、计算病理学、语义分割、物体识别、物体检测、主动视觉、物体跟踪等工作。除了机器学习,他在眼球追踪、灵长类动物视觉和理论神经科学方面也有深厚的背景。

在此之前,他是罗切斯特理工学院(RIT)卡尔森影像科学中心的一名终身副教授。在职期间,他和同事共同创建了人类意识人工智能中心(CHAI),并担任了四年的副主任。此外,Kanan还曾是康奈尔科技大学的客座副教授,为每年约100名研究生教授了4年的深度学习课程。

Christopher Kanan在俄克拉荷马州农村的一个小镇上长大。

1996年的时候,他就开始探索人工智能了,还在读高中的Kanan自制了很多「bot」来玩在线多人计算机游戏。

2002年,Kanan考入俄克拉荷马州立大学(OSU)主修哲学和计算机科学双学位,并于2004年获得学士学位。

2006年,在南加州大学(USC)获得了计算机科学获得硕士学位,主要研究人工智能和神经科学,并与计算神经科学和神经网络的先驱Michael Arbib一起工作。2013年,在加州大学圣地亚哥分校(UCSD)获得计算机科学博士学位。毕业后,Kanan又到加州理工学院从事博士后研究。

参考资料:https://www.quantamagazine.org/the-computer-scientist-trying-to-teach-ai-to-learn-like-we-do-20220802/