如今,每隔一段时间就有新的文本生成图像模型释出,个个效果都很强大,每每惊艳众人,这个领域已经是卷上天了。不过,像 OpenAI 的 DALL-E 2 或谷歌 的 Imagen 等 AI 系统,都只能生成二维图像,如果文字也能变成三维场景,那带来视觉体验势必加倍提升。现在,来自苹果的 AI 团队推出了 3D 场景生成的最新神经架构—— GAUDI 。

它可以捕捉复杂和逼真的 3D 场景分布,从移动摄像机中进行沉浸式渲染,还能根据文本提示来创建 3D 场景!该模型以 Antoni Gaudi 命名,他是西班牙著名的建筑大师 。

论文地址:https://arxiv.org/pdf/2207.13751.pdf

1 基于 NeRFs 的 3D 渲染

神经渲染(nerual rendering)将计算机图形学与人工智能结合起来,已经产生了很多从 2D 图像生成 3D 模型的系统。比如最近 Nvidia 开发的 3D MoMa 可以在一个小时内从不到 100 张的照片中创建出 3D 模型。谷歌也依靠神经辐射场(NeRFs )在谷歌地图中将 2D 卫星和街景图像组合成 3D 场景,实现了沉浸式视图。谷歌的 HumanNeRF 还可以从视频中渲染出 3D 人体。

目前,NeRFs 主要还是用作 3D 模型和 3D 场景的一种神经存储介质,可以从不同的相机视角进行渲染。NeRFs 也已经开始被用于虚拟现实体验。

那么,NeRFs 这种从不同摄像机角度逼真地渲染图像的强大能力,能不能用于生成式 AI 呢?当然可以,已经有研究团队尝试了 3D 场景的生成,如谷歌在去年首次推出了 AI 系统 Dream Fields,它将 NeRF 生成 3D 视图的能力与 OpenAI 的 CLIP 评估图像内容的能力相结合,最终实现了能够生成匹配文本描述的 NeRF。

图注:谷歌 Dream Fields

但是,谷歌的 Dream Fields 只能生成针对单个对象的 3D 视图,要将它扩展到完全不受约束的 3D 场景还存在很多困难。最大的难点就在于摄像机的位置有很大的限制,对于单个对象,每个可能的、合理的摄像机位置都可以映射到一个圆顶,但在 3D 场景中,摄像机的位置会受到对象和墙壁等障碍物的限制。如果在场景生成时不考虑这些因素,那就很难生成 3D 场景。

2 3D 渲染专家 GAUDI

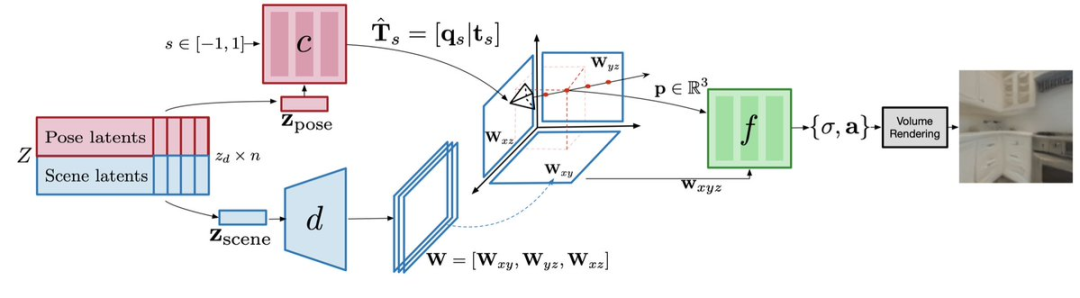

对于上述摄像机位置受限的问题,苹果的 GAUDI 模型拿出了三个专门的网络来轻松搞定:GAUDI 有一个相机姿态解码器,它将摄像机姿态与场景的 3D 几何和外观分离开来,可以预测摄像机的可能位置,并确保输出是 3D 场景架构的有效位置。

图注:解码器模型架构针对场景的场景解码器则可以预测三维平面的表示,这种表示是一种 3D 画布。

然后,辐射场解码器会在这块画布上使用体积渲染方程来绘制后续的图像。

GAUDI 的 3D 生成包含两个阶段:

一是潜在和网络参数的优化:学习对数千条轨迹的 3D 辐射场和相应相机姿态进行编码的潜在表示。与针对单个对象不同,有效相机姿态随着场景的变化而不同,所以需要对每个场景有效的相机姿态进行编码。

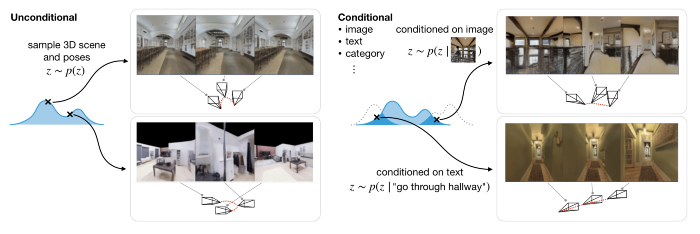

二是使用扩散模型在潜在表示上学习生成模型,从而能够在有条件和无条件的推理任务中都能很好地建模。前者是根据文本或图像提示来生成 3D 场景,后者则是根据摄像机轨迹来生成 3D场景。

通过 3D 室内场景,GAUDI 可以生成新的摄像机运动。如在下面一些示例中,文本描述包含有关场景和导航路径的信息。这里研究团队采用了预先训练的基于 RoBERTa 的文本编码器,并使用其中间表示来调节扩散模型,生成效果如下:文本提示:走进厨房

文本提示:上楼

文本提示:穿过走廊

另外,使用预训练的ResNet-18 作为图像编码器,GAUDI 能够对从随机视点观察给定图像的辐射场进行采样,从而从图像提示中创建 3D 场景。图像提示:

生成 3D 场景:

图像提示:

生成 3D 场景:

研究人员在四个不同的数据集(包括室内扫描数据集 ARKitScences)上进行了实验,结果表明, GAUDI 可以重建学习视图,而且可以与现有方法的质量相匹配。即使是在为数千个室内场景制作具有数十万张图像的 3D 场景的庞大任务中,GAUDI 也不会出现模式崩溃或方向问题。

GAUDI 的出现不仅会对许多计算机视觉任务上产生影响,而且其 3D 场景的生成能力也将有利于基于模型的强化学习和规划、SLAM 以及 3D 内容的制作等研究领域。

就目前来看,GAUDI 生成的视频质量还不算高,可以看出有很多伪影。不过,这个系统或许可以为苹果正在进行的渲染 3D 对象和场景的 AI 系统,这是一个好的开始和基础,据说 GAUDI 还将被应用到苹果的 XR 耳机中,用于生成数字化位置。可以期待一下~