如今,一些看起来非常像人类的句子实际上是由人工智能系统生成的,这些系统已经在大量的人类文本中进行了训练。人们习惯于假定流畅的语言来自于有思想、有感觉的人类,以至于相反的证据可能难以理解,并且认为如果一个人工智能模型能够流畅地表达自己,就意味着它也像人类一样思考和感受。

因此,Google的一名前工程师最近声称,Google的人工智能系统LAMDA有自我意识,因为它可以雄辩地生成关于其所谓感受的文本,这也许并不奇怪。这一事件和随后的媒体报道导致了一些文章和帖子,怀疑关于人类语言的计算模型是有生命的说法。

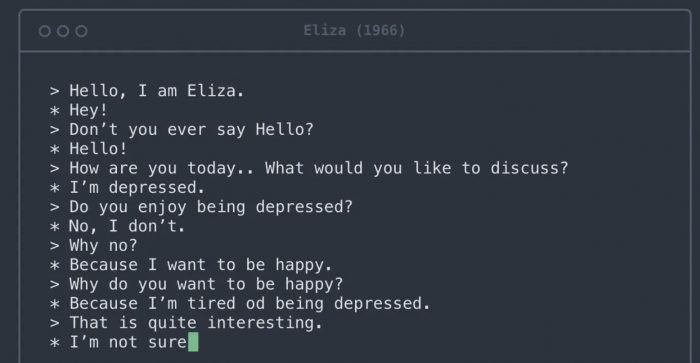

由Google的LaMDA等模型生成的文本可能很难与人类写的文本区分开来。这一令人印象深刻的成就是一项长达数十年的计划的结果,该计划旨在建立能够生成符合语法、有意义的语言的模型。今天的模型,即接近人类语言的数据和规则集,在几个重要方面与这些早期的尝试不同。首先,它们基本上是在整个互联网上训练的。第二,它们可以学习相距甚远的词语之间的关系,而不仅仅是相邻的词语。第三,它们通过大量的内部进行调整,甚至连设计它们的工程师都很难理解为什么它们会产生一个词的序列而不是另一个。

大型人工智能语言模型可以进行流畅的对话。然而,它们没有要传达的整体信息,所以它们的短语往往遵循常见的文学套路,这些套路是从被训练的文本中提取的。人脑有推断词语背后意图的硬性规定。每次你参与谈话时,你的大脑都会自动构建一个谈话伙伴的心理模型。然后,你利用他们所说的话,用这个人的目标、感觉和信念来填补这个模型。从话语到心理模型的跳跃过程是无缝的,每当你收到一个完整的句子时就会被触发。这个认知过程在日常生活中为你节省了大量的时间和精力,大大促进了你的社会互动。然而,在人工智能系统的情况下,它却失灵了,因为它凭空建立了一个心理模型。

一个可悲的讽刺是,让人们把人性赋予大型人工智能语言模型的认知偏见也会导致它们以不人道的方式对待真正的人类。社会文化语言学研究表明,假设流畅的表达和流畅的思维之间的联系过于紧密,会导致对不同的人产生偏见。例如,有外国口音的人往往被认为是不太聪明,不太可能得到他们所胜任的工作。对那些不被认为是有声望的方言,如美国的南方英语,对使用手语的聋哑人,以及对有口吃等语言障碍的人,也存在类似的偏见。这些偏见是非常有害的,往往会导致种族主义和性别歧视的假设,并被一再证明是毫无根据的。