导读:强人工智能的发展是近年来关注的话题。让AI从人类的感知和行为,而非单纯的标注数据中学习,成为许多研究者关注的重点。其中,如何利用人类习得的日常生活经验,启发构建能够适应不同环境,与外部世界交互的人工智能这成为一些领域探索的新路。

被誉为强化学习之父的Richard Sutton近日提出了利用经验启发AI发展的思路。他将AI从利用数据到利用经验的过程分为四个发展阶段,提出了未来构建真正AI(Real AI)的发展方向。2022年5月31日,Richard Sutton在2022北京智源大会上发表了题为“The Increasing Role of Sensorimotor Experience in AI”的主题演讲,对利用经验启发AI发展的方法进行了总结和展望。

讲者简介:理查德·萨顿(Richard Sutton),现代计算型强化学习创始人之一,是 DeepMind 的杰出研究科学家,阿尔伯塔大学计算科学系教授,也是英国皇家学会、加拿大皇家学会、人工智能促进会、阿尔伯塔机器智能研究所 (AMII) 和 CIFAR 的研究员。

01. 背景:经验对智能发展的重要意义

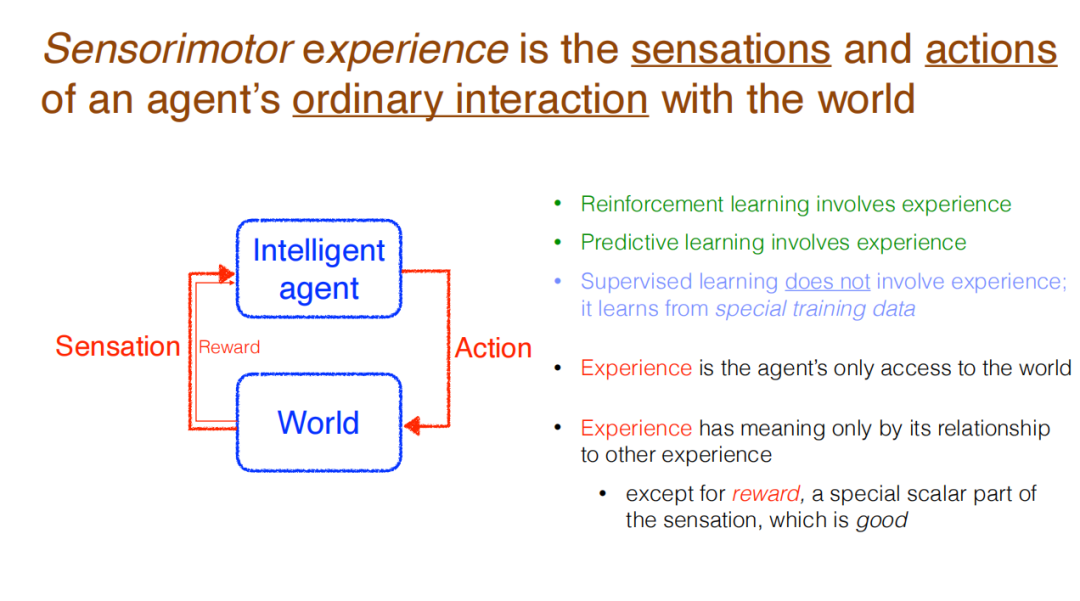

Sutton认为,智能体与外部世界发生交互,向其发出动作,并接收感知(带来的反馈)。这种涉及到经验的交互,是强化学习中正常的感知方式。也是让智能体尝试预测外部世界时所采用的正常途径。然而,这种方法在监督学习中并不多见,而监督学习是当前最为常见的机器学习类型。机器学习中并不涉及普通经验(Ordinary Experience),模型也不会从不同于普通经验的特殊训练数据中学习。事实上,在运行时,监督学习系统根本不学习。

所以说,经验是互动(带来)的数据,是与外部世界沟通的途径。经验没有任何意义,除非与其他经验之间产生联系。当然,有一个例外:经由特殊信号所表示奖励。奖励代表着好的目标,智能体当然希望能够最大化奖励。

演讲中,Sutton提出了一个核心问题:智能最终是可以被什么来解释?是客观的术语(Objective terms),还是经验的术语(Experiential terms)?前者包含外部世界的状态、目标、人、地点、关系、空间、动作、距离等不在智能体中的事物,后者则包含感知、动作、奖励、时间步等智能体内部的事物。Sutton认为,尽管研究者通常会在交流和写论文时思考客观的概念,但是现在应当更加关注有关智能体与外部世界交互过程中产生的经验。

为了进一步介绍经验对于智能体的重要意义,Richard Sutton 提出,随着经验逐渐被重视,一共经历了四个阶段。分别为:智能体(Agenthood ),奖励(Reward),经验状态(Experiential State),以及可预测知识(Predictive Knowledge)。经过这四个阶段的发展,AI逐渐拥有经验,变得更加实际、可学习且易于扩展。

02. 经验在AI发展的历程

1.智能体(Agenthood)

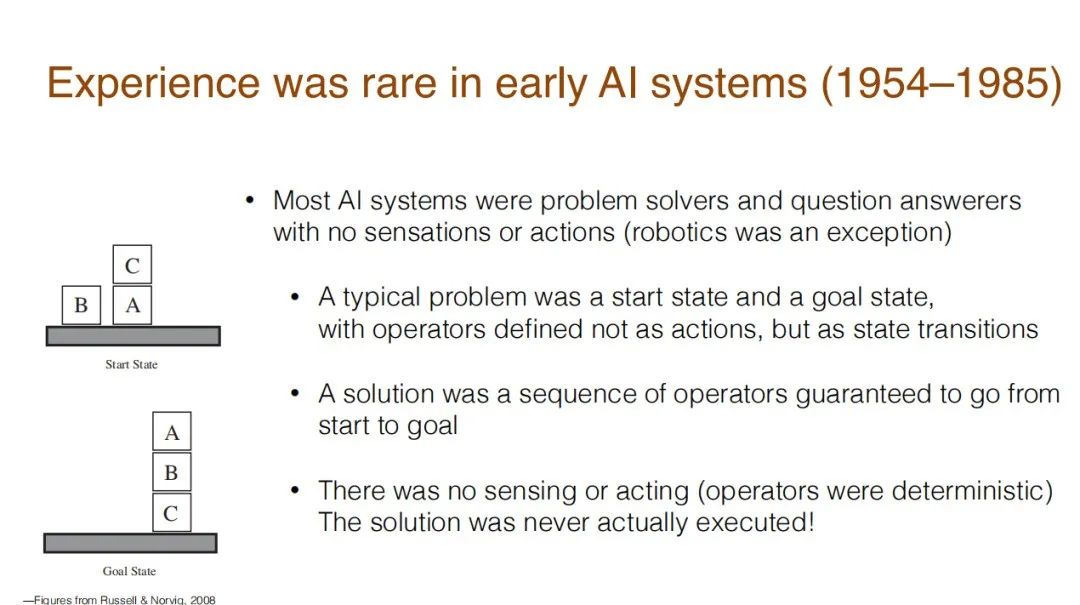

智能体的含义是拥有/获得经验(的AI)。可能令人惊讶的是,早期的AI系统确实没有任何经验。在人工智能发展的早期阶段(1954-1985年),大多数AI系统只是用来解决问题或回答问题,他们没有感知能力,也不会行动。机器人是一个例外,但传统的系统只有启动状态和目标状态,如同下图中要堆叠的积木块一样。

如果要达到恰当的目标状态,其解决方案就是一个行动序列,确保AI能够从启动状态达到目标状态。这其中没有感知和行动的存在,因为整个外部世界是已知、确定、封闭的,所以并不需要让AI感知和行动。研究者知道什么事情会发生,所以只需要构建一个解决问题的计划,让AI来执行即可,人类知道这样就能解决问题。

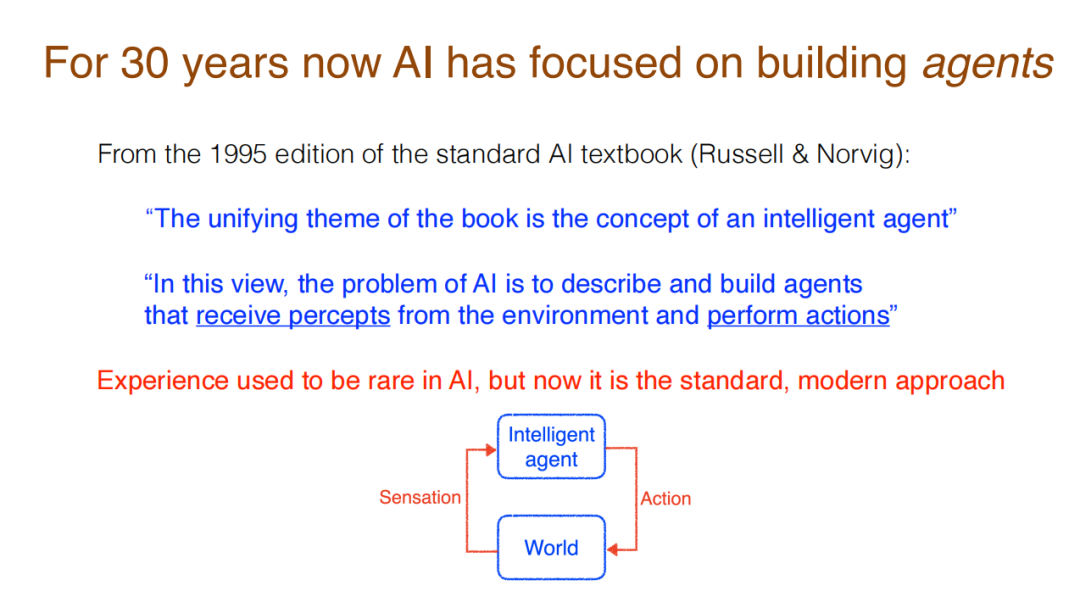

在过去30年的发展中,人工智能的研究关注构建智能体。这种转变可以体现在这一点:人工智能的标准教科书囊括了智能体的概念,将其作为基础。例如,1995年版本的《人工智能:一种现代的方法》中提到,全书的统一主题在于介绍智能体(Intelligent Agent)的概念。在这种视角下,AI的问题在于描述和构建智能体,并从环境中获得认知,并采取行动。随着研究的发展,标准、现代的方法是构建一个能够和外部世界交互的智能体。Sutton认为可以从这个视角看待AI。

2.奖励(Reward)

奖励(Reward)是以经验的形式来描述AI的目标。这也是当前提出的一种有效方法,能够构建AI的所有目标。这也是Sutton与其合作者提出的方法。

奖励被认为是目前较为充分的一种假说——智能及其相关的能力都可以被理解为是服务于最大化奖励的结果。所以有说法认为,奖励对于智能体而言已经足够了。

然而Sutton认为,这一思路是需要被挑战的。奖励并不足够实现智能。奖励仅仅只是一个数字、一个标量,它并不足以解释智能的目标。来自头脑之外,仅用单一数字表达的目标,显得太小、太还原,甚至太贬低(人类的目标)了。人类喜欢把目标想象得更宏大,如照顾家庭、拯救世界、世界和平、让世界更美好。人类的目标比最大化快乐和舒适更为重要。

正如研究者发现奖励并不是很好的构建目标的方法,研究者也发现了通过奖励构建目标的优势。奖励构建的目标太小,但是人们可以在其中取得进展——目标可以被良好、清晰地定义,且易于学习。这对于通过经验构建目标而言反而是个挑战。

Sutton认为,想象通过经验来充分地构建目标,这是有挑战的。回顾历史可以看到,AI原本也不是对奖励有兴趣的,即使是现在也是如此。所以,不管是早期的问题解决系统,还是当前最新版的AI教科书,其依然将目标定义为需要达到的世界状态(World State),而非经验性的(定义)。这种目标可能依然是特定的一系列“积木”,不是一种需要达到的感知结果。

当然,最新的教科书中已经有章节提到强化学习,并提及这些AI使用的是奖励机制。此外,构建目标的过程中,奖励已是一种常规的做法,可以使用马尔科夫决策过程来实现。对于批评奖励不能够充分构建目标的研究者(如Yann LeCun)来说,奖励已经是智能这块“蛋糕”顶端的“樱桃”了,它很重要。

在接下来的两个阶段,Sutton将介绍应当怎样从经验的角度来理解外部世界,但在此之前,他将首先介绍经验指代的是什么。

3.插曲:什么是经验

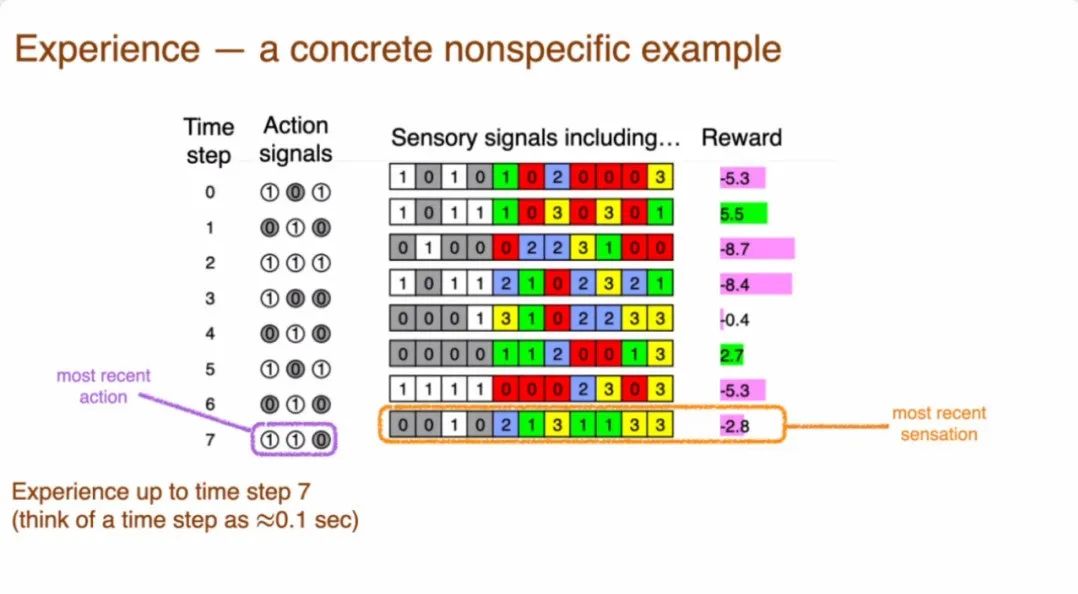

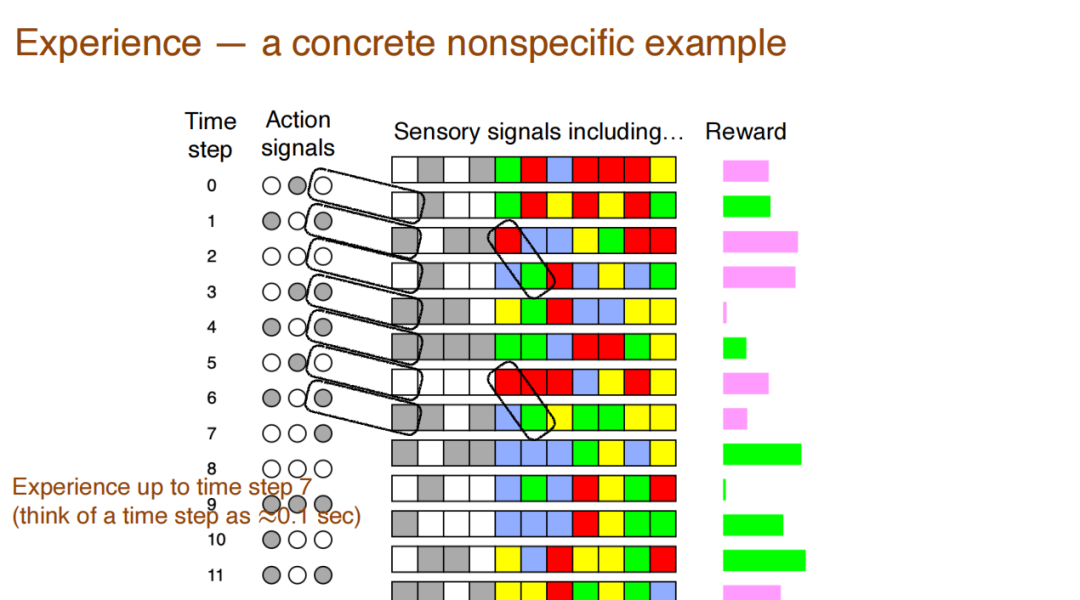

如下图的序列(非真实数据)所示,当时间步启动的时候,系统会得到感知信号,而且也会发出信号和行动。所以感知信号可能会引起一些动作,而这些动作会引起下一个感知信号。在任何时候,系统都需要关注关注最近的行动和最近的信号,这样才能决定接下来将会发生什么,应当怎样去做。

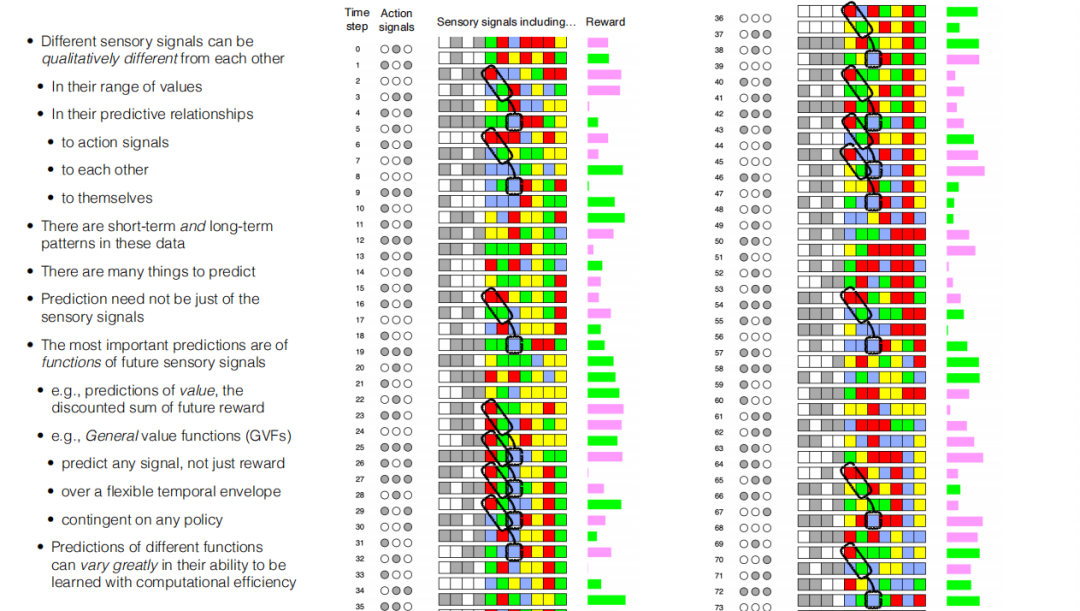

如图所示,这是一个智能体执行程序的输入输出信号阵列。第一列是时间步,每一步可认为是0.1秒或0.01秒的瞬间。行动信号列则采用二级制表示,由灰白两色表示。之后是感知信号列,其中前四列是二进制值(也使用灰白两色),后四列则采用0-3的四种取值,用红黄蓝绿四种颜色表示,最后一列则是连续变量,代表奖励。在实验中,研究者将数字去掉,只留下颜色,以便于在其中寻找模式。Sutton认为,经验,是指对感觉-运动经验的数据中发现的模式产生的知识和理解。

在本案例中,Sutton列举了四个典型的模式:

1.行动的最后一位,和紧随其后的感知信号是相同的。如果某一时间步的行动是白色的,其后的第一个感知信号也是白色,灰色亦然。

2.当出现红像素时,紧随其后的一个时间步是绿色像素。扩大数据范围后可以发现,在红绿像素先后出现后,隔一个时间步会出现蓝色像素。

3.数据的最后三列往往会出现一长串同样颜色,保持不变。一种颜色一旦开始,会持续多个时间周期,最终形成条纹。如很长的一串红色、绿色、蓝色等。

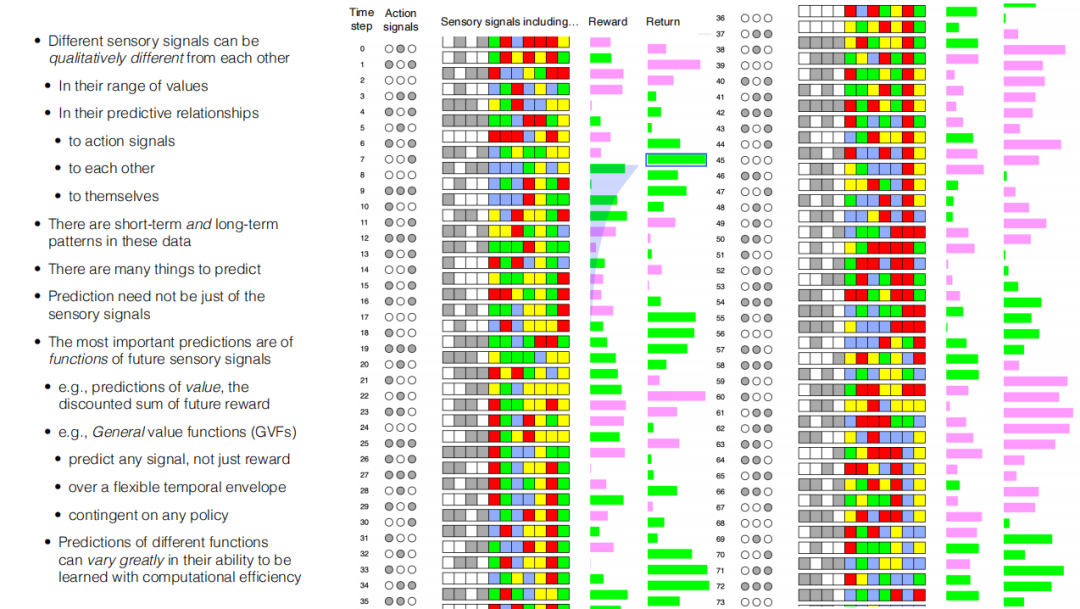

4.如果展示AI预测的特定感知数据,很多时候这是无法立刻被观察到的,因此在本数据中增加返回值(Return),其代表着对将会到来的奖励的预测。框中的绿色条带代表了随后的奖赏中,绿色会比红色多。这代表着当前对于奖励的预测。

特殊的阴影区域则表示等待函数。等待函数的阴影区域中会有绿色和红色的条带。在这里,研究者将越早返回的,带有颜色奖励给予更高的权重。当随着返回值根据时间移动时,就可以看到预测结果和实际奖励之间的颜色和值的对应变化,这种返回值便是一种预测——其可以从经验中学习到。

Sutton认为,这种返回值本质上并不是从已经发生的事件中学习的,而是从时间差信号中学到的。其中最重要的信号就是价值函数。在本例中,返回值实际上是一个价值函数,代表的是对于未来奖励的总和。如果想要一个一般形式的,复杂的,能够指代未来值的函数,可采用名为一般价值函数(General Value Functions GVFs)的方法。一般价值函数包括了各种信号,不仅仅是奖励;可以是任何时间包络形式,而不仅仅是指数。一般价值函数还可以包括任何队列的策略,可以预测数量非常多,范围很广的事情。当然,Sutton认为,通过计算进行预测,其难易程度取决于被预测对象的形式。当使用一般价值函数进行预测时,被预测对象的表达形式需要被设计成易于学习的形式,且需要很高的计算效率。

4.经验状态(Experiential State)

提到“状态”这个词,很多研究会提到的是世界状态(World State),这是一个属于客观概念之下的词语。状态指的是对客观世界的一种符号化的描述(反映),能够和世界本身的情况匹配。例如,对于积木块的位置信息(C在A上)等。在最近的一段时间,一些研究者(如Judea Pearl)提出了概率图模型,其表示的是世界状态的概率分布。一些事件,如“外面下雨,草地是否是湿的?”等,这些事件之间都存在概率关系。

另一种状态是信念状态(Belief State),在这种概念中,状态是一种概率分布,表示的是离散世界的状态,其对应的方法被称为POMDPs(Partially observable Markov decision process)——存在隐藏状态变量,其中部分是可观察到的,可以使用马尔科夫决策过程进行建模。

以上的方法均是客观的状态,与经验相距甚远,是研究者一开始尝试描述世界状态的方法。

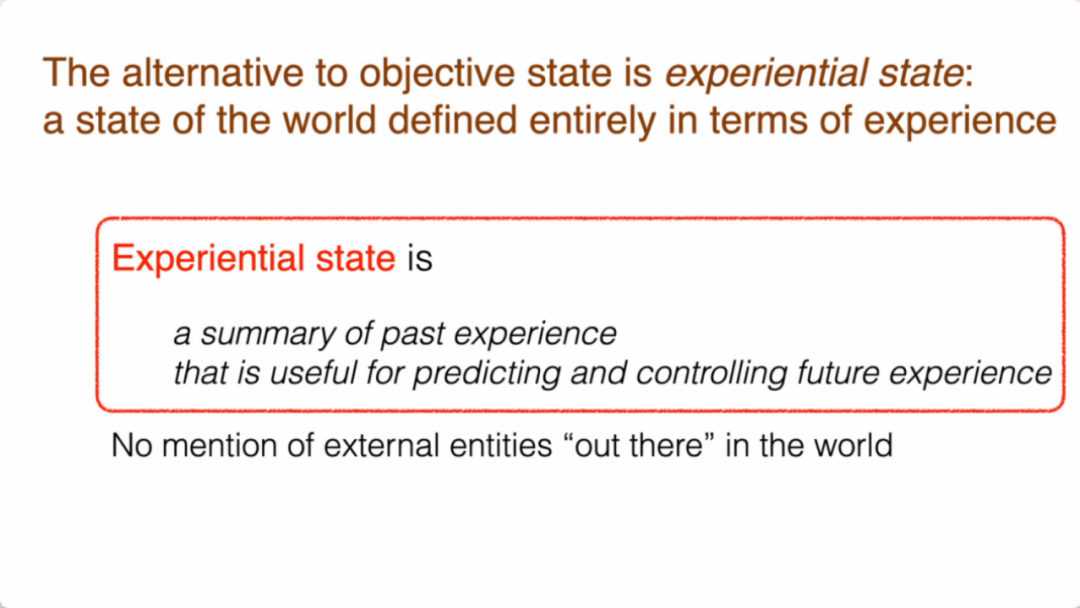

而与之不同的,是经验状态。Sutton认为,经验状态指的是整个世界的状态根据经验来定义。经验状态是过去经验的总结,能够预测和控制未来将会获得的经验。

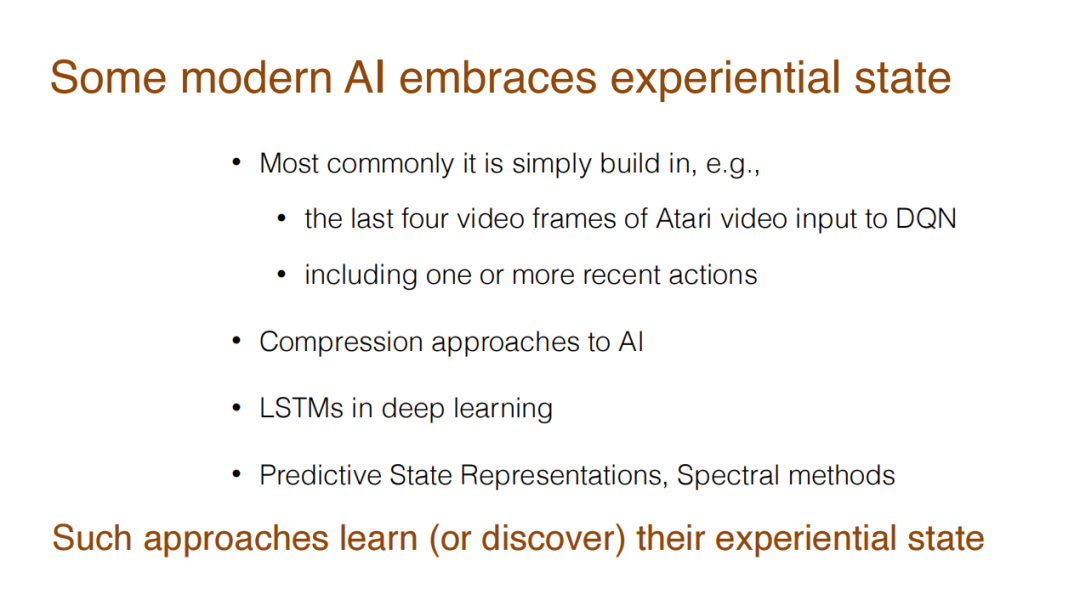

这种构造过去经验,预测未来的做法,在研究中已有体现。例如,强化学习任务之一——雅达利游戏中,研究者会用最后四帧的视频构建经验状态,然后预测之后的行为。LSTM网络中的一些方法,也可以被认为是从某种经验状态中进行预测。

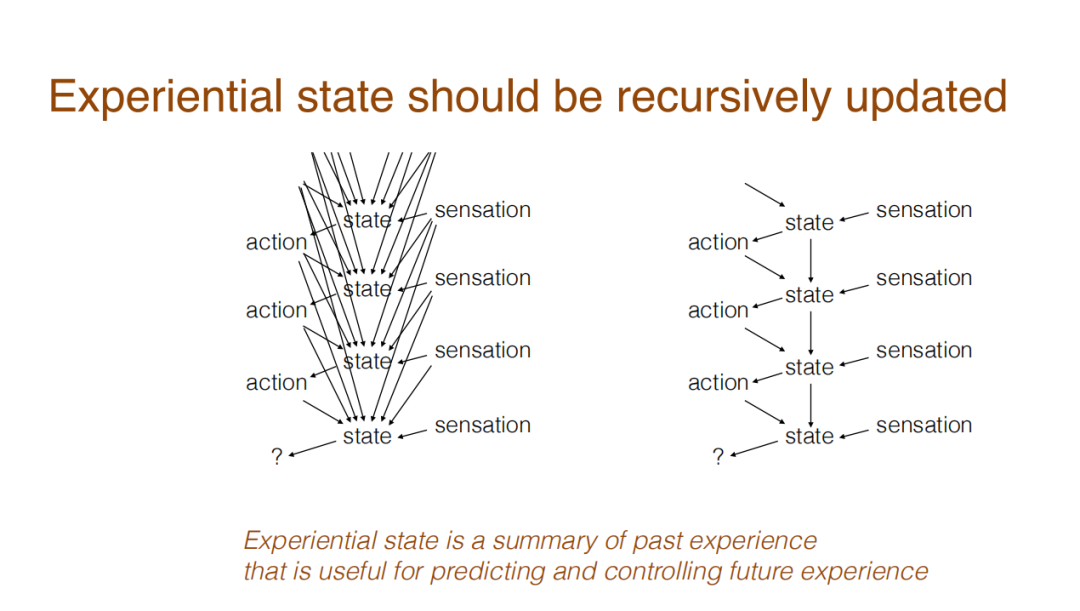

回看经验状态,它是可以递归更新的。经验状态是整个过去发生事情总结的函数,由于AI需要每时每刻访问经验状态,实现对接下来发生事件的预测,所以经验状态的更新是递归式的:当前时刻只访问上一时刻的经验状态,而上一时刻经验状态是对过去所有发生过的事件的总结。到了下一个时刻,也只访问此时此刻的经验状态,而这个经验状态也是对过去发生的所有事件的总结。

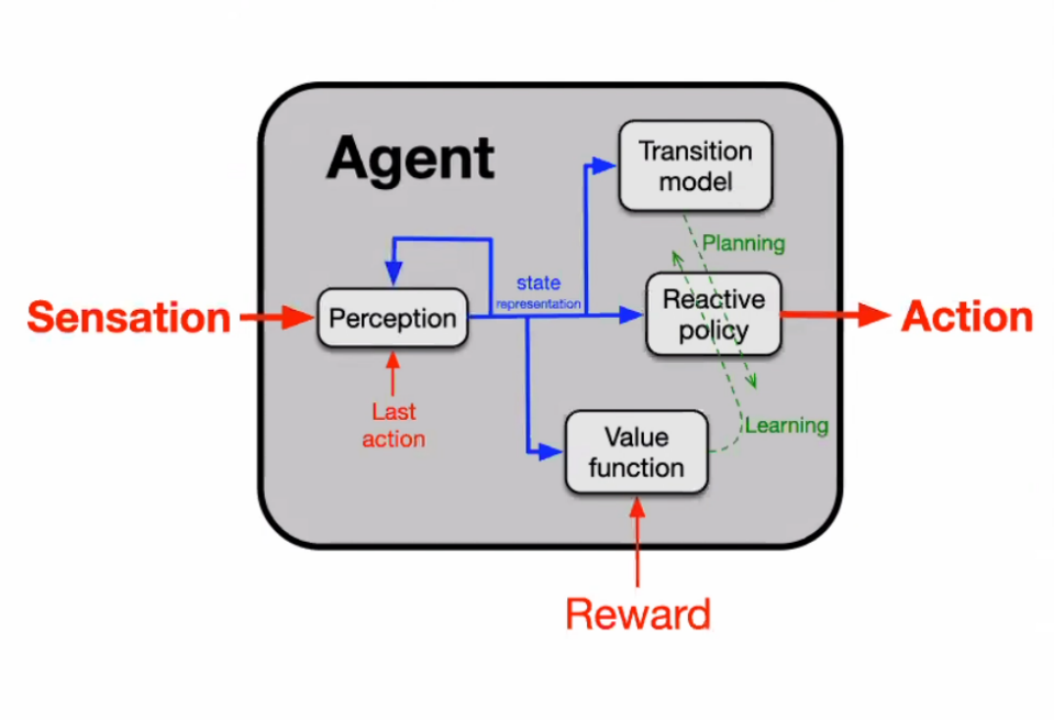

下图显示了智能体经验状态的构造过程。其中,红色箭头表明智能体的基础工作信号,包括:感觉、行动、奖励等。蓝箭头标注的是经验状态(表征)的方向,从感知中输出,其负责对每个时间步更新其经验状态。更新的状态会被用来为行动制定策略,或进行其他更新。

5.预测性知识(Predictive Knowledge)

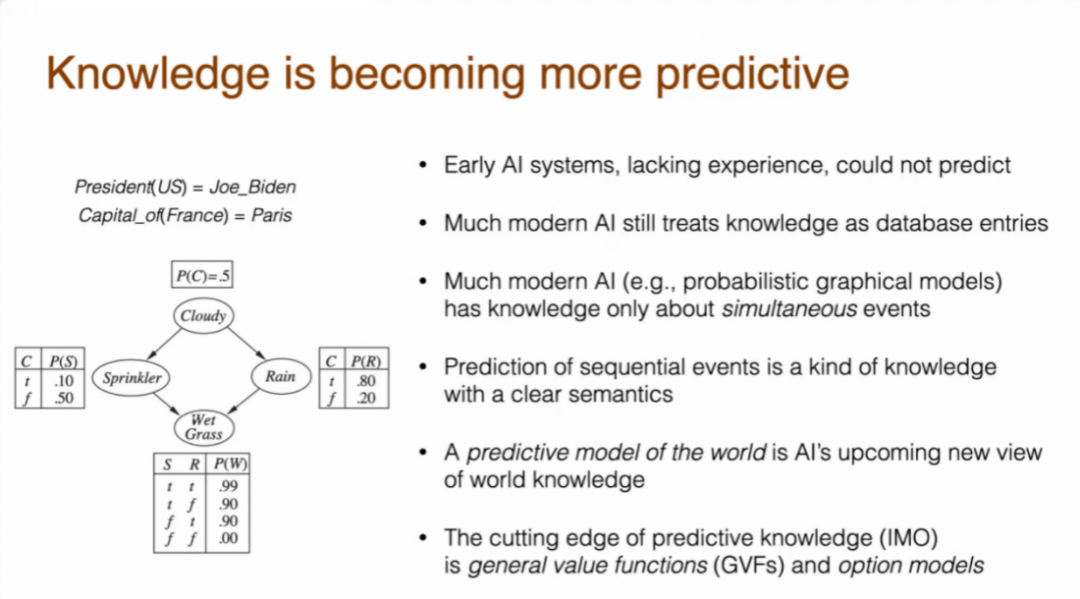

知识,如“乔拜登是美国总统”,“埃菲尔铁塔在巴黎”等,都是对于外部客观世界的一种描述,并不是经验性的。但是,类似于“做某事预计花费X小时”这类知识,是经验知识。经验知识和客观知识之间存在着巨大的差异,这也是对于AI研究具有挑战性的一点。

以往的AI研究倾向于将知识视为一种客观项,尽管近期已经有一些研究从经验的角度来看待问题。早期的AI系统没有经验,也就无法进行预测。而更现代一些的AI将知识视为客观的存在。更为先进一些的是概率图模型,但是很多时候其研究的是两件同时发生的事情之间的概率,而预测面向的应该是一连串序列事件。

基于对序列事件的预测是具有明确语义属性的知识。如果某事情被预测会发生,AI就可以将预测和实际结果对比。而这种预测模型,可以被认为是一种新的世界知识,即预测性知识。而在预测性知识中,Sutton认为最前沿的就是通用价值函数(General Value Function)和选择模型(Option Model)。

Sutton 把世界知识分为两类,一是关于世界状态的知识;二是关于世界状态转换的知识。有关世界状态转换知识的案例是世界预测模型。此处的的世界预测模型,并不是初级形态的马科夫决策过程或差分方程。它可以是抽象的状态,在经验状态中可以被抽取出来。由于预测是以整个行为为条件进行的,所以在选择模型中,智能体也可以选择停止某个策略,终结某种条件。有时候,使用对于旋律的迁移模型,可以预测进行了某个行动后的状态。以日常生活为例,假设某人要去城里,他/她会对前往市中心的距离、时间进行一个预测,对于超过某个阈值的行为(如步行10分钟进城),就会进一步预测出一个状态,如疲惫等。

有了这种能够延伸行为的模型,其知识所表示的规模也可以非常的大。例如,可以根据一个行为,预测世界状态,然后根据状态再预测下一个行为......以此类推。

总结经验在AI研究中的发展历程,Sutton表示,经验是世界知识的基础,人类本身是通过感知和行动来认识和影响世界的,经验是人类获得信息、采取行动的的唯一方式,而且是人类离不开的。遗憾的是,由于经验过于主观化和个人化,人类仍然不喜欢用经验的方式去思考和表达。经验对于人类太过陌生、反直觉、短暂、复杂。而经验也是主观、私人的,与他人进行交流,或者进行验证几乎是不可能的。

Sutton认为,经验对于AI十分重要,有以下几个原因。一是经验来自于AI的日常运行过程,获得这些经验是无成本的、自动的。同时,AI领域有大量的数据用于计算,因此经验提供了通向了解世界的道路,如果世界中的任何事实都是经验性的,那么AI可以从经验中学习对世界的认识,并在经验中进行验证。

总结而言,Sutton认为,过去70年的AI发展历程中,AI逐渐在增加对经验的重视——获得经验、根据经验设定目标、并根据经验获得状态和知识。在每一个阶段,对于人类更为陌生的经验研究正在变得更加重要,而且其具有接地气(Grounding)、可学习和可扩展的优势。

03. 未来AI利用经验的方法

Sutton认为,目前对于经验利用方面,AI还未完成阶段三和四,但是这种趋势向前会越走越远。Sutton认为,将一切都归于经验,是通向真正AI的可行路径。尽管非常具有挑战性,但这是能够理解数据流,实现智能的图景。最后,Sutton进一步凝炼重视感知运动经验的四个阶段,形成一句标语:“数据驱动着人工智能,而经验就是终极的数据。如果能利用好经验,我们就可以更快速有力地推动人工智能发展。”