本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

一场针对特斯拉的调查,在社交媒体上掀起了轩然大波。

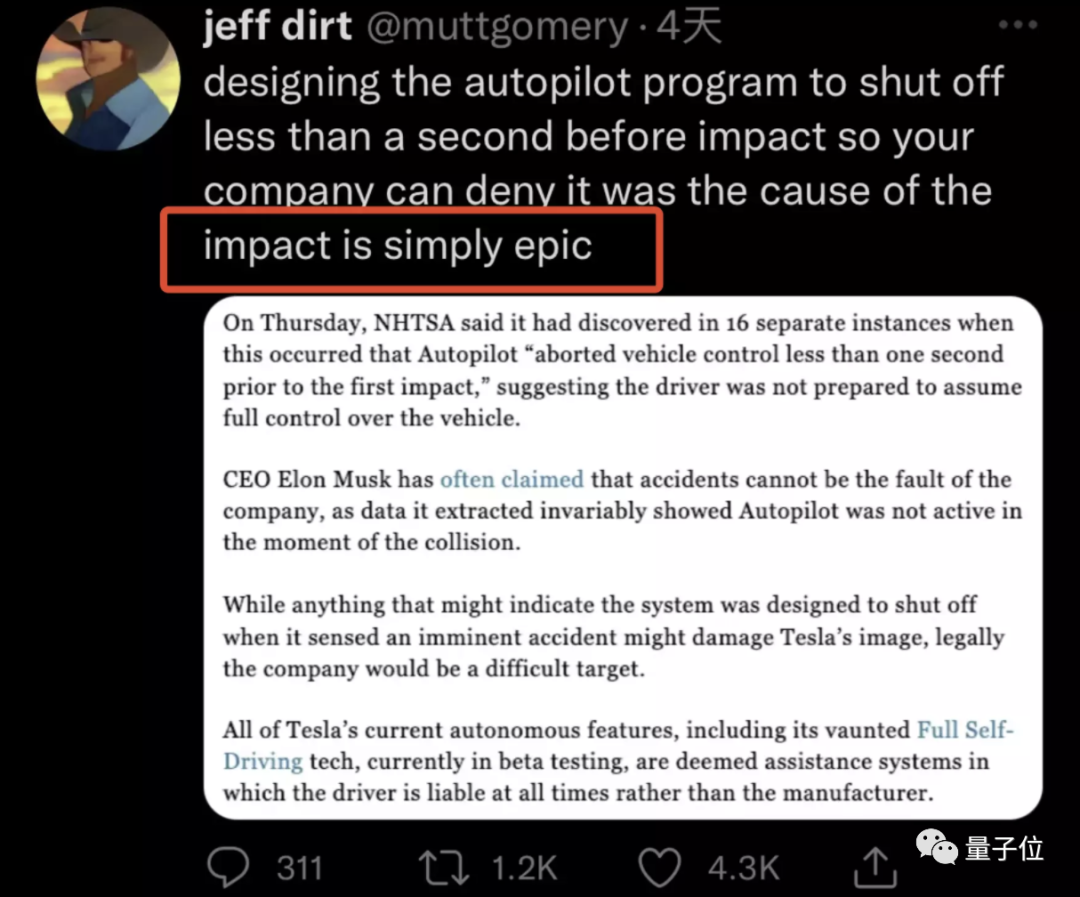

甚至有网友用“史诗级”来形容这次调查的发现:

这份调查来自美国高速公路安全管理局(NHTSA),而在曝光的文件中,有一句话显得格外醒目:

Autopilot aborted vehicle control less than one second prior to the first impact.

在撞击前不到1秒钟,Autopilot中止了对车辆的控制。

NHTSA发现的这个事,宛如向民众投掷了一枚重磅炸弹。

因为它就好比“车在撞到你之前,机器人才把方向盘交到你手上”……

然后许多网友就纷纷展开了质疑:

如此设计,特斯拉就可以否认事故是因为Autopilot了?

啊,这……

事故前不到一秒,把方向盘交到你手上

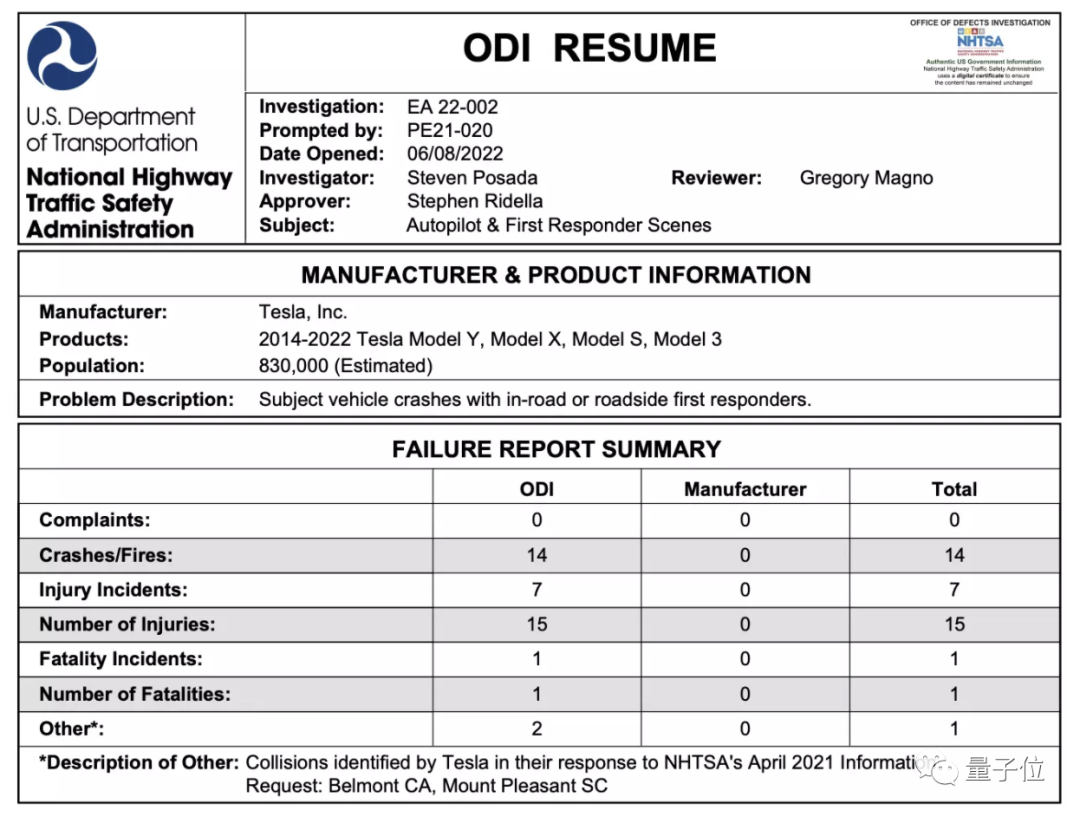

NHTSA对特斯拉的调查自去年8月就已经开始。

展开调查的直接原因,是有不止一辆特斯拉在开启自动驾驶系统Autopilot的情况下,闯入已有事故现场,撞上明明早已停在路边的急救车、警车或者出事车辆。

不查不知道,一查吓一跳。

他们发现,在16起这样的事故中,在碰撞发生之前,大多数车辆的Autopilot都激活了前向碰撞警告(FCW)。随后大约一半车辆的自动紧急制动(AEB)也进行了主动干预。

不过最后都失败了(有一人不幸死亡)。

可怕的是,平均而言,这16起事故中,Autopilot都是在汽车发生实际撞击前不到一秒才中止了控制。

而这,完全没有给够人类司机接手的时间。

事故视频显示,人类司机基本上在碰撞前8秒都注意到了前方的已有事故现场。

但其中11起事故的法庭数据显示,在碰撞前2-5秒内,没有人类驾驶员采取回避措施,虽然他们都按照Autopilot的要求,把手放在方向盘上。

或许大多数驾驶员彼时彼刻仍然“相信”Autopilot——其中有9辆车的驾驶员在碰撞前的最后一分钟内都没有对系统发出的视觉警报或提示音警报作出反应。

不过也有四辆车根本就没给出任何警报。

现在,为了进一步摸透Autopilot和相关系统的安全性(究竟能在多大程度上破坏人类司机的监督从而加剧风险),NHTSA决定把这一初步调查升级为工程分析 (EA)。

并将涉及车辆扩大到特斯拉现有所有四种车型:Model S、Model X、Model 3和Model Y,共计83万辆。

而此调查结果一经曝光,就开始有受害者现身说法。

一位用户就表示,早在2016年的时候,她的Model S也是在变道时撞上了停在路边的一辆车。但特斯拉却告诉她,这是她的错,因为她在撞车前踩下了刹车,导致Autopilot脱离了控制。

该女士称,可是这时系统发出了警报了呀。等于我怎么做都有错呗,我不踩刹车又得赖我不注意警报。

不过马斯克并未就此事作为回应,只是恰巧在网友爆料发生后6小时,发了一条推特,扔出了NHTSA早在2018年对特斯拉的一个调查报告。

该报告称特斯拉的Model S(2014年出产)和Model X(2015年出产)经NHTSA先前的所有测试,就已经证明这两种车型是所有车中发生事故后受伤概率最低的。

现在他们又发现,新出的Model 3(2018年出产)居然又取代Model S和Model X排为了第一。

△ 特斯拉还借机作了一波宣传

这是对前几日上海特斯拉车祸中“车毁人未受伤”事件的回应。

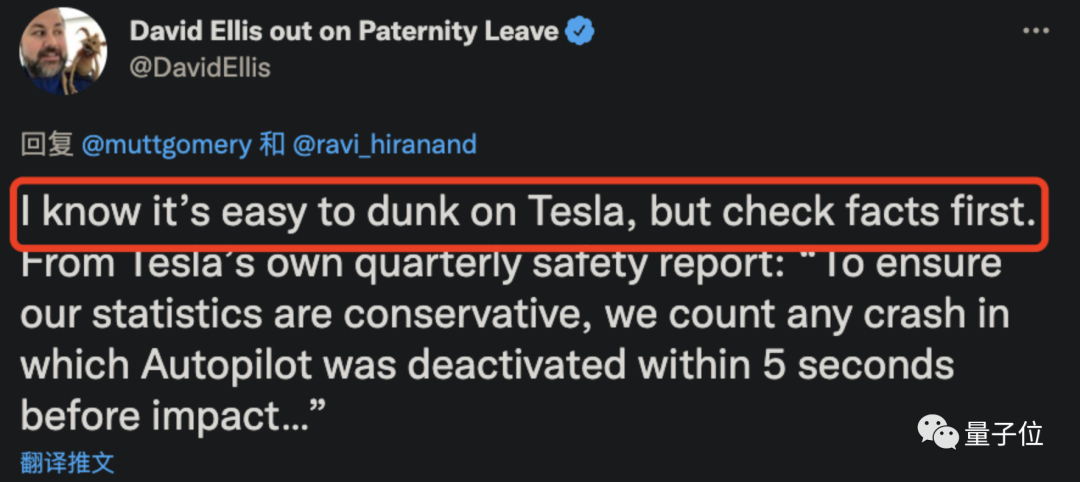

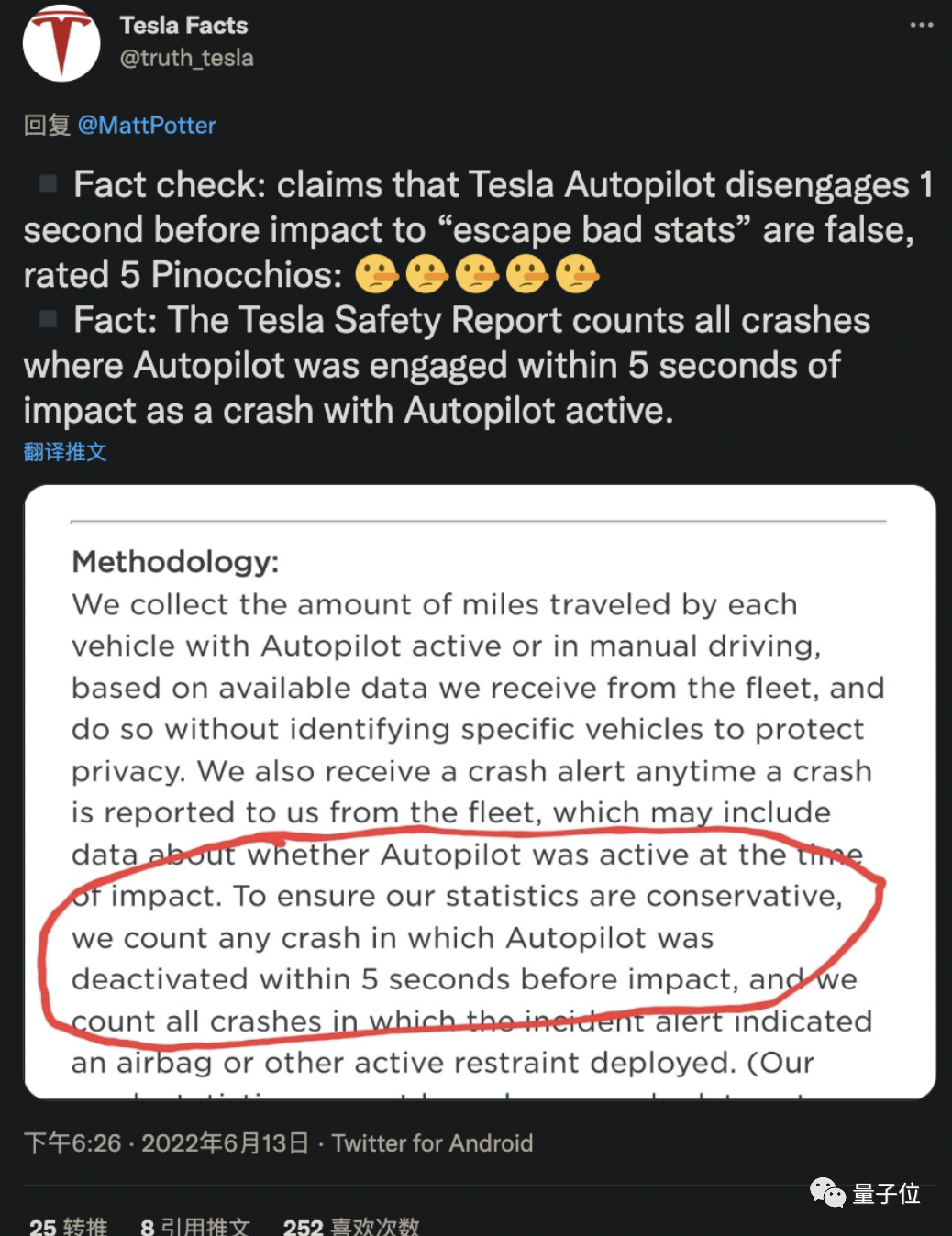

有意思的是,就在大家都在声讨特斯拉自动驾驶这么不靠谱时,有人站了出来,称大家黑特斯拉黑“魔怔”了吧。

实际上,特斯拉在事故发生1秒前中断Autopilot并不会将锅甩给人类,他们在统计特斯拉事故时,只要碰撞发生时5秒内Autopilot在工作,就会把责任算给Autopilot。

而后,特斯拉官方也出来证实了这一规则。

不过,虽说人类不用背锅了,但事故发生1秒前才将自动驾驶切断这一“骚操作”,还是无法改变人类驾驶员来不及接过方向盘的事实。

Autopilot,到底靠不靠谱?

在看完NHTSA的调查结果后,我们回头来看看这次舆论焦点的Autopilot。

Autopilot是出自特斯拉的一套高级驾驶辅助系统(ADAS),处于国际汽车工程师学会(SAE)提出自动驾驶等级中的L2。

(SAE将自动驾驶分为了六个等级,从L0至L5)

根据特斯拉官方的描述,Autopilot目前具备的功能包括在车道内自动辅助转向、加速和制动,自动泊车,以及从车库或停车位“召唤”汽车等。

那么这是否意味着驾驶员可以完全“托管”了呢?

并非如此。

特斯拉目前阶段的Autopilot只是能起到“辅助”的作用,并非是完全自动驾驶。

而且还需要驾驶员“主动”、“积极”地去监督Autopilot。

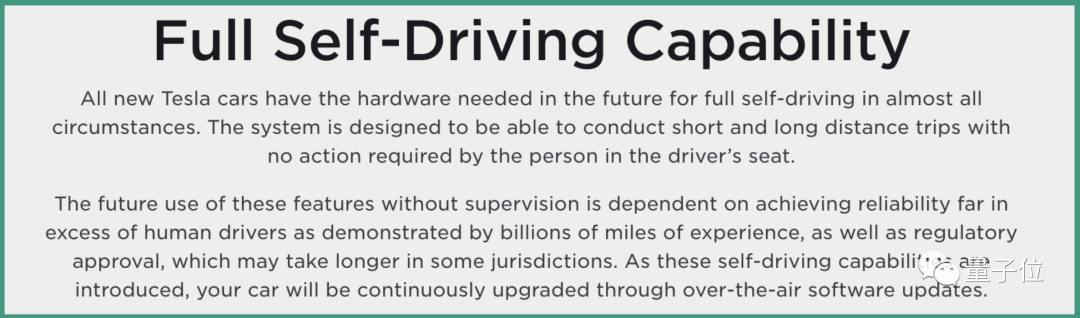

但在官方介绍中,特斯拉对于“全自动驾驶”的能力也做了些许的描述:

所有新款特斯拉,都具备未来几乎所有情况下完全自动驾驶所需的硬件。

能够在不需要驾驶员的情况下,进行短途和长途的旅行。

不过要想让Autopilot实现上面的这些目标,很重要的一点就是在安全性方面远超人类。

在这一方面,特斯拉表示已经在数十亿英里的实验中证明了这一点。

而且马斯克也不止一次地对特斯拉的安全性发声:

特斯拉全自动驾驶的安全水平远高于普通司机。

但事实是这样吗?

暂不论特斯拉和马斯克给出的评价,单就从现实角度出发,特斯拉的Autopilot在安全性方面可谓是饱受的争议。

例如屡见不鲜的“幽灵刹车”事件,便将其再一次又一次推向舆论的风口浪尖,也是NHTSA展开这次调查的主要原因之一。

“幽灵刹车”,指的是当驾驶员开启特斯拉Autopilot辅助驾驶功能以后,即便车辆在前方没有障碍物或者不会与前车发生碰撞的前提下,特斯拉车辆会进行非必要的紧急刹车。

这就给驾驶员以及道路中的其它车辆带来巨大的安全隐患。

不仅如此,若是细扒与特斯拉这家公司相关的热点事件,不难发现有许多都是与Autopilot的安全性相关:

那么NHTSA对此又是怎么看的呢?

在这份文件中NHTSA提醒,目前市面上没有完全自动驾驶的汽车,“每辆车的都要求驾驶员在任何时间都要处于控制状态,所有州的法律都要求驾驶员对其车辆的操作负责。”

至于这份调查将来会对特斯拉造成什么影响,根据NHTSA的说法:

如果存在与安全相关的缺陷,有权向制造商发出“召回请求”信。

……

最后,做一个小调查——你是否信任Autopilot呢?

完整报告:

https://static.nhtsa.gov/odi/inv/2022/INOA-EA22002-3184.PDF