本文转自雷锋网,如需转载请至雷锋网官网申请授权。

在一个隔音的板条箱里有着一个世界上最糟糕的神经网络。在看到数字6的图像后,这个神经网络会暂停片刻,然后显示出自己识别出的数字:0。

康奈尔大学的物理学家兼工程师Peter McMahon主导了这个神经网络的开发,他不好意思地笑着说,这是因为手写的数字看起来很潦草。一位从NTT研究所来访问McMahon实验室的博士后Logan Wright说,这个设备通常会给出正确的答案,不过他也承认,出错也很常见。尽管表现平平,但这种神经网络是一个开创性的研究。研究人员把板条箱翻了过来,露出的不是电脑芯片,而是一个话筒,话筒朝着固定在扬声器上的钛板倾斜。

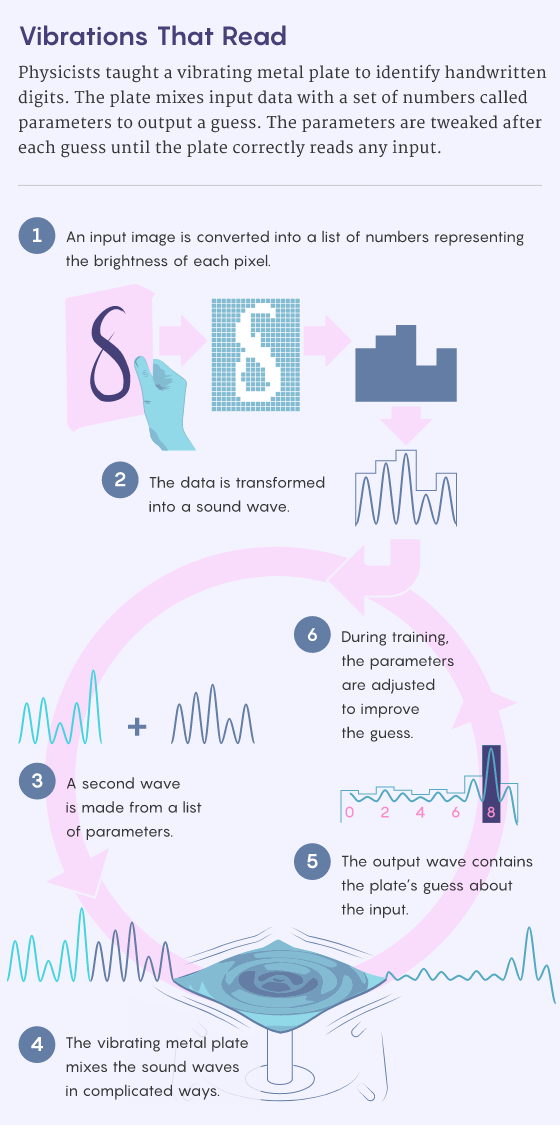

不同于运行在0和1的数字世界中的神经网络,这个设备是以声音原理运行的。当赖特给出一个数字的图像时,图像的像素被转换成音频,然后扬声器振动钛板,使得实验室里充满了微弱的叽叽喳喳声。也就是说进行“读取”操作的是金属回声,而不是运行在硅芯片上的软件。

这款设备的成功让人觉得难以置信,就连其设计者也不例外。McMahon说:“无论震动金属的作用是什么,都不应该与对手写数字进行分类有任何关系。”今年1月,康奈尔大学的研究小组在《Nature》杂志上发表了一篇论文,标题是“反向传播训练的深度物理神经网络(Deep physical neural networks trained with backpropagation)”。

这篇论文介绍了这种设备的原始阅读能力,这给McMahon和其他人带来了希望,这告诉他们,该种设备进行多次改进后可能会给计算带来革命性的变化。

论文链接:https://www.nature.com/articles/s41586-021-04223-6当谈到传统的机器学习时,计算机科学家发现神经网络越大越好。具体原因可以参见下图中的文章,这篇叫做“计算机科学家证明为什么越大的神经网络表现越好(Computer Scientists Prove Why Bigger Neural Networks Do Better)”的文章中证明了:如果希望网络能够可靠地记住其训练数据,那么过度参数化不仅有效,而且还需要强制性执行。

文章地址:https://www.quantamagazine.org/computer-scientists-prove-why-bigger-neural-networks-do-better-20220210/一个神经网络中填充更多的人工神经元(存储数值的节点),可以提高其区分腊肠犬和达尔马提亚犬的能力,也可以使其成功完成无数其他模式识别任务。

真正巨大的神经网络能够完成写论文(如OpenAI的GPT-3)、画插图(比如OpenAI的DALL·E、DALL·E2和Google的Imagen),以及更多让人细思极恐的高难度任务。有了更多的计算能力,更伟大的壮举也便成为可能。这种可能性鼓励着人们努力开发更强大、更高效的计算方法。McMahon和一群志同道合的物理学家拥护一种非常规的方法:让宇宙为我们处理数据。

McMahon说:“许多物理系统自然能够比计算机更高效或更快地进行某些计算。”他以风洞为例:当工程师们设计一架飞机时,他们可能会把蓝图数字化,然后花几个小时在超级计算机上模拟机翼周围的空气流动。或者,他们也可以把飞行器放在风洞里看看能不能飞起来。从计算的角度来看,风洞可以立即“计算”飞机机翼与空气的相互作用。

图注:康奈尔大学团队成员Peter McMahon和Tatsuhiro Onodera在为完成学习任务的各种物理系统编写程序。

图源:Dave Burbank风洞能模拟空气动力学,是一种功能专一的机器。

像McMahon这样的研究人员正在研究一种可以学习做任何事情的设备——一种可以通过试错来调整自身行为从而获得任何新能力的系统,比如对手写数字进行分类,或者区分一个元音和另一个元音等能力。

最新研究表明,像光波、超导体网络和电子分支流这样的物理系统都可以进行学习。瑞士苏黎世联邦理工学院的数学家Benjamin Scellier说,他帮助设计了一种新的物理学习算法,“我们不仅在重塑硬件,还重塑了整个计算范式”。

1 学习思考

学习是一个极为独特的过程,在十年以前,大脑是唯一能做到学习的系统。正是大脑的结构在一定程度上启发了计算机科学家设计深度神经网络这个目前最流行的人工学习模型。深度神经网络是一种通过实践来学习的计算机程序。

深度神经网络可以被认为是一个网格:用来存储值的节点层被称为神经元,神经元通过线连接到相邻层的神经元,这种线也叫“突触”。最初,这些突触只是被称为“权重”的随机数。想让网络读取4,可以让第一层神经元表示4的原始图像,可以将每个像素的阴影作为一个值存储在相应的神经元中。

然后网络进行“思考”,一层一层地移动,用神经元值乘以突触权值来填充下一层神经元。最后一层中值最大的神经元就是神经网络的答案。例如,如果这是第二个神经元,网络猜测自己看到了2。为了教网络做出更聪明的猜测,学习算法会反向工作。在每次尝试之后,它会计算出猜测和正确答案之间的差值(在我们的例子中,这个差值将由最后一层的第四个神经元的高值和其他地方的低值表示)。

然后,算法通过网络一层一层地往回走,计算如何调整权值,以使最终神经元的值根据需要上升或下降。这个过程被称为反向传播,是深度学习的核心。通过重复多次猜测和调整,反向传播将权重引导到一组数字,这些数字将通过一幅图像发起的级联乘法输出结果。

图源:Quanta 杂志Merrill Sherman但与大脑的思考相比,人工神经网络中的数字化学习看起来效率非常低。在每天摄入不到2000卡路里热量的情况下,一个人类儿童在几年内就能学会说话、阅读、玩游戏以及更多的东西。在如此有限的能量条件下,能够流畅对话的GPT-3神经网络可能需要一千年才能学会聊天。

从物理学家的角度来看,一个大型数字神经网络只是试图去做过多的数学运算。如今最大的神经网络必须记录和操纵超过5000亿个数字。这个惊人的数字出自下图中的论文“Pathways 语言模型 (PaLM):扩展到 5400 亿个参数以实现突破性性能(Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance)”:

论文链接:https://ai.googleblog.com/2022/04/pathways-language-model-palm-scaling-to.html与此同时,宇宙不断出现的任务远远超出了计算机微薄的计算能力的极限。一个房间里可能有数万亿的空气分子在四处弹跳。

对于一个成熟的碰撞模拟来说,这是计算机无法追踪的移动对象的数量,但空气本身却能轻松决定自己每时每刻的行为。我们目前的挑战是建立一个能够自然完成人工智能所需两个过程的物理系统,这两个过程分别是——对图像进行分类的“思考”,以及正确分类这类图像所需的“学习”。

一个掌握了这两项任务的系统才是真正利用了宇宙的数学能力,而不仅仅是做数学计算。“我们从来没有计算过3.532乘以1.567之类的,”Scellier说。“系统会计算,不过是通过遵循物理定律的方式隐含地计算。”

2 思考部分

McMahon和合作学者们已经在这个谜题的“思考”部分取得了进展。在新冠疫情发生前的几个月,McMahon在康奈尔大学建立了实验室,他仔细思考了一个奇怪的发现。多年来,表现最出色的图像识别神经网络已经变得越来越深度。也就是说,有更多层的网络能够更好地接收一堆像素并给出标签,如“狮子狗”。

这一趋势启发数学家们研究神经网络实现的转换(从像素到“狮子狗”),在2017年几个小组在论文“任意深度残差神经网络的可逆结构(Reversible Architectures for Arbitrarily Deep Residual Neural Networks)”中提出,神经网络的行为是一个平滑数学函数的近似版本。

论文地址:https://arxiv.org/abs/1709.03698在数学中,函数将输入(通常是x值)转换为输出(曲线在这个位置的y值或高度)。在特定类型的神经网络中,层数越多效果越好,因为函数不那么参差不齐,更接近于某种理想曲线。这项研究引起了McMahon的思考。

也许通过一个平稳变化的物理系统,人们可以避开数字方法中固有的阻塞。诀窍在于找到一种驯化复杂系统的方法——通过训练来调整它的行为。McMahon和他的合作者选择钛板作为这样一个系统,因为钛板的许多振动模式以复杂的方式混合传入的声音。

为了使平板像神经网络一样工作,他们输入一种编码输入图像的声音(例如手写的6)和另一种表示突触权重的声音。声音的峰值和波谷需要在正确的时间撞击钛板,以便设备合并声音并给出答案——例如,一个新的声音在六毫秒内最响,代表“6”的分类。

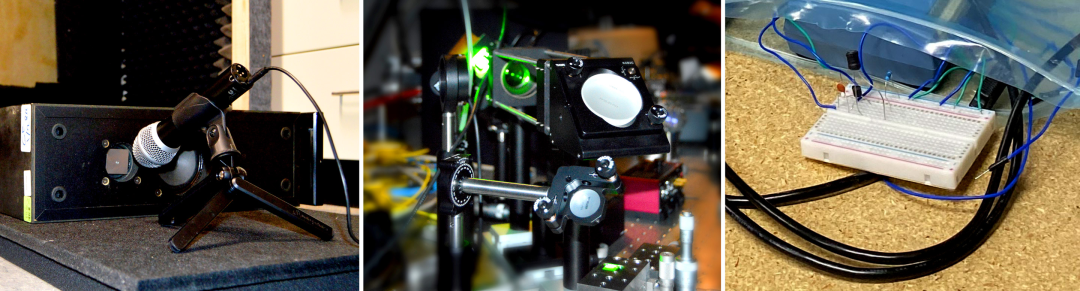

图注:康奈尔大学的一个研究小组训练了三种不同的物理系统来“读取”手写数字:从左到右分别是一个振动的钛板、一个晶体和一个电子电路。图源:左图中图为康奈尔大学Rob Kurcoba摄;右图为Quanta 杂志 Charlie Wood摄。该小组还在一个光学系统中实现了他们的方案——输入图像和权重被编码在两束由晶体混合在一起的光束中——以及一个能够类似地变换输入的电子电路中。

原则上,任何具有拜占庭行为的系统都可以如此,但是研究人员相信光学系统具有特殊的前景。晶体不仅能极快地混合光线,而且光线还包含了关于世界的丰富数据。McMahon想象他的光学神经网络的微缩版本有一天会成为自动驾驶汽车的眼睛,能够识别停车标志和行人,然后将信息输入汽车的计算机芯片,就像我们的视网膜对进来的光进行一些基本的视觉处理一样。

然而,这些系统的致命弱点在于,训练它们需要回归数字世界。反向传播涉及到反向运行神经网络,但是底片和晶体不能轻易地分解声音和光。因此,该团队为每个物理系统构建了一个数字模型。在笔记本电脑上反转这些模型,他们可以使用反向传播算法来计算如何调整权重以给出准确的答案。

通过这一训练,这块钛板学会了对手写数字进行分类,正确率为87%。而上图中的电路和激光的精度分别达到93%和97%。研究结果表明“不仅标准的神经网络可以通过反向传播进行训练,”法国国家科学研究中心(CNRS)的物理学家Julie Grollier说,“这太美了。”

该研究小组的振动钛板还没有使计算的效率接近大脑的惊人效率,这个设备甚至不及数字神经网络的速度。但McMahon认为他的设备十分惊人,因为这种设备证明了人不只可以用大脑或电脑芯片来思考。“任何物理系统都可以是神经网络。”他说。

3 学习部分

另一个的难题是——如何让一个系统完全自主学习。德国马克斯·普朗克光科学研究所的物理学家Florian Marquardt认为,有一种方法是建造一台倒着运行的机器。去年,他和一个合作者在论文“基于Hamiltonian回波反向传播的自学习机器(Self-learning Machines based on Hamiltonian Echo Backpropagation)”中提出了一个可以在这样的系统上运行的反向传播算法的物理模拟。

论文地址:https://arxiv.org/abs/2103.04992为了证明这是可行的,他们用数字技术模拟了一种类似于McMahon设备的激光装置,将可调的权重编码在一种光波中,与另一种输入波(编码,比如图像)混合。他们使输出更接近正确的答案,并使用光学组件来分解波,反转这个过程。

“神奇的是,” Marquardt说,“当你用相同的输入再一次尝试设备时,输出倾向于更接近你想要的位置。” 接下来,他们正在与实验人员合作建立这样一个系统。但是专注于反向运行的系统限制了选择,所以其他研究人员将反向传播完全抛在了后面。

因为知道大脑学习的方式不是标准的反向传播,所以他们的研究没有受到打击,反而更进一步。“大脑不是反向传播的,”斯塞利尔说,当神经元A与神经元B交流时,“传播是单向的。”

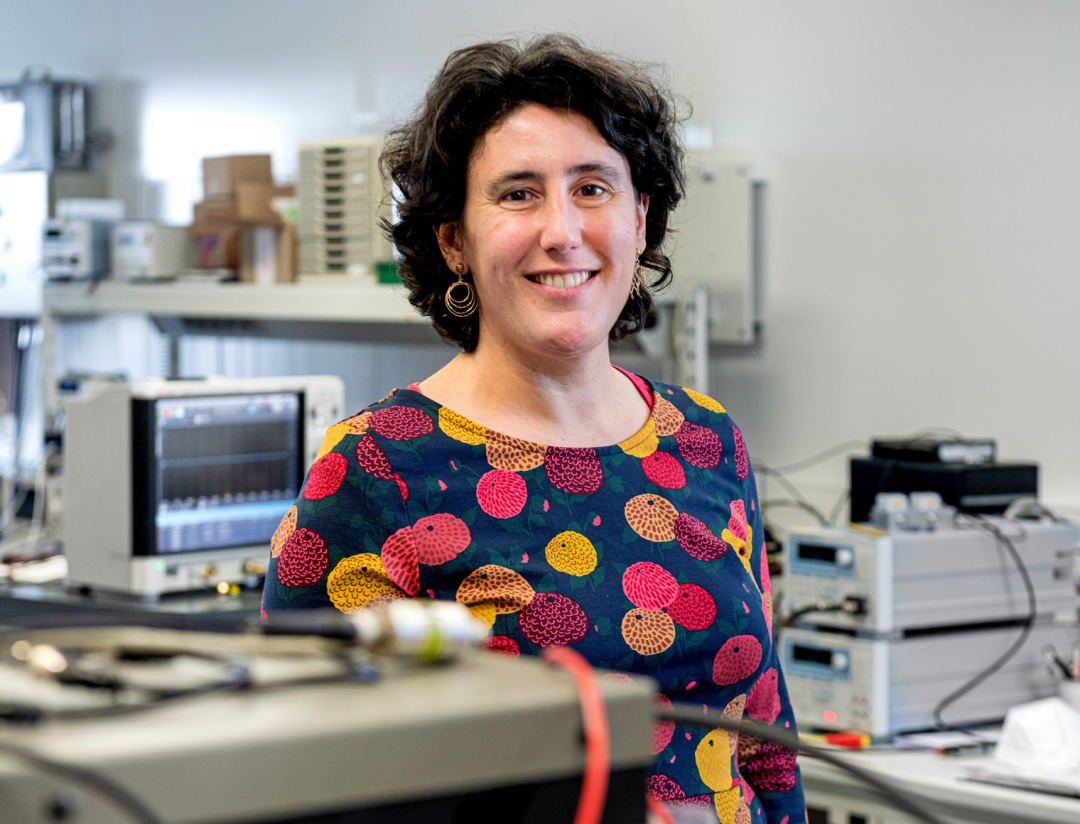

图注:CNRS的物理学家Julie Grollier实现了一种物理学习算法,被视为反向传播的一种有希望的替代方案。

图源:Christophe Caudroy2017年,Scellier和蒙特利尔大学的计算机科学家Yoshua Bengio开发了一种称为平衡传播的单向学习方法。

我们可以这样了解其运作方式:想象一个像神经元一样的箭头网络,它们的方向表示0或1,由作为突触权重的弹簧连接在网格中。弹簧越松,连接的箭头就越不容易对齐。首先,旋转最左边一行的箭头,以反映手写数字的像素,然后在保持最左边一行的箭头不变,让这种扰动通过弹簧扩散出去转动其他箭头。

当翻转停止时,最右边的箭头给出了答案。关键是,我们不需要通过翻转箭头来训练这个系统。相反,我们可以在网络底部连接另一组显示正确答案的箭头,这些正确的箭头会使上面这组箭头翻转,整个网格就进入了一个新的平衡状态。

最后,将箭头的新方向与旧方向进行比较,并相应地拧紧或松开每个弹簧。经过多次试验,弹簧获得了更聪明的张力,Scellier和Bengio已经证明,这种张力相当于反向传播。“人们认为物理神经网络和反向传播之间不可能存在联系,” Grollier说,“最近情况发生了变化,这非常令人兴奋。”

关于平衡传播的最初工作都是理论性的。但在一篇即将发表的文章中,Grollier和CNRS的物理学家Jérémie Laydevant描述了该算法在D-Wave公司制造的量子退火机器上的执行。该装置有一个由数千个相互作用的超导体组成的网络,它们可以像弹簧连接的箭头一样,自然地计算出“弹簧”应该如何更新。然而,系统不能自动更新这些突触权重。

4 实现闭环

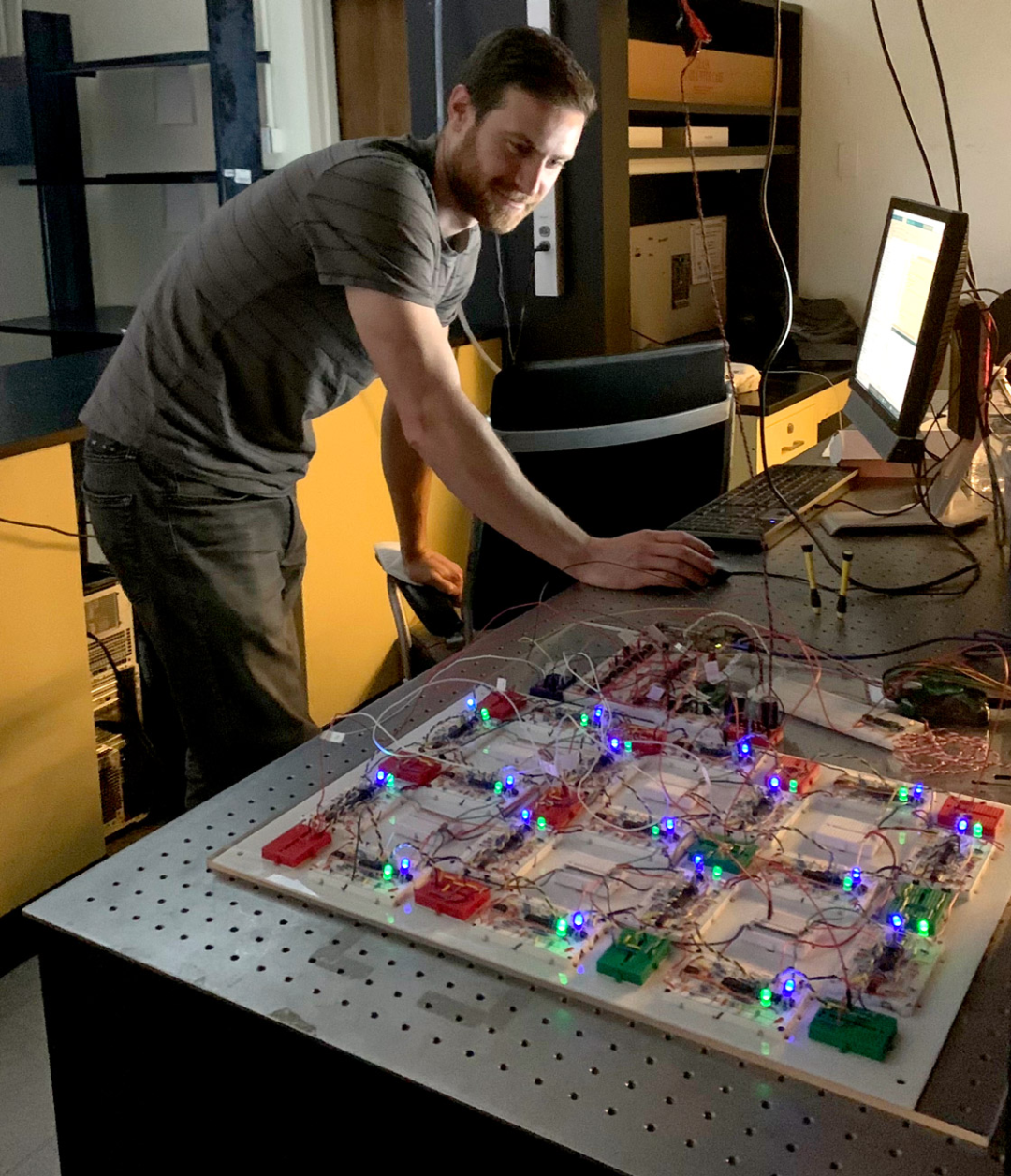

至少有一个团队已经收集了一些部件来构建一个用物理学来完成所有繁重工作的电子电路,其能完成的工作有思考、学习和更新权重。宾夕法尼亚大学的物理学家 Sam Dillavou说:“我们已经能够为一个小系统闭合回路。”

图注:宾夕法尼亚大学的物理学家Sam Dillavou修补了一个可以在学习过程中自我修改的电路。Dillavou和合作者的目标是模仿大脑,大脑才是真正的智能,其是一个相对统一的系统,不需要任何单一结构来发号施令。“每个神经元都在做自己的事情,”他说。为此,他们构建了一个自学习电路,在这个电路中作为突触权重的是可变电阻,神经元是电阻之间测量的电压。

为了对给定的输入进行分类,这个电路将数据转换为施加到几个节点上的电压。电流通过电路,寻找耗散能量最少的路径,并在稳定时改变电压。答案就是指定输出节点的电压。该想法的创新在于具有挑战性的学习步骤,为此他们设计了一种类似于均衡传播的方案,称为耦合学习(coupled learning)。

当一个电路接收数据并“猜出”一个结果时,另一个相同的电路从正确答案开始,并将其纳入其行为中。最后,连接每一对电阻的电子器件会自动比较它们的值,并调整它们,以实现“更智能”的配置。

这个小组在去年夏天的预印本(参加下图)中描述了他们的基本电路,这篇名叫“去中心化证明,物理驱动学习(Demonstration of Decentralized, Physics-Driven Learning)”的论文中显示这个电路可以学习区分三种类型的花,准确率达到95%。而现在他们正在研发一款更快、功能更强的设备。

论文地址:https://arxiv.org/abs/2108.00275即便是这种升级也无法击败最先进的硅芯片。但建造这些系统的物理学家们怀疑,与模拟网络相比,尽管数字神经网络如今看起来很强大,但最终也会显得缓慢和不足。

数字神经网络只能扩大到一定程度,否则就会陷入过度的计算,但更大的物理网络只需要做自己就好。“这是一个非常大的、快速发展的、变化多端的领域,我深信一些非常强大的计算机将会用这些原理制造出来。”Dillavou说。