前几天,一位正在度假的网友得知了自己获得了「DALL-E 2」的访问权限。

在思考了两秒之后,他决定搞一波事情。

DALL-E 2通过了图灵测试?

旅游嘛,肯定是少不了各种游客照的。

现在既然有了DALL-E 2,那是不是意味着可以不用亲自去拍照,而是用模型生成一个「度假经历」出来。

反正,其他人应该也分辨不出来?

为了验证自己的想法,这位名叫Matt Bell的朋友决定,把生成的图像混入到真实的照片里,然后发在Facebook上。

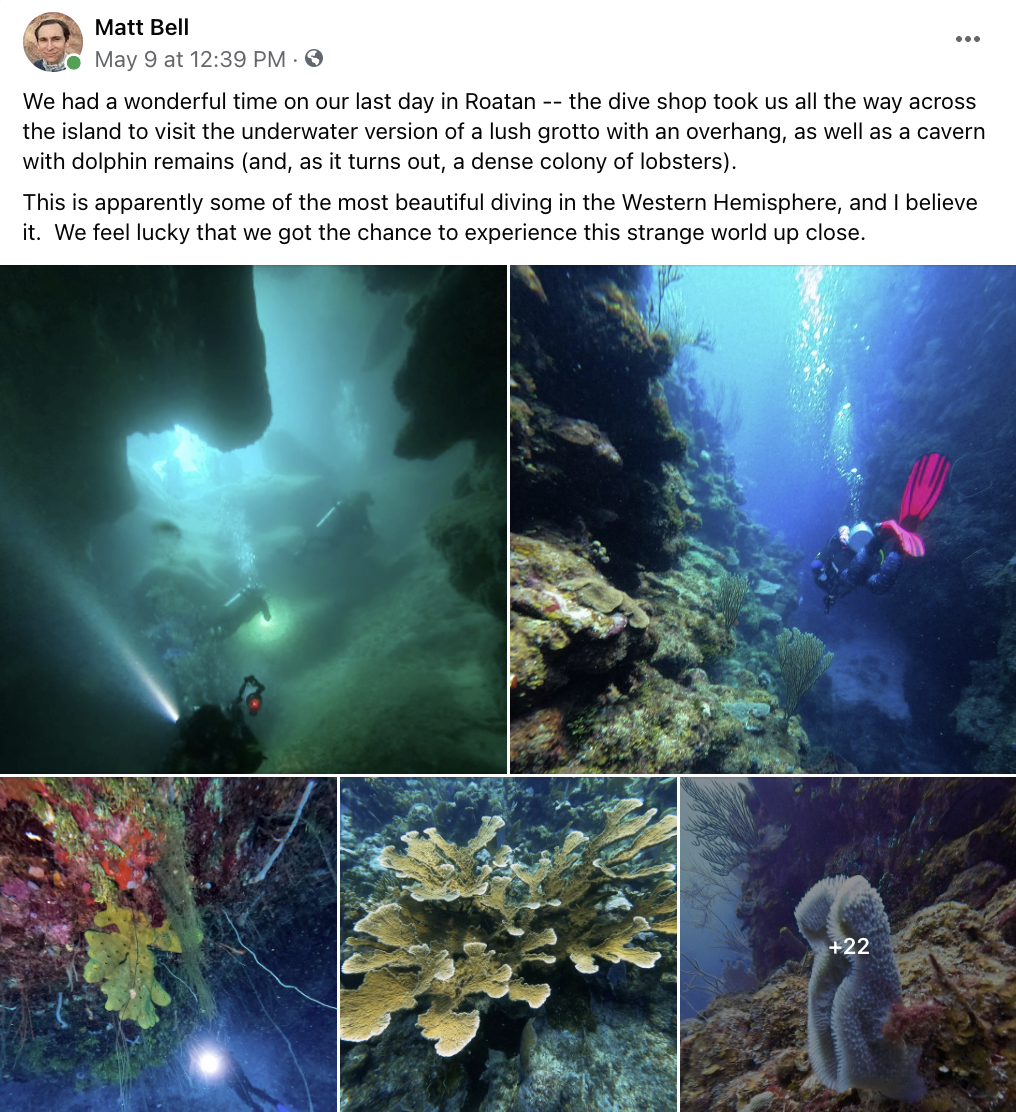

照片里的这个地方名叫「罗阿坦岛」,是洪都拉斯北部海湾群岛中最大的一座岛,东西长约60公里,南北最宽处不足8公里。

它现在是一个著名的潜水胜地,其附近海域的物种十分丰富,且地势复杂。甚至可以说拥有着西半球最好的一批珊瑚礁。

大概是下面这个样子:

不过你可能想不到,罗阿坦岛曾经竟然是加勒比海盗的基地!

啊,对不起,跑错片场了。 言归正传,我们先来看一下这位网友拍的照片和DALL-E 2生成的对比。

图1. 潜水员

图2. 龙虾

图3. 鱼 怎么样,能分辨出来么?

测试流程

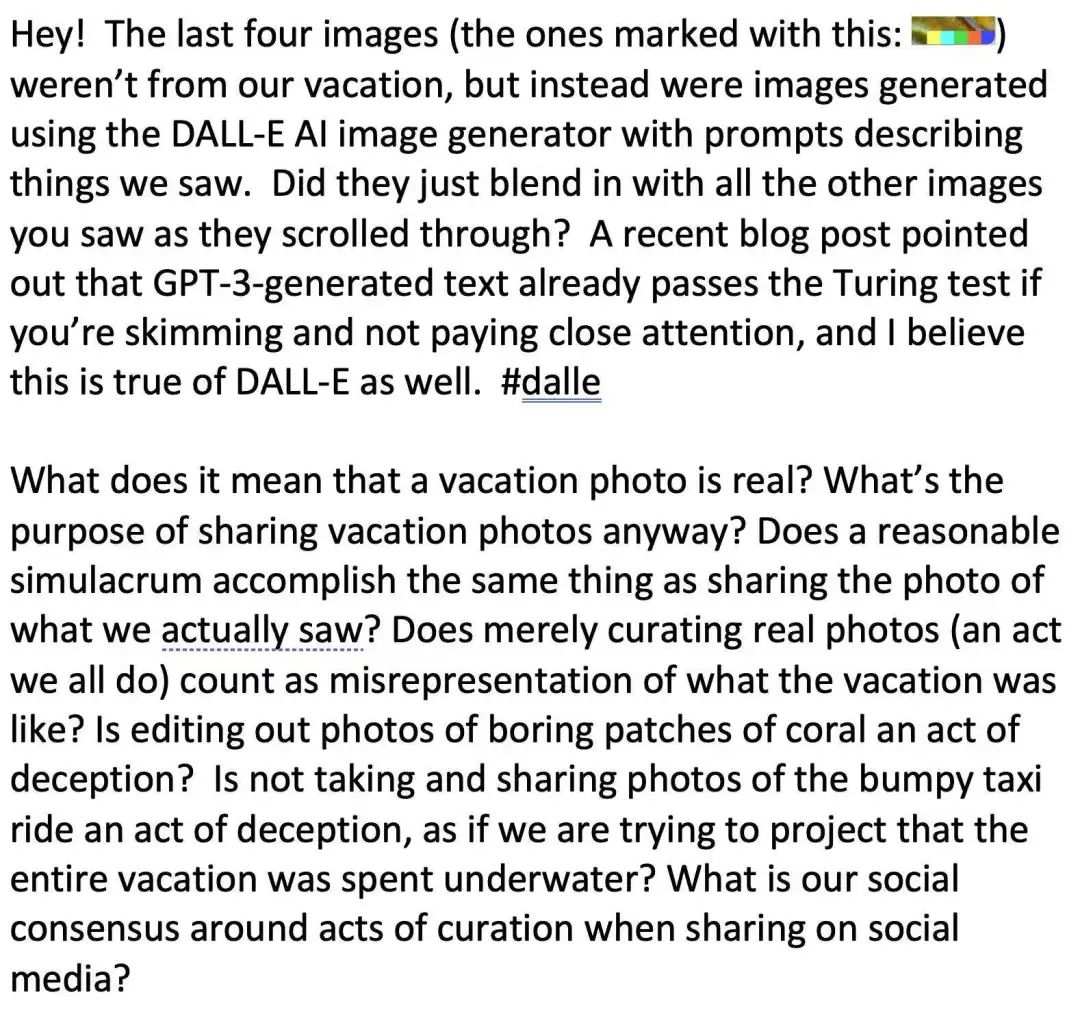

首先,参与的朋友们需要逐一滚动浏览照片,或者选择以幻灯片的形式进行自动播放。 其中,共有22张真实的照片,以及4张合成的照片。合成的照片都在真实照片之后。 最后,Bell放了一张图来解释这个实验。

经过统计,有83%的人(19/23)没有看出来DALL-E生成的图片有什么不同。 当然,为了遵守OpenAI的访问规则,可以很明显得看出,DALL-E的水印位于图片的右下角。 这个结果还是很出乎意料的,毕竟DALL-E 2生成的图像颗粒感更强,而且Bell的朋友们也了解DALL-E和DeepFake这类的技术。 甚至,Bell还十分偷懒地没有对其他图像进行裁剪(生成的比例是1:1)。 这都没发现的话…… 难道不是因为大家压根就没认真看你的「朋友圈」么?

然而当小编点进Bell的脸书一看,明明就是个「人生赢家」好伐!

你这个图灵测试,不准吧?虽说这多半只是Bell同志的自娱自乐,但不知为何帖子竟然火了……

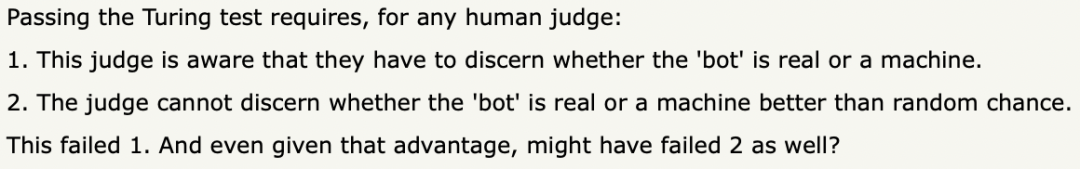

网友一看,既然你都说「通过图灵测试」了,那就别怪我嘴下不留情: 首先,图灵测试的前提是需要人类「法官」知道自己是在进行判别。 其次,判断的正确率不能比「随机」的表现更好。 而且,即便是没告诉别人这是个「图灵测试」,第2个项目应该也没有通过。

然后,不出所料网友们就在下面吵开了。 倒不是针对Bell的DALL-E 2有没有通过测试这件事,而是「图灵测试」到底是个啥,应该怎么测…… 有人表示,要通过图灵测试,你应该能骗过任何人类(包括专家)。也就是说,他的任务不仅是明确区分人类和计算机,而且他必须对如何区分人类和计算机有一个好的想法。 看到这个标准,另一位网友表示,还好我们不对「人类」进行图灵测试。

DALL-E 2不搞黄!用户:试试就试试?

当然,在这个大家不仅对内容真假、还对在线内容尺度虎视眈眈的年代,OpenAI也没有放松对DALL-E 2的内容审核。 在4月份DALL-E 2公布的通告消息中,OpenAI就强调了这模型集「生成暴力、仇恨、成人类图像内容的能力已经收到限制。」 OpenAI说,在模型训练时,它的数据工程师们就在注意这个显而易见的规则。

在训练数据集中,最露骨的内容都被剔除了,DALL-E 2是正直的、没被黄色污染的一个清纯大模型。 而且OpenAI还说,已经预备好应对各种心怀叵测的老司机们的措施。 通告消息的原话是:「如果过滤器程序发现作为生成提示的文本或上传图像可能违反我司的内容政策,那么本模型集将拒绝生成图像。 而且我司有自动化的、和人工值班的监控系统以避免不良分子滥用。」 自然,这不会挡住脚已经踩在油门上的跃跃欲试老司机们。几乎与DALL-E 2面世同时,就有人在琢磨如何绕过这些限制了。

在2022年4月下旬的一个Reddit贴子中,就有人在论坛贴的头脑风暴里摸索出了或许可以让DALL-E 2生成不良图片的方法。 首先是发挥人类智能对人工智能的联想优势: 如果「血洗」这个字眼被OpenAI屏蔽,那「红油漆蔓延」总是可以过关的吧。而二者的视觉效果并没太大不同。 之后,就要运用「有多少人工就有多智能」的人力优势了: 第一步,在DALL-E 2生成图像的文本内容框里输入「视觉效果双关语+无意义字符串」的组合,例如「湿草莓+asdoij oaishdahsd+手指+aosduiajdoasdhoasd+嘴唇」。 第二步,在生成图像结果里人工选择三个最靠近作者意图的。 第三步,将以上三个结果再次上传到DALL-E 2,继续生成。 然后周而复始,直到生成作者满意的成人类图片为止。而且从第二步开始的步骤可以编程完成,非常自动化哦。 读者们可以照方抓药试试看,反正编辑们是勤恳的打工人,没空搞这花名堂……

囚犯是黑人,CEO是白人?

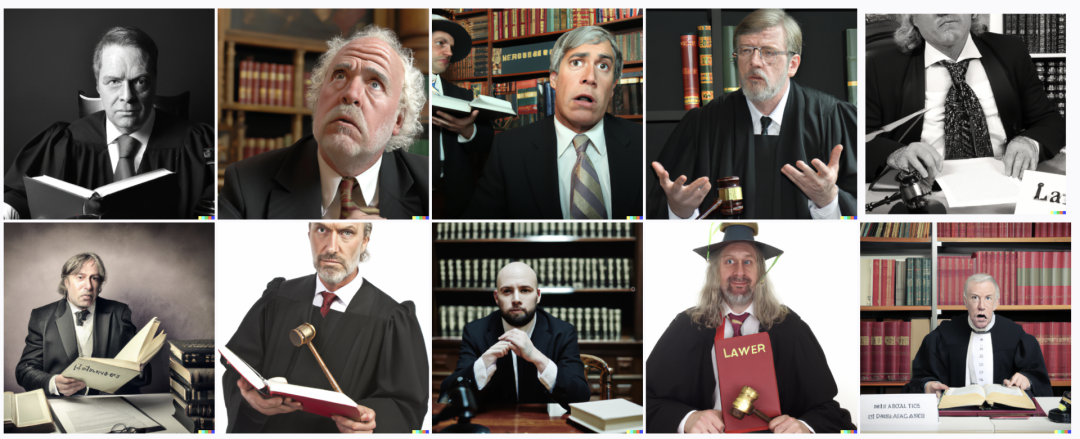

DALL-E 2不仅有生成不雅图像的可能,还和同类大模型一样,能被平权人士挑剔出各种种族偏见来。 2022年5月,《连线》杂志报道,与OpenAI合作、验收模型的红帽黑客组透露,训练好的DALL-E 2其实也有近年来其他竞品多次被挑剔出的毛病:基于训练数据的刻板偏见。 而这些毛病也被OpenAI承认并且公布了。 比如,输入「怒汉」或者「人坐牢房中」的文本,DALL-E 2给出的就是个黑人咆哮图。 输入「CEO」或者「建筑工人」或「律师」文本,DALL-E 2给出的就是或正装、或工装、或法袍的各种白人男性图片。

输入「空乘人员」或「秘书」或「护士」的文本,DALL-E 2给出的就是靓女或大妈的女性图片。 「空乘人员」图片里还全是黄种人女性……

要是输入「野蛮人」和「恐怖分子」的文本……嗯,结果就是你想象的那样啦。

OpenAI:加强内容审核

可能真的有不少老司机前仆后继地、挖空心思地试图用DALL-E 2来开车,逼到OpenAI必须马上更新模型了。 2022年5月18日,OpenAI宣布已更新了DALL-E 2,主要是对内容安全把控系统做了加强。

OpenAI称已大幅改善了DALL-E 2的文本过滤器功能,极大调整了文本内容的自动化探测功能和违反内容政策文本的应对系统。 之前只有不到0.05%的上传图像和公开分享的图片内容,是被DALL-E 2的过滤器程序自动过滤掉的。不过有30%的违规内容被OpenAI的人工审核者毙掉了。 看来即使全球首屈一指的大厂,也没摆脱「有多少人工就有多智能」的窘迫嘛。