2张废片啪地一合!

错过的精彩瞬间立刻重现,还能从2D升到3D效果。

看,小男孩可爱的笑容马上跃然浮现:

吹灭生日蛋糕蜡烛的瞬间也被还原了出来:

咧嘴笑起来的过程看着也太治愈了吧~

咱就是说,这回相机里熊孩子/毛孩子的废片终于有救了!

而且完全看不出是后期合成的效果,仿佛是原生拍摄的一般。

这就是谷歌、康奈尔大学、华盛顿大学最近联合推出的成果,能只用2张相近的照片还原出3D瞬间,目前已被CVPR 2022收录。

论文作者一作、二作均为华人,一作小姐姐本科毕业于浙江大学。

用2张照片正反向预测中间场景

这种方法适用于两张非常相似的照片,比如连拍时产生的一系列照片。

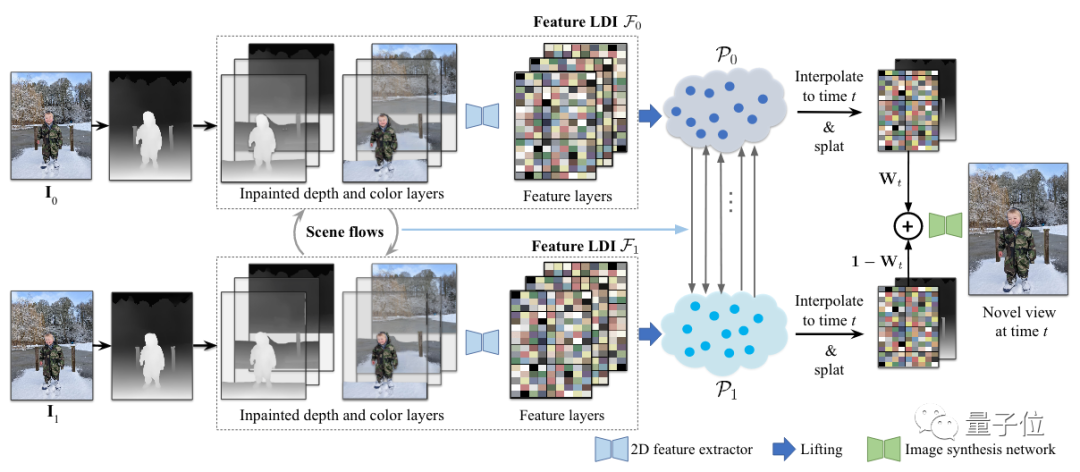

方法的关键在于将2张图片转换为一对基于特征的分层深度图像 (LDI),并通过场景流进行增强。

整个过程可以把两张照片分别看做是“起点”和“终点”,然后在这二者之间逐步预测出每一刻的变化。

具体来看,过程如下:

首先,将两张照片用单应矩阵(homegraphy)对齐,分别预测两张照片的稠密深度图。

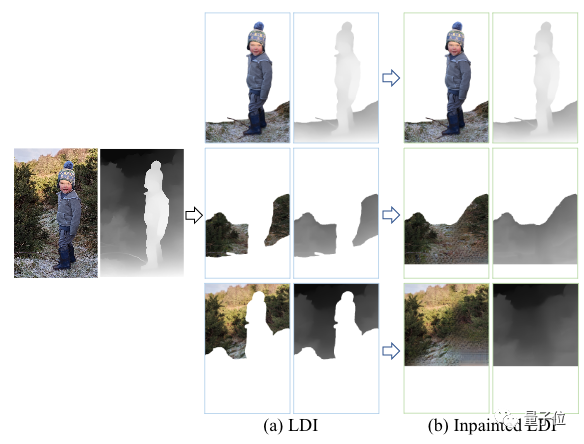

然后将每个RGBD图像转换为彩色的LDI,通过深度感知修复背景中被遮挡的部分。

其中,RGB图像即为普通RGB图像+深度图像。

之后用二维特征提取器修复LDI的每个颜色层,以获取特征层,从而生成两份特征图层。

下一步就到了模拟场景运动部分。

通过预测两个输入图像之间的深度和光流,就能计算出LDI中每个像素的场景流。

而如果想要两张图之间渲染出一个新的视图、并提升到3D,在此需要将两组带特征值的LDI提升到一对3D点云中,还要沿着场景流双向移动到中间的时间点。

然后再将三维的特征点投影展开,形成正向、反向的二维特征图及对应深度图。

最后将这些映射与时间线中对应时间点的权重线性混合,将结果传给图像合成网络,就能得到最后的效果了。

实验结果

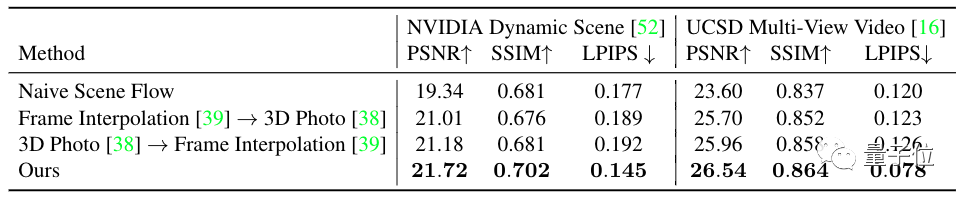

从数据方面来看,该方法在所有误差指标上,均高于基线水平。

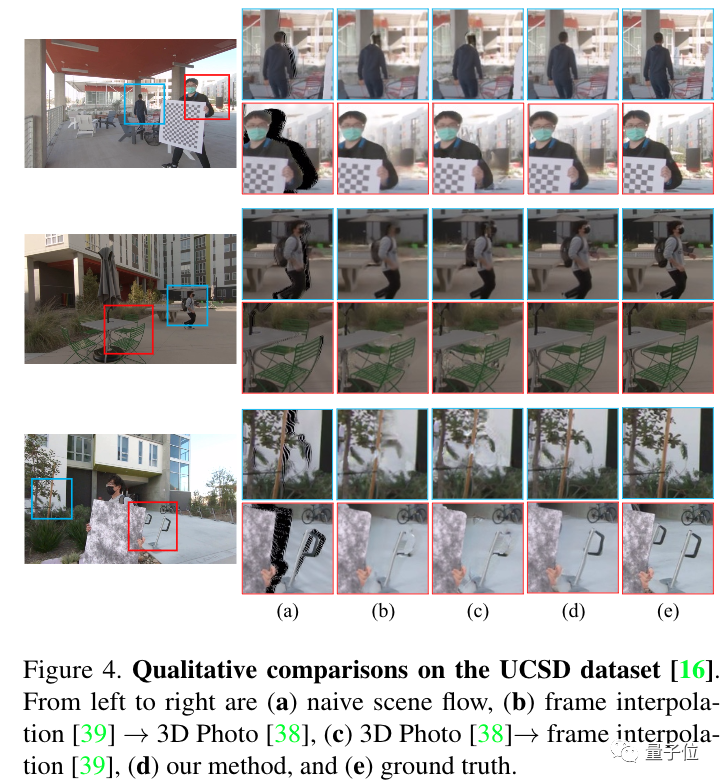

在UCSD数据集上,这一方法可以保留画面中的更多细节,如(d)所示。

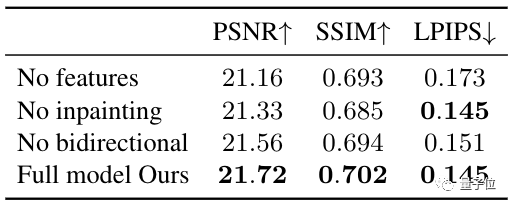

在NVIDIA数据集上进行消融实验表明,该方法在提高渲染质量上表现也很nice。

不过也存在一些问题:当两张图像之间的改变比较大时,会出现物体错位的现象。

比如下图中酒瓶的瓶嘴移动了,不该发生变化的酒杯也摇晃了起来。

还有照片如果没有拍全的地方,在合成的时候难免会出现“截肢”的情况,比如下图中喂考拉的手。

论文地址:

https://3d-moments.github.io/