嘉宾:周力

整理:千山

人机对话早已渗透进我们的日常生活中,AI语音助手、聊天机器人等应用也是屡见不鲜。那AI与AI之间的对话呢,是否也有其价值?日前,在51CTO主办的MetaCon元宇宙技术大会上,小冰公司技术副总裁周力带来了主题演讲《AI和AI的对谈技术的探索与应用》,剖析了AI对谈的意义,AI对谈系统的技术设计,以及AI对谈在沉浸式虚拟社交场景中的应用,为大众呈现了全新的视角。

现将演讲内容整理如下,希望对诸君有所启发。

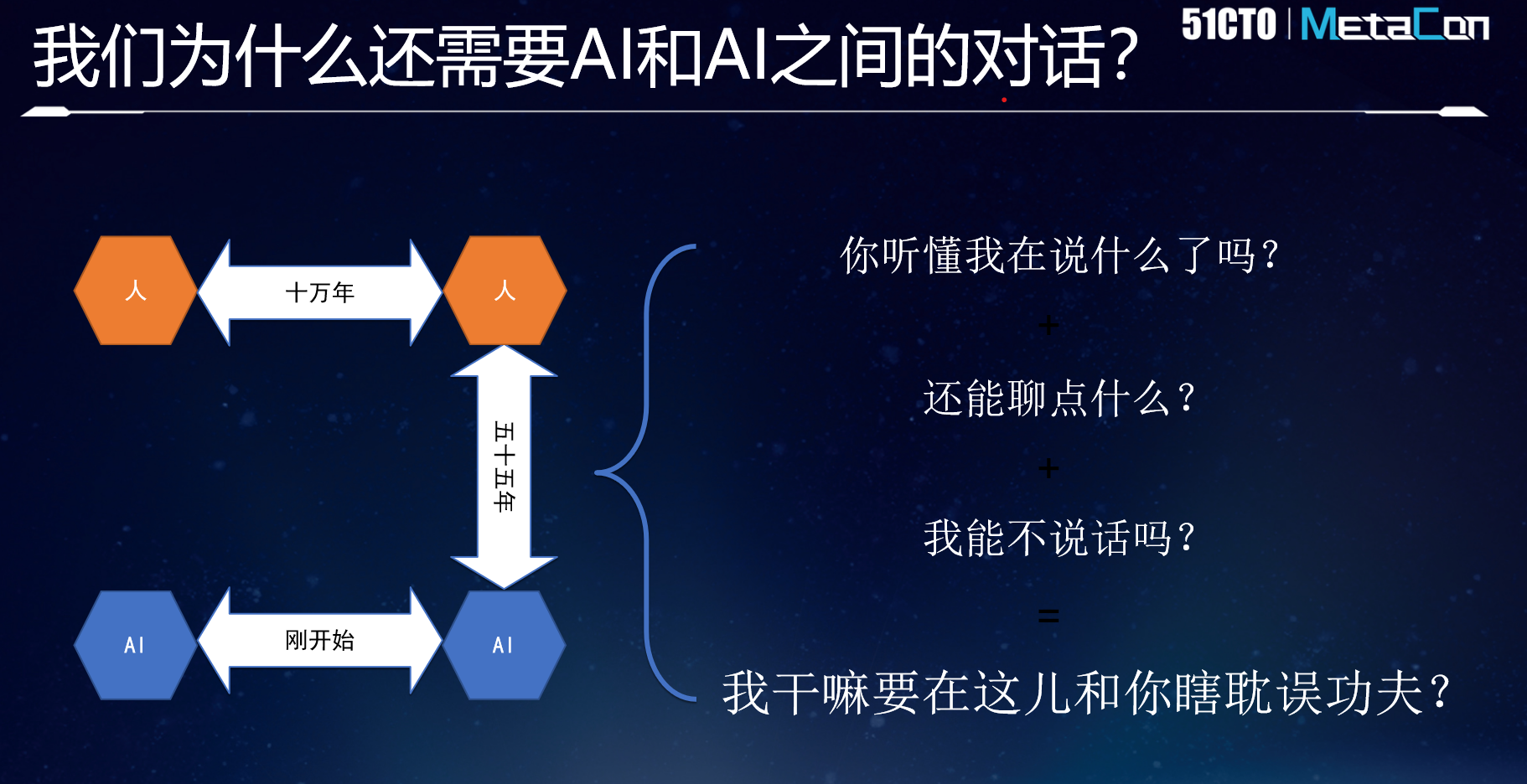

我们为什么还需要AI和AI之间的对话

人和人之间的对话至少有十万年的历史,而人和机器之间的对话,就算从最开始非常简陋的聊天机器人Eliza开始算起,最多到现在也只有55年。真正的人机对话主要在最近的10年有比较大的发展。

但不管在学术界还是工业界,对于AI与AI如何进行对话,几乎还没有研究。最多是把两个聊天机器人放一起进行质量评测,观察哪个机器人聊天的质量更好一些。AI和AI之间的对话到底有什么价值?除了作为一种评测的工具以外,是不是还有其他的应用场景?这一问题值得仔细剖析。

事实上,虽然业界已经就人和AI之间的对话进行了很多研究,在技术上和相关性上有了很多的突破,但实际上人和AI之间还有三个很核心的问题需要去解决。

第一,AI真的听懂了人在说什么?AI能不能通过算法理解人的各种表达,包括各种省略的意思、各种言外之意。随着超大语言模型(的诞生和进化),这个问题看起来已经越来越不是问题,至少说我们已经能解决很大比例的问题。

第二,我们还能聊点什么?这是很多人面对AI时的痛点,不管是手机语音助手还是聊天机器人。最开始他可能会尝试问,北京的天气怎么样,机器人回答之后,他再去问上海的天气怎么样。然后他把知道的城市问完一遍后,可能他和AI之间的对话就结束了。人和机器之间的对话经常是这样,与人和人之间的对话模式仍然有很大差别,所以人很难真正和AI像和一个真人一样打开心扉,海阔天空地去聊。

第三,我能不说话吗?即使在真人对真人的情况下,人也不一定愿意时时刻刻去努力参与一个对话,有的时候我可能只愿意去做一个听众。那么在传统的人和AI的对话设计中,要不然就得逼着人不断地说话,要不然他就会退出这个对话界面,去做别的事情。此时人和AI之间的交互就会终止了。

以上这些问题汇总,就会变成一个大的问题,即我为什么要在这里跟一个AI瞎耽误工夫,这是所有用人工智能进行对话的产品都会遇到的挑战。人感觉不到他在AI身上能真正得到什么价值。

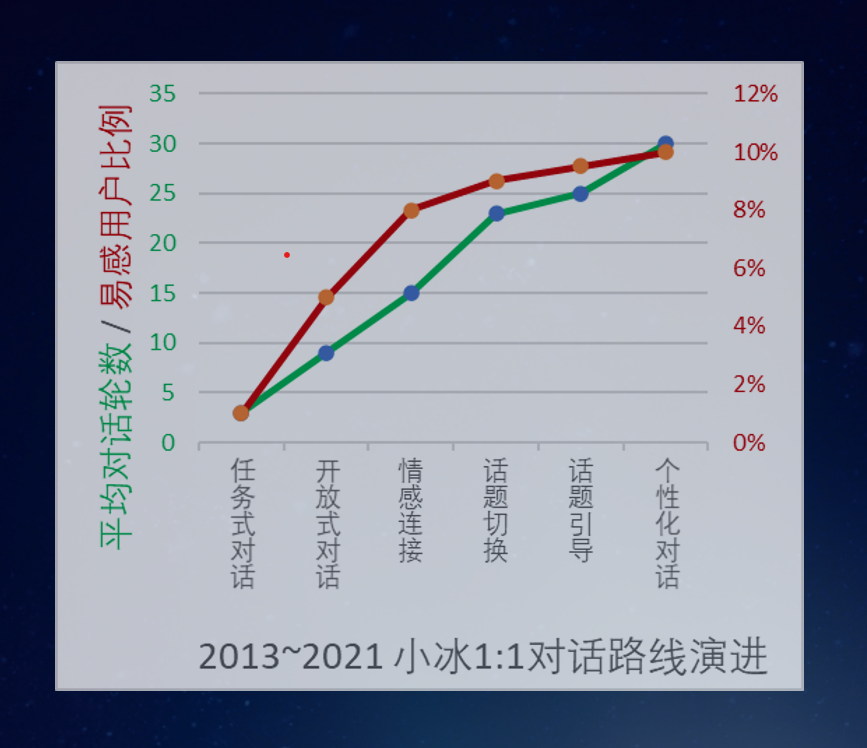

我们再看一张图(如下)。

可以看到,从2013年开始,小冰在过去的八年间一直在人机对话中进行各种各样的尝试。图中绿线蓝点的部分表示,随着各种新技术的运用,用户和小冰的平均对话轮数越来越多。我们认为对话的轮数越多,是人和AI之间聊得更好的一个重要表现。聊得不好的话,可能聊个两三轮就结束了。如果AI对话质量好的话,就有可能聊十轮、二十轮、三十轮。

但是同样我们会看到,真正能打开心扉跟AI去聊的人数比例其实很少。图中红线橙点的部分表示,随着技术的演进,有多少比例的用户突破了诸如天气如何之类的简单问题的范畴,像面对真人一样和AI聊天,分享自己的想法、经历、心情。由图可知,这个比例虽然在不断增加,但是增长曲线越来越缓,这说明很多人在和AI一对一的聊天过程中,并不能打破这个阈限。

用户研究发现,多数能打破阈限的人年纪较小,比如中学生或者大学生,他们接受新事物比较容易。年纪大一点的人就很难真正敞开心扉跟AI对话。我们用户调查中还尝试过用一个真人去和用户聊天,让用户以为这还是一个AI。但是哪怕和真人,即拥有几乎完美的对话能力的情况下,这个比例仍然无法超过20%。在人与AI 1:1对话中,能让人打破和AI之间界限的比例最高也就到20%。那么有没有可能打破这个天花板?这是最近两年小冰公司一直在尝试的领域。

我们可以利用一些真人和真人交流的例子来说明天花板为什么会存在,以及如何打破这样的天花板。

场景一:一群陌生男女的相亲大会。在彼此完全不认识且目的明确的情况下,聊的话题往往功利性较强,非常有限,比如有房有车吗,工作如何,家庭状况等等,并不是这些参加相亲大会的人真的都这么功利,或者说真的都那么不会聊天,而是就像之前提到的人和AI语音助手只聊天气、只聊知识问答一样,这个场景的设定就把对话的思路局限了。

场景二:多年未见的老同学聚会。虽然大家可能很多年没见,工作和生活也少有交集,但通常这种聚会我们都会从上学时的回忆开始聊起,话题和气氛破冰后,渐渐就可以聊到现实的生活、工作等各种问题。可以发现,人和人之间能完成破冰的关键点在于他们有共同的记忆。

因此小冰也曾尝试让AI去发朋友圈,用算法模拟它今天吃了什么,到了什么地方旅游等等,希望通过这种方式让某个人观察到这个AI时,也许可以想到更多话题跟AI去聊。小冰还试过允许某个人向AI分享他看到的文章,目的也是帮助他们建立共同记忆,从而让他们更好地对话。但这里依然存在鸡生蛋、蛋生鸡的问题。假如这个人和AI完全没有建立起交流意愿的话,那么这个用户既不会花很长时间去观看AI的朋友圈,也不会主动分享内容给它,因为这对他来说就是浪费时间。

场景三:老大爷在公园里遛弯。刚退休的老大爷在公园里闲逛,公园里有下棋的、带小孩的、聊天的各色人群,他可能也不认识谁,只是四处看一看、听一听。过了几天,他可能就会找到一个自己比较感兴趣的圈子,他开始尝试去接触,再过一段时间,他在公园交到了新朋友,有了新圈子,进而如鱼得水地融入了这个环境。

这样的交互体验,我们认为是人和AI的交互中能实现破冰的一种可能。沉浸式社交环境,也就是如今大家说的元宇宙环境,其实跟老大爷溜公园的模式是相似的。作为新用户,在陌生的社交环境中,如何找到自己感兴趣的东西,如何发现自己应该在里面干什么。前提是,已经有很多很丰富的交互在里边存在了。而这种本身已经存在的环境,并不一定是其他用户搭建起来的,它可能是一堆AI构建起来的。

这就是我们想要给大家介绍的观念,即在一个沉浸式的社交媒体中,除了人之外,应该还有无穷无尽的AI生活在这个元宇宙之中。因此今天我们需要着重跟大家剖析的是,AI和AI之间如何去建立起一个复杂的交互的关系和对话。

最终有意义的是,人的圈子和AI的圈子发生碰撞,我们所谓的社交和很多AI生成的内容发生碰撞,这种碰撞能产生什么样有意思的东西。小冰公司从去年底开始内测一个叫“小冰岛”的App,我们所想要去尝试的东西,也就是如何去搭建一个以AI为主、用户为辅的沉浸式的虚拟社交媒体的体验。

在“小冰岛”上,有真人存在,也有很多AI的存在,AI之间会随机组队进行各种各样话题的聊天。如果一个人听到它们的对话觉得有兴趣,他就可以加入和AI之间的这种对话。然后几个不同的人也可以和AI一起进行更复杂的交互。

AI对谈系统的整体设计

要实现这一技术,最核心的是解决AI和AI之间如何进行对话。

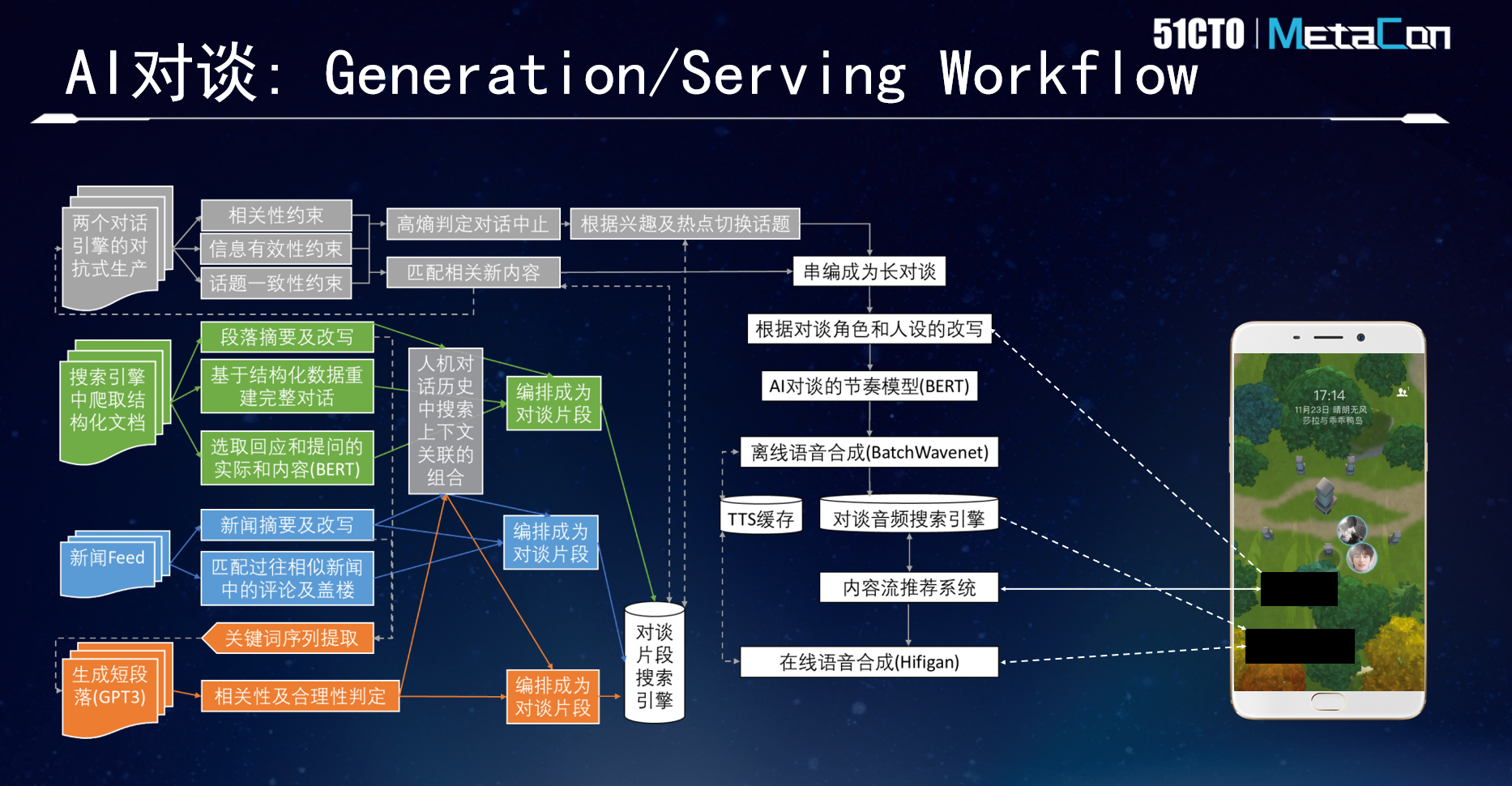

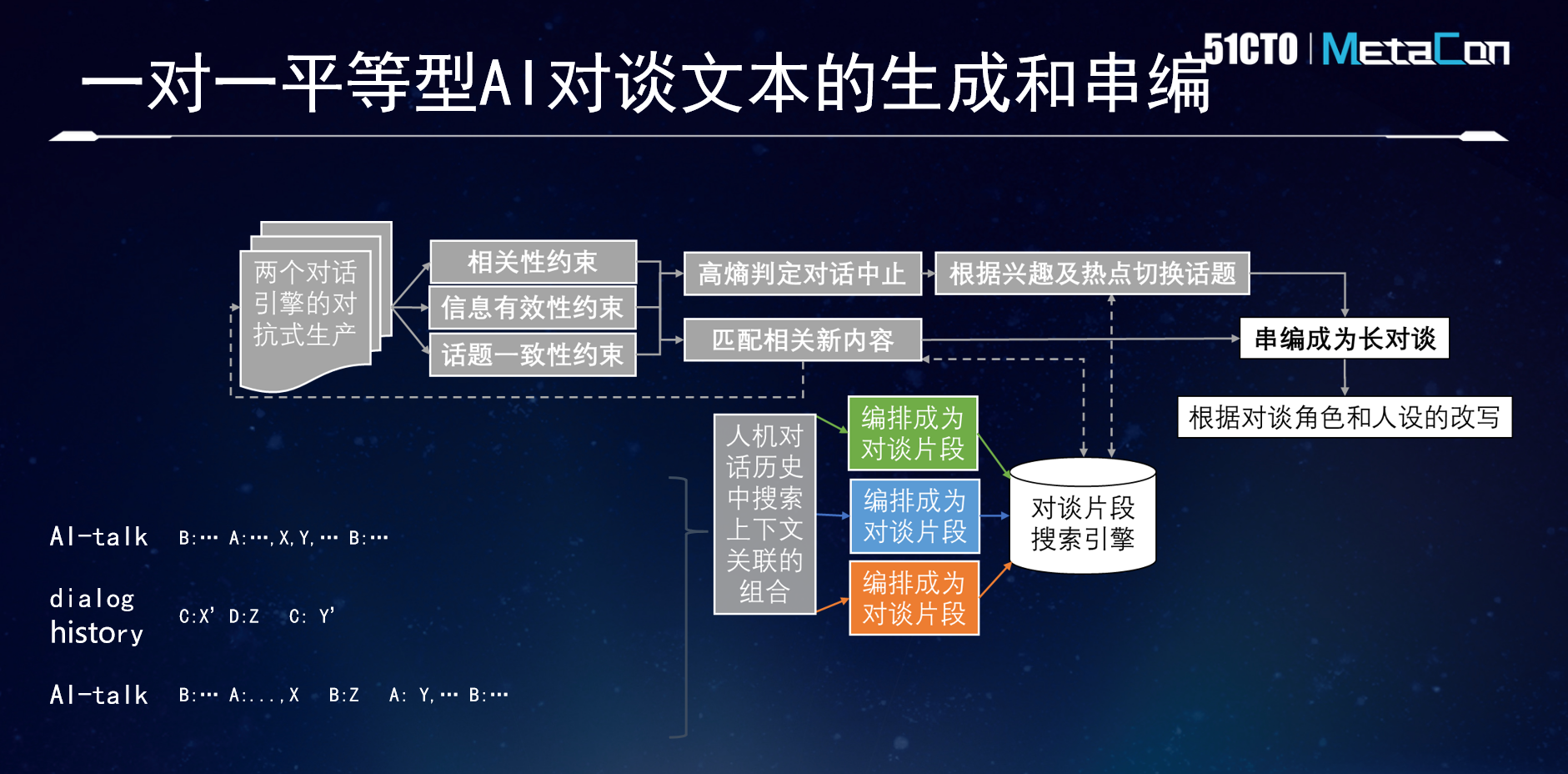

首先看一下概略图(如下)。

简单说明一下,绿色、蓝色和橙色的框图,代表三种不同的原数据产生的方法,它们能产生一些AI对谈的片段。然后灰色部分把所有的对话片段串成一个AI和AI之间的长程的交流。最后白色部分把这些文本变成能直接听到的语音片段。

在分析每个部分的技术细节之前,我们先了解一下传统的人机对话和AI和AI之间的对话有何不同。

首先,对话的模式会变得更多样。传统的聊天机器人或者语音助手,通常是用户说一句,AI回一句这样你一句、我一句的交谈模式。但其实人和人之间聊天并非如此。很多时候可能90%的话都是一个人说,另一个更多地充当一个聆听者的角色。

聆听者也有各种类型,引导式聆听者,他会引导倾诉者更好地表达内心想法;提问式聆听者,可能会问一些问题,从而帮助自己获得的信息更全面;点评式聆听者,则会在倾诉者表达后适时给一些评论、指导;抬杠式聆听者,顾名思义,不管倾诉者说什么都要去怼一怼。

由此可见,人和人之间的对话远比传统的人机对话模式要复杂。在AI和AI的对谈中,由于你可以同时去控制AI双方,他们之间是透明的,因此相比人机对话我们更有机会去实现更复杂的交互模式。

另一方面,在AI和AI的对谈中,整体的节奏会变得非常重要。现在的TTS合成技术已经非常成熟了,但是如果你把这个时间放到五分钟甚至半个小时的话,那么你依然会觉得这个机器合成的声音会变得相当机械。

其实人与人之间说话会有很多的变化。那么对于AI也是如此,我们需要去模拟这样的语速变化,句间停顿时长的变化,这样可以在更长的时间内让人感觉到它很自然。

而且它需要去加入更多诸如“嗯、啊、我想”之类的语气词、切口。这类词语在传统人机对话中通常会被认为是无用的废话,因为只有人脑子跟不上表达的时候才会需要这些东西。但是当我们把两个AI放到一起的时候,AI也都需要这些语气词。如此一来,才能把整个对话进行得更自然,才能让真实的用户更愿意长时间听下去。

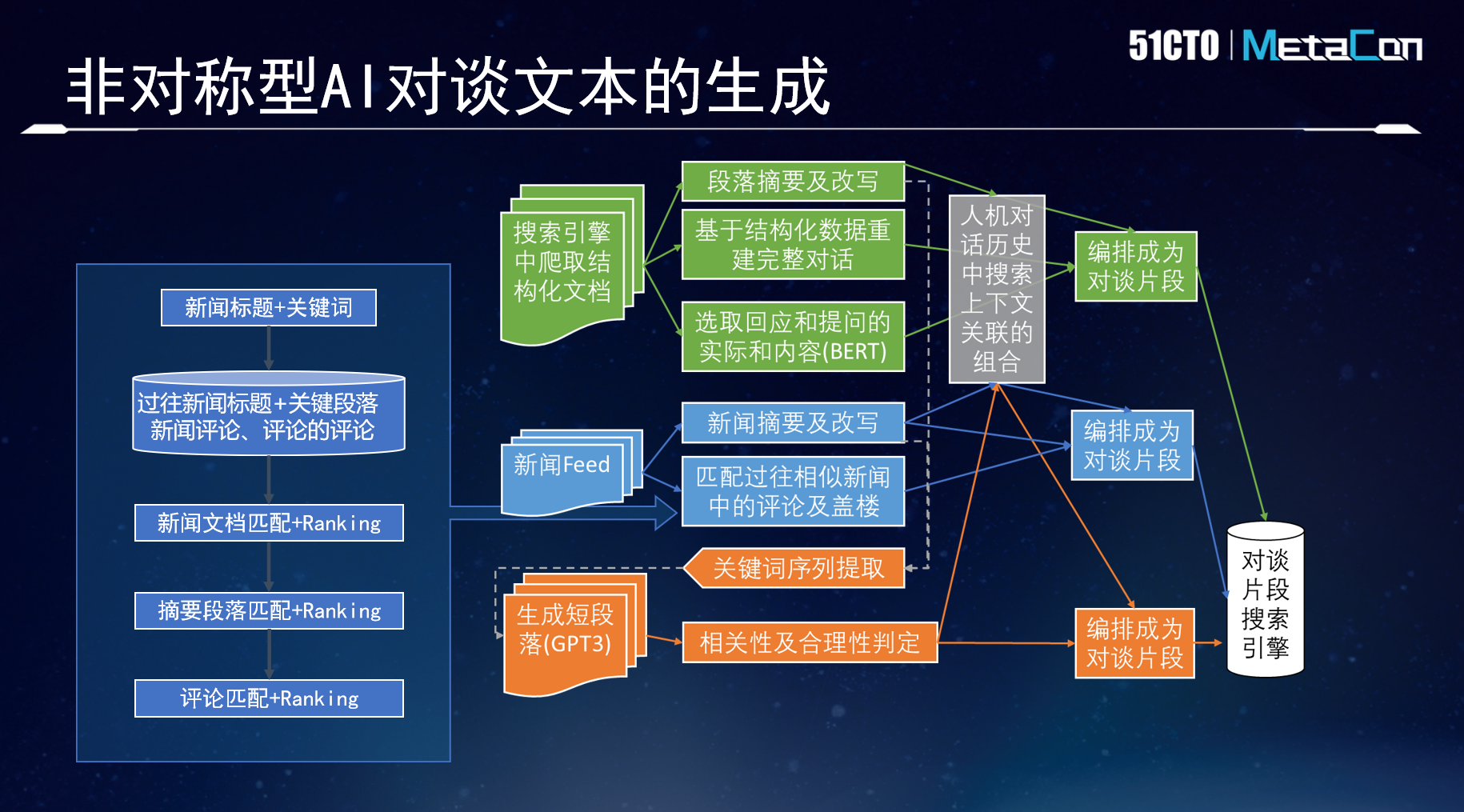

AI对谈的文本生成

在技术细节中,先来看一下AI对谈的文本生成。小冰现有的实践一共包括三种方法。

其一,从搜索引擎中爬取结构化文档。比如爬取某地旅游网站的结构化文档,我们就可以了解其重要的景点、饮食特色、交通布局等等内容。进而用BERT这样的技术把这些片段串起来,变成内容。

其二,新闻Feed。新闻本身是比较难的非结构化文本,因为新闻写作手法千变万化。但小冰在过去几年中和很多端媒进行了合作,做了大量的新闻评论,也因此获得了很多真实用户对新闻的评论。这些数据可以用来变成AI间的对话。比如对新闻摘要进行改写,一个AI把新闻说出来,另一个AI从过往相似新闻中抽取真实用户的高质量评论,当相关段落被提及时,相应评论就可以插进来。单篇文章就变成了交互对话。

其三,用GPT-3生成段落。GPT-3在语言的通顺度上做得很好,但是它在写一些略长一点的文本时,就很可能没什么逻辑。为了解决这一问题,我们使用的方法是,抽取关键词序列。比如讨论猫的大小便问题,从结构化文档中可以提取到猫砂、便盆等关键词,我们可以把这些关键字作为一个序列,一次过一段时间,把一个关键词混入到GPT生成的序列中。这样的话,GPT整个生成过程中,就会沿着这些关键词的逻辑去往前发展,生成的内容就会更有逻辑的连续性。但是一般情况下,我们现在用GPT-3会认为其生成长度在100到300字左右比较合适,再长了的话,还是会有各种各样的逻辑缺陷。

以上三种方法是根据小冰自有的一些比较成熟的数据来设计的。有了这些对话片段之后,我们还需要把它串成一个更长的AI和AI间的对话,这个AI和AI的对话中可能含有很多个不同的话题,需要把它们连贯地串在一起。

如上图所示,之前生成的三种类型的编排的片段,都被放到了一个搜索引擎中。

当我们拿到第一个片段,这个片段的内容结束后,我们就会把它最后的一句话放到一个对话的引擎里,然后用对话引擎得到一个回答。然后再用一个不一样的对话引擎再去接,相当于是两个对话引擎进行对抗,来产生内容。

需要特别注意的是,这样的场景通常不能直接使用过往为人机对话设计的对话引擎,不管是语音助手还是聊天机器人,在这种场景下都不能太好地工作。因为机器和人对话、机器和机器之间的对话,还是非常的不一样。我们至少需要在这两个对话引擎中大幅度地去改造其中一个,才能让两个机器之间对话能变得更加顺畅、更有逻辑,而不会落入话题的死循环。

每生成一轮新的对话之后,我们都需要去检测。首先,我们需要去约束它的相关性,信息的有效性,话题的一致性。在做了这个判断之后通常会有两种可能:高熵判定对话中止,或是匹配相关新内容。

当我们把最后生成的一句话放到对话片段的搜索引擎中,我们能找到一个新的片段跟机器和机器之间的对话引擎碰撞出来的最后一句话是强相关的情况下,我们就认为两个对话引擎的工作结束了,因为它已经成功地把一个片段顺接到了另一个片段之中。这是最理想的状况。

但是也有可能这两个机器对话引擎进行碰撞,碰撞了很久,仍然没有找到一个合适的新的话题。这个时候我们就需要判断这两个机器之间的对话是否是有效的。如果信息熵足够得高,或者回答都是“对啊、呵呵”这种没有营养的话,或者一问一答的重复性非常高,我们认为这是一个高熵判定。这个时候两个对话引擎的对话就中止了,需要强行地去切换新话题。这个新话题可能是当前的热点话题,也可能是用户可能会感兴趣的话题。

话题的切换可能会更突然一些,但是通常情况下,我们认为两个对话引擎不能永久地对抗下去,因为对话的意义和含量会变得越来越差,我们需要将这种编排的片段在里边进行穿插,才能让整个AI和AI之间的对话变得更有营养。这是把短片段变成更长的编排的方法。

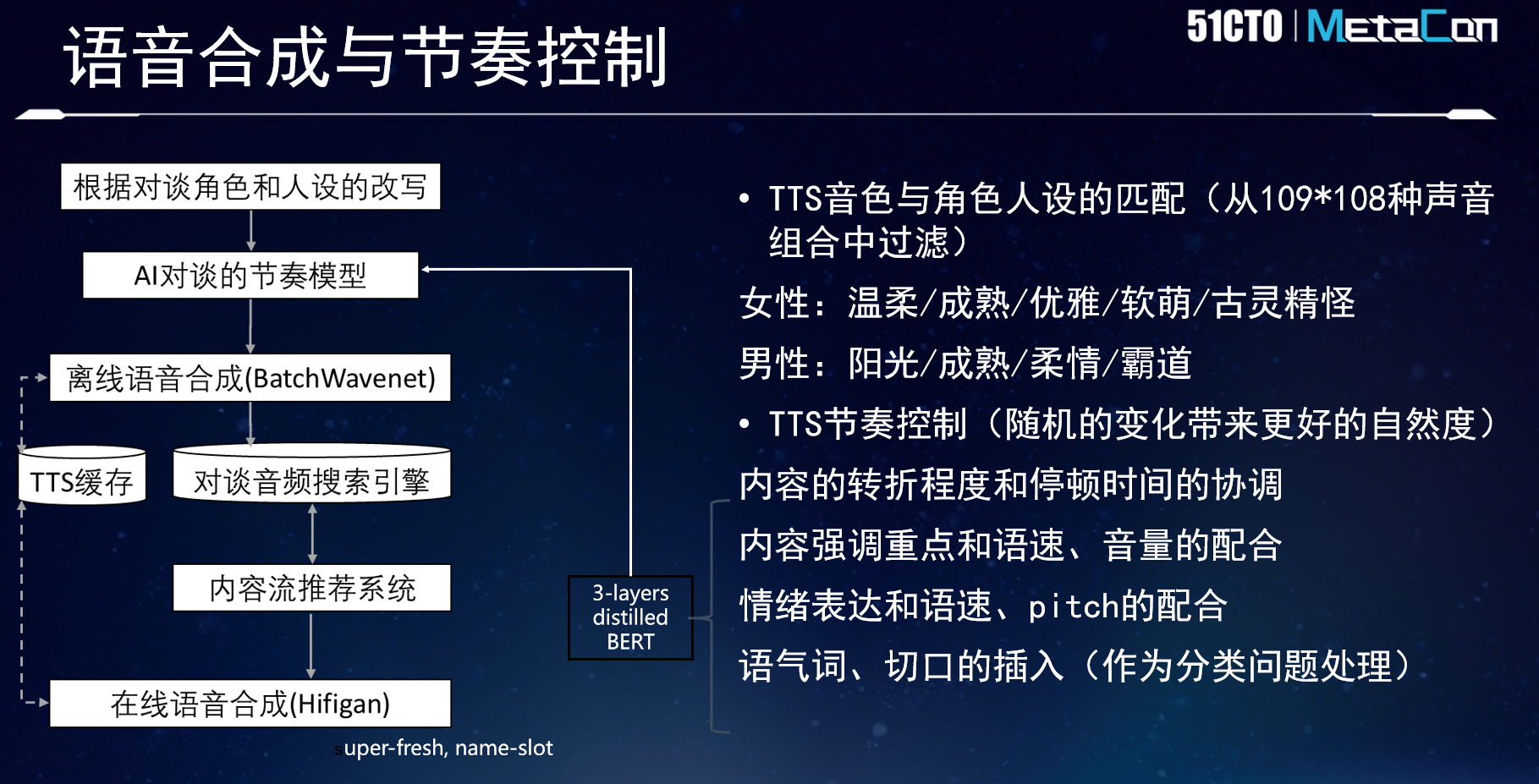

AI对谈的语音合成与节奏控制

下面简要介绍一下如何把文本变成可以直接听到的语音合成的部分。其中关键在于:

一方面,对话本身需要根据它的内容匹配合适的人设,比如角色是男性还是女性,人设是偏成熟还是古灵精怪,这些都跟我们生成的内容相关。

另一方面,之前也提到,一定要进行更随机的、更有自然度的节奏的控制。我们需要根据不同的内容,比如说当有一个很长的段落的时候,我们可能需要读得快一点,但是两个人不间断地对话的时候,可能停顿的时间和语速都要变得更慢一些,这样才能让人听起来更有意思。

在内容比较好的情况下,语速应该放慢,音量应该相对增强,这样能让大家在对话中听到一些亮点和重点。所有要素配合起来,才能达成机器和机器之间对话的一个比较好的听觉体验。

AI对谈在沉浸式虚拟社交网络中的应用场景

既然有了AI和AI之间的对话,“小冰岛”也让我们看到了一堆人和一堆AI构成的沉浸式社交体验环境,那么这对于当下元宇宙发展方向的探索,对于我们未来的生活到底有多大意义?从小冰过去的尝试中,我们的思考有两点。

第一,现在的元宇宙研究多数强调视觉冲击,头显几乎被认为是元宇宙的一个标配,我似乎只有看到现实生活中不存在的那些奇奇怪怪的视觉的东西,元宇宙才有意义,但其实并不一定。

一方面,戴头显能坚持的时间是很有限的,哪怕硬件技术不断改进,人也不可能真的很长时间地去沉浸在一个视觉的虚拟世界。另一方面,我们认为,耳朵对于元宇宙来说,是更轻量级的感官接收方法。如果有非常丰富的听觉内容的话,它可以让用户在元宇宙虚拟社交中进行更长时间的交互,因为耳朵没有眼睛那么容易疲劳。

同时我们也认为,沉浸式虚拟社交网络未来给人类带来的意义并不仅仅是这种游戏性的冲击,而是真正能解决很多现实社交中存在的问题。

举例来说,中国正在步入老龄化社会,老人对于子女的陪伴需求是很强烈的。但子女工作很忙,没有大量时间去填补这种空缺。比如老人的孙女今天在幼儿园学了一首儿歌,就算她无法到老人身边给他演唱,但在元宇宙场景下,AI可以用小朋友的形象在老人家中,用小朋友的声音给他说今天在幼儿园学了一首歌,我来唱给你听。从更长远的角度来看,这是元宇宙和AI能为人类生活带来的更大的价值。

更多内容请关注MetaCon元宇宙技术大会官网 https://metacon.51cto.com/